Datenverarbeitung, -speicherung und -archivierung sind zentrale Kerndisziplinen eines Rechenzentrums. Alle Dienste verarbeiten Daten, unterscheiden sich aber sowohl im Datentyp, der Datenmenge als auch in der nötigen Verarbeitungsgeschwindigkeit maßgeblich. Vom klassischen Fileserver bis hin zu fortgeschrittenen hybriden Speichersystemen gibt es viele verschiedene Storage-Konzepte. Was aktuell in den deutschen Rechenzentren eingesetzt wird, wurde in der Studie Optimized Data Center untersucht [1].

Für die Erfüllung der Aufgaben eines Rechenzentrums ist es nötig, dass alle Elemente der IT-Infrastruktur aufeinander abgestimmt sind. Ein mögliches Nadelöhr ist hierbei die Datenspeicherung. Einige Systeme verarbeiten Daten deutlich schneller, als sie über herkömmliche Datenspeicher gespeichert oder zur Verfügung gestellt werden können und auch die Datenmengen steigen rasant an. Bei der Wahl kommt es dann letztendlich auch wieder auf den Spagat zwischen Funktionalität und Kosten an.

Ein wichtiger Punkt ist die heute absolut notwendige dauerhafte Verfügbarkeit von Daten und Datenverarbeitung, ohne die kaum noch ein Unternehmen seinen Geschäftsalltag bestreiten kann. Knapp die Hälfte alle RZ-Betreiber ist sehr zufrieden mit der Bereitstellung von hochverfügbarem Speicher und nur wenig schlechter wird die Beschaffung von neuen Speicherelementen umgesetzt. Schlechter sieht es hingegen beim Austausch von veraltetem Storage aus, was die Klassifizierung, Lokalisierung und den eigentlichen Austausch der Storage-Hardware umfasst.

Verhaltene Bewertung fortgeschrittener Storage-Konzepte

Was die innovativen Speichertechnologien angeht, sind noch viele Rechenzentrumsbetreiber verhalten. Nur wenige RZ-Betreiber messen All-Flash-Arrays und hybriden Flash-HDD-Speichersystemen bereits eine große Bedeutung zu und dementsprechend sind diese auch eher selten gut umgesetzt. Das gilt auch für die Storage-Virtualisierung, die die geringste Relevanz-Bewertung erhält. Wichtiger sind den Betreibern die Kosten, was sich in den relevanter eingeschätzten Aspekten kosteneffiziente Speicherung kalter (d.h. selten genutzter/veränderter) Daten und Auto-Tiering widerspiegelt. Mögliche Lösungen zur Kosteneinsparung hängen allerdings oftmals mit der Virtualisierung von Storage zusammen.

Archivierung erfolgt meist klassisch auf Festplatte oder Bandspeicher

Die (vorerst) letzte Station von Daten ist die Archivierung. Auch diese ist von Bedeutung, weil im Nachhinein oftmals doch noch auf archivierte Daten zugegriffen werden muss und weil es für viele Dokumente gesetzliche Aufbewahrungspflichten gibt, die es einzuhalten gilt. Hier gibt es also nicht nur Anforderungen an den gelegentlichen Zugriff, sondern auch an die Sicherstellung der Existenz. Entsprechend gut wird diese Aufgabe umgesetzt; bei nahezu der Hälfte der Unternehmen gut oder sehr gut, nur etwa elf Prozent äußern eine mangelhafte Umsetzung der Datenarchivierung.

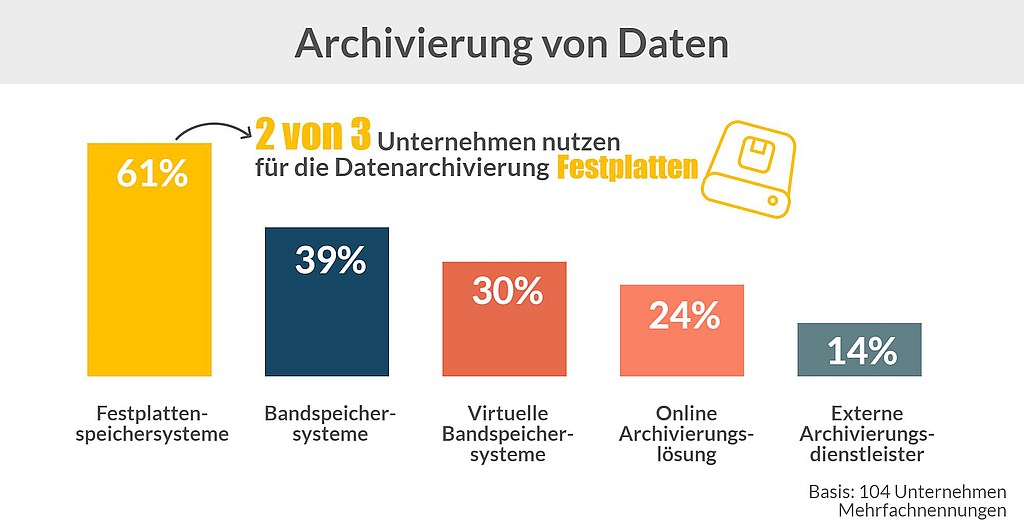

Interessant ist auch das gegenwärtige Vorgehen bei der Archivierung in Data Centern. Es gibt zum einen die Möglichkeit die Archivierung intern oder extern zu lokalisieren und zum anderen die Wahl des Mediums, die meist zwischen Festplatten oder Bandspeichern ausfällt – wobei sich die Geister scheiden, welche Technologie nun besser sei (u.A. bezogen auf RTO, RPO, Gesamtkosten). Die meisten Unternehmen haben unterschiedliche Technologien parallel im Einsatz – das gilt insbesondere für eine steigende Unternehmensgröße. Das kann zum einen die Kombination zwischen Festplatten und Bandspeichern sein, um die Anforderungen an Zugriff und Archivierungsdauer bestmöglich mit den Kosten zu vereinbaren. Oder die Kombination von interner und externer Speicherung, um möglicherweise nicht ausreichende interne Kompetenzen durch spezielles Expertenknowhow eines Dienstleisters zu ergänzen. Ein großer Teil der Unternehmen setzt auf Festplatten, die im Falle von großen HDDs bereits einen Kompromiss zwischen Kosten und Geschwindigkeit darstellen. Größere Unsicherheit gibt es noch bezüglich externer Speicherung. Online-Archivierungslösungen werden tendenziell eher von kleineren Betreibern genutzt, externe Archivierungsdienstleister tendenziell eher von größeren.

Optimized Data Center Benchmark: Ein Tool für den Überblick und zum Vergleich mit anderen Rechenzentren

Optimized Data Center verfolgt das Ziel, Server- und Rechenzentrumsbetreiber aller Größenklassen zu unterstützten, indem es für einen ganzheitlichen Überblick über das eigene Rechenzentrum sorgt. Rund 160 verschiedene Gesichtspunkte aus den Bereichen Rechenzentrumsbetrieb, physische und virtuelle IT-Infrastruktur, Gebäudeinfrastruktur und externen Anbindung können dafür strukturiert im Onlinetool evaluiert und anschließend detailliert ausgewertet werden. Die verschiedenen Angaben werden zu vergleichbaren Indizes aggregiert, die verschiedenen Referenzen wie der Größenklasse, dem Geschäftsmodell oder der Branche gegenübergestellt werden können.

[1] Die Studie wurde von der techconsult GmbH in Zusammenarbeit mit iX und Partnern aus der Anbieterlandschaft für Rechenzentrumslösungen erstellt. Das Benchmarktool und weitere Informationen zur Studie finden Sie auf dem Portal www.optimized-datacenter.de.

Herausforderung E-Mail-Archivierung – Rechtssicherheit und Datenschutz

E-Mail-Archivierung und -Verschlüsselung: So gelingt beides parallel

Studie: Jeder Datenverlust kostet deutsche Unternehmen eine halbe Million Euro

Drei Tipps für maximale Freiheit bei der Auswahl von Hardware für Backup und Recovery