Für einen stabilen und nachhaltigen Einsatz im Unternehmensumfeld haben sich fertige OpenStack-Produkte als die richtige Wahl herauskristallisiert. Denn für einen »Grüne-Wiese«-Ansatz ist OpenStack zu komplex. Zahlreiche kleine und große Technologieanbieter unterstützen hierbei mit Distributionen professionellen Support, Beratungs- und Integrationsleistungen als auch erweiterten Lösungen für das tägliche Management von OpenStack-Infrastrukturen. Worauf gilt es zu achten, um eine OpenStack-Infrastruktur auf Enterprise-Niveau zu betreiben? Crisp Research hat fünf Anforderungen identifiziert, die dafür ausschlaggebend sind.

Verfügbarkeit und Skalierbarkeit

Um die IT-Infrastruktur auf ein Cloud- und DevOps-Modell umzustellen, ist es unausweichlich Cloud-native Anwendungen im Fehlerfall innerhalb einer Cloud zu verschieben. Hierzu sollten die Anwendungen die »Intelligenz« und Kenntnisse besitzen, dass jeder Server, jede Festplatte und die Netzwerkkomponenten zu jeder Zeit ausfallen können. Die Infrastruktur muss daher in Echtzeit laufend überprüft werden. Bei Bedarf ist unverzüglich auf Anomalien zu reagieren. Der Betrieb einer Infrastruktur muss somit hinsichtlich

- Hochverfügbarkeit

- Skalierbarkeit

- Performanz

sichergestellt werden.

Die Skalierbarkeit der Infrastruktur ist eine wichtige Eigenschaft, um die Verfügbarkeit und Stabilität der Workloads zu unterstützen. Es wird damit sichergestellt, dass Applikationen trotz zunehmender Last weiterhin funktionieren. OpenStack selbst ist hochskalierbar. Die Software besteht aus einer lose gekoppelten Architektur und ist in der Lage, bei Bedarf auf Lastschwankungen in Echtzeit zu reagieren. Die Problematik besteht in den meisten Fällen in dem nicht vorhandenen Wissen hinsichtlich Design und Konfiguration der einzelnen Komponenten im Zusammenspiel mit der gesamten Infrastruktur. Eine professionelle Distribution, die auf einer OpenStack-Referenzarchitektur basiert, hilft dabei von Beginn an eine stabile Skalierbarkeit und Performance sicherzustellen, indem bereits alle entsprechenden Komponenten vorab fertig konfiguriert sind.

Management und Sicherheit

Der Aufbau, Betrieb und das Management einer sicheren IT-Infrastruktur ist komplex. Die Annahme, dass sich eine Private Cloud auf Enterprise-Niveau an einem Arbeitstag implementieren lässt und am selben Abend in Produktion geht, entspricht nicht der Realität. Dennoch wird der Faktor Zeit immer mehr zu einem Wettbewerbsvorteil, der nicht unterschätzt werden sollte. Wer eine stabile OpenStack-basierte Cloud verhältnismäßig schnell in Betrieb nehmen möchte, sollte sich auf eine Version konzentrieren, die alle Funktionen für unterschiedliche Deployment-Arten sowie das tägliche Management und Sicherheitsmechanismen beinhaltet. Andererseits werden die dafür verantwortlichen Teams viel Zeit und Aufwand in Anspruch nehmen müssen.

OpenStack wird in der Industrie gerne als das Linux der Cloud bezeichnet. Anders als bei den meisten Linux-Betriebssystemen fängt bei OpenStack die Arbeit nach der Installation erst richtig an. Ein echtes Cloud-Betriebssystem unterstützt den Administrator daher durch:

- Cloud-Management-Tools

- Ein wiederverwendbares Architekturmodell.

- Eine Referenzarchitektur für das Netzwerk.

- Tools für das Logging und Überwachen der Cloud-Infrastruktur.

- Eine Kommandozeile und Schnittstellen (APIs) für die Integration und Automation mit bestehenden und neuen Systemen.

- Graphische Oberflächen (GUI) für die visuelle Darstellung von Analysen.

Unternehmen benötigen eine Private Cloud mit einem verständlichen Sicherheitsmodel, insbesondere auf der Managementebene. Das bedeutet, dass jederzeit der Zugriff durch die Mitarbeiter und andere Nutzer der Infrastruktur erfasst und dokumentiert werden muss. Das funktioniert nur mit einer zentralen Managementkonsole und Zugriffsverwaltung. Weiterhin sollte auf folgende Eigenschaften geachtet werden:

- Zentraler Bereich für die Fehlersuche und -beseitigung.

- Vollständige Trennung des Managementbereichs (OpenStack-Datenbank) von den Daten (Virtuelle Maschinen usw.).

- Aufteilung der Cloud in Zonen mit verschiedenen Sicherheitsbereichen und unterschiedlichen Zugriffsrechten.

- Trennung der Infrastruktur anhand von VLANs auf Netzwerkebene.

Offenes Architekturdesign vs. Vendor Lock-in

Eines der zentralen Werteversprechen von OpenStack ist die Verringerung des Vendor Lock-ins. Dabei sollten CIOs die Marketingversprechungen aus dem Markt mit Vorsicht genießen. Das Verständnis, dass OpenStack zu keinem Lock-in führt, ist falsch. Jedes System hat in irgendeiner Form einen Lock-in. In diesem Zusammenhang ist es daher viel wichtiger zu verstehen, dass durch den Wechsel zu OpenStack das Risiko verändert wird. Durch das offene Architekturdesign erhält die interne IT-Mannschaft zum einen mehr Möglichkeiten, Einfluss und Kontrolle auf die Infrastruktur zu nehmen. Zum anderen können eine Vielzahl externer Anbieter und Lösungen herangezogen werden, um das Open-Source-Framework mit weiteren Funktionen zu erweitern. Mit anderen Worten bedeutet dies, dass OpenStack und dessen offener Architekturansatz lediglich dabei helfen, den Lock-in zu reduzieren, diesen aber niemals vollständig eliminieren werden. Das bedeutet, dass ein Lock-in als etwas Normales eingeordnet werden muss. Anstatt zu versuchen, diesen vollständig zu umgehen, sollten Szenarien evaluiert werden, die vertretbar sind und gleichzeitig einen individuellen Mehrwert bieten.

Hybrid-/ Multi-Cloud-Funktionalität

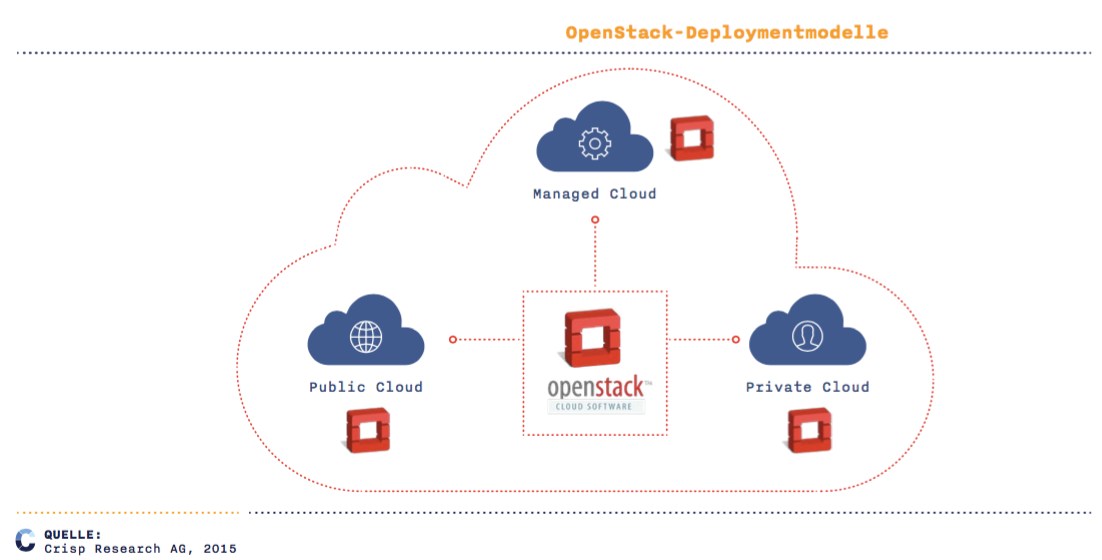

Mit dem Einzug der Cloud in die Unternehmens-IT hat sich eine echte Betriebsalternative für eine Vielzahl unterschiedlicher Workloads etabliert. Dies hat dazu geführt, dass eine weitere Differenzierung der Anbieter und Deployment-Modelle erfolgen muss. Hierbei kristallisiert sich verstärkt heraus, dass unternehmenskritische Workloads (SAP, SCM etc.) nicht in einer Public Cloud betrieben werden, während Web-Workloads und mobile Anwendungen dafür gut geeignet sind. Weiterhin erfordern Test- & Development-Systeme gänzlich andere Cloud-Umgebungen als der Betrieb eines stark frequentierten E-Commerce-Shops. Es zeigt sich somit, dass sich die Workloads hinsichtlich ihrer Anforderungen deutlich unterscheiden. Die Differenzierungen machen sich insbesondere bei den Anforderungen bemerkbar. Dabei wird unterschieden zwischen:

- Skalierbarkeit

- Performanz (I/O oder RAM)

- Verfügbarkeit (SLAs)

- Security

- Kosten

Auf Grund dessen nutzen große Unternehmen als auch Startups meist mehrere Cloud Service Provider und interne Infrastrukturen parallel. Da die Integration auf Daten-, Anwendungs- und Prozessseite aber immer wichtiger wird, kommt der Frage nach der Gestaltung sogenannter Hybrid- beziehungsweise Multi-Clouds eine elementare Rolle zu. Und hier liefert OpenStack einen gemeinsamen Nenner, da die Software zum Provisionieren und Administrieren der verschiedenen Rechen-, Speicher- und Netzwerk-Ressourcen unabhängig von den zugrundeliegenden Hardware-Komponenten und Anbieter-Modellen ist. Durch das mittlerweile gut entwickelte Ökosystem und die Unterstützung vieler namhafter Technologie-Anbieter, kann OpenStack für nahezu alle relevanten Server-, Speicher- und Netzwerk-Komponenten die notwendigen Treiber und Konnektoren bereitstellen.

Standardisierung und Kontrolle

Zu Beginn ihrer Existenz lag der Fokus der meisten Cloud-Anbieter primär darauf, möglichst schnell mit ihrem Portfolio zu wachsen, um sich Marktanteile zu sichern. Das bedeutet, es wurde ein erstes IaaS-Angebot auf den Markt gebracht und versucht, die Kunden auf die Plattform zu ziehen. Allerdings liegt es in der Natur der Sache, dass die IaaS-Anbieter sich auf die eigene Plattform konzentriert haben, um diese als Standard im Markt zu platzieren. Mit einem Multi-Provider- beziehungsweise Multi-Standort-Modell haben sich nur die wenigsten Cloud-Anbieter beschäftigt.

Aus Anwenderperspektive ist das nachteilig, da sich diese von den IaaS-Angeboten ein deutlich höheres Maß an Kontrolle und Standardisierung versprechen. OpenStack macht der Branche hier ein großes Versprechen: Sollte sich die Open-Source-Technologie auf Anbieter- und Unternehmensseite gleichermaßen verbreiten, so könnte sich in den nächsten 3-5 Jahren eine ernsthaft integrierte und verteilte IaaS-Infrastruktur-Landschaft etablieren. Innerhalb dieser lassen sich über Anbietergrenzen hinweg Ressourcen (Rechenleistung, Speicherplatz und Netzwerk) beziehen und vermarkten.

Bereits heute stellt OpenStack allgemeingültige und standardisierte APIs (Schnittstellen) bereit, sowie die Möglichkeit, deutlich mehr Kontrolle über den Cloud-Management-Stack auszuüben, als es bei proprietären Lösungen bisher möglich war. So können Anwender bei Bedarf und einer entsprechenden Expertise individuelle Anpassungen vornehmen sowie Einsicht auf Source-Code-Basis erhalten. Zudem bietet der OpenStack-Entwicklungsprozess die Möglichkeit der Mitgestaltung und Einflussnahme auch für engagierte Anwender.

Die OpenStack-Komplexität gilt es zu beherrschen

Der Aufbau, Betrieb und das Management einer sicheren IT-Infrastruktur ist hochkomplex. Die Annahme, dass sich eine OpenStack-Cloud auf Enterprise-Niveau an einem Arbeitstag implementieren lässt, um am selben Abend in Produktion zu gehen, entspricht nicht der Realität. OpenStack besteht aus zahlreichen Sub-Projekten, einer Vielzahl von Modulen und Add-ons, die alle zusammenspielen müssen. Wer eine stabile Cloud auf OpenStack-Basis relativ schnell in Betrieb nehmen möchte, sollte sich auf eine OpenStack-Version konzentrieren, die alle Funktionen für unterschiedliche Deployment-Arten sowie das tägliche Management und Sicherheitsmechanismen beinhaltet.

René Büst, Senior Analyst / Cloud Practice Lead, Crisp Research