Datenmanagementplattformen können heute deutlich mehr Leistung, Skalierbarkeit, Zuverlässigkeit und Sicherheit anbieten als in den vergangenen zehn Jahren. Während ETL-Prozesse noch mit einem hohen Aufwand für Verwaltung und Wartung einhergehen, können Datenteams mittlerweile auf automatisierte und vollständig verwaltete SaaS-Infrastrukturen zurückgreifen. Niedrige Kosten und verbrauchsabhängige Preismodelle machen es Unternehmen außerdem leichter, Dateninfrastrukturen einzuführen – egal ob großflächig oder anwendungsspezifisch.

Cloud-basierte Plattformen gewinnen rasant an Bedeutung: Einer Schätzung von Gartner zufolge laufen mittlerweile 30 Prozent aller Data-Warehouse-Prozesse in der Cloud – bis 2024 sollen es sogar zwei Drittel sein. Zum Vergleich: 2016 lag der Anteil laut Gartner bei lediglich 7 Prozent.

Um die Vorteile moderner Datenplattformen voll ausschöpfen zu können, braucht es eine zeitgemäße, umfassende und wirksame Datenmanagementstrategie. Folgende Best Practices haben sich bewährt:

1. Komplexe Datenquellen und -ströme

Der CIO ist nicht der alleinige Gatekeeper für Daten im Unternehmen. Und auch er kennt nicht alle Datenquellen, -ströme oder Verwendungszwecke. Denn die Daten werden nicht nur von den eigenen Mitarbeitern erzeugt. Auch Kunden, Partner und diverse digitale Prozesse über interne und externe Systeme sind beteiligt: Praktisch jeder ist mittlerweile in die Erstellung, Aufbereitung und Nutzung von Daten involviert. Und es kommen fortlaufend neue Datenquellen und Anwendungsfälle hinzu. Das gilt es zu berücksichtigen.

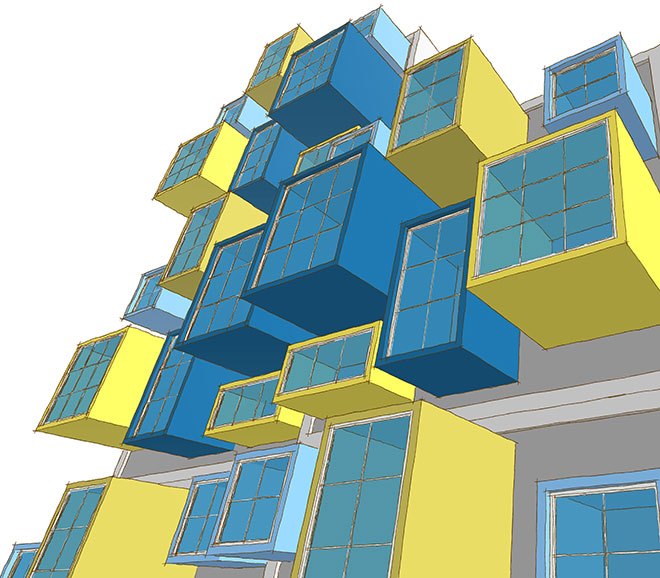

2. Modulare Datenarchitektur

Innerhalb des Data Stack eines Unternehmens gibt es verschiedene Rollen und diverse Möglichkeiten, manuelle Methoden des Datenmanagement zu umgehen. Venture-Capitalist Andreesen Horowitz zeigt in einer Analyse aus dem Jahr 2020 drei exemplarische Architekturen für den Aufbau einer modernen Dateninfrastruktur. Hier werden die dynamischen Komponenten und komplexen Abhängigkeiten in Datenarchitekturen deutlich: Das vollständige Verständnis und die Integration in eine Datenmanagementstrategie erfordern daher eine intensive Auseinandersetzung und entsprechend viel Zeit. Ziel sollte ein modulares Konstrukt sein, das von Anfang an automatisch eine Vielzahl von Datenquellen und Analysemethoden verbinden und strukturieren kann.

Dieser modulare Ansatz ist entscheidend für die Bereitstellung dynamischer, zuverlässiger und automatisierter Datenpipelines sowie konsistente und relevante Ergebnisse. Nur so können Datenteams Schritt halten mit den wechselnden Anforderungen des Unternehmens an die Datennutzung, anstatt einen Großteil ihrer Zeit mit der Pflege veralteter Datenpipelines zu verbringen.

3. Umfassende Skalierbarkeit

Das Datenvolumen wird weiter zunehmen – sowohl die Menge an Rohdaten als auch die Anzahl der Quellen. Dafür gibt es zwei Gründe: spezifische Anwendungen einerseits, und involvierte Nutzer andererseits. Mit steigender Zahl der isolierten oder lose gekoppelten Anwendungen wird die Datenmenge exponentiell wachsen. Diese Daten zu analysieren ist eine zunehmend komplexe Aufgabe, die immer mehr Mitarbeiter in den verschiedenen Bereichen einbezieht. Neue Daten wiederum geben weitere und tiefere Einblicke, die zu datengesteuerten und umsatzwirksamen Geschäftsentscheidungen führen.

Die Skalierbarkeit war früher ein großes Thema, weil dies zusätzliche physische Server im Rechenzentrum erforderte. Der Umstieg auf cloud-basierte Ressourcen macht es heute deutlich einfacher – diese Skalierungseffekte sollten nicht unterschätzt werden: Das 10-fache oder sogar 1000-fache an Speicherkapazität, Rechenleistung und Netzauslastung wirkt sich auf die gesamte Datenarchitektur und alle Prozessabläufe aus.

4. Relevante Stakeholder

Wer sind die relevanten Stakeholder und wie sollen die Daten integriert und genutzt werden? Heute spielen die sogenannten »Citizen Integrators« eine zentrale Rolle für die Datenintegration und -nutzung: Endnutzer ohne jegliche Programmierkenntnisse, welche die Daten vor allem in zweifacher Hinsicht verwenden. Zum einen für stark individualisierte, zeitnahe und genaue Reports, die aus einer zentralen Datenquelle des Unternehmens stammen. Zum anderen für dynamische und fortlaufende Erkenntnisse anhand von Ad-hoc-Analysen im Self-Service.

Um beide Szenarien zu ermöglichen, sind hochgradig standardisierte und zentralisierte Datenverwaltungsfunktionen ebenso erforderlich wie eine dezentrale, endnutzergesteuerte Datenanalyse.

Moderne Datenmanagementlösungen und -prozesse müssen diese Anforderungen austarieren. Nur so lässt sich maximaler geschäftlicher Nutzen aus den Daten ziehen und sicherstellen, dass Datenteams in der Lage sind, die Anforderungen des Unternehmens konsistent zu erfüllen.

5. Grundlegende Prinzipien

Drei Prinzipien sollten in einer Datenmanagementlösung fest verankert sein – Data Governance, Stewardship und Steuerung der Datenströme. Klar definierte, aber dynamische Prozesse und Benutzerrollen sind unerlässlich. Außerdem müssen die Zuständigkeiten und Erwartungen geklärt sein, die komplexe Datenumgebungen mittlerweile erfordern. Und nicht zuletzt braucht es ein Mapping des Datenwertstroms von der Quelle bis zur Nutzung. In Kombination helfen diese drei Grundsätze, Datenverluste zu verringern: Unternehmen können agiler handeln und sich stärker auf eine effiziente Verwaltung der Daten konzentrieren.

Damit diese Best Practices zum Erfolg führen, müssen Strategie, Tools und Prozesse im Unternehmen dynamisch auf sich ständig ändernde Datenanforderungen reagieren können. Die Datenmanagementstrategie muss dabei der Motor – und nicht die Bremse – auf dem Weg zu einem datengesteuerten Unternehmen sein.

Kevin Holler,

Kevin Holler,

Technical Lead DACH,

Fivetran