Modernes Testdatenmanagement bietet DevOps-Effizienz inklusive Zero-Trust-Schutz.

Geschwindigkeit ist für alle Unternehmen von entscheidender Bedeutung und die schnelle Entwicklung neuer Produkte und Dienstleistungen ist der Schlüssel zum Erfolg, insbesondere bei der Software- und App-Entwicklung. Und es gibt neue Herausforderungen, die sich aus dem Bedarf an erhöhter Geschwindigkeit ergeben. Mit der Ausweitung der Datenschutzgesetze und der wachsenden Bedrohung durch Cyberkriminalität müssen IT-Organisationen das traditionelle Testdatenmanagement (TDM) überdenken und moderne Systeme einführen, die den Anforderungen von Entwicklungs- und Testteams gerecht werden.

Neue Situation, neue Lösungen für das TDM. In der Vergangenheit nutzten Entwicklungsteams Daten für die Entwicklung und das Testen in einer isolierten und unstrukturierten Weise. Angesichts der kontinuierlichen Zunahme und Komplexität von Entwicklungsprojekten sehen viele große IT-Organisationen die Möglichkeit, TDM-Funktionen zu konsolidieren und zu zentralisieren, um die Effizienz zu steigern. TDM hat sich zwar angepasst, doch eine Herausforderung bleibt bestehen: Mangelnder Zugang zu hochwertigen Testdaten bedeutet, dass Software-Entwicklungsteams oft mit veralteten Kopien von Produktionsdaten arbeiten müssen, weil die Einrichtung einer neuen Testumgebung zu komplex ist. Dies kann zu Produktivitätsverlusten führen, da Zeit für die Lösung datenbezogener Probleme und die Verwendung riskanter Umgehungslösungen aufgewendet wird.

Die Lösung besteht darin, nicht nur eine effiziente Möglichkeit zur Erstellung von Testdaten zu bieten, sondern auch eine Methode zur effektiven und effizienten Verteilung dieser Daten an die Tester. Der Vorteil ist eine deutliche Verbesserung der Testeffizienz. Testdaten stellen damit keinen Flaschenhals für kontinuierliche Tests, die Testautomatisierung oder die DevOps-Pipelines mehr dar.

Compliance und Cybersicherheit müssen im TDM gewährleistet sein. Testumgebungen sind oft über interne Ressourcen oder in der Cloud verteilt. In der Regel werden sie immer wieder aufgebaut, nach den Tests gelöscht und manchmal sogar vergessen. Das Problem ist, dass Testumgebungen idealerweise mit realen Daten arbeiten und damit allzu oft mit Informationen, die besonders geschützt werden müssen. Diese sensiblen Daten werden jedoch auf beliebigen Servern gespeichert oder sogar per E-Mail zwischen den Entwicklern und Testern ausgetauscht. Daraus ergibt sich eine nicht unerhebliche Sicherheitslücke, die es in Produktionsumgebungen traditionell nicht gibt. Das macht die Testumgebungen viel anfälliger für Datendiebstahl oder Cyberkriminalität.

Datenmaskierung ist ein effizientes Mittel, um den Datenschutz auch innerhalb eines TDM zu gewährleisten, das an schnelle Entwicklungszyklen angepasst ist. Ereignisse wie Solarwinds, wo DevOps für einen groß angelegten Cyberangriff ausgenutzt wurde, zeigen, dass dies notwendig ist. Die Angreifer verschafften sich über ein infiziertes Update der IT-Überwachungs- und Verwaltungssoftware Zugang zu zahlreichen öffentlichen und privaten Organisationen weltweit. Die forensische Untersuchung bestätigte, dass die DevOps-Pipeline von Solarwinds das eigentliche Ziel war. Die Angreifer mussten sich nicht einmal in die Produktionssysteme einhacken, da die Kunden von Solarwinds das infizierte Upgrade selbst installierten, wodurch die Cyberangreifer mit kompromittierten Anmeldedaten Zugang zum Kundennetzwerk erhielten. Von dort aus bewegten sie sich seitwärts durch das Unternehmensnetzwerk und stahlen schließlich große Mengen an Daten.

Leider sind einige Unternehmen immer noch der Meinung, dass der Prozess der Anonymisierung oder Maskierung sensibler Daten nicht mit den Geschwindigkeitsanforderungen von DevOps-Workflows vereinbar ist. Untersuchungen von Delphix bestätigen, dass 56 Prozent der Unternehmen ihre sensiblen Daten in Testumgebungen immer noch nicht anonymisieren.

Aber es ist möglich. Datenmaskierung und modernes TDM sind kompatibel. Mit einer konsequenten Datenmaskierung innerhalb des TDM nach dem Zero-Trust-Prinzip lässt sich diese Herausforderung lösen. Mit der heute zur Verfügung stehenden Technologie ist die Maskierung von Daten bei der Bereitstellung von Testumgebungen kein Engpass mehr.

Viele Datenquellen, hohe Sicherheit. DevOps erfordert eine große Menge an Daten, die schnell und einfach verfügbar sein müssen. Daraus ergeben sich zwei elementare Anforderungen: Die Daten müssen aus vielen verschiedenen Quellen zusammengeführt und vor unberechtigtem Zugriff und Nutzung geschützt werden. Delphix kann für die Testszenarien reale Daten aus vielen Quellsystemen, darunter Mainframes oder Cloud-Container, schnell und in großem Umfang für Cloud-native Apps über SaaS und Private und Public Clouds importieren. Im ersten Schritt werden die Daten über eine Write-once-read-many-Architektur unveränderbar und damit immun gegen Ransomware gemacht. Die Daten werden über eine Virtualisierungsschicht zur Verfügung gestellt, mit dem Ziel, dass keine redundanten Kopien erstellt werden müssen. Der Vorteil ist, dass die Tester immer mit aktuellen Testdaten arbeiten und dass es keine Testdaten-Pools gibt, die nach den Tests die Speichersysteme belasten oder gar an unsicheren Orten vergessen werden. Drittens: Die Daten sind maskiert. In der Praxis werden PII oder sensible Daten mit Hilfe vorkonfigurierter Algorithmen geeigneter Tools schnell identifiziert, unabhängig von ihrer Quelle. Diese werden dann automatisch maskiert oder tokenisiert.

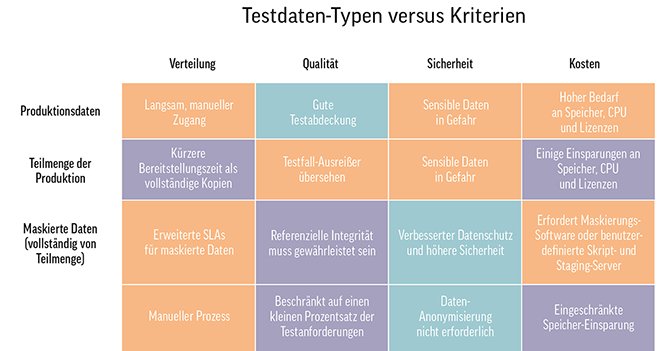

TDM-Anforderungen sind nicht immer gleich – das Toolset. Die Bereitstellung von Testdaten hat oft sehr unterschiedliche Anforderungen an Geschwindigkeit, Menge und Empfindlichkeit, so dass TDM-Tools die verschiedenen Anforderungen und die Kosten für die Bereitstellung flexibel abbilden sollten. Sobald die Anforderungen an die Testdaten ermittelt sind, sollte ein erfolgreicher TDM-Ansatz darauf abzielen, die Verteilung, Qualität, Sicherheit und Kosten der verschiedenen Arten von Testdaten zu verbessern.

Fünf wichtige Aspekte:

- Produktionsdaten bieten eine vollständige Testabdeckung, gehen aber in der Regel auf Kosten der Agilität und der Speicherkosten. Für bestimmte Anwendungen werden in Testszenarien sogar sensible Daten benötigt.

- Teilmengen von Produktionsdaten sind viel flexibler als vollständige Kopien und können Einsparungen bei Hardware-, CPU- und Lizenzkosten bringen. Es kann jedoch schwierig sein, eine angemessene Testabdeckung zu erreichen. Sensible Daten sind bei der Verwendung von Teilmengen oft gefährdet.

- Maskierte Produktionsdaten (entweder vollständige Sätze oder Teilmengen) ermöglichen es Entwicklungsteams, echte Daten zu verwenden, ohne das Risiko zu erhöhen. Maskierungsprozesse ohne geeignete Werkzeuge können jedoch die Datenlieferung verzögern. Außerdem erfordert die Maskierung (ohne Automatisierung) zusätzlichen Speicherplatz und personelle Ressourcen, um die referenzielle Integrität nach der Datenumwandlung zu gewährleisten.

- Synthetische Daten umgehen die Sicherheitsprobleme, sparen aber kaum Speicherplatz ein. Sie sind außerdem nur für einen relativ kleinen Prozentsatz der Testfälle sinnvoll.

- Die manuelle Erstellung von Testdaten ist anfällig für menschliche Fehler und erfordert ein tiefes Verständnis der Datenbeziehungen, sowohl innerhalb des Datenbankschemas oder des Dateisystems als auch der in den Daten selbst implizierten.

Mit der Matrix in Abbildung 1 haben DevOps-Teams die Möglichkeit, das passende Toolset zu bestimmen. Datenvirtualisierung optimiert die Bereitstellung und Verteilung von Testdaten, die Qualität und die Sicherheit und kann die Kosten drastisch senken. Virtuelle Daten, Kopien beliebiger Daten, die in einer relationalen Datenbank oder einem Dateisystem gespeichert sind, teilen sich gemeinsame Blöcke in allen Kopien. Dies ermöglicht Einsparungen von bis zu 90 Prozent beim Speicherplatz.

Virtuelle Daten unterstützen auch die schnelle Bereitstellung von Testdaten zu jeder Zeit über eine API. Dadurch können TDM-Teams nicht nur die Verarbeitung von Testdaten beschleunigen, sondern auch den Rollout von Testdaten an Softwareentwicklungsteams operationalisieren. Und schließlich ist die Datenvirtualisierung in TDM die Voraussetzung für die Datenmaskierung, für den vertrauenswürdigen Schutz sensibler Daten vor unberechtigtem Zugriff oder Cyberkriminalität.

Tu Nguyen,

Tu Nguyen,

Senior Field Marketing Manager

bei Delphix