Die guten alten Storage-Strukturen und -Architekturen scheinen in die Jahre gekommen zu sein. Scale-Up-Storage wie Block-Speichersysteme (vor allem die bekannten RAID-Systeme) und traditionelle NAS-Systeme stoßen in den Zeiten von virtualisierten Serverfarmen und Big Data an ihre Grenzen.

Wieso ist das so? Zum einen beziehen Scale-Up-Plattensysteme – bestehend aus Controller-Einheit und Plattenbereichen – ihre Leistungsfähigkeit hauptsächlich aus den Möglichkeiten des Controllers. Man benötigt eine bestimmte Anzahl an HDDs oder SSDs, um die maximal möglichen Durchsatzwerte in I/O und Transferleistung (MB/s) zu erreichen. Grundsätzlich skalieren diese Systeme aber nur in Bezug auf Kapazität, denn die Performanz des Controllers »dividiert« sich durch die Anzahl der Platten. Das bedeutet: jede Erweiterung lässt ab einem bestimmten Füllgrad die Performanz pro TB sinken.

Zum anderen sind gerade die Block-basierenden Plattensysteme in einer besonderen Weise Cache-optimiert, so dass sie sich sehr gut auf das Schreib-Lese-Verhalten einer Applikation einstellen können. Hot-Spots werden in den Cache verlagert, wodurch das Gesamtsystem schneller als die verwendeten Platten wird. In der virtualisierten Welt wird das zentrale Speichersystem mit Schreib-Lese-Anfragen der unterschiedlichsten Applikationen bombardiert, ohne dass dabei erlernbare Muster entstehen. Dieses Phänomen ist als I/O-Blender bekannt. Der Cache wird dadurch praktisch nutzlos. Die Performanz sinkt spürbar.

Und last but not least: CIFS- und NTFS-basierende NAS-Systeme können die Unmengen an Files, die beispielsweise Big-Data-Analysen benötigen, aus mehreren Gründen nicht beherrschen; beispielsweise schon allein durch die bestehenden Limitierungen der maximalen Volumengröße. Was sind mögliche Alternativen?

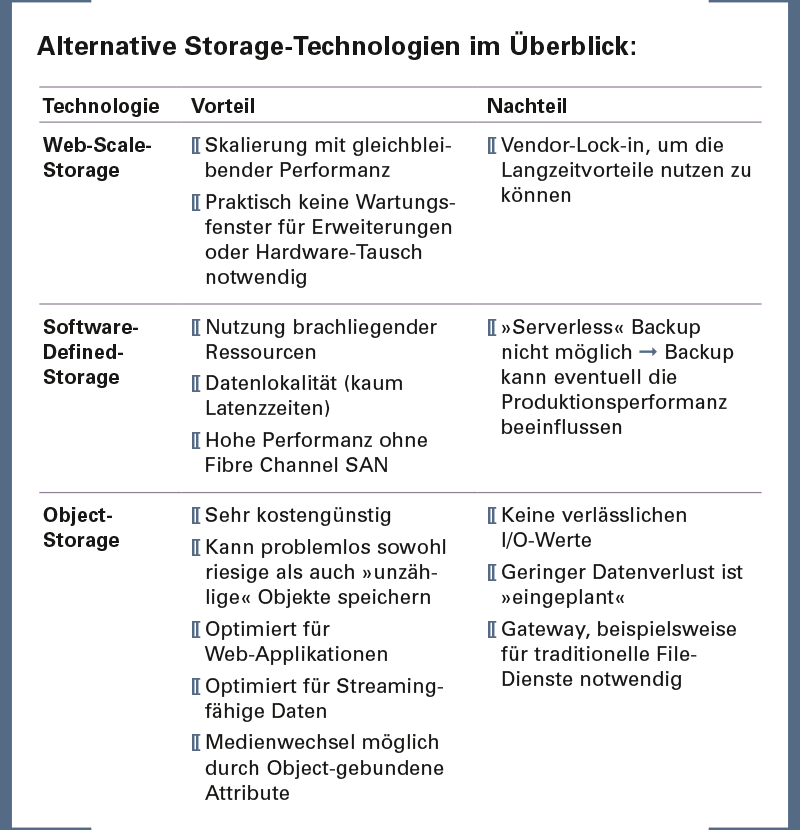

Web-Scale- oder Hyper-Scale-Storage mit Scale-Out-Architekturen (Storage Grids) versprechen unbegrenzten Speicherplatz bei gleichbleibender Performanz. Außerdem soll die Aufbewahrungsdauer der Daten praktisch unlimitiert sein, ohne dass aufwendige Migrationsverfahren bei Erweiterungen und Austausch der Hardware notwendig wären.

Das ist keine Zukunftsmusik. Schon seit Jahren bieten etablierte Hersteller sowohl File- als auch Block-basierende Storage-Systeme an, die sich aus gleichartigen Modulen zusammensetzen. Jedes einzelne Modul verfügt sowohl über Controller- als auch über Storage-Anteile. So wird mit jeder Erweiterung dem Gesamtsystem nicht nur Kapazität, sondern auch I/O-Leistung und Durchsatz hinzugefügt. Eine Anpassung an die Anforderungen des Unternehmens wird durch unterschiedliche Ausprägungen der Module in Bezug auf Controller-Leistung, Storage-Performance und -Kapazität erreicht. Selbstregulierende Mechanismen in der steuernden Software sorgen für eine gleichmäßige Auslastung über alle Module und für ein automatisches Storage-Tiering. Besagte Software sorgt auch dafür, dass fehlerhafte oder zum Austausch anstehende Module automatisch »freigeräumt« und die dort befindlichen Daten auf die anderen Module verteilt werden. Ebenso lassen sich Erweiterungs- und Austausch-Module ohne Down-Time des Gesamtsystems in das Grid einfügen und automatisch in das kapazitive und leistungsbezogene Load Balancing integrieren.

Software-Defined-Storage – im Sinne von vSAN von VMware oder Scale I/O von EMC – adressiert unter anderem das Problem des I/O-Blendings. Die Hardwaregrundlage dieser Storage-Lösung sind handelsübliche x86-Server. Wie beim Web-Scale-Storage ist auch hier die Basis-Topologie ein Grid. Alle in den Servern verbauten Platten (SSDs und HDDs) werden logisch zu einem Storage-Pool zusammengefasst, der allen Servern des Verbundes zur Verfügung steht. So können durch diese Zusammenfassung der Ressourcen die Applikationen mit ausreichend Storage versorgt werden, ohne aufwendige SAN-Strukturen aufbauen zu müssen. Bisher ungenutzter Speicherplatz in Serverfarmen kann auf diese Weise zur Verfügung gestellt werden (viele dieser Server haben noch eingebaute Disks und nutzen nicht die volle Kapazität der eingebauten Platten für den Hypervisor).

Ein weiteres wichtiges Einsatzgebiet sind Applikationen mit geringer Toleranz hinsichtlich der Latenzen. Die Software sorgt in jedem Fall dafür, dass die von der Applikation benötigten Daten auf derselben Hardware liegen wie der zugehörige Workload. Diese Art der Datenhaltung ist optimiert Latenzen zu verhindern, die durch Distanzen entstehen. Eingebaute Tiering-Mechanismen ermöglichen die optimale Nutzung der wenigen notwendigen SSDs im Verbund. Und die vom System vorgegebene Vorgehensweise – alle Daten redundant vorzuhalten – sorgt zusammen mit der intelligenten Verteilung der »Spiegel-Daten« dafür, dass Hardwareausfälle abgefangen werden. Die Systeme sind somit in sich hoch-resilient ohne Performance-Einbußen, wie sie von Wiederherstellungsvorgängen bei RAID-Systemen bekannt sind.

Object-Storage ist in dieser Zusammenfassung von aktuellem Alternativ-Storage das scheinbar jüngste Mitglied. Allerdings wirklich nur scheinbar, denn Object-Storage wird im Archiv-Bereich schon seit Jahrzehnten erfolgreich eingesetzt. Praktisch alle Cloud-Storage-Anbieter verwenden Object-Storage; und wenn Sie Fotos und Videos bei Facebook oder Flikr hochladen, nutzen auch Sie schon diese Art der Speicherung. Welche aktuellen Anforderungen an die Datenhaltung adressiert nun Objekt-Storage genau?

- Skalierung: Dank der sehr flachen Struktur und der besonders platzsparenden Art der »Verwaltungs-Datenbank« von Object-Storage skaliert diese Speichertechnologie in bisher nicht erreichte Größenordnungen. Damit ist dieser Storage extrem gut geeignet, um beispielsweise Industrie-4.0-Sensor-Daten im Petabyte-Bereich oder andere Big-Data-Dateien aufzunehmen.

- Rechte, Life-Cycle etc.: Zu jedem Objekt gehören Metadaten – Attribute wie etwa Zugriffsrechte und Aufbewahrungsdauer – die File-Sharing- und Tiering-Mechanismen nativ unterstützen. Damit ist Object-Storage prädestiniert für Langzeit-Archive. Wenn Rechte und Aufbewahrungsfristen nicht in der Archivierungs-Appliance oder -Software (allein), sondern an den einzelnen Objekten abgespeichert werden, ist es möglich, die zugrundeliegende Hardware, ja sogar die genutzte Medienart, zu tauschen, ohne dass es notwendig ist, die Archiv-Parameter aufwendig zu migrieren.

- Kosten: Object-Storage-Systeme bestehen in den meisten Fällen aus Standard-x86-Servern, auf denen die Verwaltungssoftware läuft. Sie nutzen direkt angeschlossenen JBODs (intelligenzlose Plattengehäuse – just a bunch of disks) zur Bereitstellung des notwendigen Speichervolumens. Verbunden sind sie durch eine 10-GB-Ethernet-Infrastruktur mit Load Balancern zur gleichmäßigen Verteilung der Daten. Die Software-seitig eingebauten Sicherungsmechanismen sind bezüglich der Ratio Netto-Brutto-Kapazität jedem RAID-System überlegen, was zu geringeren Kosten pro TB Nutzkapazität führt. Kostspielige Storage-Controller-Einheiten und Fibre-Channel-SANs werden nicht benötigt, was die Gesamtkosten zusätzlich senkt. Service-Provider nutzen diesen Vorteil, um günstig Speicherplatz anzubieten, zum Beispiel für Backup in die Cloud.

Alles in allem ist Object-Storage sicher eine Technologie mit Zukunft. Allerdings ist zum heutigen Zeitpunkt auf einige Besonderheiten hinzuweisen:

- Object-Storage ist weder Block- noch File-Storage. Für Applikationen, die nicht für Object-Storage geschrieben wurden, muss geprüft werden, ob sie mit einem Gateway zusammenarbeiten können.

- Durch die extrem weitläufige Verteilung der Daten-Chunks über den gesamten Speicherverbund ist es unmöglich, I/O-Werte zu garantieren oder auch nur annäherungsweise vorauszusagen.

- Backup- oder Verfügbarkeits-Mechanismen wie Spiegelung oder Replikation sind nicht vorgesehen. Die Art und Weise der Hash-Werte- und Chunk-Verteilung auf möglichst viele unterschiedliche Komponenten des Systems ist die einzige Art der Risikominimierung.

Fazit. Storage ist angeblich ein Commodity-Produkt geworden. Und trotzdem ist Storage so spannend wie nie. Wie in den vergangenen Jahrzehnten gibt es »All-in-One«-Systeme, die unter Umständen genau Ihre Anforderungen erfüllen. Auf jeden Fall wird es auch weiterhin immer wieder neue Anforderungen geben, die innovative und manchmal sogar revolutionäre Konzepte benötigen.

Angelika Stiehl,

Angelika Stiehl,

Business Development Manager

Application Delivery/Data Center

bei Controlware GmbH

www.controlware.de