Es gibt viele Ansätze, Rechenzentren effizienter zu machen und weniger Strom zu verbrauchen, von der Art der erzeugten Elektrizität bis hin zur Aktualisierungsrate neuer Technologien. So können der Standort eines Rechenzentrums, die Nutzung erneuerbarer Energie, das Design des Rechenzentrums, die Flüssigkeitskühlung und die Auswahl geeigneter Server für das RZ den Strombedarf und die Kosten erheblich reduzieren.

Rechenzentren benötigen global zwischen zwei und vier Terawatt (TW) Strom pro Jahr (etwa 1 bis 3 % des weltweiten Energieverbrauchs) und es wird erwartet, dass der Verbrauch bis 2030 um 2 bis 8 % steigt [1]. Hyperscale-Rechenzentren sind im Allgemeinen am energieeffizientesten, Colocation-Rechenzentren etwas weniger und interne Rechenzentren am wenigsten – gemessen an den Kohlenstoffemissionen pro Arbeitslast [2]. Nach Angaben der Synergy Research Group gibt es weltweit etwa 659 Hyperscale-Rechenzentren [3]. Während die Nachfrage nach digitalen Diensten aufgrund von Effizienzsteigerungen viel schneller steigt als der Energieverbrauch, müssen die Betreiber und Planer von Rechenzentren Praktiken einführen, die den Energiebedarf senken, damit Regierungen und Unternehmen ihre Umweltziele erreichen können. Von der Wahl des Standorts eines Rechenzentrums bis hin zur Auswahl der Mikroprozessoren gibt es zahlreiche Möglichkeiten, wie Entwickler und Betreiber von Rechenzentren die Umweltauswirkungen des Rechenzentrums reduzieren können.

Weltweit werden derzeit etwa 80 % der Elektrizität durch die Verbrennung fossiler Brennstoffe (Kohle, Gas, Öl) erzeugt, wobei dies je nach Region unterschiedlich ist. Rechenzentren konsumieren immer noch beträchtliche Mengen an Netzstrom, der mit fossilen Brennstoffen erzeugt wird, um den Energiebedarf zu decken, obwohl einige Rechenzentren – und Unternehmen, die sie nutzen – auf erneuerbare Energiequellen umsteigen oder sich entsprechende Ziele gesetzt haben.

Überlegungen zum Standort. Große Rechenzentren kosten eine Menge Geld. So kann beispielsweise ein einziges Hyperscale-Rechenzentrum 100 MW Strom benötigen, damit Server, Speicher und Netzwerkinfrastruktur wie erwartet funktionieren (genug, um 80.000 Haushalte mit Strom zu versorgen) [4]. Darüber hinaus verbraucht die Elektronik den größten Teil der in einem Rechenzentrum benötigten Energie, und die Kühlung dieser Elektronik zur Aufrechterhaltung der Betriebstemperatur kann 40 % der Energie der Anlage in Anspruch nehmen.

Die Gebäudekosten setzen sich aus dem Grundstückswert und den Baukosten zusammen. Die Baupreise variieren je nach Region des Landes und der Welt. Anders als beim Bau eines Hauses oder eines Bürogebäudes gelten für den Standort eines Rechenzentrums einige besondere Anforderungen, um als »grün« zu gelten und die vereinbarten Service Level Agreements (SLAs) zu erfüllen.

Eine verteilte digitale Infrastruktur bedeutet, dass die IT-Infrastruktur eines Unternehmens mehrere Standorte haben kann, von denen einige eine größere Nähe zum Geschäftsbetrieb benötigen als andere. Zu viele Rechenzentren befinden sich in heißen oder gemäßigten Klimazonen, ohne dass es dafür eine vernünftige geschäftliche Rechtfertigung gibt [5]. Rechenzentren in kühleren Klimazonen können Außenluft zur Kühlung verwenden, wodurch der Bedarf an Klimageräten für Computerräume (CRAC) reduziert wird. Außenluft kann direkt in das Rechenzentrum geleitet werden (nachdem sie einen Filtermechanismus durchlaufen hat), um kühle Luft bereitzustellen, in der Regel eine CRAC-Einheit. Schlechte Luftqualität kann jedoch die Effizienz der Außenluftzufuhr beeinträchtigen. Auch wenn dadurch die Stromkosten gesenkt werden können, können abgelegene Standorte, an denen Immobilien weniger teuer sind, auch relativ weit von Internetvermittlungsstellen entfernt sein, was zu höheren Latenzzeiten für die Kunden führt. Der Anschluss eines Rechenzentrums an mehrere Netzbetreiber kann erforderlich sein. Bevor Sie ein Rechenzentrum in einem kälteren Klima errichten, sollten Sie sich darüber im Klaren sein, woher die Energie kommt. So sind beispielsweise viele Kunden im Nordosten der Vereinigten Staaten auf Stromimporte aus dem mittleren Teil des Landes angewiesen, der große Mengen fossiler Brennstoffe für die Erzeugung benötigt.

Einige Standorte mit kühlerem Klima können natürliche Kühlungsvorteile bieten. Nehmen wir zum Beispiel an, ein Rechenzentrum befindet sich in der Nähe eines mäßig kalten Gewässers. In diesem Fall können Systeme so konstruiert werden, dass das Kühlsystem das nahe gelegene Wasser anzapfen kann. Ein geschlossener Kreislauf kann das Wasser mit der niedrigeren Temperatur, etwa aus einem Fluss, in ein internes Kühlsystem leiten. Infolgedessen wird für die Kühlung der normalen Wasserzufuhr viel weniger Energie benötigt.

Nutzung erneuerbarer Energien. Die Energiequelle eines Rechenzentrums hat den größten Einfluss auf die CO2-Bilanz und bietet die größte Chance, die Umwelt zu entlasten. In der Regel entscheidet der Betreiber eines Rechenzentrums über die Energiequelle für alle Nutzer einer Einrichtung. Viele Rechenzentren, darunter auch viele Colocation-Rechenzentren, werben mit dem Ziel, Energie aus 100 % erneuerbaren Quellen zu gewinnen. Aus einer kürzlich durchgeführten weltweiten Umfrage geht jedoch hervor, dass in allen Rechenzentren derzeit weniger als 15 % der Energie aus erneuerbaren Quellen stammt [6].

Zu den Programmen für erneuerbare Energien für gewerbliche Kunden gehören die Stromerzeugung durch das Versorgungsunternehmen selbst, Stromabnahmevereinbarungen (PPA) mit Dritten oder Gutschriften für erneuerbare Energien (REC). Die dezentrale Erzeugung erneuerbarer Energien, die sich im Besitz oder unter der Kontrolle von Rechenzentren befindet, ist optimal. Aber die erneuerbaren Energiequellen vor Ort können den Energiebedarf von Rechenzentren nicht immer decken. Glücklicherweise kann saubere Energie aus dem Netz diesen Bedarf ergänzen. Es gibt auch immer effektivere Energiespeicherlösungen für den Einsatz vor Ort, deren Kosten mit der Verbesserung und Erweiterung der Batterietechnologie sinken.

Design von Rechenzentren. Server erzeugen Wärme, die für einen ordnungsgemäßen Betrieb aus den Systemen abgeführt werden muss. Mehrere Methoden sind heute üblich, um diese Wärme abzuführen, wie beispielsweise die Wärmeabfuhr aus dem Inneren des Gehäuses mit Lüftern, die Versetzung von Racks, um heiße und kalte Gänge zu ermöglichen, und die Bereitstellung einer ausreichenden Deckenhöhe, damit die Wärme nach oben entweichen kann. Und wie Supermicro bereits dokumentiert hat, muss nur so viel Wärme abgeführt werden, wie nötig ist, um die Einlasstemperaturen unter der maximalen Betriebstemperatur zu halten und so Energie für die Kühlung zu sparen.

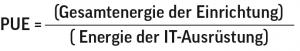

Die von der IT-Ausrüstung in Rechenzentren erzeugte Wärme ist ein entscheidender Faktor für die Maximierung, denn es gibt Hinweise darauf, dass bis zu 98 % des Stroms eines Rechenzentrums, der für die IT-Ausrüstung verwendet wird, in Form von minderwertiger Wärme verloren geht. Das Maß für die Effizienz eines Rechenzentrums im Hinblick darauf, wie viel Strom für die Kühlung und andere Aktivitäten verbraucht wird, die nicht der Berechnung, Speicherung oder Vernetzung dienen, ist als Power Usage Effectiveness oder PUE bekannt. PUE ist definiert als:

Die insgesamt an das Rechenzentrum gelieferte Energiemenge wird durch die für Server, Speicher- und Netzwerksysteme verbrauchte Energiemenge geteilt.

Ein PUE-Wert von 1,0 bedeutet, dass die gesamte an das Rechenzentrum gelieferte Energie für Server, Speicher und Netzwerke verwendet wird. Ein PUE-Wert von 1,50 bedeutet, dass für jede Energieeinheit, die für die Infrastruktur verbraucht wird, weitere 0,5 Einheiten für andere Funktionen verbraucht werden, hauptsächlich für die Kühlung. Einige sehr effiziente Rechenzentren weisen inzwischen einen PUE-Wert von unter 1,10 auf. Im Gegensatz dazu bewegen sich die meisten Rechenzentren heute im Bereich von 1,50 bis 1,60, wobei der Branchendurchschnitt bei 1,57 liegt und Europa mit 1,46 den niedrigsten PUE-Wert aufweist [7].

Herkömmliche Methoden zur Wärmeabfuhr aus einem Server bestehen darin, kühlere Luft über die elektronischen Komponenten zu leiten, wo die heiße Luft aufsteigt und aus dem Gehäuse ausgestoßen wird. Normalerweise erfolgt der Luftstrom von vorne nach hinten (wie in einem Rack), wobei die Lüfter an der Rückseite des Servers die Luft durch den Server ziehen. Bei mehreren Servern in einem Rack erzeugt die heiße Luft von allen Servern eine sehr warme/heiße Zone hinter dem Rack. Wenn mehrere Racks nebeneinander aufgestellt werden, steigt die Gesamtmenge der heißen Luft, die von der Rückseite der Server ausgestoßen wird. Um eine angemessene Kühlung zu gewährleisten, müssen die Rack-Reihen so installiert werden, dass die Rückseiten der Racks einander zugewandt sind, wodurch ein Warmgang entsteht. Bei der Planung eines Rechenzentrums empfiehlt es sich, heiße Gänge und kalte Gänge vorzusehen. Dies hat den Vorteil, dass die warme/heiße Luft von der kühleren Luft getrennt wird.

Das Konzept der kalten und warmen Gänge ist dann sinnvoll, wenn dies der Fall ist:

- Eingrenzung – die Schaffung eines Kalt- und eines Warmgangs ist nur dann sinnvoll, wenn die warme oder kalte Luft von der jeweils anderen Art isoliert ist.

- Systeme zur Abführung der zu kühlenden Warmluft – Die Klimatisierung von Computerräumen funktioniert besser, wenn die Warmluft in das Kühlsystem zurückgeführt wird.

Die Planung eines Rechenzentrums mit Warm- oder Kaltgängen hängt von mehreren Faktoren ab, wobei der wichtigste Faktor die Anfangsinvestition ist. Die Kaltgangeinhausung ist in der Regel kostengünstiger, da hierfür nur Türen und ein Dach erforderlich sind. Außerdem ist die Einrichtung unkomplizierter, und wenn zusätzliches Wachstum erforderlich ist, sind die Erweiterungskosten geringer.

Bei den meisten Warmgang-Konfigurationen handelt es sich um Doppelböden, die in der Regel effizienter und effektiver bei der Reduzierung der Umgebungstemperatur für die Datenverarbeitung sind. Der Nachteil sind die anfänglichen Kosten für den Bau eines Rechenzentrums mit Doppelböden und Rohrleitungen. Dennoch ist der langfristige Kosten-Nutzen-Effekt größer als bei einer Konfiguration mit kalten Gängen, wenn sie mit Hilfe von Best Practices optimiert wird.

Die Vorteile der thermischen Energie können über den Serverraum hinausgehen. Thermoelektrische Geräte können die Wärme der Server auffangen und in Strom für andere Anwendungen umwandeln. Ein innovativer Ansatz wird beispielsweise derzeit bei GLeSYS9 in der Stadt Vastberga, Stockholm, Schweden, verfolgt, wo die heiße Luft zu einem nahe gelegenen Heizwerk gepumpt wird, wodurch der Heizbedarf der umliegenden Städte gesenkt wird. Die thermische Nutzung der nächtlichen Abkühlung kann auch Rechenzentren zugutekommen. Die thermische Energiespeicherung (TES) ermöglicht es, Kälte in verschiedenen Medien aufzufangen, zu speichern und tagsüber zu nutzen, um den Bedarf an Klimaanlagen oder Prozesskühlung zu decken. Die Maximierung der thermischen Energievorteile kann tatsächlich zu einem PUE-Wert von weniger als 1,0 führen, nämlich dann, wenn die von den Servern erzeugte Wärme in die Anlage zurückgeführt wird.

Rack-Konstruktion. Racks können verschiedene Server und Speichersysteme aufnehmen, da die Racks standardisierte Breiten und Tiefen haben. Während sich die an das Rack gelieferte Leistung aus der Summe der einzelnen Serveranforderungen ergibt, besteht ein Vorteil der Nutzung eines Großteils der verfügbaren Rack-Einheiten darin, dass weniger Quadratmeter benötigt werden, um eine bestimmte Menge an Rechenleistung oder Speicherkapazität zu unterstützen. Durch die Nutzung einer kleineren Fläche für eine bestimmte Anzahl von Servern wird also die Größe eines Rechenzentrums reduziert oder mehr Rechenleistung auf einer bestimmten Fläche ermöglicht. Die Betreiber von Rechenzentren müssen sich jedoch auch darüber im Klaren sein, wie viel Gewicht der Boden eines Rechenzentrums tragen kann.

Server-Konstruktion. Obwohl Server in Rechenzentren viele der gleichen wesentlichen Teile und die gleiche Architektur haben, gibt es Innovationen im Serverdesign, die zu einem geringeren Stromverbrauch bei einem bestimmten Leistungsniveau führen können. Das Server Efficiency Rating Tool (SERT), das von der US-Umweltbehörde EPA und der Standard Performance Evaluation Corporation entwickelt wurde, bewertet den Stromverbrauch in Abhängigkeit von der CPU-, Arbeitsspeicher- und Speicherauslastung und ermöglicht so die Beurteilung von Serverdesigns. CPUs mit geringerer Leistung verbrauchen weniger Strom, bieten aber möglicherweise nicht die erforderlichen SLAs oder die für bestimmte Arbeitslasten erforderliche Leistung. Darüber hinaus wird die Wärmeentwicklung bei Servern, die für hohe Leistung ausgelegt sind, zu einem Problem, da die CPUs mit ihrer maximalen thermischen Auslegungsleistung (TDP) arbeiten. Die Herausforderung besteht darin, physische Hardware zu entwickeln, die die Wärme von CPU, GPU und anderen Komponenten aus dem System ableitet, gemessen in Watt oder Kilowatt.

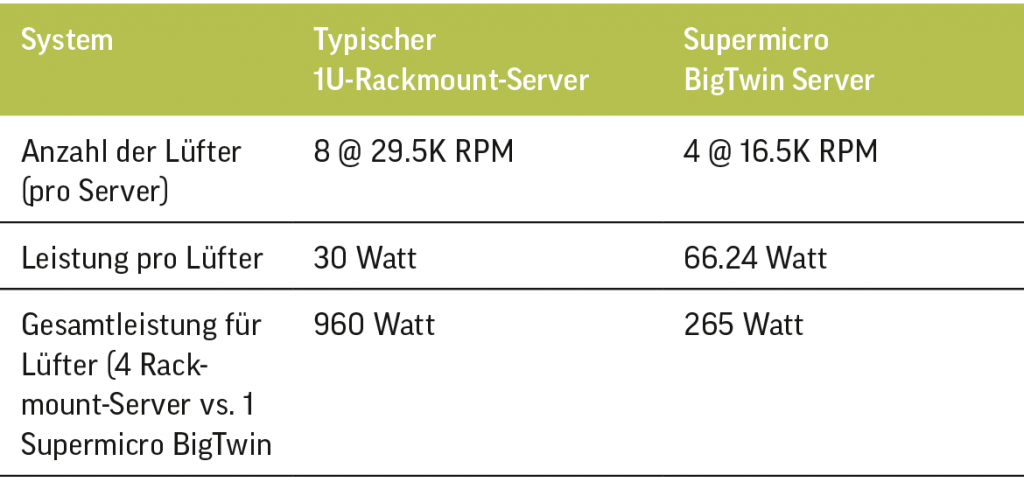

In den meisten Rechenzentren saugen mechanische Lüfter kühlere Luft über die Komponenten und auf der Rückseite des Servers ab. Je nach den physikalischen Beschränkungen und der Luftmenge in Kubikfuß pro Minute (CFM), die über die Komponenten gesaugt werden muss, werden unterschiedlich große Lüfter ausgewählt. Je heißer die CPUs werden, desto höher muss die Drehzahl der Lüfter sein. Server der Rechenzentrumsklasse sind mit mehr als einem Lüfter ausgestattet, sowohl wegen der Redundanz als auch wegen der Anforderungen an den Luftstrom. Die Größe des Lüfters und die erforderliche Drehzahl können in Abhängigkeit vom Luftstrom und dem verfügbaren Platz bestimmt werden. Bei der Konstruktion von Servern gibt es jedoch Möglichkeiten, den Stromverbrauch von mechanischen Lüftern zu reduzieren. So verbrauchen größere Lüfter, die sich langsamer drehen, weniger Energie als kleinere Lüfter, die sich schneller drehen. Wenn unabhängige Server so konzipiert sind, dass sie sich größere Lüfter teilen, kann die Lüftergeschwindigkeit den Stromverbrauch senken (Tabelle 1).

Lüftervergleich

Vergleich der äquivalenten Rechenleistung von vier typischen Ein-Sockel-Rack-Servern mit der eines Multiknoten-Servers, der vier Rechenknoten enthält:

Tabelle 1: Vergleich der Lüfterleistung.

Um gleichwertige CPUs zu kühlen, die eine rechenintensive Arbeitslast ausführen, so dass die Lüfter ununterbrochen arbeiten, verbraucht ein Supermicro BigTwin-System nur 27 % des Stroms für die Lüfter.

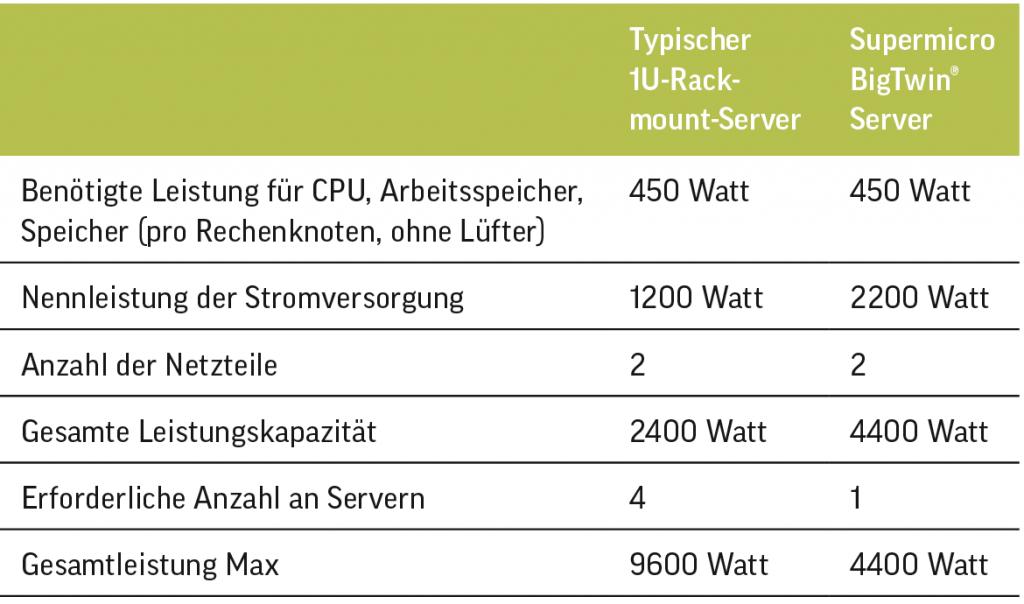

Wenn sich außerdem zwei Knoten ein größeres Netzteil teilen können, kann das Netzteil effizienter arbeiten, was die Verlustleistung reduziert und zu geringerem Stromverbrauch führt. Tabelle 2 zeigt einen Vergleich von zwei gleichwertigen Systemen mit gemeinsam genutzten Netzteilen.

Daher nutzt ein Supermicro-BigTwin-Server einen höheren Prozentsatz der verfügbaren Stromversorgung, was effizienter ist.

Tabelle 2: Vergleich der Stromversorgungen.

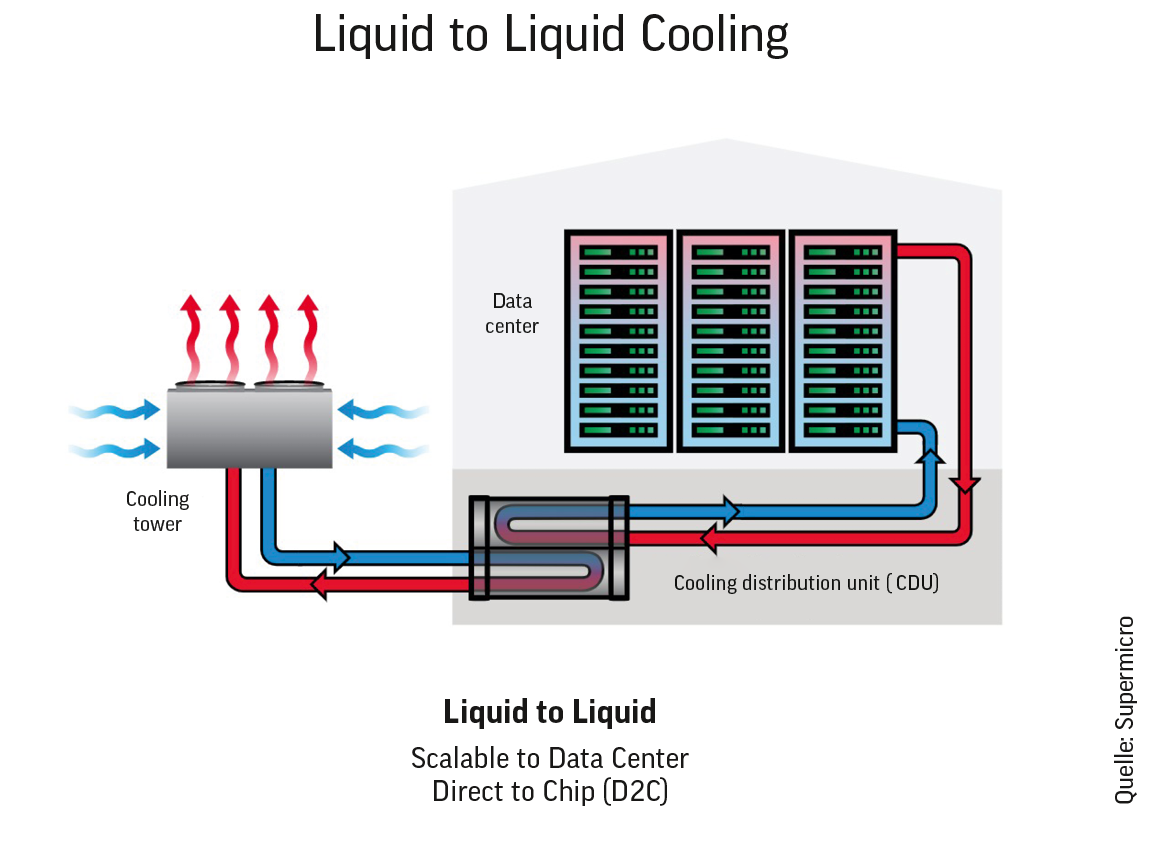

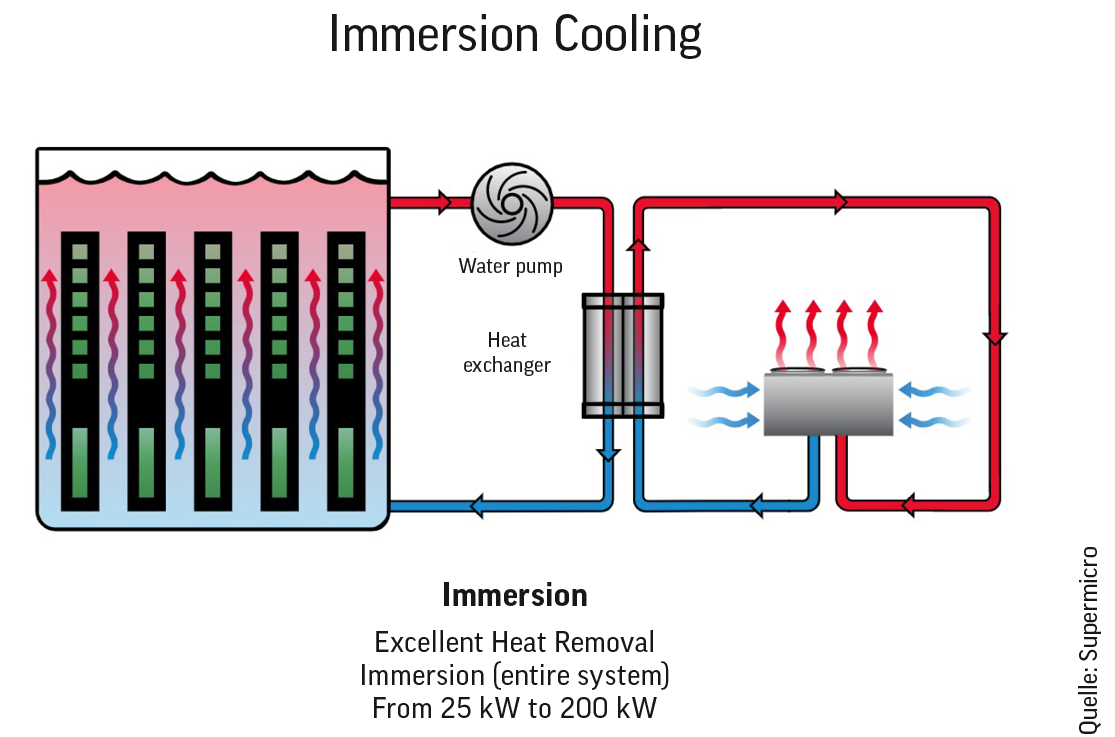

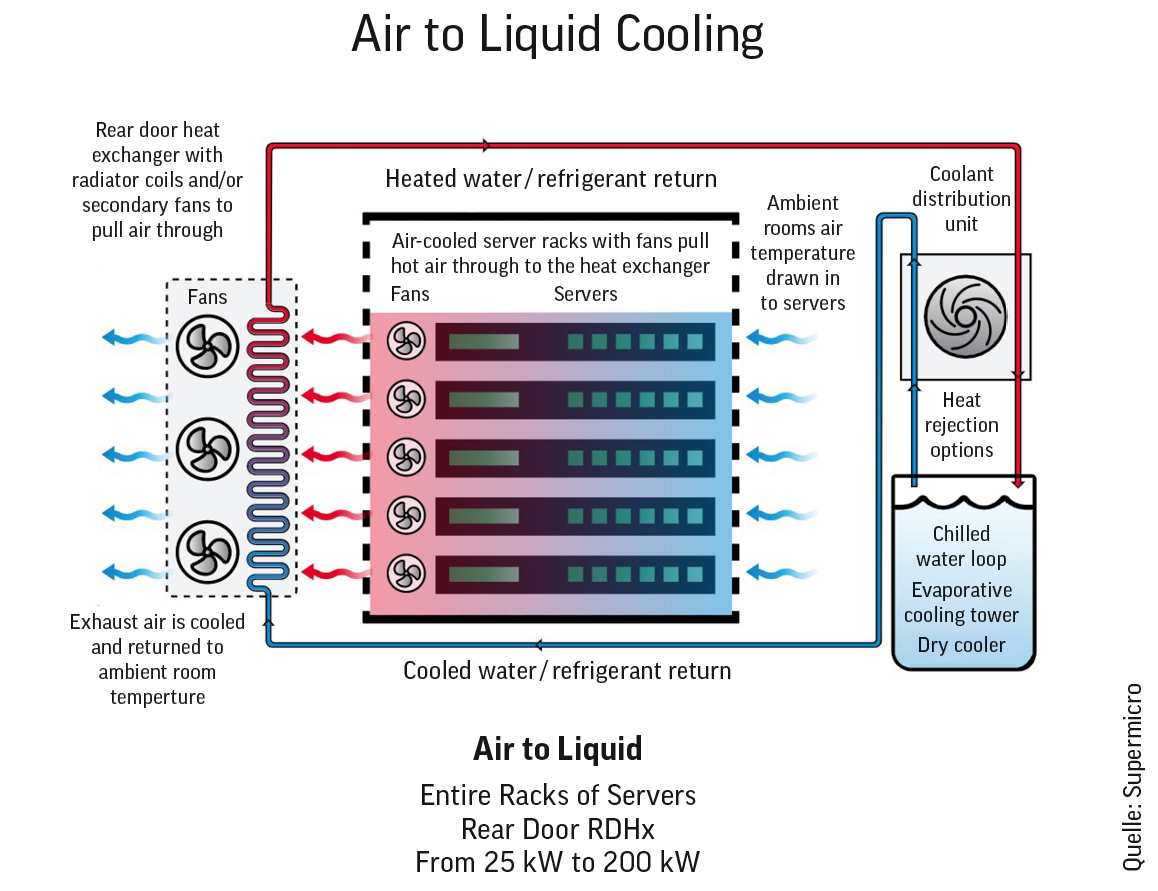

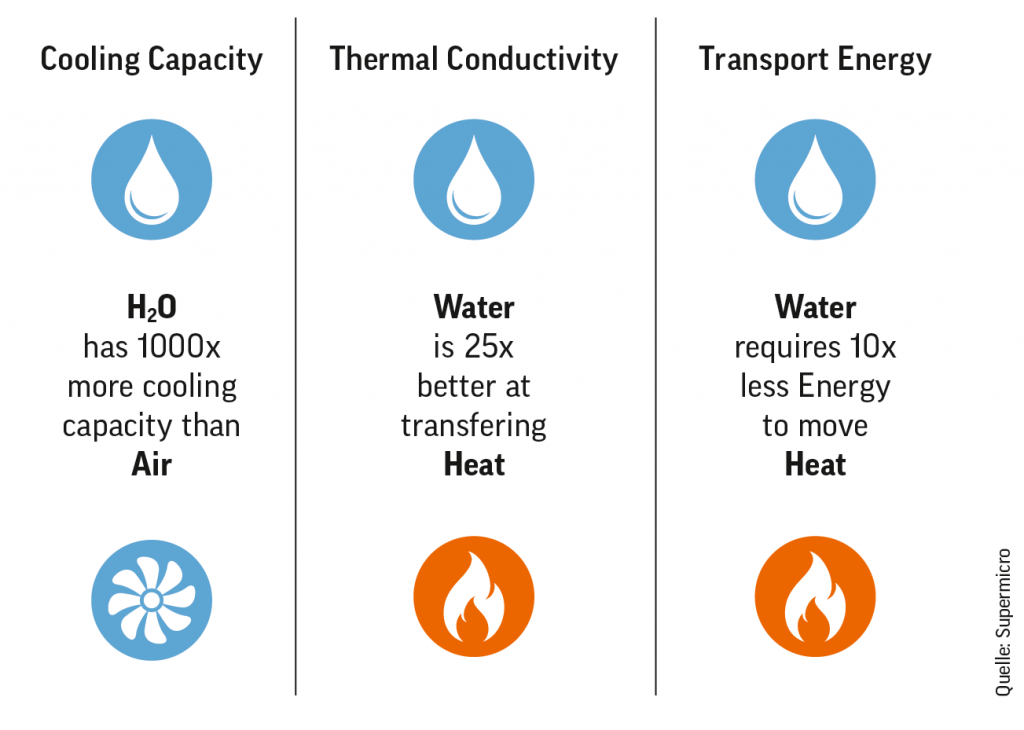

Flüssigkeitskühlung. Während luftgekühlte Systeme in Rechenzentren am häufigsten anzutreffen sind, gewinnt die Flüssigkeitskühlung an Popularität und Interesse, da Server CPUs und GPUs mit höherer Leistung verwenden. Die Luftströmung stößt bei der Kühlung eines Systems an ihre Grenzen, während die Flüssigkeitskühlung die geforderten Kühlungsspezifikationen erreichen und übertreffen kann. Da Flüssigkeit eine etwa 1000-fach höhere Kühlkapazität als Luft hat, ist die Installation eines Flüssigkeitskühlsystems eine effektivere Kühlmethode. Es gibt mehrere Möglichkeiten, bei denen eine Flüssigkeit entweder zur Unterstützung der Luftkühlung oder ausschließlich zur Kühlung der elektronischen Komponenten verwendet wird (siehe Grafik). In den Fällen der Direktkühlung und der Tauchkühlung wird zwar etwas Energie für die Bewegung und Kühlung der Flüssigkeit verbraucht, aber die Umluftkühlsysteme müssen nicht so intensiv betrieben werden, und die Lüfter in den Systemen können abgeschaltet oder der Stromverbrauch erheblich reduziert werden. Flüssigkühlung, die im gesamten Rechenzentrum eingesetzt wird, kann den Energieverbrauch drastisch senken, vor allem, wenn CPUs und GPUs mit höherer Wattzahl entwickelt und eingesetzt werden. Eine detailliertere Diskussion über die Flüssigkeitskühlung finden Sie im Supermicro Whitepaper zur Flüssigkeitskühlung und im Supermicro Datenblatt zur Flüssigkeitskühlung [8].

Wasser ist das eindeutig bessere Mittel zur Kühlung der Server in einem Rechenzentrum.

Die Platzierung der Komponenten und Kabel. Die Platzierung der Komponenten in einem Gehäuse ist ebenfalls entscheidend für die Aufrechterhaltung eines angemessenen Luftstroms, damit es nicht zu einer Überhitzung kommt. Mit fortschrittlichen Tools wie Computational Fluid Dynamics kann der Luftstrom innerhalb eines Systems simuliert und die von der Luft aufgenommene Wärme bestimmt werden. Anschließend kann ein optimiertes System entworfen werden, indem ein Server- oder Speichersystem und die mechanischen Eigenschaften und Geometrien detailliert modelliert werden, um die Kosten zu senken, indem die Wärme effizienter abgeführt werden kann.

Eine weitere Methode zur Senkung des Energieverbrauchs bei der Luftkühlung eines Servers besteht darin, auf Probleme bei der Verkabelung zu achten und diese zu reduzieren. Strom- und Netzwerkkabel, die den Luftstrom behindern, führen dazu, dass die Lüfter mit höherer Drehzahl arbeiten müssen und mehr Strom verbrauchen. Eine sorgfältige Platzierung dieser Kabel innerhalb des Gehäuses und außerhalb des Gehäuses verringert dieses mögliche Problem. Darüber hinaus hat ein Server, der aus Blades mit integriertem Switching besteht, in der Regel weniger Kabel, die die Systeme miteinander verbinden, da dies über eine Backplane geschieht.

SERT-Bewertungen ermöglichen es den Betreibern von Rechenzentren zu verstehen, wie sich der Energiebedarf von Komponenten auf die Arbeitsbelastung auswirkt und somit die beste Serverauswahl zu treffen. Aus diesem Grund verwenden die wichtigsten Energieeffizienzstandards der Branche, wie Energy Star, EU EcoDesign Lot und Japans Top Runner, die SERT-Bewertung oder eine Ersatzbewertung [9].

Beitrag der Systemverwaltung zur Stromeffizienz. IT-Administratoren, die die Energienutzung kontrollieren können, können den Gesamtstromverbrauch in einem Rechenzentrum erheblich beeinflussen. Wenn die Administratoren in der Lage sind, diesen kritischen Aspekt des gesamten Rechenzentrums zu überwachen und dann zu regulieren, kann dies zu einem effizienteren Betrieb und geringeren Kosten führen. Durch die Analyse von Protokollen über den Stromverbrauch im Laufe der Zeit können IT-Administratoren beispielsweise bestimmte Anwendungen (Jobs) so verschieben, dass die Systeme dann genutzt werden, wenn mehr erneuerbare Energie zur Verfügung steht oder wenn die Stromkosten niedriger sind (tageszeitabhängige Preise). Die Begrenzung des Stromverbrauchs eines Servers oder eines Clusters von Servern durch den Supermicro SuperCloud Composer kann ebenfalls zu einer Kostensenkung führen [10].

Überlegungen zum Mikroprozessor. Aufgrund der explosionsartig ansteigenden Datenmengen und der zunehmenden neuen Verarbeitungsanforderungen, zu denen auch GPUs für KI gehören, werden weltweit schnellere CPUs und mehr CPUs und Kerne als je zuvor benötigt. Da die Arbeitslasten zunehmen und neue Algorithmen entwickelt werden, die immer mehr Rechenleistung verbrauchen, würde der Energieverbrauch weit über das derzeitige Niveau hinaus ansteigen, wenn das Mikroprozessordesign nicht auf einem rigorosen Innovationspfad gewesen wäre. In den letzten zehn Jahren sind die CPUs nicht nur schneller geworden und verfügen über mehr Kerne pro CPU, sondern die Arbeitslast pro Watt hat sich mehr als versechsfacht. Das Mehr an Arbeit, das pro benötigter Leistungseinheit erledigt wird, hat dazu geführt, dass der Stromverbrauch von Rechenzentren deutlich langsamer wächst als die anderen Anforderungen an das Rechenzentrum.

Wenn ein Server veraltet oder unbrauchbar wird, muss er entsorgt werden. Schätzungen zufolge werden in diesem Jahr weltweit fast 60 Millionen Tonnen Elektroschrott entsorgt werden [11]. Ein Großteil davon kann unsachgemäß entsorgt werden und Giftstoffe enthalten, die der menschlichen Gesundheit und der Umwelt schaden. Elektroschrott hat einen Wert, der in dem Maße zunehmen wird, wie die darin enthaltenen seltenen Mineralien in der natürlichen Umwelt knapp werden. Zu den korrekten Entsorgungsoptionen gehören der Verkauf oder die Spende eines funktionierenden Servers an eine andere Einrichtung oder die ordnungsgemäße Entsorgung durch ein zugelassenes E-Müll-Recyclingunternehmen. Eine Entsorgung des gesamten Servers ist jedoch nicht unbedingt erforderlich. Smarte Upgrades oder »Refreshs« von Systemen sind Teil der E-Müll-Lösung. Ein Server, dessen Teilsysteme durch die neueste Technologie ersetzt werden können, ohne dass das gesamte System ausgetauscht werden muss, reduziert den Elektroschrott und die Auswirkungen auf die Umwelt schätzungsweise um bis zu 70 %. So könnte beispielsweise ein CPU-Modul, das mehr Rechenleistung pro Watt Stromverbrauch liefert, aufgerüstet werden, ohne dass neue Speichergeräte angeschafft werden müssen. Der Speicher könnte durch neuere Speichermodule ersetzt werden. Und Netzwerkkomponenten könnten ausgetauscht werden, ohne dass der Rest des Systems davon betroffen wäre. Auch wenn es sinnvoll ist, einige Teilsysteme häufiger auszutauschen als andere, wird ein längerer Auffrischungszyklus des gesamten Systems den Elektroschrott reduzieren [12].

Automatisierte Unterstützung bei der Verringerung der Umweltauswirkungen. Mit Blick auf die Zukunft wäre der Einsatz von KI zur Ermittlung der umweltfreundlichsten Kombination von Rechen- und Speichersystemen auf der Grundlage der Arbeitslasten eine wichtige Technologie für Unternehmen. Ein Konfigurationsprogramm, das die erforderlichen Workload-SLAs mit dem Wissen über den Stromverbrauch der Server berücksichtigt, wird die beste Auswahl der zu erwerbenden Server ermöglichen. Diese Art von Konfigurator hilft den Kunden bei der Auswahl der umweltfreundlichsten Server für ihre speziellen Anforderungen. Ein solcher Konfigurator wäre auch in der Lage, die Spotpreise eines öffentlichen Cloud-Angebots und die beste Wahl auf der Grundlage der Nutzung erneuerbarer Energien durch ein Rechenzentrum zu berücksichtigen. Eine hybride Cloud-Implementierung würde den Anforderungen der Arbeitslast entsprechen und so konzipiert und implementiert werden, dass die Kohlenstoffemissionen reduziert werden. Der Supermicro AutoConfigurator könnte den Kunden dabei helfen, die Auswirkungen auf die Umwelt zu minimieren, wenn sie ihre Rechen- und Speicheranforderungen erfüllen.

Zusammenfassung. Bei der Planung, Nachrüstung oder Aufrüstung eines Rechenzentrums können mehrere Entscheidungen getroffen werden. Es gibt viele Möglichkeiten, Rechenzentren effizienter zu machen und weniger Strom zu verbrauchen, von der Art der erzeugten Elektrizität bis hin zur Aktualisierungsrate neuer Technologien. So können beispielsweise der Standort eines Rechenzentrums, die Gestaltung des Rechenzentrums und die Auswahl geeigneter Server für das Rechenzentrum den für den Betrieb benötigten Strom erheblich reduzieren.

Erfahren Sie mehr unter www.supermicro.com

Quellenangaben:

[1] https://www.datacenterknowledge.com/energy/study-data-centers-responsible-1-percent-all-electricity-consumed-worldwide

[2] The environmental footprint of data centers in the United States (iop.org)

https://iopscience.iop.org/article/10.1088/1748-9326/abfba1/pdf

[3] https://www.srgresearch.com/articles/microsoft-amazon-and-google-account-for-over-half-of-todays-600-hyperscale-data-centers

[4] How Much Energy Do Data Centers Really Use? – Energy Innovation:

Policy and Technology https://energyinnovation.org/2020/03/17/how-much-energy-do-data-centers-really-use/

[5] Energy Hogs: Can World›s Huge Data Centers Be Made More Efficient? – Yale E360

https://e360.yale.edu/features/energy-hogs-can-huge-data-centers-be-made-more-efficient

[6] https://www.networkworld.com/article/3325397/idc-expect-175-zettabytes-of-data-worldwide-by-2025.html

[7] https://www.datacenterknowledge.com/industry-perspectives/setting-realistic-goals-powering-data-centers-renewable-energy

[8] https://www.supermicro.com/white_paper/white_paper_Liquid-Cooling-Solutions.pdf

[9] https://journal.uptimeinstitute.com/datacenter-energy-efficiency-by-region/

[10] www.opendistrictheating.com/case/glesys-en/

[11] https://news.climate.columbia.edu/2018/08/27/growing-e-waste-problem/

[12] https://www.intel.com/content/www/us/en/it-management/intel-it-best-practices/green-computing-at-scale-paper.html

Weitere Lektüre:

Was Sie über Kühltechnologien für Rechenzentren wissen sollten.

https://www.vxchnge.com/blog/data-center-cooling-technology

Wie viel Energie verbrauchen Rechenzentren wirklich?

https://energyinnovation.org/2020/03/17/how-much-energy-do-data-centers-really-use/

Effizienz der Google-Rechenzentren.

https://www.google.com/about/datacenters/efficiency/

Intel Green Computing At Scale.

https://www.intel.com/content/www/us/en/it-management/intel-it-best-practices/green-computing-at-scale-paper.html