Schnell wachsende Datenmengen stellen viele Unternehmen und ihre IT-Teams vor Herausforderungen. Ihre Storage-Landschaften werden zunehmend komplexer und müssen trotz enger Budgets und dünner Personaldecke immer höhere Anforderungen erfüllen. Eine Vereinfachung könnte viele Probleme lösen – doch was zeichnet »einfachen Storage« eigentlich aus?

Waren Speichersysteme früher meist reine Datenlager, auf die nur gelegentlich zugegriffen wurde, so sind sie heute kritische Infrastrukturkomponenten, die nahezu alle Geschäftsprozesse mit Daten versorgen. Als solche müssen sie hohe Anforderungen an Verfügbarkeit, Performance und Skalierung erfüllen. Allerdings haben IT-Teams häufig mit knappen Budgets und Personalengpässen zu kämpfen, sodass es ihnen schwerfällt, schnell Storage-Ressourcen für neue Workloads bereitzustellen oder Legacy-Infrastrukturen zu modernisieren. Sie stecken zu sehr im Tagesgeschäft fest, weil die komplexen, über viele Jahre gewachsenen Systemlandschaften ihre ganze Aufmerksamkeit erfordern.

Unterschiedliche Systeme für Block und File Storage, Cloud-Speicher, hyperkonvergente Appliances sowie eine Vielzahl an Backup-Lösungen machen jede Anpassung oder Migration zu einer Mammutaufgabe mit umfangreichen Abstimmungen und zahlreichen manuellen Arbeitsschritten. Die verschiedenen Systeme bringen jeweils eigene Management-Tools mit und erfordern tiefgehendes Spezialwissen, etwa beim RAID-Design, LUN-Sizing oder Performance-Tuning. Vieles ist nur unzureichend dokumentiert, und das Wissen um Sonderfälle oder Workarounds steckt in den Köpfen weniger Experten. Letztlich ist eine paradoxe Situation entstanden, in der eigentlich klar ist, dass Veränderungen dringend notwendig sind, um technische Schulden und strukturelle Risiken zu beseitigen, man den Storage aber trotzdem oft lieber nicht anfasst.

Dabei könnte eine Vereinfachung nicht nur dafür sorgen, dass Storage zuverlässig, effizient und unkompliziert steuerbar im Hintergrund funktioniert, sondern auch die Budgetplanung und die Standardisierung von Services erleichtern. Der derzeit regelmäßig anzutreffende Lizenz- und Feature-Wildwuchs jedenfalls geht mit schwer zu überblickenden Kostenstrukturen einher und erfordert regelmäßig individuelle Anpassungen oder Problemlösungen.

Wann ist Storage eigentlich »einfach«?

Geht es in der IT um Vereinfachung, stehen meist intuitive Bedienoberflächen und Automatisierungsfunktionen im Vordergrund. Das jedoch ist lediglich die operative Perspektive. Selbstverständlich soll der Verwaltungsaufwand im Arbeitsalltag möglichst niedrig ausfallen, sprich: Provisionierung, Lastverteilung, Monitoring, Schutz und Recovery sollen nicht jeden Tag hochqualifizierte Experten binden. Vor allem Routineaufgaben müssen weitgehend automatisiert ablaufen – das IT-Team soll nur gezielt in Ausnahmesituationen eingreifen und hat Freiräume, um sich um die Weiterentwicklung der Storage-Infrastruktur zu kümmern.

Darüber hinaus dürfen IT-Verantwortliche aber nicht die strategische Perspektive aus dem Blick verlieren: Der Storage muss einen eindeutigen Beitrag zu den Unternehmenszielen leisten, also helfen, die digitale Transformation, KI-Initiativen und Multi-Cloud-Strategien voranzutreiben, ohne dabei Komplexität aufzubauen. Zudem muss er gut planbare Kosten haben. Neben nachvollziehbaren TCO-Prognosen spielen hier auch mögliche Einsparpotenziale – etwa hinsichtlich Energieverbrauch, Speicherplatznutzung oder Support-Aufwand – eine Rolle, wobei IT-Verantwortliche vertraglich zugesicherte Garantien bei ihren Anbietern einfordern und sich nicht auf »bis zu«-Versprechen verlassen sollten.

Schluss mit den Silos

Viele Probleme in Storage-Infrastrukturen sind struktureller Natur und liegen in unterschiedlichen Systemen, Betriebsmodellen und Tools begründet. Eine Vereinfachung muss deshalb bei der Architektur ansetzen und mit der Konsolidierung der Systemwelten beginnen.

Plattformen, die Block und File Storage zusammenführen und unterschiedliche Workloads bedienen, reduzieren die Komplexität sowie Aufwände und Risiken, die sich aus der Fülle an Schnittstellen in heterogenen Systemlandschaften ergeben. Für viele neue Workloads ist außerdem eine Ende-zu-Ende-NVMe-Architektur sinnvoll, die schnelle SSDs via Fibre Channel und TCP anbindet. Durch sie fallen Protokollwechsel weg – das moderne NVMe kann vom Speichermedium bis zum Server genutzt werden, was Latenzen verringert und Übertragungsgeschwindigkeiten erhöht. Die Systeme bieten die Performance von Haus aus und müssen nicht stetig optimiert werden.

Speichersysteme, deren Software auf Container-basierten Microservice-Architekturen aufbaut, erlauben es IT-Teams, selbst grundlegende neue Funktionen komfortabel via Software-Update auszurollen, ganz ohne die bei älteren Systemen häufig notwendigen Plattformwechsel. Diese erforderten nicht selten einen Hardware-Austausch – die ungeliebten Forklift-Upgrades mit aufwendigen Migrationen.

Wachstum in bedarfsgerechten Schritten

Die Architektur entscheidet auch über die Skalierung, bei der IT-Teams viel Flexibilität benötigen, da Datenmengen im Unternehmen nicht gleichmäßig wachsen. Für Bestandsanwendungen reichen meist Erweiterungen in kleinen, kontinuierlichen Schritten, doch neue Projekte, KI-Workloads und Firmenübernahmen sorgen oft für sprunghaft steigende Kapazitäts- und Performance-Anforderungen. Architekturen, die sowohl Scale-up als auch Scale-out unterstützen, sind daher von Vorteil, weil die Speicherlandschaft dynamisch mit den Anforderungen mitwachsen kann. Die Erweiterung erfolgt je nach Bedarf mit einzelnen Laufwerken oder mit zusätzlichen Speichersystemen, sodass Investitionen besser planbar und Architektur-Redesigns überflüssig werden.

Neben der Skalierung entscheidet auch die Verfügbarkeit darüber, ob der Storage alltagstauglich ist oder ein Risiko darstellt. Die Architektur sollte daher Verfügbarkeitsfunktionen fest integrieren, sodass IT-Teams sie nicht mit separaten Lösungen nachrüsten müssen. Die Basis dafür sind nicht notwendigerweise die gebräuchlichen RAID-Konfigurationen – moderne Plattformen setzen teilweise auf alternative Ansätze, die leistungsfähiger und kosteneffizienter sind, weil sie unter anderem bei Medien unterschiedlicher Größe die gesamte Kapazität nutzen können. In starren RAID-Sets wird von allen Laufwerken nämlich nur jeweils die Kapazität verwendet, die das kleinste verbaute Laufwerk bietet.

Im Zusammenspiel mehrerer Systeme ermöglichen schließlich synchrone und asynchrone Replikationen, Metro-Cluster mit sogenanntem Witness, der inkonsistente Daten und Schreibkonflikte nach Ausfällen verhindert, sowie sichere Snapshots eine Verfügbarkeit von 99,999 Prozent und mehr.

Kosten im Griff

In Zeiten schnell wachsender Datenmengen und steigender Energiepreise ist Effizienz kein Nice-to-have, sondern unverzichtbar, um unnötige Kosten zu vermeiden. Systeme mit niedrigem Energieverbrauch sind daher Pflicht, wobei die Watt pro Terabyte (W/TB) die entscheidende Kennzahl sind. Mit ihrer Hilfe lassen sich Storage-Systeme gut vergleichen und Effizienzverbesserungen leicht nachvollziehen. Medien mit hoher Kapazität bieten in dieser Hinsicht einen Vorteil, weisen sie doch kleinere W/TB-Werte als Medien mit geringer Kapazität auf. Zugleich reduzieren sie den Kühlaufwand im Rack, da weniger Systeme benötigt werden. Allerdings sind bei der Entscheidung in der Regel auch andere Aspekte wie Performance oder Rebuild-Zeiten bei der Wiederherstellung von Redundanzen nach einen Laufwerksausfall zu berücksichtigen.

Um den Bedarf an Speicherkapazitäten zu senken, ist eine effiziente Datenreduktion unerlässlich. Diese sollte Hardware-Beschleunigung nutzen, damit Kompression und Deduplizierung die Storage-Performance nicht negativ beeinflussen und beide Funktionen dauerhaft aktiv bleiben können. Wie viel Speicherplatz sich einsparen lässt, hängt von den jeweiligen Daten und den eingesetzten Verfahren ab. Eine Inline-Deduplizierung mit variablen Blockgrößen ist meist am effizientesten – sowohl was Platzersparnis als auch Systemlast angeht. Bei festen Blockgrößen können kleine Blöcke die Systeme stark belasten, weil viele Blöcke auf identische Inhalte hin verglichen werden müssen. Große Blöcke wiederum sparen kaum Platz, weil schon ein einziges abweichendes Bit bedingt, dass der gesamte Block gespeichert werden muss.

Storage-Anbieter und ihre Partner können die Reduktionsraten mit ihrer Erfahrung und smarten Sizing-Tools recht zuverlässig prognostizieren, sodass Unternehmen gut planen können. Diese sollten allerdings darauf achten, dass ihnen die Reduktionsraten nicht nur versprochen, sondern vertraglich zugesichert werden, und verbindliche Zusagen existieren, was geschieht, wenn die Systeme die Werte nicht erreichen. Üblich sind beispielsweise Preisnachlässe oder kostenfreie Speichererweiterungen.

Automatisierung im Tagesgeschäft

In vielen IT-Abteilungen sind gar nicht Speicherkapazitäten oder Rechenleistung das knappste Gut – vielmehr fehlt das Personal, darunter vor allem erfahrene Storage-Spezialisten. Die Teams sind geradezu darauf angewiesen, dass ihnen die Speichersysteme wiederkehrende Aufgaben abnehmen und sie mit umfangreichen Automatismen und Analysen bei Optimierungen und Fehlersuchen unterstützen.

Moderne Plattformen bieten daher bedienfreundliche Oberflächen mit geführten Workflows – etwa für die Provisionierung von Volumes und File-Shares oder die Einrichtung von Replikationen und Snapshots. Sie liefern aufschlussreiche Auswertungen und Prognosen zur Ressourcennutzung und zeigen mögliche Fehlerquellen sowie Engpässe frühzeitig auf. Auf diese Weise verringern sie den manuellen Verwaltungsaufwand erheblich und sorgen für einen verlässlicheren Storage-Betrieb. Das IT-Team ist seltener im »Fire Fighting«-Modus unterwegs, weil Probleme behoben werden können, bevor sie akut werden und Störungen verursachen.

KI und Machine Learning haben den IT-Betrieb in den vergangenen Jahren geradezu revolutioniert und unter dem Stichwort »AIOps« dazu beigetragen, dass sich komplexe Infrastrukturen weitgehend selbst optimieren und viele Probleme proaktiv beseitigen können. Zudem sorgen sie dafür, dass Daten intelligent auf den am besten geeigneten Medien und Systemen platziert sowie Lasten geschickt innerhalb eines Clusters verteilt werden. Damit erhöhen sie die Performance und Verfügbarkeit von Storage-Services besser und schneller als Menschen das je könnten.

Integration ins große Ganze

Da Storage kein Selbstzweck ist und im Unternehmen nicht isoliert vor sich hin existiert, muss er sich nahtlos in bestehende Plattformen und Prozesse einfügen. Das betrifft vor allem Virtualisierungsplattformen, Cloud-Umgebungen und Backup-Lösungen. Schnittstellen und Plug-ins sind hier der Schlüssel für ein perfektes Zusammenspiel: Können IT-Teams beispielsweise Storage-Ressourcen direkt aus vCenter bereitstellen oder Datensicherungen auf Backup-Appliances und in der Cloud direkt über die Oberfläche der Speichersysteme konfigurieren, erspart ihnen das ein stetes Hin-und-Her-Wechseln zwischen verschiedenen Tools. Es entsteht ein Ökosystem aus Lösungen statt einer Ansammlung von Insellösungen.

Alle bislang genannten Merkmale von einfachem Storage sind allerdings nur die Hälfte wert, wenn sich Systeme lediglich mit hohem Aufwand einführen lassen oder keine klaren Modernisierungspfade bieten. Denn dann bleiben Migrationen umfangreiche, mit Downtimes und Risiken verbundene Projekte, die regelmäßig anstehen, weil neuer Storage in drei bis fünf Jahren selbst zum Legacy-Storage wird. Das Lifecycle Management ist daher das vielleicht anspruchsvollste Kriterium dafür, ob Speichersysteme wirklich einfach sind.

Im Grunde sind sie das nur, wenn Hardware- und Software-Updates unterbrechungsfrei möglich sind, damit die gesamte Umgebung kontinuierlich und ohne Beeinträchtigung laufender Workloads auf dem neuesten Stand gehalten werden kann. Voraussetzung dafür ist auch, dass Anbieter ihre Plattform langfristig und ohne fundamentale

Architekturwechsel weiterentwickeln, sodass diese über Jahre aktuell bleibt und nicht im typischen Fünfjahresrhythmus große Migrationsprojekte anstehen. Bei der initialen Einführung und späteren Hardware-Aktualisierungen sollten integrierte Tools unter anderem Datenimporte und das Host-Remapping mit Hilfe geführter und überwiegend automatisiert ablaufender Workflows erleichtern.

Keep it simple

Einfacher Storage heißt: einfache Architektur, einfache Skalierung und Verfügbarkeit, hohe Effizienz und einfache Kostensteuerung, einfacher Betrieb im Tagesgeschäft, einfache Integrationen sowie einfache Migrationen und Modernisierungen. Diese Anforderungen sollten Unternehmen, die ihre Speicherlandschaften neu gestalten wollen, in ihren Roadmaps und Ausschreibungen klar formulieren und Nachweise wie unabhängige Tests und Referenzen von Anbietern einfordern. Schließlich ist einfacher Storage die Voraussetzung dafür, dass IT-Teams sich um das kümmern können, was im Business wirklich zählt: Daten, Anwendungen und Innovationen.

Christian Winterfeldt ist Senior Director Datacenter Sales DACH bei Dell Technologies

Abbildung: Grafik einfacher Storage.jpg Vereinfachung ist mehr als nur schöne Bedienoberflächen und Automatisierungsfunktionen (Quelle: Dell Technologies)

1407 Artikel zu „Storage“

News | Trends 2026 | Cloud Computing | Effizienz | Trends Infrastruktur | Favoriten der Redaktion | Infrastruktur | Infografiken | Rechenzentrum

Storage-Limitierungen bremsen Unternehmen beim Einsatz von KI aus

Für fast alle deutschen IT- und Business-Entscheider ist klar, dass das Training und der Betrieb von KI im eigenen Rechenzentrum viele Vorteile bringt. Zugleich müssen sie aber mehrheitlich einräumen, dass ihre bestehenden Storage-Landschaften dafür ungeeignet sind. Das geht aus der aktuellen »IT Strategy Pulse«-Umfrage von Dell Technologies hervor. Im Rahmen der Umfrage wurden im…

News | Infrastruktur | Rechenzentrum

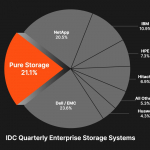

Pure Storage – eine reale Alternative zu den klassischen Speichergiganten

Neben seinem Gründer John Colgrove wird das noch relativ junge Speicher-Unternehmen »Pure Storage« ( »Speicher, nichts als Speicher«) von Charles Giancarlo angefūhrt. Auf der letzten großen Anwenderkonferenz in Las Vegas im Sommer diesen Jahres traten beide nebeneinander als gleichberechtigte Sprecher und Entscheider auf. Colgrove, auch bekannt als »Coz« oder als »Chief Visionary Officer«,…

News | Infrastruktur | Rechenzentrum | Services

Zwischen Datenwachstum und Effizienz: Wie Storage as a Service zur Schlüsseltechnologie wird

Storage: dynamischer Service statt starrer Infrastruktur. Der digitale Wandel zwingt Unternehmen zu einem grundlegenden Umdenken beim Umgang mit ihren Daten. Eine IDC-Studie prognostizierte bereits für dieses Jahr ein weltweites Datenvolumen von rund 175 Zettabyte oder mehr. Laut Statista wird es 2028 auf knapp 400 Zettabyte anwachsen – und sich damit in drei Jahren mehr…

News | TechTalk | Infrastruktur | Künstliche Intelligenz

TechTalk: Darum sollte die Storage-Infrastruktur mit der KI Schritt halten können

News | Infrastruktur | Produktmeldung | Rechenzentrum

Pure Storage stellt Storage-Produkte der nächsten Generation vor, die Höchstleistung in jeder Größenordnung bieten

Die neuen Pure Storage FlashArray- und FlashBlade-Angebote unterstützen die höchsten Anforderungen für immer intensiver werdende Workloads. Pure Storage, der IT-Pionier, der die weltweit fortschrittlichsten Datenspeichertechnologien und -services anbietet, hat eine Erweiterung seiner Storage-Produkte der nächsten Generation für anspruchsvollste Hochleistungs-Workloads bekannt gegeben. »In einer Zeit, in der Daten an vorderster Stelle stehen und die Komplexität der…

News | Effizienz | Infrastruktur | Rechenzentrum

DAOS und die Höhen und Tiefen von SDS (Software-Defined Storage)

»Distributed Asynchronous Object Storage« (DAOS), von Intel im Jahr 2012 von der kleinen Firma »Whamcloud« übernommen, hat eine wechselvolle Geschichte hinter sich, ohne bis heute zu einem eindeutigen Durchbruch am Speichermarkt für Unternehmen gekommen zu sein. Doch was ist unter »Software-Defined Storage«(SDS) und DAOS genauer zu verstehen? Auf der Web-Seite des Speicherspezialisten »Datacore« finden…

News | Infrastruktur | Lösungen | Rechenzentrum

Die Storage-Spreu vom Weizen trennen: viele Lösungen nicht für Unternehmen geeignet

Der Begriff »Enterprise Class« oder »Unternehmenslösung« sollte Lösungen vorbehalten bleiben, die den strengen Anforderungen großer Organisationen gerecht werden. Einige Anbieter behaupten, dass ihre Produkte für Unternehmen geeignet sind, obwohl sie nur eine Architektur mit doppelter Redundanz anbieten, deren Mängel sie mit Clustering- oder Meshing-Technologien zu kompensieren versuchen. Im Gegensatz zur dreifachen Redundanz können diese Ansätze…

News | Cloud Computing | Infrastruktur | Rechenzentrum | Services

Multicloud-Plattformen für File Storage: Ausweg aus dem Daten-Chaos

Menschen, Anwendungen und Maschinen generieren Daten in nie dagewesener Geschwindigkeit. Die meisten dieser Daten sind unstrukturiert und werden auf File Storage an unterschiedlichen Standorten und in verschiedenen Clouds abgelegt. Für Unternehmen ergeben sich daraus zahlreiche Herausforderungen bei der Verwaltung und Nutzung ihrer Datenschätze. Dell Technologies erklärt, wie Multicloud-Plattformen bei der Bewältigung dieser Herausforderungen helfen. Multicloud-Plattformen…

News | Cloud Computing | Infrastruktur

IT-Perspektiven: Moderne Storage-Ansätze ohne Kompromisse

Ende Januar 2025 fand die von Philippe Nicolas aus Frankreich organisierte IT Press Tour in San Francisco statt. Hartmut Wiehr war für »manage it« vor Ort und schaute sich vier vorgestellte Unternehmen genauer an. Nicht alle jungen Unternehmen in der IT-Branche können sofort einen schnellen Durchbruch verzeichnen. So hat auch »Hammerspace« eine kleine Vorgeschichte:…

News | Business Process Management | Infrastruktur | Rechenzentrum | Services | Strategien

Storage-Management: Warum intelligente Self-Services mittelfristig unverzichtbar sind

Das Storage-Management entwickelt sich schnell weiter. Vorangetrieben durch den KI-Boom und die digitale Transformation müssen Rechenzentren ein massives Datenwachstum, beispiellose Anforderungen an die Agilität von Anwendungen, eine steigende Komplexität, einen Mangel an Fachkräften und steigende Energiekosten bewältigen. Es handelt sich weniger um einen Umbruch als um einen perfekten Sturm, was jedoch auch Chancen für Verbesserungen…

News | Trends 2024 | Digitalisierung | Trends Infrastruktur | Infrastruktur | Rechenzentrum

Der Spagat zwischen Leistung und Effizienz – Technologientrends rund um Storage und Data Management

Markus Grau, Principal Technologist bei Pure Storage, erläutert heute vier Entwicklungen, die seiner Ansicht nach die technologische Entwicklung rund um Storage und Data Management im kommenden Jahr prägen werden. Die Nachfrage nach generativen KI-Lösungen wird eine neue Welle der Container-Einführung auslösen. Der Ansturm auf die Entwicklung und Implementierung generativer KI-Lösungen führt zu einer neuen…

News | Effizienz | Infrastruktur | Künstliche Intelligenz

Large Language Models (LLMs) und Herausforderungen an den Storage – die Bedeutung von Parallelität und Checkpoints

Wenn man die Nachrichten im Bereich Deep Learning verfolgt, hat man sicher zur Kenntnis genommen, dass die Daten und Modelle im Bereich Deep Learning inzwischen sehr groß sind. Die Datensätze können in der Größenordnung von Petabytes liegen, und die Modelle selbst sind ebenfalls Hunderte von Gigabytes groß. Das bedeutet, dass nicht einmal das Modell selbst…

News | Trends 2024 | Trends Infrastruktur | Infrastruktur | Künstliche Intelligenz

Storage-Trends für 2024: Storage, Sexiest Technology Alive?

AI-Daten, mehr Performance für Objektspeicher, besseres Datenmanagement, Datenverwaltung über API und Risk-Management bei der Datenspeicherung werden im kommenden Jahr wichtige Trends. Zugegeben, Data-Storage war noch nie wirklich sexy. Ob auf Band, Festplatte oder Flash, in der Cloud, im Rechenzentrum oder Hybrid, die Datenspeicherung war für die IT immer eher die Pflicht als die Kür.…

News | Cloud Computing | Effizienz | Infrastruktur

Object Storage: »Wir stehen am Anfang einer Welle«

Anwendungsbeispiel des ADN Partners Nugolo. Unternehmen müssen heute große Mengen an Daten speichern, vor Diebstahl oder Verschlüsselung durch Ransomware schützen, über Jahrzehnte revisionssicher aufbewahren und auf Knopfdruck Mitarbeitern, Kunden oder Behörden zur Verfügung stellen können. Diese Anforderungen lassen sich mit herkömmlichen Storage-Ansätzen nicht erfüllen und bedürfen eines kompetenten Partners mit Know-how, wie es der…

News | Cloud Computing | Infrastruktur | Strategien | Ausgabe 9-10-2023

Moderne Storage-Lösungen optimieren die Gesamtperformance, Kosteneffizienz, Nachhaltigkeit und Sicherheit

Ein an die Cloud angebundenes All-Flash-Rechenzentrum senkt die Kosten und kommt der Umwelt zugute, weil es eine bessere Energieeffizienz aufweist. Eine ganzheitliche Managementschnittstelle orchestriert die hybride Multicloud-Infrastruktur und fungiert gleichzeitig als Security-Kontrollzentrale. So kann es durch integrierte Sicherheitslösungen gegen Ransomware-Attacken schützen. Das ist die nächste Welle der Storage-Innovation.

News | Cloud Computing | Infrastruktur | Strategien | Ausgabe 9-10-2023

Der Vierklang: Performance, Skalierbarkeit, Security, Nachhaltigkeit – Highend-Storage im Aufwind

In einer sich ständig wandelnden digitalen Landschaft müssen Unternehmen nicht nur mit der Zeit gehen, sondern vorausdenken. Dabei spielt die effektive Speicherung und Verwaltung von Daten eine entscheidende Rolle. Trotz der zunehmenden Beliebtheit von Cloud-Speicherlösungen bleiben Highend-Speicherarrays im »On-Premises«-Betrieb eine starke Option für Großunternehmen, die eine leistungsfähige, skalierbare und sichere Datenspeicherung benötigen.

News | Infrastruktur | Lösungen

Software-Defined Storage-Lösungen für die Automobilbranche

Große Datenmengen schnell, flexibel und aufwandsarm speichern. Automotive-Unternehmen stehen vor großen Herausforderungen, um im Wettbewerb um die Mobilität der Zukunft mitzuhalten. Diese betreffen nicht nur die Technik im Fahrzeug, sondern auch die Informationstechnologie dahinter und in diesem Zuge vor allem die enormen Datenmengen, die bei der Entwicklung erzeugt und verarbeitet werden. Automotive-Unternehmen brauchen daher…

News | Infrastruktur

Wie die Flut an unstrukturierten Daten die Anforderungen an Storage-Systeme verändert

Menschen, Maschinen und Anwendungen generieren Daten in einem immer höheren Tempo. Der größte Teil der Datenflut ist unstrukturiert und schraubt die Anforderungen an Storage-Systeme deutlich nach oben. Dell Technologies erläutert, was diese leisten müssen, um die wachsenden Datenmengen effizient zu speichern und optimal für die Nutzung bereitzustellen. Unstrukturierte Daten sind Informationen, die sich nicht…

News | Lösungen

SVA macht Cloud Storage zu einfach nutzbaren Services mit Vertrauensbonus

StorageGRID ist das Herz von S3-Objekt-Storage-as-a-Service. Der Komfort von Cloud Storage gewinnt eine persönliche Note. SVA ist einer der führenden Systemintegratoren in Deutschland. Wird Leistung ausgezeichnet, ist SVA häufig unter den Preisträgern. Als SVA hörte, dass Kunden ja zu Cloud Storage aber nein zu Public Clouds sagten, war es Zeit für eine neue Lösung. SVA…

News | Infrastruktur | Services | Strategien

Weniger Stress für IT-Teams: Bereitschaft für neue Nutzungsmodelle auch beim Storage steigt

Die vergangenen Monate waren in vielerlei Hinsicht ein harter Stresstest. Es hat Unternehmen, Arbeitnehmer, Volkswirtschaften und ganze Branchen an ihre Grenzen gebracht. Die kaskadenartigen Auswirkungen der Transformation in eine digitale Welt haben die IT-Infrastrukturen auf eine harte Probe gestellt – und die überlasteten IT-Teams, die sie betreiben, auf eine harte Probe gestellt – und sie…