Virtuelle Sprachassistenten werden immer beliebter. Ob im Auto, auf dem Fahrrad oder schwer beladen zu Fuß: Nicht immer hat man eine Hand frei, um das Smartphone zu bedienen. In diesen Situationen erweist es sich als durchaus nützlich, Befehle per Sprachsteuerung zu geben, die das Telefon dann im Idealfall umsetzt.

Wer jedoch regelmäßig mit Siri und Co. kommuniziert, wird festgestellt haben, dass die vermeintlich intelligenten Spracherkennungssysteme manchmal etwas schwer von Begriff sind. »Das habe ich leider nicht verstanden«, ist noch eines der harmloseren Ergebnisse der virtuellen Missverständnisse. Das Verschicken unverständlicher Textnachrichten oder fehlgeleitete Anrufe sind da schon nervigere Konsequenzen.

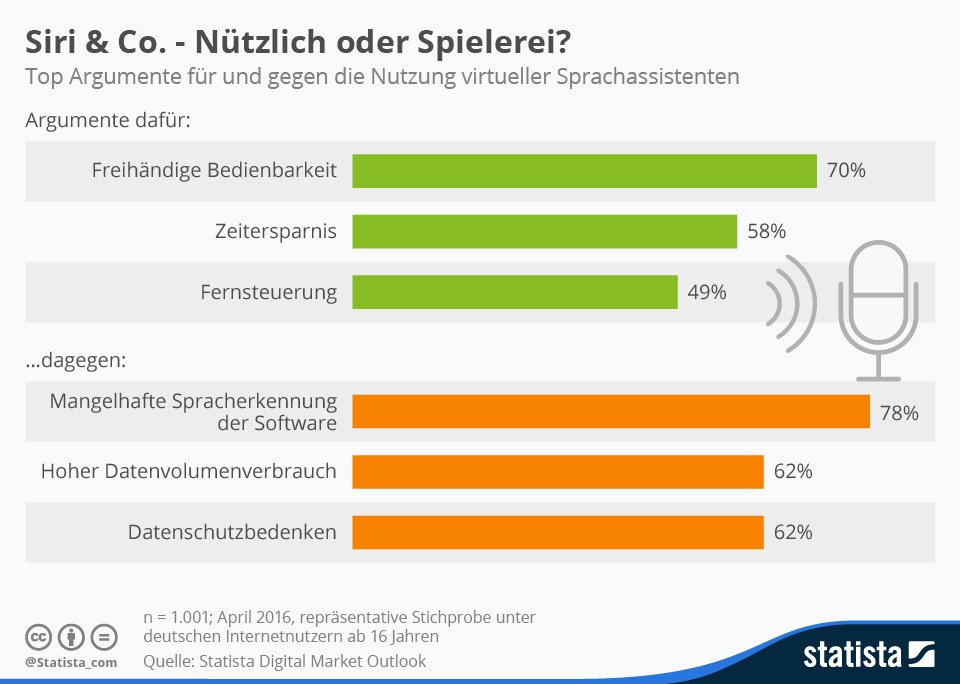

So sehen es auch die Befragten in einer von Statista durchgeführten Befragung zu dem Thema, die mangelhafte Spracherkennung als wichtigstes Argument gegen die Nutzung der virtuellen Assistenten anführen. Was aus Sicht der Nutzer sonst noch für oder gegen Siri, Cortana und Co. spricht, zeigt die folgende Grafik. Weitere Informationen zum Thema Smart Home finden Sie im Statista Digital Market Outlook. Felix Richter

Diese Grafik zeigt die wichtigsten Argumente für und gegen die Nutzung von Sprachassistenten im Stile von Siri und Google Now.

https://de.statista.com/infografik/5704/argumente-fuer-und-gegen-digitale-sprachassistenten/

Wesentliche Grundlage der natürlich-sprachlichen Assistenten, wie etwa Siri oder Cortana, bildet die Spracherkennung, die heute zu rund 90 Prozent funktioniert. 2010 lag die Erkennungsquote noch bei lediglich 70 Prozent. Bei 99 Prozent, die in Kürze erreicht werden, kommt man der natürlichen Kommunikation ganz nahe und die Systeme werden große Akzeptanz finden.

Assistenzsysteme sind auch beim kuratierten Shopping angesagt, also der professionellen Beratung beim Online-Einkauf. Kuratiertes Einkaufen ist der Gegentrend zum Massenangebot: Ein »persönlicher« Berater gibt Hilfe und Orientierung, welche Kleidung, Weine oder sonstigen Konsumgüter am besten zu einem selbst und seinem Lebensstil passen.

Als die »entscheidenden Drillinge« bezeichnet Dr. Bettina Horster, Vorstand Vivai AG, Artificial Intelligence, Machine Learning und Business Intelligence. »Drill down« bezeichnet die tiefgehende Analyse großer Datenmengen, um aus den Daten tatsächliche Informationen und Trends abzuleiten. Die dadurch ermöglichte Wertschöpfungskette erstreckt sich vom Datensammeln über die »intelligente« Auswertung und das Feedback, aus dem die Systeme wiederum Rückschlüsse ziehen.

Sprechen statt tippen: Jeder zweite Smartphone-Nutzer (52 Prozent) bedient sein Gerät per Stimme – sei es, um einen Anruf aufzubauen, eine SMS zu diktieren oder nach dem Wetter zu fragen. Das zeigt eine repräsentative Befragung im Auftrag des Digitalverbands Bitkom.

Dabei ist die Sprachsteuerung besonders unter jungen Smartphone-Nutzern beliebt: Bei den 14- bis 29-Jährigen verwenden schon 58 Prozent die Spracheingabe, bei den 30- bis 49-Jährigen sind es 54 Prozent und bei den 50- bis 64-Jährigen 52 Prozent. Aber selbst bei den Smartphone-Nutzern ab 65 gibt jeder Vierte (25 Prozent) Fragen oder Befehle per Stimme ein statt über das Display.

»Die Spracherkennungssoftware ist inzwischen so weit ausgereift, dass selbst komplexe Befehle oder Fragen gut verstanden und ausgeführt beziehungsweise beantwortet werden«, sagt Bitkom-Hauptgeschäftsführer Dr. Bernhard Rohleder. »Die Sprachsteuerung macht die Bedienung des Smartphones noch intuitiver und komfortabler. Auch für ältere oder körperlich eingeschränkte Menschen kann dies eine enorme Erleichterung sein«, so Rohleder.

Wer die Sprachsteuerung seines Smartphones nutzt, tut das derzeit vor allem, um einen Anruf aufzubauen (80 Prozent), aber auch um eine Textnachricht zu verfassen (49 Prozent) oder um beispielsweise das Wetter oder die aktuellen Fußballergebnisse abzufragen (33 Prozent). Ebenfalls beliebt sind die Navigation (16 Prozent) oder das Starten von Apps (12 Prozent) per Spracheingabe.

Durch die Vernetzung mit weiteren intelligenten Geräten wird die Sprachsteuerung nach Bitkom-Einschätzung künftig auch über das Smartphone hinaus eine immer größere Rolle spielen. »Im Smart Home kann intelligente Sprachsoftware zum Beispiel eingesetzt werden, um das Licht auszuschalten oder die Rollläden herunterzulassen.« Mittelfristig werden außerdem Gesten und Berührungen zur Steuerung von vernetzten Gegenständen und Geräten eingesetzt.

Hintergrund der Entwicklung

Die Steuerung von Mobiltelefonen hat sich in wenigen Jahren stark geändert: Die ersten Handys hatten Tasten, die mehrfach belegt waren. Entsprechend langwierig war das Tippen von SMS. Die Worterkennung beschleunigte die Tastatureingabe. Später wurde dann zudem bei bestimmten Modellen jeder Taste ein einzelner Buchstabe zugeordnet. Beim Smartphone wurde die physische Tastatur durch ein Touch-Display ersetzt. Die neuen Betriebssysteme der Smartphones unterstützen in aller Regel Sprachbefehle.

Für den Durchbruch auf dem Massenmarkt sorgte Apple im Jahr 2011. Damals stellte das Unternehmen die Spracherkennungssoftware Siri für das iPhone 4s vor. Ein Jahr später zog Google mit Google Now nach. Die Verarbeitung der Spracheingabe geschieht dabei nicht auf dem Mobiltelefon, sondern auf Servern der Unternehmen. Dieses Verfahren erhöht die Zuverlässigkeit beim Erkennen der gesprochenen Befehle. Allerdings werden dafür schnelle mobile Internet-Verbindungen gebraucht. Die Spracherkennung profitiert also vom Trend zum Cloud Computing, den schnelleren mobilen Internetverbindungen und mobilen Daten-Flatrates.

Die erste Spracherkennungssoftware für Computer generell hatte IBM im Jahr 1984 der Öffentlichkeit präsentiert. Rund 10 Jahre später wurde sie für den PC und damit für den Massenmarkt konzipiert. Microsoft setzte Spracherkennung in einem Betriebssystem erstmals 2007 ein, bei Windows Vista.