Datenbasierte Mehrwertdienstleistungen benötigen eine tragfähige Umsetzungsstrategie, um durch die Nutzung veredelter Daten nachhaltig Werte generieren zu können. Es gilt die innerhalb der Prozesskette beteiligten Systeme so zu integrieren, dass diese automatisch miteinander kommunizieren können.

Big Data war eine harmlose Epoche, die echten Datenherausforderungen kommen erst jetzt in Form von Huge Data – so beschreibt Kevin Coleman, Analyst von Aureus Analytics, die Schwierigkeit, Massendaten zu beherrschen und produktiv zu nutzen. Denn Sensoren und Maschinen liefern bereits heute Zustands-, Qualitäts- und Produktivitätsdaten in Zettabyte-Größenordnungen.

Datenbasierte Mehrwertdienstleistungen brechen die klassische Beziehung zwischen Hersteller und Kunde auf und verändern die industrielle Wertschöpfung nachhaltig. Obwohl dieses Thema bereits einige Jahre auf der Management-Agenda ganz weit oben steht, existiert in vielen Unternehmen, vor allem im Mittelstand, noch keine tragfähige Umsetzungsstrategie, wie durch die Nutzung veredelter Daten nachhaltig Werte generiert werden können. Viele starten eher unkoordinierte, isolierte Einzelprojekte, etwa das partielle Einbinden von Daten in die Produktentwicklung. Die Stolpersteine für den nötigen disruptiven Wandel liegen derzeit vor allem in der Organisation und Unternehmenskultur. Auf dem Weg zur digitalen Exzellenz werden Business und IT künftig noch enger verzahnt sein.

Neue digitale Geschäftsmodelle. Der Besitz großer Datenmengen per se ist noch nicht wertvoll. Erst der Veredelungsprozess der Analyse, Bewertung, Interpretation und das Matching von Smart Data auf konkrete neue, wertschöpfende Anwendungsgebiete stellen den künftigen wirtschaftlichen Erfolg sicher. Die Tatsache, dass Data Analytics alles mess-, analysier- und quantifizierbar macht, ist daher der Hebel, um vorhandene Geschäftsmodelle zu optimieren, zu ergänzen oder sukzessive durch neue, skalierbare zu ersetzen.

Dabei gewinnen vor allem »digitale« Preismodelle wie beispielsweise Predictive Maintenance an Relevanz: So verschiebt sich das traditionelle eigentumsbasierte Modell hin zu nutzungsbasierten Geschäftsmodellen (pay per use) und mittelfristig zu ergebnisbasierten Geschäftsmodellen. Nicht mehr die Maschine beziehungsweise Anlage wird verkauft, sondern Unternehmen nutzen die Betriebsleistung und zahlen nur das realisierte Ergebnis, den Output. Die Möglichkeiten, die das kontinuierliche Monitoring von Nutzungs- und Verschleißdaten bietet, bildet die Grundlage hierfür.

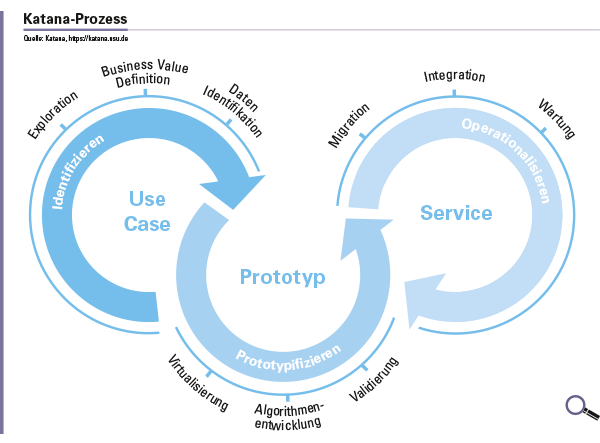

Welche Vorgehensweise hat sich bewährt? Nach dem Motto »Think big, start small, gain fast« wird im Folgenden ein iterativer Ansatz skizziert, bei dem gelingt, einen ersten Anwendungsfall rasch zu erarbeiten und umzusetzen – mit vergleichsweise wenig Aufwand und geringen Kosten. Diese »Bring-Data-to life«-Methode hat sich in der Praxis bewährt: In vier Schritten werden dabei Big Data in wertvolle Smart Data gewandelt und daraus Smart Services entwickelt. Im Erfolgsfall werden dann in der Folge sukzessive weitere Use Cases umgesetzt. Die systemseitige Unterstützung erfolgt durch entsprechende Tools.

Schritt 1: Use Case − was soll optimiert werden?

In der Praxis kommt der »Kickoff«-Veranstaltung eine zentrale Bedeutung zu. Teilnehmer sind in der Regel die interne IT, Maschinenexperten, Data Scientisten, wenn möglich der Digitalisierungsbeauftragte / Budgetgeber und – idealer Weise – der Vertrieb, der den neuen Service verstehen und verkaufen soll. Im Rahmen dieses Workshops werden erste Analyseergebnisse vorgestellt, diskutiert, hinterfragt und bewertet, ob der Informationsgehalt der Daten zur Umsetzung des Use Cases ausreicht oder nicht. Neben der Machbarkeit wird auch darauf geachtet, dass der Mehrwert des daraus gewonnen neuen Service nachvollziehbar ist und sich »verkaufen« lässt. Außerdem werden im Rahmen dieser Veranstaltung erfahrungsgemäß auch Ideen für weitere Use Cases gewonnen.

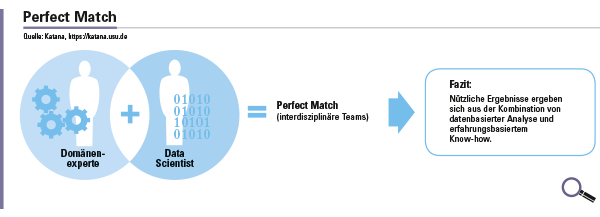

Um ein gemeinsames Verständnis für die zielgerichtete Verwendung bestimmter Daten zu erhalten, ist der Austausch zwischen einem (externen) Datenanalyse-Experten (Data Scientist) mit einem Maschinen-Experten unabdingbar. Dies kann beispielsweise das Detektieren von anomalen zeitlichen Verläufen physikalischer Messgrößen sein, wie etwa ungewöhnliche Temperaturanstiege, Drehmomentverläufe oder Bauteilschwingungen. Oder das Auffinden von Korrelationen zwischen Ereignissen in Log-Daten. In einem ersten Gespräch wird erörtert, welche Fehler oder Störungen datenbezogen gesichtet werden sollen und wo es Optimierungsbedarf gibt. Im nächsten Schritt erarbeitet der Data Scientist einen Algorithmus und analysiert damit einen Auszug der Daten mit Blick auf einen möglichen Anwendungsfall. Im Rahmen eines Workshops werden die Daten und ersten Auswertungen von einem interdisziplinären Team untersucht und begutachtet, aufgearbeitet und verfeinert. Das Ergebnis dieses wichtigen Schrittes, der in der Regel zwei Wochen dauert, ist die Business-Value-Definition des ersten Anwendungsfalls.

Schritt 2: Prototyp − funktioniert es?

Nun folgt der Schritt der Datenvorbearbeitung: der Data Scientist bereitet die realen Daten speziell für den Anwendungsfall auf. Hierbei werden beispielsweise noch »Offsets« korrigiert oder falsche Sensorwerte (etwa Öltemperatur unter null in einer beheizten Halle) eliminiert. Dies ist insbesondere wichtig, um unerwünschte Seiteneffekte bei der anschließenden Analyse zu vermeiden. Ein individuell angepasster Algorithmus entsteht, oft auf Basis von Machine Learning und künstlicher Intelligenz. Muster, Unregelmäßigkeiten und Ausreißer werden damit identifiziert und bislang unbekannte Kausalzusammenhänge aufgezeigt. Eine Ablaufumgebung für den Algorithmus wird eingerichtet, mit der dann die Daten der Maschinen ausgelesen, entsprechend des Anwendungsfalls aufbereitet und die Ergebnisse dargestellt werden. Der entstandene Prototyp dient dem Kunden dann zur Beurteilung der Ergebnisse und ist Basis für die Entscheidung über die weitere Vorgehensweise. Die Basis zur einem Operativsystem ist geschaffen. Diese Projektphase dauert etwa 3 bis 4 Wochen.

Schritt 3: Operationalisierung − ab in die Praxis!

Es folgt die Transformation auf die Big-Data-Plattform. Dazu migriert der Data Engineer den prototypisch entwickelten Algorithmus, so dass dieser performant und zuverlässig auch auf große Datenmengen und im Dauerbetrieb angewandt werden kann. Durch die abschließende Integration in die Wertschöpfungskette (etwa das Erzeugen von Servicefällen oder Tickets im Service Management) wird das in Schritt 1 festgelegte Ziel erreicht. Dieser Schritt dauert meist 3 bis 6 Monate. Mit Schritt 3 und dem »Live-Betrieb« des ersten Use Cases ist die Basis für die Entwicklung weiterer Smart Services geschaffen.

Dafür beginnt der Prozess für neue Use Cases von vorne. In der Regel verkürzen sich die Bearbeitungszeiten der verschiedenen Schritte deutlich durch den fortschreitenden Lernprozess bei allen Beteiligten und die entstandene technische Umgebung. In der Praxis lassen sich die Zeitspannen für die Entwicklung neuer Auswertungen teilweise auf wenige Tage reduzieren. Neue Geschäftsmodelle entstehen sehr oft auch dadurch, dass Daten, die ohnehin in Massen verfügbar sind, in einen neuen Kontext gestellt und auf neuartige Weise verknüpft werden. So kann man beispielsweise durch Peer-Group-Vergleiche erkennen, wo der Wertstromprozess verbessert werden kann.

Schritt 4: neue Services positionieren − Gewinn einholen!

Die Wertschöpfung wird erst dann realisiert, wenn die Zielgruppe den Nutzen des erfolgreichen Anwendungsfalls erkennt. Marketing und Vertrieb sollten in der Lage sein, die Mehrwerte des neuen Service plastisch darzustellen und gegebenenfalls zu quantifizieren. Diese müssen für Kunden (und Kundenkunden) nachvollziehbar sein. Beispielsweise ist der Servicebereich durch Predictive Maintenance jetzt in der Lage, frühzeitig Fehler zu erkennen und dadurch eine proaktive Handlungsempfehlung auszusprechen. Diese führt unmittelbar zur Steigerung der Produktivität und Risikominimierung. Oder mittels Peer-Group-Vergleich konnte die Basis geschaffen werden, einen Beratungsansatz zur Performance-Steigerung anzubieten, mit dem Ziel der Effizienzsteigerung des Wertstromprozesses und Qualitätsverbesserung in der Produktion. Hierbei sind aus der Erfahrung heraus durchaus Steigerungen von 40 Prozent OEE (Overall Equipment Effectiveness) erreichbar.

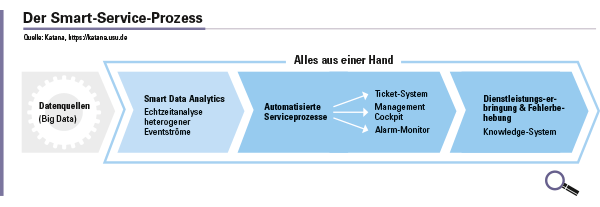

Die komplette Servicekette betrachten. Um die Wertschöpfungspotenziale, die datengetriebene Services heute bieten, umfassend und wirtschaftlich optimal nutzen zu können, bedarf es der Betrachtung der kompletten Servicekette. Dies ist insbesondere deshalb interessant, da industrielle Dienstleistungen zeit- und kostenintensiv sind und »Full-Service-Modelle« vermehrt nachgefragt werden. Es bringt nichts, wenn man mittels Predictive Maintenance in der Lage ist, einen Bauteilausfall einige Wochen vor Eintritt vorherzusagen, wenn aufgrund mangelnder Informationsweitergabe und langsamer Prozesse nicht gewährleistet ist, dass ein Servicetechniker rechtzeitig den Austausch bei der betroffenen Maschine vornimmt.

Es gilt die innerhalb der Prozesskette beteiligten Systeme, also Datenanalyse-Tools, Servicemanagement-Systeme, wissensbasierte Anwendungen, ERP-Werkzeuge und Logistik-Tools so zu integrieren, dass diese automatisch miteinander kommunizieren können. Bewährte Standards, zum Beispiel den De-facto-Industrie-Standard ITIL (IT Infrastructure Library) als Sammlung vordefinierter Prozesse, Funktionen und Rollen für IT-Services, lassen sich auch auf die Serviceprozesse des Maschinen- und Anlagenbaus übertragen.

Ziel ist ein vollautomatisierter Servicebetrieb. Wenn aufgrund der Maschinenanalyse klar ist, dass ein Luftfilter in 14 Tagen ausgetauscht werden muss, kann hierfür automatisch ein Ticket angelegt werden. Des Weiteren liefert die Lösungsdatenbank dem Techniker die notwendigen Details zum Bauteilewechsel, das ERP-System steuert die Beschaffung, die Logistikanwendung regelt die Einsatzplanung und Disposition. Bei komplexeren Problemen ist künftig auch der Einsatz eines Service-Bots denkbar: mit Hilfe von KI-Technologien und Inhalten aus einer intelligenten Wissensdatenbank schaltet sich dieser als Kommunikator zwischen Daten und Servicetechniker und liefert im Dialog Ideen für Fehlerursachen und Lösungen.

Dr. Thomas Gerick,

Dr. Thomas Gerick,

Berater USU Software AG

Illustration: © vs148 /shutterstock.com

128 search results for „USU Service“

NEWS | KOMMENTAR | SERVICES

Plattformen: Service wird nur mit Vertrauen und Transparenz erfolgreich

Kunden drängen immer häufiger auf Plattformen, um Dienstleistungen oder Produkte in Anspruch zu nehmen. Das Angebot an Plattformen wird gleichzeitig auch immer größer. Und Kunden nehmen sogar eine aktive Rolle ein, wenn sie mit Unternehmen gemeinsam auf Kollaborationsplattformen an der Weiterentwicklung von Produkten und Services arbeiten. Vertrauen und Transparenz sind dabei der Schlüssel zum Erfolg,…

NEWS | BUSINESS | SERVICES | WHITEPAPER | AUSGABE 1-2-2019

Entwicklung einer servicezentrierten IT-Organisation – Ein langer Prozess

Bei vielen IT-Organisationen steht der »Service« als zentrales Objekt zur Definition und Strukturierung ihres Angebots noch nicht im Mittelpunkt. Der Aufbau eines Servicekatalogs ist dann ein erster Schritt in diese Richtung. Der Übergang von einer infrastrukturgetriebenen zu einer servicezentrierten IT-Organisation ist aber ein längerer Prozess, der nicht nur Änderungen bei den eingesetzten Tools mit sich bringt, sondern auch Veränderungen in der Aufbau- und Ablauforganisation erfordert.

NEWS | SERVICES | AUSGABE 1-2-2019

Zeitgemäßes Service Management – Geschwindigkeit versus Kontrolle

Ein sofortiger und reibungsloser Service gehört mittlerweile zum Standard. So optimieren Sie in 5 Schritten Ihr Service Management, um den gestiegenen Anforderungen der User gerecht zu werden.

NEWS | CLOUD COMPUTING | SERVICES | AUSGABE 11-12-2018

Steuerung über das IT-Servicemanagement – So verwalten Sie Ihre Cloud-Ressourcen effizient

Mittlerweile nutzen die meisten Unternehmen Cloud-Umgebungen, um schnell und flexibel IT-Infrastrukturen zur Verfügung zu stellen. Die agile Cloud-Welt bleibt aber häufig noch entkoppelt von den IT-Servicemanagement-Prozessen, mit denen die traditionelle Infrastruktur -gesteuert wird. Diese Parallelwelten erschweren aber die effiziente Verwaltung, Transparenz und Kontrolle der im Unternehmen genutzten Infrastruktur.

NEWS | CLOUD COMPUTING | KOMMUNIKATION | SERVICES

Keine Chance für den Grinch: Glänzender Kundenservice während der gesamten Weihnachtszeit

Skalierbare, Cloud-basierte Contact Center-Tools helfen E-Commerce und Einzelhandel, damit Nachfragespitzen über die Feiertage nicht zum Albtraum werden. Einzel- und Online-Händler bereiten sich zum bevorstehenden Weihnachtsfest auf die für sie oft nachfrage- und umsatzstärkste Zeit des Jahres vor. Unternehmen wie beispielsweise Photobox, der europäische Marktführer für Fotoprodukte, verzeichnen zu saisonalen Spitzenzeiten wie Weihnachten und anderen Feiertagen…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | GESCHÄFTSPROZESSE | KOMMUNIKATION | LÖSUNGEN | ONLINE-ARTIKEL | SERVICES

Servicequalität verbessern und Mitarbeiter motivieren

Quality Management Software lässt Erfolge messbar werden. In Industrie und Fertigung gehören Qualitätssicherung und ständige Optimierung zum Alltag. Viele Call- und Kundencenter dagegen hinken hinterher und nutzen wenig zeitgemäße Methoden, um die Qualität der Gespräche zu evaluieren und zu verbessern: Schulungen nach dem Gießkannenprinzip erreichen häufig die falschen Adressaten. Die Alternative Side-by-Side-Einzel-Coaching ist zeitintensiv und…

NEWS | BUSINESS PROCESS MANAGEMENT | FAVORITEN DER REDAKTION | SERVICES | WHITEPAPER | AUSGABE 7-8-2018

DevOps: Praktische Auswirkungen auf ITSM – Agiles IT Service Management

DevOps wird durch den Einsatz moderner Tools zur automatisierten Produktivsetzung (Continuous Integration & Delivery) immer effektiver. Werden diese Tools mit dem IT-Service-Management-Tool integriert, können auch die kurzen Release-Zyklen agiler Entwicklungsteams mit Hilfe der ITIL-Prozesse kontrolliert werden.

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | SERVICES | STRATEGIEN | WHITEPAPER | AUSGABE 3-4-2018

Entwicklung einer servicezentrierten IT-Organisation – Aufbau eines Servicekatalogs

Bei vielen IT-Organisationen steht der »Service« als zentrales Objekt zur Definition und Strukturierung ihres Angebots noch nicht im Mittelpunkt. Der Aufbau eines Online-Servicekatalogs zum Abruf häufig genutzter Services durch die Endanwender ist dann ein erster Schritt in diese Richtung. Letztlich kann der Servicekatalog aber auch zum zentralen Verzeichnis sämtlicher IT-Leistungen werden, auf dessen Grundlage der operative IT-Betrieb servicezentriert gesteuert und überwacht werden kann.

NEWS | BUSINESS PROCESS MANAGEMENT | GESCHÄFTSPROZESSE | INFRASTRUKTUR | SERVICES | WHITEPAPER | AUSGABE 1-2-2018

Ziele und Strategie für die Entwicklung einer servicezentrierten IT

Bei vielen IT-Organisationen steht der »Service« als zentrales Objekt zur Definition und Strukturierung ihres Angebots noch nicht im Mittelpunkt. Der Aufbau eines Servicekatalogs ist dann ein erster Schritt in diese Richtung. Der Übergang von einer infrastrukturgetriebenen zu einer Servicezentrierten IT-Organisation ist aber ein längerer Prozess, der sorgfältig geplant werden sollte.