Ein Beitrag über Chancen, Hindernisse und Trends dieses Lösungsansatzes.

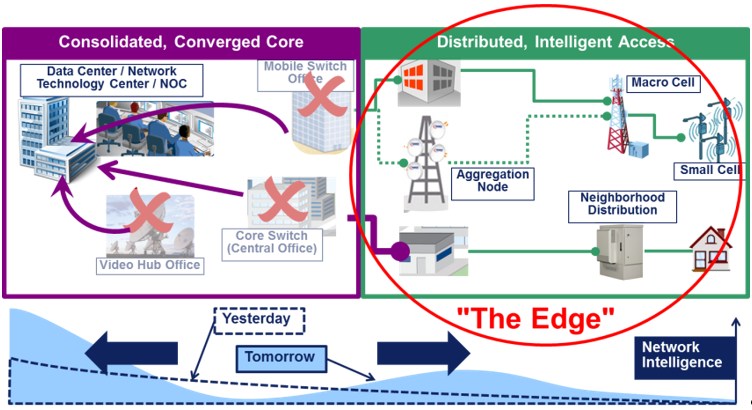

Die wachsende Digitalisierung und Globalisierung erfordert immer modernere IT-Umgebungen: transparent, kostengünstig, einfach zu managen sollen sie sein und sich gleichzeitig flexibel an den Geschäftsbedarf anpassen lassen, um nur ein paar Anforderungen zu nennen. Hybride Cloud-Strukturen waren und sind dann in vielen Fällen das Mittel der Wahl – mit einer immer stärkeren Konsolidierung der Infrastruktur und Zentralisierung auf wenige Rechenzentren. Aber die wachsende Komplexität dieser Strukturen birgt neue Herausforderungen: Die Anwender haben beispielsweise mit der Performance, Schnelligkeit, Kapazitäten, Bandbreiten und Latenzzeiten bei der Übertragung zu kämpfen, die IT-Abteilung damit, die Probleme der Anwender zu lösen, die komplexen Strukturen zu managen und Kosten gering zu halten. Lösungsansätze dafür? Viele finden sie im Edge beziehungsweise Fog Computing – also in der Verschiebung der Rechenleistung von einer zentralen Stelle in eine dezentrale oder mehrstufige Architektur mit verteilten Access Points.

Abbildung 1: Rechenleistung bewegt sich vom Kern und zum Rand. Quelle: Vertiv

Datenübertragung ohne Verzögerung und hohe Kosten

Unter anderem das rasch wachsende Internet of Things bringt einen enormen Anstieg an Datenmengen mit sich, die verarbeitet und lokal zum Einsatz kommen müssen – natürlich in Echtzeit. Die Verarbeitung in weit entfernten, zentralen Rechenzentren ist dafür wenig geeignet, weil die Latenzzeiten einfach zu hoch sind. Edge Computing kann hier helfen, Daten ohne Verzögerung zu verarbeiten und die Kosten trotzdem gering zu halten.

Mit dem dezentralen Lösungsansatz entfällt die Übertragung von Daten an ein weit entferntes, zentrales Rechenzentrum und zurück an den Einsatzort und damit das Risiko von Verzögerungen. Indem Rechenzentrums-Ressourcen in die Randbereiche des Netzwerks verschoben werden, können viele Anwendungen dort in Echtzeit ausgeführt werden. Dazu gehören etwa Apps für Zahlungstransaktionen, zur Anzeige von Produktkatalogen oder zur Bereitstellung von Inhalten. Die Bereitstellungsstrategie von Netflix basiert beispielsweise stark auf dem Edge-Computing-Konzept. Archive werden so nah wie möglich am End-User gehostet, um ihm die qualitativ bestmögliche Streaming-Erfahrung zu bieten.

Zudem müssen beim Edge Computing Endgeräte nicht durchgängig mit dem Internet verbunden sein. Eine Verbindung ist nur dann nötig, wenn ein Zugriff auf die Anwendung, beispielsweise zu Konfigurationszwecken oder einem regelmäßigen Abgleich, notwendig ist. So lassen sich die Kosten für die Übertragung und ausreichende Bandbreiten – besonders bei international verteilten Anwendungen – niedrig halten.

Ade Ausfälle – Hallo hohe Verfügbarkeit

Globalisierung und Wettbewerb – viele Unternehmen sind mit mehreren Standorten in verschiedenen Ländern oder Städten vertreten. Wenn in Netzwerken mit zentralen Rechenzentren nur teilweise IT-Infrastruktur ausfällt, kann das den Betrieb an allen Standorten erheblich beeinträchtigen – bis hin zu ernsthaften Auswirkungen auf Umsatzziele und den Ruf des Unternehmens. Auch dieses Problem kann Edge Computing lösen.

Durch die Verlagerung von Teilressourcen in die Randbereiche des Netzwerks lässt sich der Betrieb an dezentralen Standorten selbst bei einem Ausfall im Kernbereich aufrechterhalten. Verschiedene, teilweise isolierte Netzwerke können bei Ausfall der WAN-Verbindung gegebenenfalls separat betrieben werden.

Ein dezentraler Datentresor

Neben der Ausfallsicherheit spielt auch die Sicherheit geschäftskritischer Daten eine große Rolle. Die Speicherung und Verarbeitung von Informationen am Ort des Geschehens ist gerade für Branchen wie das Gesundheitswesen, das Finanzwesen und den Einzelhandel eine Möglichkeit, sensible Daten »bei sich zu behalten« und sie damit besonders zu schützen. Denn Geräte, die sich am Netzwerkrand befinden, sind meist weniger anfällig für Sicherheitsbedrohungen als zentral Gelegene. Andererseits bietet eine verteilte IT-Infrastruktur mehr Geräte und Zugangspunkte und damit auch mehr Angriffsfläche. Der Schutz der Endpunkte ist daher beim Edge Computing sehr wichtig. Unabhängig davon, wo sich die Geräte und Daten befinden, sollten IT-Abteilungen in der Lage sein, Sicherheitsbedrohungen rechtzeitig zu erkennen und das System als Ganzes abzuschotten.

Datacenter in a Box – Das Produkt zum Lösungsansatz

Neben den erfolgsversprechenden Argumenten für Edge Computing, gibt es auch ein paar Wermutstropfen. Bei dem dezentralen Lösungsansatz sind hohe Verfügbarkeit, Energieeffizienz und physische Sicherheit mit deutlich höheren Kosten verbunden als bei einem Großrechenzentrum vergleichbarerer Leistung. Außerdem sind Edge-Computing-Kapazitäten schlechter skalierbar, daher muss mehr Überkapazität vorgehalten werden. Zusätzlich ist die Wartung aufwändiger.

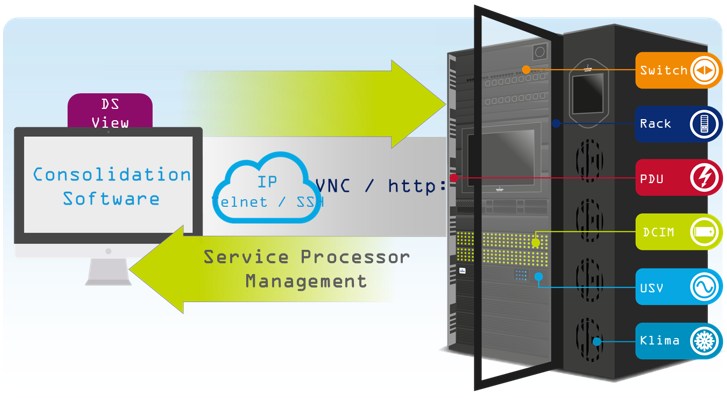

Es geht also bei der Entscheidung für oder gegen Edge Computing immer darum, die richtige Balance zwischen Mehraufwand und Nutzen zu finden. Mikro-Rechenzentren, auch Datacenter-in-a-Box genannt, helfen Unternehmen dabei, den Vorteil großer Rechenzentren mit dem Edge Computing zu kombinieren. Sie integrieren alle relevanten Schutzmaßnahmen in einem oder mehreren Racks. Dazu gehören Kühlung, USV-Lösung, Zugangssicherung und Brandschutz, aber auch die Möglichkeit die Assets durch Remote oder Data Center Infrastructure Management (DCIM) zu überwachen, zu steuern und zu warten. Wobei erwähnt werden muss, dass Mikro-Rechenzentren nur ein kleiner aber sehr wichtiger Teil von Edge Computing sind. Generell gilt, dass der Edge-Lösungsansatz für alle Arten von Rechenzentren geeignet ist – sei es für lokale Cloud- oder Colocation-Rechenzentren.

Abbildung 2: Das Mikro-Rechenzentrum kombiniert die Vorteile eines Großrechenzentrums mit dem Edge Computing. Quelle: Vertiv

Individualität, Zeit und Know-how als Schlüssel zum Erfolg

Für die richtige Balance zwischen zentralisierter Infrastruktur und Edge Computing gibt es keine Universallösung. Edge Computing kann alles umfassen: von der Installation von ganzen Mini-Rechenzentren an wichtigen Standorten bis hin zur Implementierung von Analysefunktionen über ausgewählte eingebettete Geräte oder Speichersysteme. Filialisten setzen beispielsweise häufig auf eine Kombination zentraler Rechenzentren und lokaler Datenverarbeitung in Form von Server- oder Netzwerkräumen. Einzig der gemeinsame Nenner einer Fernwartung ist gegeben. Nur so können die IT-Abteilungen die Infrastruktur auch weiterhin überwachen, analysieren und warten, egal wo sich diese befindet.

Ein weiterer wichtiger Punkt ist, dass die Umsetzung einer effektiven Edge-Computing-Strategie nicht über Nacht funktioniert. Sie birgt nicht nur verschiedene technische Herausforderungen, sondern ist darüber hinaus von der Mitwirkung vieler Stakeholder und ihrer Teams abhängig. Erfolgreich werden am Ende die IT-Verantwortlichen sein, die ein umfassendes Know-how aller – nicht nur der technischen – Anforderungen mitbringen und die Infrastruktur dahingehend flexibel anpassen.

Dr. Peter Koch

Dr. Peter Koch, Vice President Solutions for Europe, Middle East & Africa, Vertiv

Hier folgt eine Auswahl an Fachbeiträgen, Studien, Stories und Statistiken die zu diesem Thema passen. Geben Sie in der »Artikelsuche…« rechts oben Ihre Suchbegriffe ein und lassen sich überraschen, welche weiteren Treffer Sie auf unserer Webseite finden. Diese Auswahl wurde von Menschen getroffen und nicht von Algorithmen.

Cognitive Computing oder die Suche nach der Information im Heuhaufen

Data-Center-Trends 2017: Standort, Energie und Kühlung werden immer wichtiger