Auch wenn alle Welt über Daten und ihre Bedeutung für mehr Wettbewerbsfähigkeit und Flexibilität spricht, so fällt es vielen Unternehmen dennoch schwer, dieses Potenzial zu nutzen – und zwar aus einem einfachen Grund: Traditionelle Storage-Anbieter halten sie davon ab, ihr System zu modernisieren, weil sie an herkömmlichen Architekturen mit all ihrer inhärenten Komplexität und Einschränkungen festhalten.

»Es ist schwer genug, Storage, das auf diesen veralteten herkömmlichen Architekturen aufbaut, am Laufen zu halten, geschweige denn eine flexible Mobilität und Wiederverwendung der Daten in einer wirklich hybriden Multi-Cloud-Umgebung zu ermöglichen«, erklärt Markus Grau, Principal Systems Engineer bei Pure Storage. »So bleiben neue Geschäftspotenziale außer Reichweite und können nicht genutzt werden. Während die Entwicklung in Richtung Zukunft schnell voranschreitet, werden Unternehmen von traditionellen Speicherlösungen ausgebremst.«

Im Jahr 2013 führte Dell EMC (damals nur EMC) XtremIO ein und behauptete, es würde »extreme Performance für jeden Workload bieten, egal bei welcher Array-Auslastung, über jeden beliebigen Zeitraum hinweg« liefern. Jetzt hat Dell EMC eine massive Rationalisierung seines Midrange-Portfolios zugunsten einer neuen Midrange-Plattform angekündigt. Von allen früheren Plattformen hieß es bereits, sie seien der Weg in die Zukunft.

Im oberen Preissegment versprach EMC im Jahr 2014, sein neuer VMAX3 würde Unternehmen »Wirtschaftlichkeit im Cloud-Maßstab« bieten. Das Problem ist: Selbst, wenn die Produkte von Dell EMC mit neuen Technologien wie NVMe »aufgerüstet« werden, werden sie noch immer durch frühere Architekturentscheidungen beeinträchtigt.

»Um ihren Modernisierungsprozess tatsächlich ins Rollen zu bringen, brauchen Unternehmen wirklich moderne Partner, die sich ganz auf sinnvolle Innovationen statt auf inkrementelle Verbesserungen des Status quo konzentrieren«, erläutert Markus Grau. »Partner, die im Hinblick auf sich entwickelnde Hybrid- und Multi-Cloud-Umgebungen den Fokus auf Effizienz, Einfachheit und Automatisierung legen, damit Unternehmen Ressourcen für die strategischen Projekte auf ihrer To-do-Liste freisetzen können. Daher ist es an der Zeit, die Dinge anders anzugehen.«

Konsequente Modernisierung

Nach Meinung von Pure Storage gibt es einen besseren, einen wirklich modernen Weg, um den geschäftskritischen Anforderungen an lokalen Block-, Datei- und Objektspeicher gerecht zu werden. Erforderlich sind eine 100 Prozent nahtlose Architektur, proaktive und vorausschauende Support-Services und flexible Verbrauchsmodelle für investitionsorientierte Käufer sowie ein nutzungsabhängiges Modell für betriebskostenorientierte Käufer.

Aber das ist erst der Anfang. Es gibt einen neuen Ansatz, der Unternehmen dabei helfen soll, lokale Umgebungen und Cloud-Umgebungen zu vereinen. Hierzu dienen neue Cloud-Datenservices für die Cloud-Datensicherung und ein Cloud-Blockspeicher, der nativ in der Public Cloud ausgeführt wird. Der Flash-to-Flash-to-Cloud-Ansatz (F2F2C) für moderne Datensicherung basiert auf einer leistungsstarken Kombination aus einer Datei-Objektspeicher-Plattform und einer Objektspeicher-Engine-Appliance.

Zeitgemäße Datensicherung

Ein Speicherdienst nach dem Evergreen-Prinzip für moderne Datensicherung hilft Unternehmen, Kosten direkt der Nutzung von Flash-to-Flash-to-Cloud-Backups zuzuordnen. Diese neue Lösung, die führende Backup-Produkte von Drittanbietern ergänzt, kombiniert überzeugende Backup-Performance und Storage-Effizienz mit einem As-a-Service-Erlebnis für eine schnelle Wiederherstellung über die gesamte Hybrid-Cloud-Infrastruktur eines Unternehmens hinweg.

Unternehmen können somit eine integrierte, nutzungsbasierte Datenwiederherstellungsstrategie implementieren, die durch die Nutzung von Flash und Cloud eine hohe Servicekontinuität bietet. Sie können mit einer elastischen Infrastruktur und einer kostengünstigen Cloud Geld sparen und ihre Datenwiederverwendung maximieren, indem sie die Backup-Datensilos eliminieren, die beim herkömmlichen Disk-to-Disk-to-Tape-Ansatz (D2D2T) erstellt werden.

»Die Funktionsweise ist ganz einfach«, sagt Markus Grau. »In jedem Quartal erhalten die Kunden eine integrierte, nutzungsbasierte Rechnung. Diese deckt die lokale Aufbewahrung ihrer aktuellen Daten zur schnellen Wiederherstellung sowie zur Deduplizierung und Kompression von Backup-Daten für die Langzeitarchivierung im AWS-S3-kompatiblen Speicher des Kunden lokal oder in der Cloud ab. Somit ist ein Pay-per-Use-Verbrauchsmodell lokal für alle Block-, Datei-, Objekt- und Backup-Daten möglich.«

Abonnement für einheitlichen Blockspeicher

Ein Speicherservice für Blockspeicher nach dem Evergreen-Prinzip stellt ein einheitliches Abonnement für lokale, gehostete und öffentliche Cloud-Umgebungen bereit. Dies hilft Unternehmen, Anwendungs-Workloads jederzeit mit der effektivsten Cloud-Infrastruktur abzustimmen. Mit einem derartigen Abonnementmodell können Unternehmen flexibel und einfach die gesamte oder einen Teil ihrer Pay-per-Use-Block-Storage-Kapazität zwischen On-Premises und Public Cloud Umgebungen verschieben, ohne ihren Servicevertrag anzupassen.

Dies bedeutet auch: Ein TB ist ein TB, unabhängig davon, wo es eingesetzt wird, ob lokal (auf einem Flash-Array) oder in AWS (basierend auf Cloud Block Store). Das Storage-as-a-Service-Modell ist überall nutzbar, ohne mehrere Abonnements verwalten oder separate oder überlappende Kapazitäten erwerben zu müssen. Dies wiederum wird kombiniert mit einem konsistenten Satz von Datenservices und APIs sowie einer konsistenten Verwaltung und Unterstützung mit einer SaaS-basierten Plattform für Cloud-Datenmanagement. Dadurch können Unternehmen den Weg zu einer wirklich einheitlichen Hybrid-Cloud-Umgebung erheblich verkürzen.

VM-Analyse-Tool für die Hybrid-Cloud

Ein VM-Analyse-Tool, das in der VMware Cloud (VMC) in AWS verwendet werden kann, hilft Unternehmen, Probleme bei der Anwendungs-Performance schnell zu erkennen und zu beheben. Ein solches Cloud-basiertes Full-Stack-Performance-Analyseangebot bietet eine schnelle und einfache Übersicht über virtuelle Disks, VMs, Hosts, Datastores, Volumes und Speichersysteme mit einer grafischen Darstellung der gesamten Infrastruktur. Das Analyse-Tool für VMware-basierte Umgebungen lässt sich überall einsetzen, sei es in lokalen, gehosteten oder AWS-Umgebungen.

»In der Welt der Speicherlösungen – also Hard- und Software – hat sich in den vergangenen Jahren viel getan. Entwicklungen wie Cloud, KI und IoT haben die Anforderungen dramatisch verändert und zugleich die Hersteller in die Lage versetzt, ihre Lösungen weiterzuentwickeln«, fasst Markus Grau, Principal Systems Engineer bei Pure Storage zusammen. »Ich kann Unternehmen, die ihre Strategie in Sachen Cloud und Datenmanagement neu planen nur empfehlen, bei Ihren Plänen auch die Zukunftstauglichkeit ihrer Storage-Systeme zu überdenken.«

108 search results for „Storage Architektur“

INFRASTRUKTUR | AUSGABE 9-10-2014

Architektur der Speicherlandschaft – Spannende Zeiten für Storage

NEWS | RECHENZENTRUM

In 5 Schritten zum Open Source Software Defined Storage

Die Anforderungen für Speichersysteme sind in den letzten Jahren immer weiter gestiegen, Agilität, Flexibilität und die schnelle Bereitstellung von Ressourcen sind in einer bi-modalen IT die großen Herausforderungen. Wir haben heute mit mobilen und IoT-Geräten weitaus mehr Endpunkte, an denen Daten generiert werden, als noch vor einigen Jahren denkbar gewesen wäre. Besonders Videoinhalte verbreiten sich…

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | ONLINE-ARTIKEL | STRATEGIEN

Mit dem Einsatz von Containern steigen die Storage-Herausforderungen

Laut einer Gartner Studie wird im Jahr 2020 über die Hälfte der Unternehmen Container-Technologien einsetzen. Kein Wunder, schließlich bieten Container bisher ungekannte Mobilität, Vereinfachung und Effizienz, damit IT-Teams neue Mikroservices und bestehende Anwendungen schnell aufsetzen und aktualisieren können. Wegen ihrer zahlreichen Vorteile werden Container in den kommenden Jahren eine immer größere Rolle in der IT…

TRENDS 2019 | NEWS | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | EFFIZIENZ | INFRASTRUKTUR | KÜNSTLICHE INTELLIGENZ | RECHENZENTRUM

Prognosen für 2019: Storage zwischen Cloud, Container und KI

Die Anforderungen an Storage sowie Data Management steigen und verändern sich aktuell rasant. Explodierende Datenvolumina, Trends wie KI und IoT sowie die wachsende Beliebtheit von Cloud-Modellen und IoT-Anwendungen halten die Hersteller auf Trab. Für Pure Storage wagt Güner Aksoy, Regional Sales Director Central Europe, einen Blick auf die Veränderungen im kommenden Jahr. Beseitigung der…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | EFFIZIENZ| INFRASTRUKTUR | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL | TIPPS

Systeme künstlicher Intelligenz erfolgreich einsetzen – Merkmale und Vorteile einer datenzentrischen Architektur

Die vierte industrielle Revolution, die von künstlicher Intelligenz (KI) und maschinellem Lernen (ML) angetrieben wird, verändert Gesellschaft und Wirtschaft. KI hat bereits immensen Einfluss auf einige Branchen und ermöglicht vieles: von einer intelligenteren Gesundheitsversorgung und besseren Genomik-Tests bis hin zu einem besseren Verständnis von Pflanzenkrankheiten in der Landwirtschaft und einem verbesserten innerstädtischen Verkehrsmanagement. Zum Erfolg…

NEWS | BUSINESS | CLOUD COMPUTING | DIGITALISIERUNG | GESCHÄFTSPROZESSE | INFRASTRUKTUR | ONLINE-ARTIKEL | SERVICES | TIPPS

Fünf Merkmale zukunftssicherer Cloud-Architekturen

Agilität, Skalierbarkeit, Kostenvorteile, Innovation und Wachstum – das sind den Analysten von Gartner zufolge die Gründe, weshalb Unternehmen auch weiterhin Milliarden in neue Cloud-Dienste investieren. Allein der Markt für Software-as-a-Service soll demnach im Jahr 2017 um mehr als 20 Prozent wachsen [1]. Wer sein Unternehmen aktuell auf die Cloud ausrichtet, will die Grundlage für eine…

NEWS | TRENDS INFRASTRUKTUR | CLOUD COMPUTING | DIGITALE TRANSFORMATION | EFFIZIENZ | TRENDS 2017 | INFRASTRUKTUR | RECHENZENTRUM

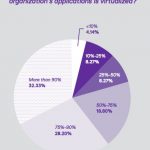

Studie mit teilweise überraschenden Befunden: Software-defined Storage, Hyper-converged und Cloud-Speicher

Die Infrastruktur in den Rechenzentren entwickelt sich von hardwarezentrierten Silos hin zu software-dominierten Ökosystemen. Hier bestimmt die Agilität der Anwendungen die Infrastrukturarchitektur. DataCore Software, Anbieter von Hyper-converged Virtual SAN, Software-defined Storage und Parallel-I/O-Technologie, hat zum sechsten Mal seine jährliche Anwenderstudie »State of Software-Defined Storage, Hyperconverged and Cloud Storage« veröffentlicht. 426 IT-Profis, darunter 180 aus Europa,…

NEWS | INFRASTRUKTUR | RECHENZENTRUM | AUSGABE 1-2-2017

Hybrid- und All-Flash-Storage im Rechenzentrum: Es gibt kein Entweder-oder

NEWS | TRENDS INFRASTRUKTUR | BUSINESS | DIGITALISIERUNG | TRENDS 2017 | INFRASTRUKTUR | PRODUKTMELDUNG | STRATEGIEN

Prototyp des The-Machine-Projekts: Weltweit erste Arbeitsspeicher-zentrische Computer-Architektur

Memory-Driven Computing ist eine Computer-Architektur, bei der nicht der Prozessor, sondern der Arbeitsspeicher im Zentrum steht. Mit dieser Architektur lässt sich eine bisher nicht erreichte Leistung und Effizienz erzielen. Der HPE-Prototyp ist ein Meilenstein des Forschungsprogramms mit dem Namen »The Machine«, mit dem das Unternehmen die grundlegende Architektur transformiert, auf der Computer seit 60 Jahren…

NEWS | TRENDS INFRASTRUKTUR | EFFIZIENZ | TRENDS 2016 | INFRASTRUKTUR

Storage: Einfache Verwaltung löst Performance als wichtigste Herausforderung ab

Mehr als ein Drittel nutzt noch immer manuelle Listen für die Übersichtserstellung ihrer VMs. In der Studie »Storage Status Quo 2016« (State of Storage) für virtuelle Umgebungen werden jährlich 300 IT-Profis zum Stand der Speicherindustrie befragt [1]. Die wichtigste Erkenntnis des diesjährigen Reports besteht darin, dass Performance nicht mehr die größte Herausforderung der IT-Verantwortlichen ist…