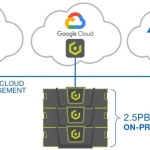

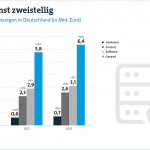

Führungskräfte sorgen sich um die Ausfallsicherheit ihrer Infrastruktur und setzen auf die Hybrid-Cloud, da sich der Datenspeicherbedarf bis 2025 verdoppeln wird. Rund 73 Prozent der deutschen Unternehmen fühlen sich mit der Menge der von ihnen verwalteten Daten überfordert und 63 Prozent befürchten, dass ihre derzeitige Infrastruktur nicht in der Lage sein wird, zukünftige Anforderungen…