![]() Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem sämtliche Daten gespeichert und verwaltet werden.

Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem sämtliche Daten gespeichert und verwaltet werden.

Ein Data Lake bringt zahlreiche Vorteile mit sich. Er erleichtert die Datenerfassung, reduziert den zeitlichen Aufwand für Datenauswahl- und Integration und bietet eine enorme Rechenleistung, die es ermöglicht, Daten je nach Anwendungsbereich beliebig zu transformieren und zu kombinieren. Ein kürzlich veröffentlichter Report der Aberdeen Group zeigt, dass die Anwender einer Data-Lake-Architektur neun Prozent mehr organisches Wachstum verbuchen können als die Konkurrenz [1].

Hierin spiegelt sich eine der interessantesten Perspektiven wider, die der Data Lake bietet: Die Analyse von Daten mittels Machine Learning (ML). Auf diesem Weg lassen sich Geschäftsergebnisse prognostizieren und aufschlussreiche Informationen über die Effizienz von Prozessen, Mitarbeiterproduktivität und andere geschäftskritische Bereiche gewinnen.

Die Schattenseite.

Trotz der Möglichkeiten, die ein Data Lake theoretisch bietet, haben viele Unternehmen nach wie vor Probleme mit bestimmten Aspekten der Datenverfügbarkeit- und Integration. Studien zeigen, dass Datenexperten bis zu 80 Prozent ihrer Zeit mit entsprechenden Aufgaben beschäftigt sind [2].

Das Problem besteht darin, dass es nicht ausreicht, Daten in ihrer »Rohform« zu speichern. Für die Verarbeitung mittels ML müssen diese aufbereitet werden – was sich als äußerst kompliziert erweisen kann. In den letzten Jahren sind zahlreiche Tools für die Datenaufbereitung auf den Markt gekommen, die diesen Prozess vereinfachen sollen. Doch die Leistungsfähigkeit dieser Tools ist begrenzt, da sie nur für einfache Integrationsaufgaben verwendbar sind. Daher stehen IT-Abteilungen oft vor der schwierigen Aufgabe, neue Datensätze im Data Lake zu erstellen, die mit ML kompatibel sind.

Darüber hinaus verfügen viele Firmen heute über hunderte von Repositories, die über On-Premises-Plattformen, Rechenzentren, Cloud-Lösungen und dergleichen verteilt sind. Es überrascht also nicht, dass oft nur ein Bruchteil aller relevanten Daten überhaupt in den Data Lake gelangt.

Datenvirtualisierung schafft Abhilfe.

Glücklicherweise gibt es eine Möglichkeit, diese Probleme in den Griff zu bekommen: Datenvirtualisierung. Unabhängig davon, wo sich die Daten befinden oder in welchem Format die Daten vorliegen, bietet die Datenvirtualisierung einen zentralen Zugriffspunkt. So werden auch Daten verfügbar, die sich noch nicht im Data Lake befinden.

Datenvirtualisierung bietet zudem ein hohes Maß an Benutzerfreundlichkeit. Insbesondere die Tools, die es ermöglichen, Daten zu katalogisieren, helfen Data Scientists, alle verfügbaren Datensätze zu durchsuchen. Die Technologie bietet Anwendern und Unternehmen gleichermaßen neue Möglichkeiten, indem sie Daten demokratisiert und einen schnellen und kostengünstigen Zugriff ermöglicht.

Gleiches zeigt sich bei der Datenintegration: Daten werden per Datenvirtualisierung nach einem konsistenten Repräsentations- und Abfragemodell organisiert, das heißt, unabhängig davon, wo die Daten ursprünglich gespeichert sind, können sämtliche Daten dargestellt werden, als ob sie sich am gleichen Ort gespeichert wären. Weiter ist es möglich wiederverwendbarer logische Datensätze zu erstellen, die an individuelle ML-Prozess angepasst werden können. Dadurch werden Aufbereitung und Integration von Daten erheblich erleichtert.

Mehr Produktivität für Datenexperten

Der globale ML-Markt wird in den nächsten vier Jahren um über 40 Prozent wachsen. Da heute kein Weg mehr an datenbasierten Insights vorbeiführt, sind viele Unternehmen momentan auf der Suche nach modernen Lösungen für Analytics und ML. Vor diesem Hintergrund gewinnt Datenvirtualisierung immer mehr an Bedeutung. Die Technologie vereinfacht nicht nur die Arbeit von Datenexperten erheblich; sie liefert auch ML-basierte Analyseergebnisse und stellt damit die ideale Lösung für Unternehmen dar, die organisches Wachstum aus ihren Datenmassen schöpfen wollen.

Günther Derstroff, Senior Sales Director bei Denodo

[1] https://s3-ap-southeast-1.amazonaws.com/mktg-apac/Big+Data+Refresh+Q4+Campaign/Aberdeen+Research+-+Angling+for+Insights+in+Today’s+Data+Lake.pdf

[2] https://www.forbes.com/sites/gilpress/2016/03/23/data-preparation-most-time-consuming-least-enjoyable-data-science-task-survey-says/#12b58f7b6f63

39 search results for „Data Lake“

BUSINESS INTELLIGENCE | TOP-THEMA | AUSGABE 3-4-2015

Data Lake statt Data Warehouse – Im Zuhause für Big Data erfolgreich fischen

Daten, so war auf der CeBIT immer mal wieder zu hören, seien doch ein recht dröges Thema. Big Data hingegen, das sei eine spannende Sache. Nicht zuletzt wegen seiner engen Verbindung mit dem Internet der Dinge. Also eine wichtige Zukunftstechnologie. Tatsächlich geht es aber auch bei Big Data um nichts anderes als das Zusammenführen von strukturierten und unstrukturierten Daten beispielsweise aus dem Internet of Things oder Social Media.

AUSGABE 3-4-2019 | NEWS | BUSINESS INTELLIGENCE | STRATEGIEN

Vorsprung durch Wissen – Die Ära von Big Data kommt noch

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | INFRASTRUKTUR | OUTSOURCING | ONLINE-ARTIKEL | SERVICES

6 Gründe für ein Cloud-basiertes Data Warehouse

Ein Data Warehouse, das Daten aus verschiedenen Quellen zusammenfasst, um sie analysieren und darauf reagieren zu können, ist heute entscheidend für den Geschäftserfolg. Denn es verarbeitet schnell die enormen Datenmengen, die sich heute in Unternehmen ansammeln. Darauf basierend können Führungskräfte zuverlässige datenbasierte Entscheidungen treffen. Allerdings halten es fast zwei Drittel der kürzlich befragten Experten für…

NEWS | DIGITALISIERUNG | FAVORITEN DER REDAKTION | LÖSUNGEN | ONLINE-ARTIKEL

Wie Automatisierung des Data Warehouse den Wert der Unternehmensdaten erhöhen kann

Volume, Velocity, Variety, Veracity. Im englischen IT-Sprachgebrauch haben sich die vier Vs der Datenspeicherung längst etabliert. Volumen, Geschwindigkeit, Vielfalt und Wahrhaftigkeit gilt es in Einklang zu bringen, um die Daten eines Unternehmens erfolgreich verwalten zu können. Herkömmliche Data-Warehouse-Infrastrukturen sind häufig nicht mehr in der Lage, die enormen Datenmengen, die Vielfalt der Datentypen, die Geschwindigkeit mit…

TRENDS 2019 | NEWS | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | DIGITALE TRANSFORMATION | TRENDS SERVICES | OUTSOURCING

Ertragsoptimierung bei Cloud-Data-Warehouse-Investitionen

Immer mehr datengestützte IT-Systeme werden in die Cloud verlagert und dazu gehört auch das Data Warehouse. Neue Cloud-Data-Warehouse-Lösungen (CDW) sollen noch umfassendere Datenfunktionen, eine bessere Leistung und mehr Flexibilität als herkömmliche lokale Datenbanken bieten. Laut einer neuen Umfrage des TDWI (The Data Warehousing Institute) im Auftrag von Talend bieten neue Cloud-Data-Warehouse-Lösungen (CDW) noch umfassendere…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | INFRASTRUKTUR | ONLINE-ARTIKEL | RECHENZENTRUM

Health-Check: Wie fit ist Ihr Data Warehouse?

In vielen Unternehmen ist das Data Warehouse in die Jahre gekommen. Gleichzeitig wachsen die Anforderungen der Fachabteilungen. Mit IoT und der Digitalisierung kommen zudem neue Herausforderungen hinzu. Ist Ihr Data Warehouse all dem noch gewachsen? Machen Sie den Health-Check. Das Data Warehouse (DWH) bildet das Fundament für Business Intelligence und Data-Analytics-Plattformen. Es dient als zentraler…

NEWS | BUSINESS INTELLIGENCE | CLOUD COMPUTING | DIGITALISIERUNG | ONLINE-ARTIKEL | RECHENZENTRUM | TIPPS

Data- & Analytics-Trends 2018: Flexibel Daten analysieren und integrieren

Business Intelligence, Big Data, IoT und künstliche Intelligenz haben eins gemeinsam: Sie alle drehen sich um Daten und ihre Auswertung. Um bestmöglich von den neuen Technologien zu profitieren, benötigen Unternehmen geeignete Datenplattformen und Analytics-Lösungen. Hier kommen fünf aktuelle Trends, die zeigen, worauf es ankommt. Die Fähigkeit, Daten zu sammeln und auszuwerten, ist heute essenziell für…

NEWS | TRENDS INFRASTRUKTUR | BUSINESS | TRENDS CLOUD COMPUTING | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | GESCHÄFTSPROZESSE | INFRASTRUKTUR | TRENDS 2018 | INTERNET DER DINGE | LÖSUNGEN | STRATEGIEN

Data-Warehouse-Landschaft 2018: Automatisierung wird entscheidend für Kunden sein

»In der Vergangenheit bauten Entwicklerteams Data Warehouses manuell, und Führungskräfte fokussierten sich nicht primär auf die Effizienz dieses Vorgangs. Doch mittlerweile erkennen sie, dass ein Großteil hiervon automatisiert werden kann, um die Bereitstellung von Entscheidungsdaten, die sie täglich benötigen, zu beschleunigen. Bereits 2017 haben Führungskräfte begonnen, das »Wie« der Daten in Frage zu stellen, und…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | FAVORITEN DER REDAKTION | GESCHÄFTSPROZESSE | ONLINE-ARTIKEL | SERVICES | TIPPS

Big Data und Data Analytics: Schritt für Schritt zur eigenen Infrastruktur

Big Data und Data Analytics gehören zu den Kernthemen, mit denen sich Unternehmen heute im Rahmen der Digitalisierung ihrer Geschäftsmodelle auseinandersetzen. Externe Unterstützung in der Vorbereitungs- und Aufbauphase hilft Unternehmen, schnell und zielgerichtet eigene Strukturen aufzubauen, um Daten zur Wertschöpfung nutzen zu können. Big Data ist für die Mehrheit der Unternehmen inzwischen ein relevantes Thema,…

47 search results for „Datenvirtualisierung „

TRENDS 2019 | NEWS | CLOUD COMPUTING | KÜNSTLICHE INTELLIGENZ

Trends 2019: Datenvirtualisierung, KI und Cloud

Maschinelles Lernen wird für Unternehmen ein Muss. Interaktive Datenkataloge um nach relevanten Datenbeständen zu suchen. Datenvirtualisierung spielt bei Multi-Location-Cloud-Architekturen eine zunehmend wichtige Rolle. Denodo, ein Unternehmen im Bereich der Datenvirtualisierung, hat für das Jahr 2019 drei Top-Tech-Trends identifiziert. Neben künstlicher Intelligenz und modernen Datenvirtualisierungs-Tools wird sich auch die Cloud neu erfinden. Maschinelles Lernen für…

NEWS | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN | ONLINE-ARTIKEL | STRATEGIEN

Sechs Gründe für Datenvirtualisierung

Im Zeitalter von Big Data und Cloud Computing, mit explodierendem Datenvolumen und zunehmender Datenvielfalt, können es sich Unternehmen nicht mehr leisten, zahlreiche Kopien und Reproduktionen der Daten zu speichern, die sie für ihr Geschäft benötigen. Deshalb werden bis 2020 mehr als ein Drittel (50 Prozent) der Unternehmen laut Gartner eine Form der Datenvirtualisierung als effiziente…

NEWS | CLOUD COMPUTING | DIGITALE TRANSFORMATION | INFRASTRUKTUR | ONLINE-ARTIKEL

Datenvirtualisierung: Überbrückung der Technologielücke mit Hybrid-IT

Der Begriff »Hybrid-IT« wird oft falsch interpretiert oder verwendet. Er steht nicht einfach für eine heterogene Umgebung aus altgedienten, herkömmlichen (»Legacy«-) Umgebungen und modernen virtualisierten Umgebungen. Er steht vielmehr für eine Strategie, die IT auf einer offenen, erweiterbaren Basis zu betreiben, was Technologiefragen, Geschäftserwartungen, Sicherheits- und Überwachungsbedarf sowie diverse Kostenstrukturen mit einschließt. Actifio sieht in…

NEWS | EFFIZIENZ | TRENDS 2015 | RECHENZENTRUM

Rechenzentrum: Datenvirtualisierung löst Konflikt zwischen Datenexplosion und Energiebedarf

Eine aktuelle Studie [1] hat weltweit 800 Rechenzentrumsspezialisten befragt, wie sie die zukünftigen Entwicklungen im Rechenzentrum einschätzen. Herausgekommen ist unter anderem, das die durchschnittliche Leistungsdichte pro Rack signifikant ansteigen wird, wodurch sich zusätzlich Herausforderungen beim Wärmemanagement ergeben. Die Studie befasste sich auch damit, wie die Stromversorgung von Rechenzentren im Jahr 2025 aussehen würde. Energieeffizienz ist…

NEWS | BUSINESS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | GESCHÄFTSPROZESSE | KÜNSTLICHE INTELLIGENZ

Einführung von Stream Processing und KI im Unternehmen – Engpässe und erfolgskritische Zusammenhänge

Aktuell wird viel darüber diskutiert, wie künstliche Intelligenz (KI) eingesetzt werden kann, insbesondere im Hinblick auf Stream Processing und Datenströme zwischen Systemen, Endgeräten und Echtzeitanwendungen. Da die Einführung von KI im Unternehmen einen entscheidenden Punkt erreicht hat, wird deutlich, dass Stream Processing und KI oft zusammenhängen und ähnliche Herausforderungen auftreten. KI und Echtzeitdaten sind…

NEWS | IT-SECURITY | PRODUKTMELDUNG | STRATEGIEN

Die Grenzen KI-basierter Sicherheit

Klassische Sicherheitslösungen können viele Cyberangriffe nicht verhindern. Neuester Trend sind deshalb KI-gestützte Applikationen. Aber auch sie sind zum Scheitern verurteilt, denn sie sind nach wie vor auf die Angriffserkennung angewiesen. Nur die konsequente Isolation aller Gefahren lässt Cyberattacken zuverlässig ins Leere laufen. Security-Unternehmen werben derzeit stark mit Begriffen wie künstliche Intelligenz (KI) oder Machine Learning…

TRENDS 2019 | TRENDS WIRTSCHAFT | NEWS | TRENDS INFRASTRUKTUR | BUSINESS | INFRASTRUKTUR | TRENDS 2018

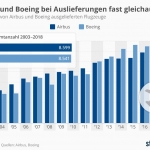

Airbus und Boeing bei Auslieferungen fast gleichauf

Die beiden Flugzeugbauer Airbus und Boeing dominieren den weltweiten Markt für Passagierflugzeuge – und liefern sich bei der Zahl der ausgelieferten Passagierflugzeuge ein Kopf-an-Kopf-Rennen. Wie die Infografik von Statista zeigt, lag im Zeitraum von 2003 bis 2011 jeweils Airbus knapp vor Boeing. Von 2012 bis 2017 hat Boeing mehr Flieger ausgeliefert. 2018 lagen sie mit…

NEWS | DIGITALISIERUNG | DIGITALE TRANSFORMATION | LÖSUNGEN | ONLINE-ARTIKEL

Digitale Gesundheitsversorgung erfordert durchgängiges Datenmanagement

Ob Budgetrestriktionen, politische Entwicklungen oder Personalengpässe – über die akuten und chronischen Herausforderungen für die Gesundheitseinrichtungen wurde und wird aktuell viel kritisch berichtet. Während diese Fragen natürlich wichtig sind, erscheint die Aufmerksamkeit, die den möglichen Lösungen für diese Herausforderungen gewidmet wird, wesentlich geringer zu sein. Markus Grau, Principal Systems Engineering bei Pure Storage erläutert, welch…