foto freepik ki

Unternehmen gehen beim Einsatz von Large Language Models (LLMs) ohne angemessene Regularien, Verifikation und Aufsicht erhebliche rechtliche, finanzielle und reputationsbezogene Risiken ein.

Die Studie »Risks of Unmanaged AI Reliance: Evaluating Regional Biases, Geofencing, Data Sovereignty, and Censorship in LLM Models« von Trend Micro zeigt, dass KI-Systeme je nach geografischem Standort, Sprache, Modelldesign und integrierten Kontrollmechanismen teils deutlich unterschiedliche Ergebnisse lieferten [1]. In kundenorientierten oder entscheidungsunterstützenden Einsatzszenarien könnten solche Inkonsistenzen das Vertrauen untergraben, im Widerspruch zu lokalen regulatorischen oder kulturellen Rahmenbedingungen stehen und kostspielige geschäftliche Folgen nach sich ziehen.

Trend-Micro-Forscher testeten mehr als 100 KI-Modelle mit über 800 gezielt entwickelten Prompts, um Verzerrungen, politisches und kulturelles Kontextverständnis, Geofencing-Verhalten, Signale zur Datensouveränität sowie kontextuelle Einschränkungen zu analysieren. Tausende wiederholte Experimente dienten dazu, Veränderungen der Ausgaben über Zeit und Standorte hinweg zu messen. Insgesamt werteten die Forscher mehr als 60 Millionen Eingabetokens und über 500 Millionen Ausgabetokens aus.

Die Ergebnisse zeigen, dass identische Eingaben je nach Region und Modell unterschiedliche Antworten erzeugen und selbst bei wiederholten Interaktionen mit demselben System variieren. In politisch sensiblen Szenarien, etwa bei der Darstellung umstrittener Gebiete oder nationaler Identitäten, weisen die Modelle klare regionale Ausrichtungsunterschiede auf. In weiteren Tests lieferten die Systeme inkonsistente oder veraltete Ergebnisse in Bereichen, die hohe Präzision erfordern, darunter Finanzberechnungen und zeitkritische Informationen.

»Viele Unternehmen gehen davon aus, dass KI wie klassische Software funktioniert, bei der dieselbe Eingabe zuverlässig dieselbe Ausgabe erzeugt«, erklärt Robert McArdle, Director of Cybersecurity Research bei Trend Micro. »Unsere Forschung zeigt, dass diese Annahme nicht zutrifft. LLMs verändern ihre Antworten abhängig von Region, Sprache und Schutzmechanismen und diese Antworten können sich von einer Interaktion zur nächsten unterscheiden. Werden KI-Ausgaben direkt in Customer Journeys oder Geschäftsentscheidungen eingebunden, riskieren Unternehmen den Verlust der Kontrolle über Markenkommunikation, Compliance-Positionierung und kulturelle Anschlussfähigkeit.«

Der Bericht hebt hervor, dass sich diese Risiken insbesondere für globale Unternehmen verstärken, die KI grenzüberschreitend einsetzen. Dort müsse ein KI-gestützter Service häufig gleichzeitig unterschiedlichen rechtlichen Rahmenbedingungen, politischen Sensibilitäten und gesellschaftlichen Erwartungen gerecht werden. Zudem verweist die Studie auf besondere Herausforderungen für den öffentlichen Sektor: KI-generierte Inhalte könnten dort als offizielle Orientierung wahrgenommen werden, während der Einsatz nicht lokalisierter Modelle Risiken für Souveränität und Zugänglichkeit berge.

»KI sollte nicht als Plug-and-Play-Produktivitätswerkzeug betrachtet werden«, ergänzt Robert McArdle. »Unternehmen müssen sie als Abhängigkeit mit hohem Risiko behandeln, die klare Regularien, eindeutige Verantwortlichkeiten und die menschliche Verifikation aller nutzerseitigen Ausgaben erfordert. Dazu gehört auch, von KI-Anbietern Transparenz darüber einzufordern, wie sich Modelle verhalten, auf welchen Daten sie basieren und wo Schutzmechanismen greifen. Wenn KI mit einem klaren Verständnis ihrer Grenzen eingesetzt und mit Kontrollmechanismen versehen wird, die dem tatsächlichen Verhalten dieser Systeme in realen Umgebungen Rechnung tragen, kann sie Innovation und Effizienz erheblich vorantreiben.«

[1] Die vollständige Studie Risks of Unmanaged AI Reliance: Evaluating Regional Biases, Geofencing, Data Sovereignty, and Censorship in LLM Models finden Sie hier:

https://www.trendmicro.com/vinfo/de/security/news/cybercrime-and-digital-threats/how-unmanaged-ai-adoption-puts-enterprises-at-risk

Wichtige Erkenntnisse

Die Analyse hat sieben zentrale Aspekte ergeben, die Organisationen bei der Bewertung und Einführung von LLM-basierten Systemen berücksichtigen sollten:

Geschäftsrisiken:

Der Einsatz von LLMs in kundenorientierten Prozessen kann erhebliche rechtliche, finanzielle und reputationsbezogene Risiken bergen, wenn keine geeigneten Kontrollmechanismen vorhanden sind. Werden LLM-Ergebnisse unreflektiert in Geschäftsprozesse übernommen, können Unternehmen solchen Risiken ausgesetzt sein. Negative Kundenerfahrungen können zu Kundenabwanderung und Umsatzverlust führen. Es ist entscheidend, diese Risiken zu verstehen, zu bewerten und zu quantifizieren, um sie zu minimieren.

Voreingenommenheit (Bias):

Die KI-Modelle zeigten je nach Region, aus der die Fragen gestellt wurden, unterschiedliche Grade an Voreingenommenheit. Beispielsweise unterschieden sich die Antworten auf Fragen zu Taiwan und der Krim deutlich je nach geografischem Standort, was regionale politische Voreingenommenheiten widerspiegelt. Im Test wurden verschiedene Arten von Bias festgestellt, darunter rechnerische Fehler (z. B. fehlerhafte mathematische Berechnungen, da LLMs nicht logisch rechnen), soziale, geopolitische, kulturelle und sprachliche Verzerrungen.

Nicht-deterministische Natur von KI:

Im Gegensatz zu traditionellen Computersystemen, bei denen die Ausgabe immer gleich ist, ist die Natur von KI nicht-deterministisch. Das bedeutet, dass die Ergebnisse für identische Eingaben erheblich variieren können. Für Unternehmen wird es dadurch schwierig, die Auswirkungen KI-generierter Ausgaben vorherzusehen und zu steuern.

Zugänglichkeit:

Die Verfügbarkeit von GenAI-Lösungen variierte stark zwischen verschiedenen Regionen. Einige Modelle waren in bestimmten geografischen Gebieten leichter zugänglich, während andere eingeschränkt oder gar nicht verfügbar waren.

Zensur:

Einige KI-Modelle unterlagen einer spürbaren Zensur, insbesondere in Regionen mit strengen Informationskontrollrichtlinien. Antworten auf sensible Themen wie ausländische Agenten und Medienplattformen wurden häufig durch eingebaute Kontrollmechanismen gefiltert oder verändert.

Datensouveränität:

In den Antworten der KI-Modelle zeigten sich Hinweise auf Datensouveränität, was darauf hindeutet, dass Datenlokalisierung und regionale Datenrichtlinien die Ausgaben der Modelle beeinflussen. Modelle aus einer bestimmten Region haben mehr Einblick in regionsspezifische Daten.

Geofencing:

Die Geofencing-Eigenschaften der Modelle waren deutlich erkennbar: Bestimmte Antworten wurden je nach Standort des Nutzers eingeschränkt oder angepasst. Der Zugang zu einigen regionalen Modellen ist zudem auf IP-Bereiche bestimmter Länder oder Nutzer einer bestimmten Nationalität beschränkt.

Wie können Unternehmen die Herausforderungen beim Einsatz von KI und insbesondere Large Language Models (LLMs) bewältigen?

Die genannten Risiken – wie Geschäftsrisiken, Voreingenommenheit, Nicht-Determinismus, Zugänglichkeit, Zensur, Datensouveränität und Geofencing – erfordern einen systematischen und verantwortungsvollen Umgang.

Empfohlene Maßnahmen zur Bewältigung dieser Herausforderungen:

Klare Regularien und Verantwortlichkeiten etablieren:

Unternehmen sollten interne Richtlinien für den Einsatz von KI entwickeln, die Verantwortlichkeiten klar zuweisen und die menschliche Verifikation aller KI-Ausgaben sicherstellen. KI darf nicht als Plug-and-Play-Produktivitätswerkzeug betrachtet werden, sondern als Abhängigkeit mit hohem Risiko.

Transparenz von KI-Anbietern einfordern:

Es ist wichtig, von KI-Anbietern Offenheit darüber zu verlangen, wie Modelle funktionieren, auf welchen Daten sie basieren und wo Schutzmechanismen greifen. Nur so können Unternehmen die Grenzen und das Verhalten der Systeme verstehen und kontrollieren.

Regionale und regulatorische Anforderungen berücksichtigen:

Gerade globale Unternehmen müssen sicherstellen, dass KI-gestützte Services den unterschiedlichen rechtlichen Rahmenbedingungen, politischen Sensibilitäten und gesellschaftlichen Erwartungen in den jeweiligen Märkten gerecht werden.

Bias und Nicht-Determinismus erkennen und minimieren:

Unternehmen sollten regelmäßig testen, wie KI-Modelle auf verschiedene Eingaben reagieren, um Verzerrungen und inkonsistente Ergebnisse zu identifizieren. Die Ergebnisse sollten dokumentiert und bei der Entscheidungsfindung berücksichtigt werden.

Datensouveränität und Geofencing beachten:

Die Auswahl und Konfiguration von KI-Modellen sollte so erfolgen, dass regionale Datenrichtlinien und Zugriffsrechte eingehalten werden. Unternehmen müssen prüfen, ob die Modelle in den relevanten Regionen verfügbar und konform sind.

Zensur und Zugänglichkeit überwachen:

Es empfiehlt sich, die Antworten der KI auf sensible Themen regelmäßig zu überprüfen und sicherzustellen, dass keine unerwünschte Zensur oder Einschränkung der Zugänglichkeit vorliegt.

Fazit

Die Bewältigung dieser Herausforderungen erfordert einen ganzheitlichen Ansatz, der technische, rechtliche und organisatorische Aspekte vereint. Mit klaren Regeln, Transparenz, regelmäßiger Überprüfung und Anpassung der Systeme sowie einer bewussten Einbindung menschlicher Kontrolle können Unternehmen die Risiken minimieren und die Vorteile von KI verantwortungsvoll nutzen.

Albert Absmeier & KI

4684 Artikel zu „KI Risiko“

News | Business | IT-Security | Ausgabe 11-12-2025 | Security Spezial 11-12-2025

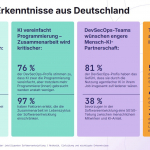

Welche Compliance-Risiken beschert KI deutschen Unternehmen – Vom Regelhüter zum Risikonavigator

Das Interview mit Oliver Riehl, Regional Vice President DACH bei NAVEX, beleuchtet die Herausforderungen und Chancen, die künstliche Intelligenz (KI) für deutsche Unternehmen im Bereich Compliance mit sich bringt. Riehl betont, dass KI helfen kann, Ordnung in die wachsende Komplexität der Regularien zu bringen, jedoch eine gute Governance und klare Richtlinien erforderlich sind, um effektiv eingesetzt zu werden. Zudem wird die Bedeutung einer vertrauensvollen Compliance-Kultur hervorgehoben, um Datenverluste zu vermeiden und die Effizienz von Hinweisgebersystemen zu steigern.

News | Effizienz | Geschäftsprozesse | IT-Security | Künstliche Intelligenz | Tipps

Prüfbare KI-Qualität: MISSION KI präsentiert Qualitätsstandard und digitales Prüfportal für Niedrigrisiko-KI

Der VDE hat sich an dem Projekt MISSION KI – Nationale Initiative für Künstliche Intelligenz und Datenökonomie beteiligt. Entstanden sind ein Qualitätsstandard und ein Portal für die strukturierte Bewertung der Qualität von KI-Systemen, die sich unterhalb der Hochrisikoschwelle befinden. Die Partner des Projekts MISSION KI – Nationale Initiative für Künstliche Intelligenz und Datenökonomie haben…

News | Trends Security | IT-Security | Künstliche Intelligenz

Cybervorfälle sind das größte Geschäftsrisiko – KI in diesem Zusammenhang Fluch und Segen zugleich

Cyberangriffe sind in Deutschland das größte Geschäftsrisiko – noch vor Naturkatastrophen, politischen Risiken oder regulatorischen Herausforderungen. Das zeigt die aktuelle Umfrage Allianz Risk Barometer 2025. Jüngste Vorfälle zeigen: Bedrohung ist real Allein im Juli 2025 sorgten zahlreiche Bedrohungen für Schlagzeilen. Darunter sogenannte DDoS-Attacken auf kommunale Websites von Stadtverwaltungen, S-Bahnen und Landratsämtern. Solche Angriffe verfolgen das…

News | Business | Favoriten der Redaktion | Künstliche Intelligenz | Strategien | Tipps

KI ohne wirksames Risikomanagement ist verantwortungslos

Globale Technologien und lokale Gesetze erfordern verantwortungsvollen Umgang mit KI. Die Entwicklung von künstlicher Intelligenz schreitet weiter voran, doch weltweit fehlt es an einheitlichen Vorgaben. Während die EU mit dem AI Act und der Datenschutzgrundverordnung (DSGVO) zwei rechtlich verbindliche Regelwerke geschaffen hat, gibt es international viele Lücken. Für global tätige Unternehmen bedeutet das vor…

News | Cloud Computing | IT-Security | Künstliche Intelligenz | Ausgabe 5-6-2025

KI zwingt Unternehmen, Abstriche in Sachen Hybrid-Cloud-Sicherheit zu machen – Public Cloud als größtes Risiko

KI verursacht größeres Netzwerkdatenvolumen und -komplexität und folglich auch das Risiko. Zudem gefährden Kompromisse die Sicherheit der hybriden Cloud-Infrastruktur, weshalb deutsche Sicherheits- und IT-Entscheider ihre Strategie überdenken und sich zunehmend von der Public Cloud entfernen. Gleichzeitig gewinnt die Netzwerksichtbarkeit weiter an Bedeutung.

IT-Security | Ausgabe 11-12-2024 | Security Spezial 11-12-2024

it-sa 2024: Zwischen KI-gestützter Bedrohungsabwehr und digitaler Identität – Von reaktiver Gefahrenabwehr zu proaktivem Risikomanagement

Die Messehallen in Nürnberg verwandelten sich auch 2024 wieder zum Epizentrum der IT-Sicherheitsbranche. Die it-sa bestätigte einmal mehr ihre Position als Europas führende Fachmesse für Cybersecurity. Die Rekordbeteiligung internationaler Aussteller unterstrich dabei den Stellenwert der Veranstaltung weit über den deutschsprachigen Raum hinaus. Während die Gänge von geschäftigem Treiben erfüllt waren, kristallisierten sich rasch die dominierenden Themen heraus: Der Umgang mit künstlicher Intelligenz, die Bedeutung digitaler Identitäten und die wachsende Verschmelzung von IT- und OT-Security.

News | Trends 2024 | Trends Security | IT-Security | Künstliche Intelligenz

71 Prozent der Verbraucher sieht KI als Risiko für Datensicherheit

Große Mehrheit der Endkunden prüft Wechsel zur Konkurrenz, wenn Anbieter ihre Daten nicht wirksam schützen. Weltweit sind Verbraucher sehr besorgt über die Menge an Daten, die Unternehmen über sie sammeln, den Umgang damit und sehen auch deren Sicherheit gefährdet – insbesondere durch die den zunehmenden Einsatz von künstlicher Intelligenz. Das belegt eine Umfrage von…

News | Business Process Management | Digitalisierung | Geschäftsprozesse | Services

Risikomanagement: KI-gestützte Risikoanalyse

Mit KI-gestützten Projektmanagement-Anwendungen schneller, flexibler und sicher zum Erfolg. Mit auf KI- und maschinellem Lernen (ML)-gestützten Datenanalysetools können Unternehmen ihr gesamtes Projektportfolio scannen und die risikoreichsten Projekte und Arbeitspakete identifizieren. Außerdem lassen sich auf Projektbasis Simulationen durchführen und wahrscheinliche Risiken aufzeigen, die bei einer manuellen Analyse möglicherweise nicht erkennbar sind. Monte-Carlo-Analyse (Szenarioanalyse) Die…

News | Business | Trends 2024 | Künstliche Intelligenz

Deutschland zu risikoscheu bei Nutzung und Einsatz von KI

Verbraucher erkennen die Vorteile von KI für Wirtschaft und Gesellschaft. Bedenken vor allem in Bezug auf Cybersicherheit. Nach dem »Jahr der künstlichen Intelligenz (KI)« hat eine aktuelle, repräsentative Umfrage von Splunk, Anbieter in den Bereichen Cybersicherheit und Observability, ein gemischtes, aber weitgehend positives Bild der öffentlichen Einstellung zur KI aufgezeigt. Die Mehrheit der Befragten…

News | IT-Security | Produktmeldung

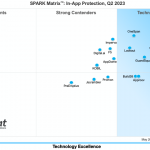

Mobile Sicherheit und Risikomanagement: Wettbewerbsanalyse und Ranking der führenden Anbieter für In-App-Schutzlösungen

In einer neuen Marktstudie hat das Analystenhaus Quadrant Knowledge Solutions die Stärken und Schwächen von In-App-Schutzlösungen untersucht. Neben einer Wettbewerbsanalyse umfasst die Untersuchung ein Ranking der führenden Technologieanbieter. Die »Quadrant Knowledge Solutions SPARK Matrix« beinhaltet eine detaillierte Analyse der globalen Marktdynamik, der wichtigsten Trends, der Anbieterlandschaft und Wettbewerbsposition. Darüber hinaus bietet die Studie strategische Informationen,…

News | Business | Trends Wirtschaft | Digitalisierung | Trends Kommunikation | Trends 2018 | Services

Künstliche Intelligenz: Bürger sehen mehr Risiko als Nutzen in KI

Künstliche Intelligenz wird unsere Gesellschaft grundlegend verändern, das steht fest. Ob diese Veränderungen positiv oder negativ sein werden, darüber sind sich die Deutschen nicht einig, wie eine Umfrage von YouGov zeigt. Während 15 Prozent aller Befragten glauben, der Nutzen von KI sei größer als das Risiko, denken immerhin 26 Prozent das Gegenteil. Beinahe die Hälfte…

News | Business | Favoriten der Redaktion | Geschäftsprozesse | Services | Strategien

Lock-in 2.0: Warum sich die Cloud-Fehler bei KI nicht wiederholen dürfen

Im vergangenen Jahr wurde viel über die Bedeutung von künstlicher Intelligenz und digitaler Souveränität geredet. Jetzt müssen Taten folgen. Denn während KI zunehmend in kritische Geschäftsprozesse integriert wird, läuft Europa Gefahr, noch tiefer in die Abhängigkeit von großen US-Anbietern zu rutschen. 2026 wird es entscheidend sein, die richtigen Weichen zu stellen. Es braucht von Anfang…

News | Business Intelligence

KI-Inferenz vs. klassische Analytik im Unternehmenseinsatz

Unternehmen stehen 2026 unter wachsendem Entscheidungsdruck. Kundeninteraktionen, Sicherheitsereignisse und Lieferketten erzeugen Datenströme, die nicht mehr auf nächtliche Auswertungen warten können. Genau hier beginnt die Trennlinie zwischen klassischer Analytik und moderner KI-Inferenz. Während traditionelle Business-Intelligence-Ansätze stark auf Batch-Verarbeitung setzen, verlangen viele Geschäftsprozesse heute unmittelbare Reaktionen. Die Frage lautet daher nicht mehr, ob analysiert wird, sondern wie…

News | Business | Digitalisierung | Favoriten der Redaktion | Geschäftsprozesse | IT-Security | Services | Strategien

Digitale Souveränität, Sicherheit, KI: Wie sich Europas IT-Strategien neu ausrichten

Unternehmen in Europa stehen vor einem Dilemma: Entweder sie halten am Status quo fest und riskieren eine folgenschwere Abhängigkeit von einzelnen Anbietern – oder sie akzeptieren die tiefgreifenden technologischen Veränderungen und machen ihre IT wirklich zukunftsfähig. Das Festhalten an proprietären Single‑Vendor‑Lösungen ist längst nicht mehr nur eine Frage der Technologie. Es ist ein finanzielles Risiko und kann zur Bedrohung für das…

News | Business Process Management | Effizienz | Favoriten der Redaktion | IT-Security | Künstliche Intelligenz | Services

KI-gestützte Ausfallsicherheit: Die Zukunft des Site Reliability Engineering

Die Integration von KI in das Site Reliability Engineering revolutioniert die Arbeitsweise von SRE-Teams, indem sie von reaktiver Problemlösung zu proaktiver Systemoptimierung übergehen. KI automatisiert nicht nur repetitive Aufgaben wie Patch-Management und Log-Analyse, sondern ermöglicht auch eine vorausschauende Fehlerdiagnose und effizienteres Incident Management. Entscheidend für den Erfolg ist jedoch, dass KI als strategischer Partner eingesetzt…

News | Business | Künstliche Intelligenz | Services | Strategien

Schluss mit KI-Pilotprojekten – jetzt wird skaliert

Bei der Umsetzung jeder Digitalstrategie nimmt KI aktuell eine herausragende Bedeutung ein. Viele Unternehmen setzen sich bereits intensiv mit dem Einsatz von KI auseinander. Entscheidend ist jedoch, das Thema nicht auf einzelne Projekte zu beschränken, sondern KI strategisch und ganzheitlich im gesamten Unternehmen zu verankern und nachhaltig zu skalieren. Erst damit wird das KI-Potenzial optimal…

News | Trends 2026 | Effizienz | Trends Infrastruktur | Industrie 4.0 | Künstliche Intelligenz

2026 wird KI vom Innovations- zum Produktivitätsmotor

Die Fertigungslandschaft hat im vergangenen Jahr stürmische Zeiten erlebt und KI war mittendrin. 2026 wird das Jahr, in dem der KI-Einsatz von der experimentellen Test- in die produktive Wertschöpfungsphase tritt. Schwierige Umgebungsbedingungen, enormes Innovationstempo und strenge regulatorische Anforderungen haben 2025 für Produktionsunternehmen eine komplexe Gemengelage geschaffen. Der Einsatz künstlicher Intelligenz galt und gilt in…

News | Trends 2026 | Business Process Management | Trends Kommunikation | Trends Geschäftsprozesse | Trends Services | IT-Security | Services

Das KI-Paradox in der Softwareentwicklung

Künstliche Intelligenz revolutioniert die Softwareentwicklung und beschleunigt die Code-Erstellung, bringt jedoch neue Herausforderungen bei Qualität, Sicherheit und Compliance mit sich. Das sogenannte KI-Paradox zwingt Unternehmen dazu, ihre operativen Frameworks zu überdenken und intelligente Orchestrierungslösungen zu etablieren. Die Studie zeigt, dass menschliche Kontrolle und Expertise trotz flächendeckendem KI-Einsatz weiterhin unverzichtbar bleiben. GitLab hat seinen aktuellen…

News | Trends 2026 | Business | Business Process Management | Trends Wirtschaft | Effizienz | Favoriten der Redaktion | Geschäftsprozesse | New Work | Strategien

KI-Trends – Kooperation von Menschen und intelligenten Maschinen

KI wird sich im laufenden Jahr weg von beeindruckenden Demo-Anwendungen und hin zu einem verantwortungsbewussten, energieeffizienten Betriebsmodell entwickeln, in dem Menschen und intelligente Maschinen Workflows, Daten, Sicherheit und Vertrauen in großem Maßstab verändern werden. Die Experten von Pure Storage sind zuversichtlich: 2026 wird KI nicht mehr nur eine beeindruckende Demo-Anwendung sein, sondern ein neues…

News | Trends 2026 | Trends Kommunikation | Favoriten der Redaktion | Künstliche Intelligenz

Kritisches Denken wird zur rollenübergreifenden Schlüsselfähigkeit im Umgang mit KI

Der »Job Skills Report 2026« von Coursera deutet eine Verschiebung der menschlichen Rolle in KI-gestützten Arbeitsprozessen an: weg von ausführenden Tätigkeiten, hin zur kritischen Ergebnisbewertung [1]. »Kritisches Denken« weist das zweitschnellste Wachstum unter Lernenden aus Unternehmen weltweit auf; zugleich liegt »KI-Agenten« auf Platz drei der am schnellsten wachsenden GenAI-Skills. Der Report analysiert die aktuell gefragtesten Fähigkeiten und…