Der Einsatz von künstlicher Intelligenz (KI) und maschinellem Lernen (ML) wächst in rasantem Tempo, wenn auch oft noch in Test-Umgebungen. Unternehmen entwickeln parallel dazu ihre Dateninfrastruktur konsequent weiter, um von den aktuellen technologischen Entwicklungen zu profitieren und um im Wettbewerb, der von der Digitalisierung angeheizt wird, zu bestehen.

Die Verlagerung der Dateninfrastruktur und der Datennutzung eines Unternehmens auf eine »KI-bereite« Infrastruktur bringt nach Meinung von Ververica (ehemals data Artisans) mehrere kritische Schritte und Überlegungen mit sich. Dies gilt insbesondere für Unternehmen, die künstliche Intelligenz in großem Maßstab nutzen wollen. Diese kritischen Aspekte reichen von der Sicherstellung, dass die erforderlichen Datenprozesse zur Einspeisung dieser Technologien vorhanden sind, bis hin zu den richtigen Fähigkeiten für die jeweilige Aufgabe.

Daher beginnen Unternehmen ihren Weg zur »KI-Erkenntnis« meist mit der Implementierung von Technologien, die den Betrieb und die Orchestrierung von Datenteams rationalisieren. Zudem müssen sie in der Regel ihre Geschäftsstrategie überdenken, denn welche Daten benötigen sie eigentlich? Dies ist ein natürlicher erster Schritt für die meisten Unternehmen, da ML und andere KI-Initiativen stark von der Verfügbarkeit und Qualität der Eingabedaten abhängen, um sinnvolle und korrekte Ergebnisse zu erzielen. Die Gewährleistung, dass die Pipelines, die diese Leistungen erbringen, unter den gewünschten Leistungs- und Fehlertoleranzanforderungen arbeiten, wird zu einem notwendigen, aber sekundären Schritt.

Wie eine aktuelle Studie von O’Reilly Media ergab, planen mehr als 60 Prozent der Unternehmen, in den nächsten zwölf Monaten mindestens fünf Prozent ihres IT-Budgets für künstliche Intelligenz aufzuwenden. In Anbetracht des weiter wachsenden Interesses an KI und der Tatsache, dass Unternehmen für den Rest des Jahres stark in KI-Initiativen investieren wollen, ist zu erwarten, dass eine wachsende Zahl von Early-Adopter-Unternehmen mehr IT-Budget für grundlegende Datentechnologien zum Sammeln, Bereinigen, Transformieren, Speichern und Bereitstellen von Daten aufwenden wird. Zu diesen Technologien können unter anderem Plattformen für Datenintegration und ETL (Extract, Transfor, Load), Data Governance und Metadatenmanagement gehören.

Die große Mehrheit der Unternehmen, die sich auf diesen Weg begeben haben, beschäftigt bereits Teams von Datenwissenschaftlern oder ebenfalls qualifizierten Mitarbeitern. Diese Unternehmen nutzen die Flexibilität der Infrastruktur in der Cloud, um unternehmensweite Datendienstplattformen zu erkunden und aufzubauen. Solche Plattformen unterstützen die Zusammenarbeit durch Mandantenfähigkeit ideal und koordinieren mehrere Dienste unter einem Dach, wodurch der Datenzugriff und die Datenbearbeitung innerhalb der Organisation demokratisiert werden. Es ist nicht verwunderlich, dass Technologie-Giganten wie Uber, Airbnb und Netflix ihre eigenen internen Datenplattformen eingeführt haben, die es den Anwendern ermöglichen, schwierige Prozesse wie das Training und die Produktion von Deep-Learning-Modellen zu rationalisieren oder ML-Modelle experimentell zu nutzen.

Die Software-Experten des Berliner Software-Startups Ververica fragen aber: Wie bauen Unternehmen ihre Infrastruktur aus, um »KI-bereit« zu werden? Setzen sie datenwissenschaftliche Plattformen und Dateninfrastrukturprojekte vor Ort ein oder nutzen sie einen hybriden Multi-Cloud-orientierten Ansatz für ihre Infrastruktur? Da immer mehr Unternehmen den »Write Once, Run Anywhere«-Ansatz für die Dateninfrastruktur verfolgen, sind mehr Unternehmensentwicklungen in einer Kombination aus On-Prem- und Cloud-Umgebungen oder sogar einer Kombination verschiedener Cloud-Services für ein und dieselbe Anwendung zu erwarten.

In einer anderen aktuellen Umfrage von O’Reilly Media gaben mehr als 85 Prozent der Befragten an, dass sie beabsichtigen, einen (oder mehrere) der sieben großen Public Cloud-Anbieter für ihre Dateninfrastrukturprojekte zu nutzen, nämlich AWS, Google Cloud, Microsoft Azure, Oracle, IBM, Alibaba Cloud oder andere Partner. Unternehmen in verschiedenen Regionen zeigten Interesse an einer Umstellung auf eine Cloud-Dateninfrastruktur als Mittel zur Nutzung von KI und ML, wobei mehr als 80 Prozent der Befragten in Nordamerika, EMEA und Asien antworteten, dass dies die Strategie ihrer Wahl sei. Ein Beweis für den zunehmenden Trend zu einer hybriden Multi-Cloud-orientierten Anwendungsentwicklung ist die Erkenntnis, dass jeder zehnte Befragte alle drei großen Cloud-Anbieter für einen Teil seiner Dateninfrastruktur (Google Cloud Platform, AWS und Microsoft Azure) nutzt.

Zweifellos werden Technologien zur effektiven Erfassung und Verarbeitung von Daten im Maßstab 1:1 nicht nur zur obersten Priorität, sondern zu einer unverzichtbaren Notwendigkeit, sobald Unternehmen mit ihren KI- und ML-Bemühungen ernst machen. Dies ist nach Meinung von Ververica keine Überraschung, wenn man die Bedeutung von Echtzeitdaten für die Entwicklung, Schulung und Bereitstellung von ML-Modellen für das moderne Unternehmen bedenkt. Kontinuierliche Verarbeitung und Echtzeit-Datenarchitekturen werden auch dann zum Schlüsselfaktor, wenn ML und andere Anwendungsfälle der KI in die Produktion übergehen.

Hier setzt Apache Flink als moderne Engine für Open-Source-Stream-Processing an: Flink wurde von Grund auf für die Stream-Verarbeitung entwickelt, mit unschlagbaren Leistungsmerkmalen, einer hochskalierbaren Architektur sowie starken Konsistenz- und Fehlertoleranzgarantien. So wird Flink bereits in den größten Streaming-Produktionsumgebungen der Welt eingesetzt, wobei riesige Mengen an Echtzeitdaten mit einer Latenzzeit von weniger als einer Sekunde verarbeitet werden. Beispiele für solche groß angelegten Anwendungsfälle sind Netflix, wo Apache Flink für die Echtzeit-Datenverarbeitung zum Erstellen, Warten und Bedienen von ML-Modellen zum Einsatz kommt. Diese Modelle werden verwendet, um die verschiedenen Teile der Website zu unterstützen, einschließlich Videoempfehlungen, Suchergebnis-Ranking und Auswahl von Grafiken. Google setzt Apache Flink zusammen mit Apache Beam und TensorFlow zur Entwicklung von TensorFlow Extended (TFX), eine End-to-End-Lernplattform für TensorFlow, die Produkte im gesamten Alphabet-Konzern unterstützt, ein.

Die Entwicklung in Richtung KI-Nutzung mag für manch Unternehmen zunächst wie eine überwältigende und beängstigende Aufgabe erscheinen. Daher gilt es die richtigen Investitionen und Entscheidungen im Vorfeld zu treffen, um eine geeignete Infrastruktur für Datentechnik und Analytik aufzubauen, Cloud-basiert zu denken und Stream Processing als Echtzeit-Business-Enabler zu betrachten. Dies wird nach Meinung des Berliner Software-Startups technologisch führenden Marktakteuren helfen, ihre KI-Strategie voranzubringen und künftig in hohem Maße von KI zu profitieren.

Einführung von Stream Processing und KI im Unternehmen – Engpässe und erfolgskritische Zusammenhänge

Aktuell wird viel darüber diskutiert, wie künstliche Intelligenz (KI) eingesetzt werden kann, insbesondere im Hinblick auf Stream Processing und Datenströme zwischen Systemen, Endgeräten und Echtzeitanwendungen. Da die Einführung von KI im Unternehmen einen entscheidenden Punkt erreicht hat, wird deutlich, dass Stream Processing und KI oft zusammenhängen und ähnliche Herausforderungen auftreten.

KI und Echtzeitdaten sind eng miteinander verwoben und werden den Unternehmen künftig massive technologische Fortschritte bringen. Analysten und Branchenkenner argumentieren, dass jedes moderne Unternehmen im Grunde genommen bereits im Datengeschäft tätig ist und KI zukünftig benötigt, um Big Data zu bewältigen und die Daten zu verarbeiten, um sie zu verstehen und wirtschaftlich zu nutzen [1].

Ververica, das Software-Startup (ehemals data Artisans) aus Berlin, sieht unterschiedliche Verbindungen zwischen Stream Processing und KI. Deren gemeinsame Nutzung bietet Unternehmen, die mit immensen Mengen von Echtzeitereignissen zu tun haben, eine einzigartige Gelegenheit. Beide Technologien beinhalten verteilte Elemente, sind in logischen Einheiten organisiert und unterstützen inkrementelle Updates sowie iterative Aufgaben. Last but not least, haben beide einen asynchronen Charakter.

Eine aktuelle Studie von O’Reilly Media ergab, dass die meisten Unternehmen planen, die IT-Budgets für KI-Projekte im Jahr 2019 zu erhöhen. Konkret: Mehr als 60 Prozent der Unternehmen planen, in den nächsten zwölf Monaten mindestens fünf Prozent ihres IT-Budgets für KI auszugeben, während ein Fünftel (19 Prozent) der Unternehmen planen, einen erheblichen Teil, mindestens 20 Prozent, ihres IT-Budgets in KI zu investieren.

Die gleiche Umfrage prognostiziert eine wachsende Kluft zwischen den Branchenführern und denjenigen Unternehmen, die in Bezug auf die KI-Nutzung zurückbleiben. Dies ist in erster Linie auf Engpässe zurückzuführen, mit denen einige Unternehmen konfrontiert sind, insbesondere in den folgenden vier Bereichen:

- Datenmangel

- Fachkräftemangel

- Unzeitgemäße Unternehmenskultur

- Schwierigkeiten bei der Identifizierung relevanter Anwendungsfälle

Interessanterweise haben sowohl Stream-Verarbeitung als auch KI nicht nur die gleichen Gemeinsamkeiten, die sie in ihrer Kombination einzigartig machen. Ebenso ergeben sich nach Meinung von Ververica die gleichen Herausforderungen und Engpässe bei der Einführung der beiden Innovationen in Unternehmen. Projektverantwortliche können diese Engpässe beseitigen, indem sie die richtigen Investitionen tätigen und die notwendigen Maßnahmen im Zusammenhang mit ihrer Datenarchitektur ergreifen.

Der von den Befragten zitierte »Datenmangel« bezieht sich entweder auf ineffiziente Daten, um das maschinelle Lernen und die KI-Modelle und -Anwendungen im Unternehmen effektiv trainieren und pflegen zu können, oder – im Falle von Daten-Streaming – auf Fragen der Datenqualität. Die Einführung einer ereignisgesteuerten Datenstrategie mit Stream Processing und Apache Flink ermöglicht es Unternehmen, ihre Daten besser zu verstehen, zu transformieren und in Echtzeit anzureichern. Sie können wertvolle Erkenntnisse aus Ereignissen gewinnen, die aus Systemen, vernetzten Geräten oder Interaktionen zwischen Websites und mobilen Anwendungen generiert werden. Dies ist der neue Ansatz, anstatt die Daten in einem Data Lake zu speichern, um dann rückwirkend zu versuchen, Erkenntnisse zu gewinnen. Die Stream-Verarbeitung mit Apache Flink ermöglicht es Unternehmen, in Echtzeit auf Informationen zu reagieren, indem KI-Modelle und -Anwendungen iterativ werden und darauf reagieren, wie sich die Welt im Moment verändert.

Die Qualifikationslücke scheint nach Meinung von Ververica ein gemeinsamer Nenner für die Einführung von KI und Stream Processing im Unternehmen zu sein. Die gleiche, bereits erwähnte O’Reilly-Studie kommt zu dem Schluss, dass die Nachfrage nach Datenwissenschaftlern, Experten für maschinelles Lernen sowie Daten- und Infrastrukturingenieuren einer der am häufigsten genannten Gründe ist, die derzeit die Einführung von KI vielerorts ausbremsen. Um dies zu verhindern, müssen Unternehmen strategische Maßnahmen ergreifen und ihre Abteilungen und Teams sowohl auf technischer als auch auf kultureller Ebene verändern. Die Einführung von KI, ähnlich wie bei der Stream-Verarbeitung, erfordert Investitionen in die Fähigkeiten der Mitarbeiter, Schulungen und eine gemeinsame Kultur innerhalb des Unternehmens. Es gilt Datensilos zu minimieren und Daten für mehrere Teams, die an verschiedenen Projekten und Anwendungen arbeiten, zugänglich zu machen. Dadurch können die Time-to-Market und die erfolgreiche Bereitstellung erheblich verkürzt werden.

Die verbleibenden beiden Hürden, die der KI-Einführung im Wege stehen, beziehen sich auf die Unternehmenskultur und das Fehlen von identifizierten Anwendungsfällen. Wie bei jeder neuen Technologie müssen Führungskräfte im Bereich des Datenmanagements und der Analytik eine offene und integrative Kultur in ihren Teams annehmen, den Status quo hinterfragen und Wege finden, um das Potenzial der Teams zu nutzen, schneller und kostengünstiger Ergebnisse zu erzielen. Stream Processing und KI können zu einem Katalysator für organisatorische Veränderungen in der IT- und Datenabteilung werden: ein Prozess, der sich von Datensilos und hierarchischen Strukturen löst und die Daten-, Betriebs- und Produktteams zusammenführt. Ziel ist es, die Zeit, die für die Produktion von Echtzeitanwendungen, KI- und maschinellen Lernmodellen oder Deep-Learning-Algorithmen benötigt wird, deutlich zu reduzieren.

Da die Akzeptanz für KI im Laufe der Zeit wächst, wird die Identifizierung relevanter Anwendungsfälle für die Technologie einfacher werden, so Ververcia. Berichten zufolge nutzen Unternehmen bereits KI, um ihren Kundenservice, ihren Betrieb sowie andere Anwendungen und Anwendungsfälle in den Bereichen Finanzen, Buchhaltung, Marketing, Werbung und nicht zuletzt F&E zu unterstützen. Führungskräfte sollten sich darauf konzentrieren, die richtigen Fachkräfte zu finden, die praxisnahe Anwendungsfälle sowohl für Echtzeitdaten als auch für KI identifizieren und diese Projekte vorantreiben können.

83 search results for „Stream Process“

NEWS | INTERNET DER DINGE | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

Intelligente Städte – Wie Stream Processing reale Smart-City-Projekte zum Leben erwecken kann

Die öffentliche Diskussion rund um 5G, Digitalisierung und das Internet der Dinge bringen ein weiteres Thema auf die Agenda: Dass Interesse für das Thema Smart City wächst stetig, und es wurden -zumeist außerhalb Europas – bereits einige spannende Technologieprojekte realisiert. Immer mehr Regierungen unternehmen ernsthafte Schritte zur Modernisierung ihrer Infrastruktur, um die Herausforderungen des Bevölkerungswachstums…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | RECHENZENTRUM | SERVICES | STRATEGIEN

IT-basierte Innovationen in der Finanzbranche – Welches Potenzial steckt in Stream Processing?

Finanzunternehmen durchlaufen einen umfassenden digitalen Wandel, da die Marktvolatilität zunimmt, sich das Verbraucherverhalten ändert und die Anforderungen der Regulierungsbehörden steigen. Die Kapitalmarkt- und Finanzbranche wandelt sich von der minimalen Digitalisierung und Automatisierung ihrer Geschäftsprozesse zu einer hoch automatisierten und software- und IT-gesteuerten Branche. Dieser Wandel und der Wunsch nach zunehmender Dynamik erfordern ein Umdenken in…

TRENDS 2019 | NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | EFFIZIENZ | GESCHÄFTSPROZESSE | INFRASTRUKTUR | KÜNSTLICHE INTELLIGENZ | STRATEGIEN

Trends für 2019 – Stream Processing als Ansatz für Big Data und komplexes Datamanagement

Um vorherzusehen, dass die schiere Masse an Daten auch im kommenden Jahr neue Rekordwerte erklimmen wird, muss man kein Experte sein. Um dieser Entwicklung Herr zu werden und die entstehenden Datenmassen effizient zu nutzen, sind jedoch Experten und neue Technologien gefragt. Ein erfolgsversprechender Ansatz ist dabei Stream Processing. Stream Processing, also Datenstromverarbeitung, ist…

NEWS | BUSINESS | DIGITALE TRANSFORMATION | EFFIZIENZ | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

Digital Workspace: Chancen und Ängste rund um die Einführung von Robotic Process Automation

Digitale Transformation bedeutet einerseits Effizienzsteigerung und Kostenminimierung, Kundenbindung, Wachstum sowie Wettbewerbsfähigkeit, andererseits fordert sie Modernisierung in den eigenen Reihen – sprich: die Ausstattung der Mitarbeiter mit neuen Technologien. Laut einer aktuellen Studie leben Unternehmen, die ihre Arbeitsplätze nicht mit zeitgemäßer Technik ausstatten, in Zeiten des Fachkräftemangels gefährlich, denn Angestellte wünschen sich heutzutage neben reibungslosen internen…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | TRENDS GESCHÄFTSPROZESSE | DIGITALE TRANSFORMATION | TRENDS SERVICES | GESCHÄFTSPROZESSE | INFRASTRUKTUR | TRENDS 2018| TRENDS 2020 | KÜNSTLICHE INTELLIGENZ | RECHENZENTRUM | SERVICES | STRATEGIEN

Im Jahr 2020 werden 92 Prozent der europäischen Unternehmen Robotic Process Automation (RPA) einsetzen

Im vergangenen Jahr sind die Ausgaben für RPA um neun Prozent gestiegen. Breiteneinsatz von Automatisierung in Europa verdoppelt sich bis 2020. Der geschäftliche Einsatz von Robotic Process Automation (RPA) in Europa soll sich einer neuen Studie der ISG Information Services Group zufolge bis 2020 verdoppeln [1]. Die Unternehmen wollen damit vor allem ihren Kundenservice…

NEWS | BUSINESS | DIGITALISIERUNG | DIGITALE TRANSFORMATION | TRENDS SERVICES | TRENDS 2017| SERVICES

Smarte Maschinen werden ab 2021 Mainstream

Unternehmen suchen Unterstützung der Service-Provider für den Einsatz von AI-Technologien. Im Jahr 2021 werden 30 Prozent der großen Unternehmen smarte Maschinen einsetzen, die Technologie wird damit zum Mainstream, so das IT-Research und Beratungsunternehmen Gartner. Unter den Oberbegriff »smarte Maschinen« fallen Technologien wie Cognitive Computing, Artificial Intelligence, intelligente Automation, Machine Learning und Deep Learning. »Der Einsatz…

NEWS | ONLINE-ARTIKEL

Die Entwicklung von modernen Technologien in der Spielebranche

Die Spielebranche ist eine der am schnellsten wachsenden Felder im Online-Bereich und entwickelt sich zeitgleich immer weiter fort. Die technologischen Errungenschaften der letzten Jahre in der Branche sind atemberaubend. Die Spieler fordern mehr von den Anbietern und diese müssen liefern. Dies hat dazu geführt, dass jede Menge junge Unternehmen den Markt revolutioniert haben. Einer…

NEWS | IT-SECURITY | ONLINE-ARTIKEL

Cybersecurity in Unternehmen: kontinuierliche Reaktion auf moderne Bedrohungen

Mit der Weiterentwicklung von Bedrohungen wächst auch der Bedarf von Unternehmen, sich gegen die geschäftsschädigenden Auswirkungen von Cyberangriffen zu schützen. Angesichts dieses Trends fordert der Cybersicherheitsanbieter F-Secure, dass sowohl die ständige Bereitschaft für mögliche Sicherheitsverletzung als auch eine schnelle und effektive Eindämmung, die das richtige Gleichgewicht von Mensch, Prozess und Technologie abdeckt, stärker in den…

TRENDS 2019 | TRENDS WIRTSCHAFT | NEWS | BUSINESS

Analog und digital wird eins: Gute Chancen für digitale Vermögensverwaltungen

Die Finanz- und Versicherungswelt befindet sich stark im Wandel. Die Zahl digitaler Angebote von Banken und Versicherungen steigt stetig an, doch wie nehmen Konsumenten diese Angebote wahr? Einblicke in das Verhalten, die Bedürfnisse und Wünsche von Konsumenten im Hinblick auf Finanzangelegenheiten im WorldWideWeb zeigt nun eine aktuelle Umfrage des Mannheimer Spiegel Institut. Neben Direktversicherungen…

TRENDS WIRTSCHAFT | NEWS | BUSINESS | EFFIZIENZ | TRENDS 2018

Patentanmeldungen: Die Schweiz – Wer hat`s erfunden?

Die Schweiz ist europaweit führend bei der Zahl der Patentanmeldungen pro Kopf. Laut einer aktuellen Statistik des Europäischen Patentamts stammten 7.927 der insgesamt 174.317 Patentanmeldungen im vergangenen Jahr aus der Schweiz. Pro Millionen Einwohner sind das 956 Patentanmeldungen. Damit steht die Schweiz europaweit auf Platz 1, vor den Niederlanden (416), Dänemark (411) und Schweden (403…

TRENDS WIRTSCHAFT | NEWS | BUSINESS | DIGITALISIERUNG | TRENDS 2018

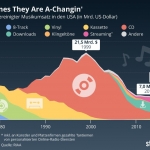

Musikumsatz: The Times They Are A-Changin‘

1999 war ein extrem umsatzstarkes Jahr für die US-Musikindustrie. 21,5 Milliarden US-Dollar wurden damals erwirtschaftet – davon 89 Prozent durch CDs. Gut möglich, dass sie damals in den Chefetagen der Major Labels dachten, dass es genau so weiter gehen würde. Tatsächlich sollte es aber erstmal für mehr als ein Jahrzehnt bergab gehen für die Branche,…