foto freepik

Um eine gute Nutzererfahrung zu gewährleisten, ist Performance-Testing Pflicht. Doch was, wenn unerwartete Lastspitzen auftreten? Was Unternehmen tun können, um Risiken zu mindern?

Der Streaming-Anbieter Netflix ist für seine stabile Plattform und ein flüssiges Video-Erlebnis bekannt. Doch selbst die Großen kommen einmal ins Stolpern: Als Millionen von Fans die Live-Übertragung des Boxkampfs von Jake Paul gegen Mike Tyson sehen wollten, kam es in entscheidenden Momenten zu Rucklern, Verzögerungen und App-Abstürzen. Ganz ähnlich erging es der Plattform Ticketmaster beim Vorverkauf für die US-Tournee von Taylor Swift. Weil man den Ansturm unterschätzt hatte, gingen die Server in die Knie. Schließlich musste das Unternehmen den Ticketverkauf sogar ganz einstellen. Solche Vorfälle zeigen: Plötzliche Lastspitzen können jeden treffen. Während manche Events vielleicht noch vorhersehbar sind, treten andere ganz unerwartet auf. So fiel zum Beispiel der Service des Online-Gaming-Anbieter Wizards of the Coast aus, weil zu viele Kunden gleichzeitig ihr Abonnement kündigen wollten. Der Grund: Jemand hatte eine geplante Lizenzänderung geleakt und die Community dazu aufgefordert, den Anbieter zu wechseln.

Die Belastungsgrenzen austesten

Wenn Server zusammenbrechen, Applikationen abstürzen und Dienste nicht mehr erreichbar sind, wirkt sich das nicht nur unmittelbar auf die Verkaufszahlen aus, sondern schadet auch der Reputation. Denn frustrierte Kunden wechseln zur Konkurrenz und sind das denkbar schlechteste Marketing. Doch Unternehmen können etwas tun, um solche Risiken zu minimieren. Die zwei wichtigsten Fragen sind: Wie können wir unser Performance-Testing verbessern? Und was machen wir, wenn trotzdem unerwarteten Lastspitzen auftreten? Die meisten Unternehmen führen heute Performance-Tests durch. Diese dienen dazu, die Geschwindigkeit, Robustheit und Zuverlässigkeit einer Anwendung unter einer bestimmten Arbeitslast sicherzustellen. Häufig fehlen aber Stresstests, die eine Applikation wirklich an ihre Grenzen treiben und bis zum Absturz führen. Solche Tests sind wichtig, um zu monitoren, wie sich eine Anwendung unter Spitzenlast verhält und welche Symptome sie zeigt, bevor es zum Ausfall kommt. Denn nur wenn man die Anzeichen erkennt, kann man rechtzeitig gegensteuern.

Eine Umleitung ist besser als eine Fehlermeldung

Das führt zu Schritt zwei: den lastbedingten Ausfall vermeiden. Eine Notfallmaßnahme besteht darin, übermäßigen Traffic auf eine statische Seite umzuleiten. Anwender erhalten dann zum Beispiel die Nachricht »Aufgrund eines unerwartet hohen Datenaufkommens ist die Website zu diesem Zeitpunkt nicht verfügbar. Bitte versuchen Sie es später noch einmal.« Das ist in jedem Fall besser als eine Fehlerseite mit dem Code »502 Bad Gateway«. Auf Basis der im Stresstest ermittelten Parameter können Unternehmen Grenzwerte definieren, ab wann eine Umleitung erfolgen soll. Dabei empfiehlt es sich, lieber ein bisschen Puffer einzukalkulieren und die Leitplanken großzügig abzustecken, lange bevor das System gefährdet ist. So wie man einen Zaun nicht direkt am Abgrund, sondern mit etwas Abstand errichtet, um Spaziergänger ausreichend zu schützen.

Warum setzen viele Unternehmen diese Maßnahmen noch nicht um?

Was in der Theorie einfach klingt, hat in der Praxis einen Haken. Denn Stresstests, die bis an die Belastungsgrenze gehen, verursachen in der Regel zusätzliche Kosten für Infrastruktur und Nutzungsraten. Für viele Unternehmen lohnt sich das nicht, da das Risiko einer extremen Belastungssituation verschwindend gering scheint. Dazu kommt, dass das Anbringen von Leitplanken die Betriebskosten erhöhen kann. Denn wenn man die maximale CPU-Auslastung der Server auf 80 Prozent beschränkt, steigt womöglich die Zahl der benötigten Geräte. Am Ende geht es darum, Risiken, Kosten und Nutzen abzuwägen. Kann das Unternehmen einen Ausfall in Kauf nehmen oder ist die Applikation geschäftskritisch? Was wäre teurer: ein Absturz oder die Präventionsmaßnahmen? Mit den richtigen Tools lässt sich Performance-Testing kosteneffizient in DevOps-Prozesse integrieren. Eine Lösung wie Tricentis NeoLoad kann zum Beispiel reale Bedingungen simulieren und komplexe Szenarien automatisiert testen.

Je früher, desto besser

Um eine gute Nutzererfahrung sicherzustellen, sollten Unternehmen Performance-Engineering frühzeitig in die Entwicklung integrieren. Denn je eher man Probleme erkennt, desto kostengünstiger lassen sie sich beheben. Dabei ist es wichtig, eng mit den Business-Stakeholdern zusammenzuarbeiten und zu identifizieren, welche Leitplanken für einen reibungslosen Betrieb gelten. Kontinuierliches Monitoring und Testautomatisierung schaffen die Basis, um die richtigen Entscheidungen zu treffen und Aufwand zu minimieren. So können Unternehmen bereits im Vorfeld Risiken mindern und selbst unvorhergesehene Lastspitzen abfedern.

Bryan Cole, Director of Customer Engineering bei Tricentis

984 Artikel zu „Performance Test“

News | Trends Infrastruktur | Trends Kommunikation | Effizienz | Trends 2016 | Kommunikation | Services

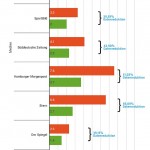

Web-Performance-Test deutscher Medien: Die Leser wollen Tempo

Ein im April veröffentlichtes Experiment der Financial Times bestätigt: Gerade Smartphone-Nutzer bevorzugen schnell ladende Webseiten. Das IT-Team der Zeitung führte folgendes Experiment durch: Für einige Nutzer wurde die Webseite mit einer zusätzlichen, künstlichen Verzögerung von einer Sekunde angezeigt. Eine weitere Gruppe musste, neben der regulären Wartezeit, 3 Sekunden länger warten. Das Ergebnis nach sieben Tagen:…

News | Produktmeldung | Rechenzentrum

Supermicro X14 Max Performance Server für KI, HPC, Virtualisierung und Edge Workloads jetzt verfügbar

Supermicro, ein Anbieter von IT-Gesamtlösungen für KI/ML, HPC, Cloud, Storage und 5G/Edge, beginnt mit der Auslieferung seiner X14 Max Performance Server basierend auf den neuesten Intel Xeon 6900 Prozessoren. Die neuen Systeme bieten Unterstützung für GPUs der nächsten Generation, 400GbE-Netzwerkschnittstellen, E1.S- und E3.S-Laufwerke, MRDIMMs mit hoher Bandbreite von bis zu 8800 MT/s sowie Direct-to-Chip-Flüssigkeitskühlung. Die Supermicro…

News | Business | Business Process Management | Digitalisierung | Geschäftsprozesse

Kapitalbindung durch zu hohe Lagerbestände: Die unsichtbare Fessel der Lieferperformance

Viel zu hohe Lagerbestände und dennoch eine schlechte Lieferperformance – dieses Phänomen beklagen derzeit zahlreiche EMS-Dienstleister. Häufig ist die Materialwirtschaft ein kritischer Faktor, der verhindert, dass Liefertermine zuverlässig eingehalten werden können. Die Problematik liegt unter anderem in einer Komplexitätszunahme im Wertschöpfungsprozess. Perzeptron beleuchtet die Ursachen und zeigt auf, wie Kapitalbindungsanalysen und digitale Werkzeuge zur Verhinderung…

News | Infrastruktur | Produktmeldung | Rechenzentrum

Supermicro stellt neue Max-Performance Intel-basierte X14 Server vor

Die branchenweit größte Auswahl an Workload-optimierten Systemen für KI, HPC, Cloud und Edge. Mehr als 15 Produktfamilien vollständig aktualisierter Server, die für maximale Leistung oder Effizienz optimiert sind, mit GPU-Unterstützung der nächsten Generation, Speicher mit höherer Bandbreite, 400 GbE Netzwerk, E1.S- und E3.S-Laufwerken und Direct-to-Chip-Flüssigkeitskühlungsunterstützung, die auf den neuen Intel® Xeon® Prozessoren der Serie 6900 mit…

News | Effizienz | Favoriten der Redaktion | Infrastruktur | Nachhaltigkeit | Rechenzentrum

Supercomputer des KIT ist einer der energieeffizientesten der Welt

Der »Hochleistungsrechner Karlsruhe« (HoreKa), der seit Juni 2021 am Karlsruher Institut für Technologie (KIT) in Betrieb ist, zählt derzeit zu den schnellsten Rechnern Europas. Nach einem kürzlich erfolgten Upgrade belegt er nun außerdem Rang 6 in der halbjährlich erscheinenden Green500-Liste der energieeffizientesten Rechner der Welt. Damit verbessert sich der Supercomputer um sieben Plätze im Vergleich…

News | Trends 2024 | Trends Wirtschaft | Business | Trends Security | IT-Security | Whitepaper

Security Performance Score – Deutschland hängt im internationalen Vergleich hinterher

Eine neue Studie zeigt, dass Cybersicherheit ein unternehmensweites Problem ist und dass eine stärkere Kontrolle durch den Vorstand zu einer besseren Cybersicherheitsleistung führt. Ein neuer Bericht von Diligent und Bitsight hat ergeben, dass Unternehmen mit fortschrittlicher Leistung im Bereich Cybersicherheit im Durchschnitt 372 Prozent mehr Aktionärsrendite auszahlen können als Unternehmen mit einem einfachem Security…

News | Infrastruktur | Produktmeldung

Rack-Scale-Gesamtlösung für KI-Speicher, um Datenpipelines für High-Performance-KI-Training und KI-Inferenz zu beschleunigen

Schlüsselfertige Datenspeicherlösung für Large Scale KI-Training und -Inferenz – Hunderte von Petabytes in einer Multi-Tier-Lösung unterstützen die für skalierbare KI-Workloads erforderliche enorme Datenkapazität und #Datenbandbreite. Supermicro, ein Hersteller von IT-Gesamtlösungen für KI, Cloud, Speicherung und 5G/Edge, bringt eine optimierte Full-Stack-Speicherlösung für KI- und ML-Datenpipelines auf den Markt – von der Datenerfassung bis zur hochleistungsfähigen…

News | Infrastruktur | Nachhaltigkeit | Rechenzentrum | Ausgabe 11-12-2023

Nachhaltigkeit und Performance bei Rechenzentren – Flüssigkeitskühlung gewinnt zunehmend an Bedeutung

Server für KI stoßen schnell an die Grenzen der Luftkühlung. Es ist daher eine Reihe von Flüssigkeitskühlungen erforderlich, von Wärmetauschern an der Rückseite der Tür über die direkte Kühlung des Chips bis hin zum vollständigen Eintauchen des Systems, um den PUE-Wert in einem Rechenzentrum auf nahezu 1,0 zu senken. Michael McNerney, Senior Vice President Marketing and Network Security gibt noch weitere Einblicke in die innovativen Entwicklungen bei Supermicro.

News | Cloud Computing | Infrastruktur | Strategien | Ausgabe 9-10-2023

Moderne Storage-Lösungen optimieren die Gesamtperformance, Kosteneffizienz, Nachhaltigkeit und Sicherheit

Ein an die Cloud angebundenes All-Flash-Rechenzentrum senkt die Kosten und kommt der Umwelt zugute, weil es eine bessere Energieeffizienz aufweist. Eine ganzheitliche Managementschnittstelle orchestriert die hybride Multicloud-Infrastruktur und fungiert gleichzeitig als Security-Kontrollzentrale. So kann es durch integrierte Sicherheitslösungen gegen Ransomware-Attacken schützen. Das ist die nächste Welle der Storage-Innovation.

News | Cloud Computing | Infrastruktur | Strategien | Ausgabe 9-10-2023

Der Vierklang: Performance, Skalierbarkeit, Security, Nachhaltigkeit – Highend-Storage im Aufwind

In einer sich ständig wandelnden digitalen Landschaft müssen Unternehmen nicht nur mit der Zeit gehen, sondern vorausdenken. Dabei spielt die effektive Speicherung und Verwaltung von Daten eine entscheidende Rolle. Trotz der zunehmenden Beliebtheit von Cloud-Speicherlösungen bleiben Highend-Speicherarrays im »On-Premises«-Betrieb eine starke Option für Großunternehmen, die eine leistungsfähige, skalierbare und sichere Datenspeicherung benötigen.

News | Business Process Management | Künstliche Intelligenz

Intelligente Bilderkennung: KI »James« automatisiert Testläufe für User Interfaces

Das intuitive Bedienen von Software setzen Nutzer meistens voraus. Um Programmfehler, sogenannte Bugs, zu vermeiden, müssen Unternehmen jedoch regelmäßig aufwendige Tests im Hintergrund durchführen. Dem Karlsruher Start-up askui ist es gelungen, ein Developer-Tool für das parallele und automatisierte Testen unterschiedlicher Anwendungen mithilfe von künstlicher Intelligenz zu entwickeln. Vom Nutzer unbemerkt werden die Klickpfade, die…

News | Business | Strategien

Technologien nutzen, um soziale, wirtschaftliche und ökologische Performance zu maximieren

Traditionell spielen Themen wie Environment, Social und Governance für deutsche Unternehmen eine große Rolle und grüne Technologien werden auch in Zukunft stark an Relevanz gewinnen. Im Interview erklärt Dr. Rolf Werner von Cognizant wie seine Organisation den Wandlungsprozess hin zu nachhaltig agierenden Unternehmen unterstützt. Was war die Intention zur Veröffentlichung des ESG-Reports? Der ESG-Report…

News | IT-Security | Produktmeldung

Checkmarx ist Leader im Gartner Magic Quadrant für Application Security Testing 2021

Checkmarx, Anbieter entwicklerzentrierter Application-Security-Testing-Lösungen, gibt bekannt, dass das Unternehmen im Gartner Magic Quadrant for Application Security Testing 2021 im vierten Jahr in Folge als »Leader« eingestuft wurde. Im Report würdigt Gartner Checkmarx für die ganzheitliche Vision und die hohe Umsetzungskompetenz im Markt für das Application Security Testing (AST). Laut den Autoren des Reports »hat…

News | Lösungen

Digitale Schnelltestlösung mit App für Unternehmen: Organisation, Dokumentation und Nachverfolgung einfach, schnell und sicher mit dem Huber Smart Health Check

Als rein digitale Lösung für Laientests oder als Service-Option mit medizinischen Antigen-Schnell- und PCR-Tests vor Ort oder mobil im Testbus. Die Testpflicht für Unternehmen ist beschlossen und stellt selbige vor große organisatorische Herausforderungen. Ob Laientests zu Hause (Selbsttests) oder Schnelltests vor Ort – Abläufe müssen effizient und wirtschaftlich organisiert werden. Eine Dokumentation ist zwar…

News | Services | Strategien

Projektabwicklung im Softwaretest: Fundierte Planung ist der Schlüssel für erfolgreiches Testprojekt

Softwaretests wurden noch vor einiger Zeit als lästiges Übel klassischer Entwicklungsprojekte angesehen. Doch viele Unternehmen haben mittlerweile ihren Standpunkt geändert und geben einen erheblichen Teil ihres IT-Etats für das Testen von Software aus. Denn nur so können langfristig die Qualitätserwartungen der Kunden erfüllt werden. Allerdings: Welche Teststrategie ist die richtige? Welche Risiken gibt es und…

News | IT-Security | Tipps | E-Government

Vorsicht vor Betrügern beim Online-Kauf von Corona-Schnelltests

Corona-Schnelltests sollen nach den aktuellen Plänen der Bundesregierung zügig Fortschritte auf dem Weg aus dem Lockdown bringen. Die Tests auch für zu Hause sollen frei erhältlich sein, also auch in Online-Shops. Beim zu erwartenden Run auf die Teststreifen könnten auch Cyberkriminelle gute Geschäfte wittern, vermuten die Cybersicherheitsexperten des Karlsruher Instituts für Technologie (KIT). Sie geben…

News | Business | Ausgabe 7-8-2020

Monitoring und automatisierte Tests – Erfolgreiches Change Management für VDI-Umgebungen

News | Infrastruktur | Lösungen | Ausgabe 7-8-2020

Automatisierung und Shift-Left-Testing – Schnell und zuverlässig Tests automatisieren

Die Entwicklung von Mainframe-Software ist langsam – zumindest bisher. Denn Unternehmen automatisieren immer mehr repetitive Test-Prozesse, um Performance und Qualität zu erhöhen. Durch automatisierte Tools erhalten Mainframe-Entwickler mehr Freiraum für strategische Aufgaben wie das Schreiben von neuem Code.

News | Business Process Management | Effizienz | Tipps

High Performance Applications – DevOps für bessere Entwicklung und Bereitstellung

Wer DevOps aktiv praktiziert ist in der Lage, von Beginn an leistungsfähigere Software zu entwerfen: Probleme können schnell ausgemerzt und hochleistungsfähige Anwendungen eingesetzt werden. Ein effizientes Performance-Testing-Modell zu schaffen, geht im Idealfall mit vier Schlüsselattributen einher: Ausweitung der Leistungstests auf neue Rollen, Integration in den CI/CD-Prozess, End-to-End-Leistungsüberwachung sowie kontinuierliche Optimierung. Mark Levy, Director of Strategy…