Die Entwicklung von Mainframe-Software ist langsam – zumindest bisher. Denn Unternehmen automatisieren immer mehr repetitive Test-Prozesse, um Performance und Qualität zu erhöhen. Durch automatisierte Tools erhalten Mainframe-Entwickler mehr Freiraum für strategische Aufgaben wie das Schreiben von neuem Code.

Von Covid-19 über digitale Wettbewerber bis zum Brexit: Unternehmen müssen sich heute auf immer schnellere Veränderungen einstellen. Dabei gibt es für alle Krisen einen sicheren Fels in der Brandung: den Mainframe. Denn was auch immer geschieht, der Mainframe unterstützt weiterhin geschäftskritische Anwendungen und verarbeitet wichtige Daten.

Ein Hindernis für die schnelle Anpassung an neue Anforderungen war jedoch die langsame Entwicklung von Mainframe-Software aufgrund vieler manueller, sich wiederholender Abläufe. Inzwischen haben aber viele Unternehmen damit begonnen, repetitive Prozesse zu automatisieren, um die Effizienz zu steigern und gleichzeitig den hohen Qualitätsstandard des Mainframes aufrechtzuerhalten.

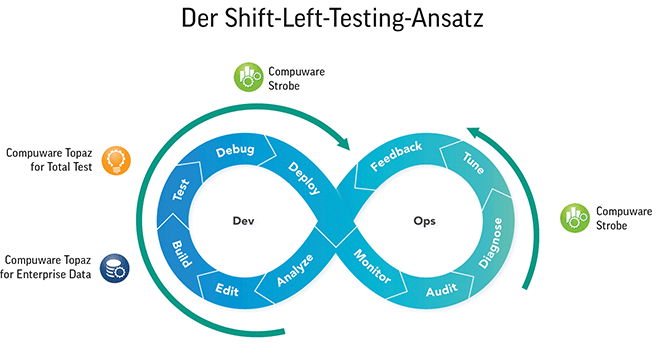

Neuer Ansatz: Shift-Left-Testing. Dabei ist es nicht nur wichtig, bestehende Testroutinen zu automatisieren, sondern sie auch möglichst früh im Entwicklungszyklus durchzuführen. Dies versteht man unter »Shift-Left-Testing«, also die Verschiebung der Tests nach vorne und damit nach links in der Darstellung des zeitlichen Ablaufs. Denn je früher ein neu entwickelter Code geprüft wird, desto eher fallen mögliche Probleme auf und desto effizienter ist ihre Lösung. Je später ein Bug entdeckt wird, desto aufwändiger wird dessen Behebung. Unter Umständen müssen Entwickler dann sogar in einer späten Phase völlig neuen Code schreiben und erneut aufwändig testen. Damit geht unnötig Zeit verloren.

Sowohl Automatisierung als auch Shift-Left-Testing erhalten eine zunehmende Bedeutung. Denn die steigende Nachfrage der Fachabteilungen nach schnelleren Innovationen übt einen immer größeren Druck auf die IT-Abteilungen aus. Laut einer aktuellen Umfrage von Vanson Bourne im Auftrag von Compuware halten es 85 Prozent der IT-Führungskräfte für schwierig, Innovationen schneller zu liefern, ohne dabei Qualität, Sicherheit, Kundenerfahrung und betriebliche Effizienz zu beeinträchtigen [1]. Entsprechend gilt die Testautomatisierung als wichtigster Einzelfaktor zur Überwindung dieser Risiken.

Gleichzeitig sagen 82 Prozent der Befragten, dass sie den Bedarf ihres Unternehmens an Geschwindigkeit nicht erfüllen können, wenn sie nicht mehr Testfälle automatisieren. Die Kombination aus Automatisierung und Shift-Left-Testing hilft Mainframe-Teams, qualitativ hochwertige Software schneller bereitzustellen. Die Entwickler erhalten schnelles Feedback zu ihrem Code, so dass sie Performance-Probleme frühzeitig erkennen und beheben können.

»Qualität so früh wie möglich in Software zu integrieren, ist eine der größten und wichtigsten Veränderungen«, erklärt zum Beispiel Gary Gruver, unabhängiger Experte für digitale Transformation [2]. »Häufig ist sie auch eine der schwierigsten, aufgrund der Herausforderungen bei der Koordination und Automatisierung von Code-Änderungen, Testfalländerungen und Testdaten.«

Neue Tools für die Automatisierung. Der bisherige Mangel an Testautomatisierung und einfachem Zugang zu guten Testdaten hielt Unternehmen von notwendigen Verbesserungen der Qualität, Geschwindigkeit und Effizienz der Mainframe-Software-Entwicklung ab. Doch inzwischen stehen Tools zur Verfügung, die automatisches Testen sowie das Management von Mainframe- und Nicht-Mainframe-Daten integrieren. Dadurch lässt sich die Testdateneinrichtung direkt in automatisierte Tests einbetten. Aufgrund der weiteren Automatisierung der Shift-Left-Tests können Unternehmen eine noch höhere Konsistenz, Genauigkeit und Sicherheit der Testdaten gewährleisten. Damit profitieren sie von folgenden Vorteilen:

Verbesserte Testkonsistenz

Kontinuierliche automatisierte Tests erfordern konsistente Testdaten. Ansonsten drohen inkonsistente oder falsche Ergebnisse, aufwändige Fehlerbehebung oder sogar die Einführung neuer Fehler. Mit integrierten Tools gewährleisten Unternehmen Testkonsistenz, indem sie den Datenladeprozess als Teil des Testfalls aufrufen und automatisch eine Teilmenge von Daten in eine Testumgebung laden. Falls der Test fehlschlägt, können Entwickler und Tester das Problem zuverlässig am Code festmachen, da es nicht an den Daten liegen kann.

Weniger Reibungsverluste

Entwickler benötigen oft ein spezialisiertes Team oder einen Datenbankadministrator, um Daten zu erstellen und in eine Testumgebung zu laden. Dieser Vorgang erfordert viele manuelle Prozesse, Wartezeiten und Übergaben, welche die Geschwindigkeit und Effizienz unnötig beeinträchtigen. Mit Hilfe aktueller Lösungen können Entwickler selbst die richtigen Testdaten einrichten und nutzen, sobald sie diese benötigen.

Schrittweise automatisieren

Die Automatisierung lässt sich Schritt für Schritt einführen. So können Unternehmen Umfang und Tempo der Umstellung steuern und manuelle Abläufe nach und nach ersetzen. Ein wiederholbarer Prozess zum Extrahieren und Laden von Daten kann Teil einer automatisierten Test-Toolchain sein. Dies erhöht die Datenkonsistenz und verringert die Komplexität.

Schutz sensibler Daten

Mit integrierten Prozessen lassen sich die Testdaten anonymisieren, sobald sie geladen sind. Dies schützt persönlich identifizierbare Informationen (PII). Automatisieren Unternehmen diesen Vorgang im Rahmen kontinuierlicher Tests, verringern sie das Risiko eines Sicherheitsvorfalls.

Fazit. Beim Wort »Mainframe« denken viele IT-Experten immer noch an zuverlässige, aber statische Prozesse. Doch das ändert sich gerade, da integrierte Tools über neue Funktionen die Testdaten- und Testfallprozesse weiter automatisieren und integrieren. So wird auch der Mainframe immer agiler und lässt sich vollständig in alle Aspekte der DevOps-Toolchain einbinden – von Unit-Tests über Funktions- und Integrationstests bis hin zu CI/CD-Systemen. So gibt es keinen Grund mehr, warum der Mainframe den Entwicklungsaufwand für neue Lösungen verlangsamen sollte. Das Programmieren von neuem Code ist hier inzwischen genauso schnell, kostengünstig und risikoarm wie bei anderen Plattformen.

Thomas Keisel,

Thomas Keisel,

Vice President Central Europe,

Eastern Europe bei

Compuware

[1] https://resources.compuware.com/automated-testing-survey-vanson-bourne-en

[2] https://garygruver.com/

Illustration: © Ink Drop, Flat art /shutterstock.com

95 Artikel zu „Mainframe“

NEWS | INFRASTRUKTUR | LÖSUNGEN | AUSGABE 3-4-2019

Software Defined Mainframes – Die letzten ihrer Art

Mainframes sind für Ausfallsicherheit, Zuverlässigkeit und hohen Datendurchsatz bekannt. Dennoch erscheint eine Modernisierung auf einen Software Defined Mainframe (SDM) zweckmäßig. Dieser ermöglicht den Weiterbetrieb der Bestandsapplikationen in einer Open-Source-Umgebung. Dadurch kann Bewährtes beibehalten, Neues flexibel hinzugefügt und die Unternehmensagilität gesteigert werden.

NEWS | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | INFRASTRUKTUR | TRENDS 2019 | RECHENZENTRUM

Mainframe-Trends für 2019

Der Mainframe wird auch im Jahr 2019 seinen Platz in der Unternehmens-IT behaupten. Machine Learning, Analytics und intelligente Algorithmen werden den Weg ebnen für selbstverwaltende Mainframe-Umgebungen. In mehrschichtigen Architekturen ist der Mainframe die leistungsfähigste, sicherste und zuverlässigste Backend-Infrastruktur. Welche weiteren Entwicklungen besonders prägend sein werden, weiß Hubert Göhler, Sales Director ZSO in der DACH-Region bei…

NEWS | TRENDS WIRTSCHAFT | TRENDS INFRASTRUKTUR | DIGITALISIERUNG | INFRASTRUKTUR | TRENDS 2018 | TRENDS 2022 | STRATEGIEN

Mythos Mainframes: Großrechner bleiben langfristig Rückgrat der Digitalisierung

Es existieren Vorurteile über aktuelle Rolle und Zukunft von Großrechnern (Mainframes) in Industrie, Handel, Dienstleistung und Verwaltung. Eine Umfrage belegt, dass 91 Prozent der Befragten mit einer Zunahme von Mainframes rechnen. Multicloud-Technologien können sie auch langfristig nicht ersetzen. Große Unternehmen aus Industrie, Handel und Dienstleistung sowie der öffentlichen Verwaltung setzen auch in Zukunft auf…

NEWS | BUSINESS PROCESS MANAGEMENT | TRENDS INFRASTRUKTUR | CLOUD COMPUTING | TRENDS CLOUD COMPUTING | DIGITALE TRANSFORMATION | EFFIZIENZ | TRENDS GESCHÄFTSPROZESSE | GESCHÄFTSPROZESSE | INFRASTRUKTUR | TRENDS 2018 | RECHENZENTRUM

Mainframe wird immer wichtiger: Kritische Workloads nehmen zu

Mehr als drei Viertel der Kunden-Anwendungen hängen vom Mainframe ab. Zahl der Mainframe-Experten sinkt. Unternehmen versäumen die Erhebung wichtiger KPIs. Der Mainframe wird für große Unternehmen immer wichtiger. Die Zahl der Nutzer, die mindestens die Hälfte ihrer geschäftskritischen Anwendungen auf dieser Plattform laufen lässt, wird im kommenden Jahr steigen. Allerdings droht der Mangel an…

NEWS | TRENDS SECURITY | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | DIGITALE TRANSFORMATION | EFFIZIENZ | INFRASTRUKTUR | TRENDS 2017 | IT-SECURITY | STRATEGIEN

Mainframes gelten als besonders sicher, doch bleiben Insiderbedrohungen vielerorts ein weißer Fleck

In Deutschland vertrauen 76 Prozent der Unternehmen einseitig auf Logdateien – und setzen sich damit selbst der Gefahr von Datenlecks aus. Laut einer internationalen CIO-Umfrage halten hierzulande 72 Prozent der IT-Verantwortlichen ihre Mainframerechner für sicherer als andere IT-Systeme [1]. Gleichzeitig gehen 85 Prozent der deutschen Studienteilnehmer von signifikanten Insiderrisiken aufgrund mangelnder Transparenz bei Datenzugriffen auf…

NEWS | BUSINESS | EFFIZIENZ | INFRASTRUKTUR | IT-SECURITY | ONLINE-ARTIKEL | RECHENZENTRUM | SERVICES

RACF-Audit minimiert Risiken bei Mainframe-Kunden

Neun Zehntel aller globalen z/OS-Anwenderunternehmen nutzen RACF für Benutzeridentifikation, Zugriffsrechte-Verwaltung und Logging. Steigende kriminelle Angriffe, organisatorische Mängel oder technische Unfälle erfordern es, das IBM-Tool permanent auf IT-Risiken und Schwachstellen zu überprüfen. Im Rahmen eines neuen Beratungsangebotes bietet die Beta Systems DCI Software AG z/OS-Anwenderunternehmen solche Audits an. Mögliche Schwachstellen lassen sich dadurch rechtzeitig aufdecken und…

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | DIGITALE TRANSFORMATION | INFRASTRUKTUR | OUTSOURCING | RECHENZENTRUM | SERVICES | TIPPS

Studie: Mainframe-Anwendungen behindern Innovationen

DevOps ermöglichen günstigere und schnellere Bereitstellung in höherer Qualität. Unternehmen mit Mainframes haben Schwierigkeiten damit, neue Versionen von Anwendungen so schnell bereitzustellen, wie es die digitale Geschäftsentwicklung erfordert. Damit laufen sie Gefahr, die Erwartungen der Kunden an die Produkte nicht zu erfüllen. Dies zeigt eine neue Studie, die von Forrester Consulting im Auftrag von Compuware…

NEWS | BUSINESS | TRENDS INFRASTRUKTUR | DIGITALE TRANSFORMATION | INFRASTRUKTUR | TRENDS 2017 | RECHENZENTRUM | STRATEGIEN

Der Mainframe ist auch im Zeitalter des digitalen Wandels unverzichtbar

Überragende Zuverlässigkeit, Leistung und Sicherheit sind Hauptgründe für Investitionen in Mainframe-Technik. BMC hat die Ergebnisse seines 11. Mainframe Research Report vorgelegt [1]. Danach bleiben schnelle und robuste Mainframe-Systeme auch in Zeiten des digitalen Wandels eine gefragte Plattform. Fast 60 Prozent der befragten Unternehmen gehen davon aus, dass sie sich angesichts zunehmender Datenmengen, Transaktionsvolumina und Datenbankzahlen…

NEWS | CLOUD COMPUTING | EFFIZIENZ | INFRASTRUKTUR | KOMMENTAR | ONLINE-ARTIKEL | RECHENZENTRUM | STRATEGIEN

Zeit umzudenken: Der Mainframe ist tot, lang lebe der Mainframe!

7 Mythen über Mainframes von Peter Schroff, Principal Value Engineer bei BMC Software. Mainframes stehen nicht im besten Ruf. Der Otto Normalverbraucher assoziiert sie zuweilen mit gewissenlosen Künstlichen Intelligenzen, die die Menschheit entweder ausbeuten oder auslöschen wollen – wie etwa in den »Terminator«- oder »Matrix«-Trilogien. Im besten Fall denkt er an den Supercomputer »Deep Thought«…

NEWS | CLOUD COMPUTING | INFOGRAFIKEN | RECHENZENTRUM

So sehen vier Mitarbeiter-Generationen den Mainframe

Viele Technologien kommen und gehen, doch eine bleibt: Der Mainframe. Dieser bildet bereits seit seiner Einführung in den 60er-Jahren die Basis für fast alle Transaktionen im Finanzsektor, aber auch in anderen Bereichen wie im Flugverkehr. Während sich die grundlegenden Technologien nur wenig verändert haben, wird er inzwischen von der vierten Generation an Mitarbeitern verwaltet. Doch…

NEWS | TRENDS INFRASTRUKTUR | INFRASTRUKTUR | RECHENZENTRUM

IT-Führungskräfte müssen ihre Investitionen in Mainframes überdenken

Unternehmen laufen Gefahr, hinsichtlich des Generationenwechsels bei der Mainframe-Verwaltung unzureichend zu planen, obwohl sich Mainframe-Workloads gerade im Wachstum befinden und eine kritische Rolle bei der digitalen Innovation spielen. Das ist ein Kernergebnis der globalen Studie »Die neue Welt der Mainframes«, die das unabhängige Marktforschungsinstitut Vanson Bourne im Auftrag von Compuware bei 350 CIOs aus unterschiedlichen…

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | INFRASTRUKTUR

Königsweg Automatisierung – Der Weg zu mehr Effizienz für Data Warehouse und Data Lake

Data Warehouses haben eine lange Tradition. Doch mit Big Data Analytics und Data Lakes haben viele diesen Ansatz totgesagt. Das entspricht allerdings nicht der Realität: Geschätzt betreiben mehr als 60 Prozent der Unternehmen Data Warehouses, oft sogar mehrere. Assets, in die viel investiert wurde und die Vorteile bieten, die mit einem Data Lake nicht erreicht…

NEWS | IT-SECURITY | TIPPS

Cybersicherheit: Insider-Bedrohungen in Zeiten der Pandemie

Schlechte Zeiten und Krisen sind gute Zeiten für Cyberkriminelle, denn ihnen gelingt es in der Regel aus der Situation Kapital zu schlagen. Die Covid-19-Pandemie bildet da keine Ausnahme. Unternehmen sind umso mehr gefährdet, als dass die meisten von ihnen ausreichend damit zu tun haben, die Firma durch die Krise zu navigieren, parallel dazu agieren Cybersicherheits-Teams…

NEWS | BUSINESS PROCESS MANAGEMENT | STRATEGIEN | TIPPS

Wer große Sprünge macht, verliert den Überblick

Immer wieder lassen Unternehmen die Pflege ihrer Anwendungen schleifen. Oft verlieren sie dann den Überblick – und es wird teuer. Software kann aber auch von kleinen Anpassungsschritten profitieren. Jedes Unternehmen, das Applikationen selbst entwickelt, weiß: Software ist nie fertig. Regelmäßig werden neue Bugs entdeckt, und Fachabteilungen fordern in zunehmendem Maße Flexibilität von der…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | AUSGABE 5-6-2020

Neue Wertschöpfungsmöglichkeiten und Geschäftsmodelle entdecken – Prozessoptimierung am digitalen Arbeitsplatz

Die Digitalisierung bestimmt nachhaltig den Arbeitsalltag und bietet zahlreiche Potenziale sowie Wertschöpfungsmöglichkeiten. Gleichzeitig stellt sie jedoch auch viele Unternehmen vor einige Herausforderungen. Grund dafür sind vor allem die Anforderungen hinsichtlich der Verarbeitung und Auswertung kontinuierlich wachsender Datenmengen sowie die steigende Anzahl an Applikationen. Wichtig ist es, die relevanten Informationen aus den diversen Unternehmensbereichen zentral im Blick zu behalten und notwendige Anwendungen auch außerhalb des Unternehmens einfach und sicher für Mitarbeiter oder Kunden bereitzustellen.

NEWS | BUSINESS | DIGITALISIERUNG | STRATEGIEN | SECURITY SPEZIAL 5-6-2020

Nach dem Stillstand wird Innovationsgeschwindigkeit wichtiger als jemals zuvor – Die Krise als Chance

Corona befördert die deutsche Wirtschaft per Schleudersitz in die digitale Zukunft. Unternehmen und Institutionen sind nun gezwungen, Innovationen mit aller Konsequenz voranzutreiben. Die gute Nachricht: Organisationen, die jetzt die richtigen Maßnahmen einleiten, werden aus der Krise gestärkt hervorgehen.

NEWS | TRENDS 2020 | TRENDS INFRASTRUKTUR | CLOUD COMPUTING | EFFIZIENZ | INFRASTRUKTUR | RECHENZENTRUM

Studie: Rechenzentren sind Garant für nachhaltige Digitalisierung in Europa

Deutliche Steigerung der Energieeffizienz: 12 Mal niedrigerer Energieverbrauch pro übertragenem GB Daten in Rechenzentren im Vergleich zu 2010. Stetig sinkende CO2-Emissionen (30 % weniger bis 2030) trotz steigender Anforderungen an Rechenleistung. Globales Energieeffizienzpotenzial durch Cloud Computing noch nicht ausgeschöpft. Forderung: Bundesregierung muss energiewirtschaftliche Rahmenbedingungen für Rechenzentren dringend optimieren und europäische Rahmenbedingungen anstreben. Rechenzentren sind…

NEWS | EFFIZIENZ | FAVORITEN DER REDAKTION | INFRASTRUKTUR | RECHENZENTRUM

Grüne Rechenzentren statt heißer Luft

Auf dem IN-Campus in Ingolstadt wird Audi künftig die Abwärme des Rechenzentrums als Heizenergie nutzen. (Bild ©Audi AG, Audi IN-Campus: https://www.incampus-tec.de ) Nicht nur der gestiegene Serienkonsum auf Netflix, Amazon Prime und Co. stellt die Kapazitäten der Rechenzentren auf eine harte Probe. Auch unzählige E-Mails, Social Media Posts, Videokonferenzen oder Kryptowährungen wie Bitcoin tragen…

NEWS | BUSINESS | BUSINESS PROCESS MANAGEMENT | GESCHÄFTSPROZESSE | STRATEGIEN

Business Analysten: Fachkräftebedarf und neue Anforderungsprofile in der IT

Mehr als Anforderungsmanagement: Die Arbeit der Business Analysten. Ihr Berufsprofil ist noch wenig bekannt, dabei sind sie in IT-Projekten unverzichtbar: Business Analysten. Als Bindeglied zwischen Fachbereich und IT verantworten sie das Anforderungsmanagement, sind aber zunehmend auch mit neuen Aufgaben bis hin zum Projektmanagement konfrontiert – für Unternehmen oft ein Grund, nach Verstärkung in diesem Bereich…

NEWS | INFRASTRUKTUR

5 Schwerpunkte bei der IT-Modernisierung

Was sind die fünf entscheidenden Punkte, die für den Aufbau einer zukunftsfähigen, krisenfesten IT-Infrastruktur für Unternehmen wichtig sind? Viele Unternehmen stoßen in Krisenzeiten an ihre Grenzen. Überlastete Hotlines, eingeschränkte Kundenkommunikation und die Herausforderungen der Mitarbeiter beim Home Office illustrieren die Notwendigkeit, interne Strukturen und Abläufe neu zu ordnen. Häufig spielt dabei eine zu starre, ineffiziente…