Data Warehouses haben eine lange Tradition. Doch mit Big Data Analytics und Data Lakes haben viele diesen Ansatz totgesagt. Das entspricht allerdings nicht der Realität: Geschätzt betreiben mehr als 60 Prozent der Unternehmen Data Warehouses, oft sogar mehrere. Assets, in die viel investiert wurde und die Vorteile bieten, die mit einem Data Lake nicht erreicht werden können – und umgekehrt. Beide Ansätze haben ihre Daseinsberechtigung, vorausgesetzt allerdings, sie entsprechen dem aktuellen Stand der Technologie. Die wirkliche Herausforderung besteht heute darin, beide Ansätze zu optimieren – also zu automatisieren.

Data Warehouse – strukturiert und unflexibel?

Data Warehouses spielen eine große Rolle in den Datenstrategien von Unternehmen, sowohl für traditionelle Anwendungsfälle als auch für neue Szenarien. Die Technologie schafft eine bewährte »Single Source of Truth« mit schnellen Abfrageergebnissen und vielen Analytics-Optionen. Doch der Ansatz hat auch seine Schattenseiten. Data Warehouses wie SQL Server, Oracle Exadata und Teradata brauchen einen komplizierten Extract-Tansform-and-Load-Prozess (ETL). Beim klassischen ETL-Prozess werden verschiedenste Daten aus mehreren Quellen in einer Zieldatenbank zusammengeführt und dafür in das erforderliche Schema und Format gebracht. Der Datentransfer beginnt normalerweise mit einem Full-Load: Daten aus den Quellen gehen durch Raw-and-Refinement-Phasen, in denen Tools korrupte und ungenaue Records entdecken, korrigieren oder löschen. Bei diesem Schritt werden zusätzliche Bereinigungen durchgeführt, wie zum Beispiel ungenaue und falsche Einträge zu entdecken und zu korrigieren oder zu löschen. Dieser Prozess der ETL-Codierung dauert je nach Datengröße und -formaten mehrere Stunden.

Herausfordernd ist auch die Datenanalyse: Eine Analyse-Anfrage darf sich nicht auf die Produktivsysteme auswirken und wird deshalb auf andere Plattformen ausgelagert. Bei diesem Batch-Loading werden Files oder Tabellen im Ziel geschaffen, ihre Metadatenstrukturen auf Basis der Quelle definiert und die Tabellen dann mit den von der Quelle kopierten Daten nach Vorgaben der Metadaten-Definition befüllt. Batch-Verarbeitung und periodisches Hochladen der neuesten Daten braucht Zeit und oft auch viel Rechenpower im Quellsystem. Traditionelle Batch-Replikation und manuelles Extrahieren von Scripts sind ineffizient und langsam, und stoppen den laufenden Betrieb für die Batch-Verarbeitung. Das ist immer weniger akzeptabel.

Data Warehouse Automation – der Turbo für die Prozesse

Abhilfe schaffen Data-Warehouse-Automation-Tools (DWA). Sie automatisieren rund drei Viertel der Prozesse, etwa mit Hilfe von algorithmischen Quell- und Ziel-Transformationen. DWA sorgt in jedem Abschnitt der Pipeline für zuverlässige Ergebnisse, angefangen bei der Datenmodellierung und Echtzeiterfassung bis zu Datenbereinigung und Transformation, Data Marts und Governance.

Vermutlich am häufigsten automatisiert werden ETL-Prozesse, die damit schneller und qualitativ konsistenter werden. Mit DWA können Unternehmen ETL automatisch in Code-Vorlagen umwandeln, die überall repliziert werden können. Diese Code-Vorlagen enthalten Metadaten, die den Kontext darüber angeben, was sie bei der Ausführung tun sollen. Die Vorlagen sind nicht nur wiederverwendbar, sondern können auch an bestimmte Prozesse angepasst werden, um die Automatisierung über immer mehr Prozesse hinweg voranzutreiben und redundante Aufgaben zu reduzieren. Infolgedessen können Data Warehouses schnell umgestaltet werden, was Kosten und Ressourcen spart.

DWA beschleunigt die Integration von Daten mit Hilfe von vorkonfigurierten Konnektoren erheblich. Integrationszyklen kosten nur noch einen Bruchteil der Zeit: So kann eine Aufgabe, die früher rund sechs Stunden manuelle Arbeit erfordert hat, in nur 30 Minuten erledigt werden. Ein weiterer Vorteil: Die Server laufen stabiler, denn die richtige Balance zwischen Anwendungs- und ETL-Arbeitslasten gewährleistet, dass die Server nicht mit Datenspeicherprozessen überlastet werden, sondern die optimale Leistung für Operatives erhalten bleibt. Der schnellere Zugriff auf Daten im Data Warehouse erhöht die geschäftliche Agilität erheblich.

Automatisierungstools bieten zudem eine automatische Analyse der Ergebnisse, sobald ein ETL-Prozess abgeschlossen ist. Für Compliance ist gesorgt, da jede Aufgabe sichtbar gemacht und jede Prozessausführung verfolgt wird. Da ganze Prozesse überwacht werden, können IT-Teams Bereiche zur Verbesserung identifizieren, Fehler leicht beheben und automatisierte Tests durchführen – eine Transparenz, die Verantwortlichkeit sicherstellt. Das durchgängige Datenmanagement bildet die Grundlage für intelligente Anwendungen wie Machine-Learning-Projekte. BI-Abfragen werden so günstiger und lassen sich innerhalb von Stunden anstatt Wochen oder Monaten durchführen. Sogar neue Data Wahrehouses können über DWA-Tools mit Hilfe der visuellen Benutzeroberfläche per Drag&Drop schnell und relativ einfach designt und implementiert werden.

Data Lakes – Flexibel, aber leicht versumpft?

Data Lakes wurden dafür entwickelt, riesige Mengen an strukturierten, halbstrukturierten und unstrukturierten Daten in ihren nativen Formaten zu speichern. Ihr Vorteil liegt zum einen in der relativ kostengünstigen Speicherung, zum anderen in ihrer Echtzeitfähigkeit bei Kombination mit ebenfalls automatisiertem Data-Streams, wodurch sie Analytics-Anwendungen wie Betrugserkennung, Echtzeitangebote für Kunden, Trendanalysen, Social Media Monitoring etc. unterstützen können. Der Schritt in die Cloud macht sie skalierbar. Mehr Maschinen können den Ressourcen-Pool innerhalb des Rechenzentrums oder mit einer VPN-Verbindung in die Cloud-Infrastruktur erweitern.

Bei allen Vorteilen bringen Data Lakes aber auch ihre eigenen Herausforderungen mit sich. Der Data Lake kann zu einem Data Swamp werden, wenn Anwender nicht einfach auf die Daten zugreifen und sie analysieren können. Bei einer großen Menge von Datenquellen leiden die Implementierungszeit, die Entwicklungsressourcen und die gesamte IT-Umgebung. Unternehmen müssen sich Gedanken über den für sie besten Ansatz für den Aufbau und die Verwaltung dieser Speicher machen, damit sie die benötigte Agilität bieten können.

Bei der Schaffung eines Data Lakes wird Datenintegration zum erfolgskritischen Faktor. Die Analyse von Informationen aus sehr vielen verschiedenen Datenquellen macht das Management komplex und beeinträchtigt die Produktivität. Nun fehlt es Unternehmen aber oft an Integrations-Tools und dem entsprechenden Know-how. Die traditionellen Softwaretools für Datenintegration sind nicht darauf ausgelegt, die Anforderungen von Data-Lake-, Streaming- und Cloud-Plattformen an die Aufnahme großer Datenmengen zu erfüllen, vor allem wenn es um Echtzeitanwendungen geht. Machine Learning und andere KI-Algorithmen belasten die Datenintegrationstools zusätzlich: Sowohl bereits operationalisierte KI- und Data-Science-Anwendungen als auch dedizierte Entwicklungsumgebungen (Sandboxes) benötigen – möglichst viele – Daten zum Trainieren ihrer selbstlernenden Algorithmen, die alle in den Data Lake integriert werden müssen.

Damit alle Data-Lake-Nutzer ausreichend Performance haben, braucht es eine ausgeklügelte Analytics-IT-Architektur. Zu den wichtigen Prozessen in Bezug auf Data-Lake-Architektur zählen Datenerfassung, Data Streaming, Change Data Capture, Transformation, Datenvorbereitung und Katalogisierung. Meist umfassen Architekturen mehr als einen Data Lake – on-premises – in der Cloud oder in einer hybriden Umgebung. Dynamische Architekturen (wie etwa Lambda) ergänzen einen BatchProcessing Layer (meist MapReduce) mit einem »Speed Layer« (Apache Storm, Spark Streaming etc.), minimieren so Latenzen und bieten Echtzeiteinblicke. Kappa-Architekturen erfordern hingegen über die Hadoop-Infrastruktur hinaus Integration über mehrere Streaming-Tools und -Applikationen hinweg.

Damit Echtzeit-Analytics von Data Lakes unterstützt werden, müssen unterschiedliche Datentypen erkannt werden. Einige Daten brauchen vielleicht nur Batch- oder Micro-Batch-Verarbeitung, andere erfordern Stream Processing Tools oder Frameworks – etwa um Daten in Bewegung zu analysieren. Um die gesamte Palette zu unterstützen, muss das System so konzipiert sein, dass es je nach Bedarf Technologien wie Apache Kafka, Hortonworks DataFlow (HDF), Amazon Kinesis, Azure Event Hubs, MapR Streams usw. unterstützt. Die Anwendung von Technologien wie Hive auf Hadoop hilft, eine SQL-ähnliche Abfragesprache bereitzustellen, die von praktisch allen Analyse-Tools unterstützt wird. Im Idealfall könnte man sowohl einen operativen Datenspeicher (ODS) für traditionelle BI und Berichterstattung als auch einen umfassenden historischen Datenspeicher (HDS) für fortgeschrittene Analysen bereitstellen.

Data Lake Automation – der Integrationszauberer

Die Automatisierung der Data Lakes löst das Problem der vielen Datenformate und beschleunigt die – normalerweise sehr aufwändige – Bereitstellung der Daten. Durch die Automatisierung der Dateneingabe, die Erstellung von Schemata und kontinuierliche Aktualisierungen wird der ROI für Data Lakes erheblich schneller, der Zeit- und Personalaufwand sinkt. Dafür ist die Unterstützung von Streaming Change-Data-Capture wichtig: Dies ermöglicht eine inkrementelle Replikation – nur Datenupdates und Veränderungen in Datenstrukturen werden kopiert. Bewährt haben sich auch ein effizienter Eingabeprozess, die Vermeidung von Software-Agenten auf den Quellsystemen und ein zentralisiertes Aufgaben- und Quellenverwaltungssystem.

Ein Tool für die Automatisierung der Data-Lake-Pipeline muss alle wichtigen Quell- und Ziel-Plattformen sowohl on-premises als auch in der Cloud unterstützen. Das heißt, wenn sich die Architektur des Data Lake verändert, um neue Quellen aufzunehmen und auch die Häufigkeit der Updates sich ändert, sollten Data Architects dies mit einem Tool und einem Prozess für alle Endpunkte umsetzen können. Automatisierungstools beschleunigen auch die Datenreplikation, den Daten-Ingest und das Daten-Streaming über eine Vielzahl heterogener Datenbanken, Data Warehouses, Data Marts und Big-Data-Plattformen. Gut, wenn in einer einzigen Umgebung der Prozess der Erstellung und des kontinuierlichen Ladens von SQL-basierten betrieblichen und historischen Datenspeichern für die Nutzung durch Apache Hive automatisiert ist. Speziallösungen helfen, Daten aus Mainframe-, SAP-, Cloud- und anderen komplexen Umgebungen zu integrieren.

Die Automatisierungs-Tools bieten viele Datenperspektiven: Unterschiedliche Versionen eines Datensets (etwa alle Versionen eines Fertigungsauftrags), einen zeitlichen Snapshot (den Stand des Auftrags zu einem bestimmten Zeitpunkt) oder aber lediglich die aktuelle Variante.

Fazit: Um Automatisierung führt kein Weg herum

Data Lakes oder Data Warehouses – die Diskussion, welche Lösung für welchen Bedarf besser ist, wird sicher noch einige Zeit anhalten. Beide Varianten haben ihre Daseinsberechtigung und die Definitionen sind nicht vollständig gegeneinander abgegrenzt. Der Schritt in die Cloud kann die Relevanz dieser Entscheidung etwas abmildern, denn in der Cloud wird es einfacher, beide Ansätze miteinander zu verbinden und von ihren Vorteilen zu profitieren.

Doch egal welchen Ansatz man für sein Unternehmen wählt: Ohne eine Automatisierung wird man auf lange Sicht nicht konkurrenzfähig bleiben. Wenn Unternehmen über Unmengen von Datenquellen verfügen, wirkt sich das auf die Implementierungszeit, die Entwicklungsressourcen, die Aufnahmemuster (wie vollständige Datensätze gegenüber inkrementellen Updates), die IT-Umgebung, die Wartbarkeit, den Betrieb, die Verwaltung, die Steuerung und Kontrolle aus. Nur mit Automatisierung kann man mühsame Datenaufbereitung und komplexe ETL-Prozesse beschleunigen und flexibilisieren, hohe Leistung und analytische Fähigkeiten maximal nutzen.

42 Artikel zu „Data Lake Warehouse“

BUSINESS INTELLIGENCE | TOP-THEMA | AUSGABE 3-4-2015

Data Lake statt Data Warehouse – Im Zuhause für Big Data erfolgreich fischen

Daten, so war auf der CeBIT immer mal wieder zu hören, seien doch ein recht dröges Thema. Big Data hingegen, das sei eine spannende Sache. Nicht zuletzt wegen seiner engen Verbindung mit dem Internet der Dinge. Also eine wichtige Zukunftstechnologie. Tatsächlich geht es aber auch bei Big Data um nichts anderes als das Zusammenführen von strukturierten und unstrukturierten Daten beispielsweise aus dem Internet of Things oder Social Media.

NEWS | VERANSTALTUNGEN

Save the date: InfoZoom Data Quality Management Online-Konferenz im November

Die humanIT Software GmbH führt ihre jährliche InfoZoom-Kundenveranstaltung am 4. November 2020 als Online-Event durch. Die Teilnehmer erhalten in der DQM-Online-Konferenz einen Überblick über aktuelle Strategien für ein zukunftssicheres und nachhaltiges Data Quality Management. Praxisbeispiele steuern unter anderem die Anwender von Vodafone und dem LKA Rheinland-Pfalz bei. Interessenten können sich ab sofort kostenfrei anmelden unter…

NEWS | BUSINESS PROCESS MANAGEMENT | FAVORITEN DER REDAKTION | GESCHÄFTSPROZESSE | ONLINE-ARTIKEL

Datenstrategien für Big Data – Automatisierung des Data Warehouse muss Teil der Lösung sein

Im Zeitalter von Big Data könnte man davon ausgehen, dass man gar nicht genug Daten haben kann. Denn aus Daten lassen sich in der Theorie wichtige Erkenntnisse ziehen, die Unternehmen zu ihrem Vorteil nutzen können. Und so sammeln Unternehmen seit Jahren fleißig Daten aus immer mehr Quellen ein – und stehen damit auch vor der…

NEWS | DIGITALISIERUNG | SERVICES | STRATEGIEN

Open-Data-Initiative: Mit Datenkooperationen gegen die »Daten-Kluft«

Durch die Nutzung und den Austausch öffentlich zugänglicher Daten können fundierte Entscheidungen getroffen und sogar einige der weltweit drängendsten sozialen Herausforderungen besser bewältigt werden. So heißt es in der neuen Datenstrategie der Bundesregierung, »Daten sind eine Schlüsselressource«, etwa für die Verbesserung der Gesundheitsversorgung. Die Fähigkeit Daten verantwortungsvoll und selbstbestimmt zu nutzen, zu verknüpfen und auszuwerten,…

NEWS | BUSINESS INTELLIGENCE | DIGITALISIERUNG | FAVORITEN DER REDAKTION | TIPPS | WHITEPAPER

Data Preparation: In 4 Schritten zum Data-Science-Projekt

Die richtige Data Preparation erhöht die Vorhersagequalität von Datenmodellen und steigert die Wirksamkeit von Machine Learning-Zyklen. Die meisten Daten sind ohne eine vorher durchgeführte Data Preparation für KI-gestützte Prognosen ungeeignet: ihre Qualität ist unzureichend, sie liegen nicht in numerischer Form vor, oder es fehlen Werte. Diese Handlungsempfehlungen unterstützen bei der Datenvorbereitung und helfen, den…

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | SERVICES | TIPPS | WHITEPAPER

Wie gelangt man zu einem effektiven Data Lake?

Die schnelle Entscheidungsfindung auf Basis digitaler Daten verändert die Art und Weise, wie Unternehmen und IT arbeiten. Da Unternehmen auf alle Arten von Informationen zugreifen wollen, haben sie einen Bedarf an Infrastrukturexperten erkannt, die ihnen helfen, aus ihren Daten neue Werte zu erschließen. Rubrik, Anbieter einer Plattform für Multi-Cloud Data-Control, erläutert jüngste Entwicklungen in diesem…

NEWS | EFFIZIENZ | LÖSUNGEN | SERVICES | AUSGABE 11-12-2019

Data Quality: HELM AG modernisiert und zentralisiert Datenhaltung

Dezentral organisierte Unternehmen tun sich oft schwer, Informations- und Datenprozesse schlank, einheitlich und transparent zu organisieren. Die Digitalisierung verstärkt den Erneuerungsdruck. Die global tätige HELM AG hat es mit Hilfe einer Data-Quality-Lösung geschafft, ihre vertrieblichen und kaufmännischen Arbeitsabläufe zu optimieren. Die Software sorgt dafür, dass die neu erstellte zentrale Stammdatenbasis von Dubletten und Inkonsistenzen befreit wird und im Tagesgeschäft dauerhaft »sauber« bleibt.

NEWS | TRENDS 2020 | BUSINESS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | DIGITALISIERUNG | TRENDS SERVICES | FAVORITEN DER REDAKTION | KÜNSTLICHE INTELLIGENZ

Analytics reicht nicht mehr aus: Top-Trends im Big-Data-Umfeld 2020

Wide Data, DataOps, Metadaten-Kataloge, Datenkompetenz und Shazamen sind die wichtigsten Trends im kommenden Jahr. Für 2020 hat der Data-Analyst-Spezialist Qlik folgende fünf Trends im Zusammenhang mit Big Data und Analytics identifiziert: Aus Big Data wird Wide Data Dank skalierbarer Cloud-Lösungen sind in Big-Data-Umgebungen nicht länger die Kapazitätslimits unternehmensinterner IT-Infrastrukturen ein begrenzender Faktor. Die Herausforderung…

NEWS | TRENDS 2020 | BUSINESS INTELLIGENCE

Die Trends für Business Intelligence & Big Data 2020

Welche Trends für Business Intelligence (BI), Data & Analytics werden das Jahr 2020 prägen? Im Interview gibt BARC-Chef-Analyst Dr. Carsten Bange seine Prognosen ab. Außerdem stellt er exklusiv die Ergebnisse des BARC BI Trend Monitor 2020 vor, der 2.650 Anwender von BI-Technologie zu ihren persönlichen Trendthemen befragt hat. Dr. Carsten Bange, Gründer und Geschäftsführer von…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | ONLINE-ARTIKEL | STRATEGIEN

Big Data: Wo die wilden Daten leben

Data Lakes, Data Marts, Data Vaults und Data Warehouses. Worin unterscheiden sich die verschiedenen Ansätze der Dateninfrastruktur? Big Data oder Data Analytics sind einige der größten Herausforderungen für die IT unserer Zeit. Viele Unternehmen befinden sich inmitten einer Umstellung auf eine datengesteuerte Ausrichtung ihrer Organisation und sind auf der Suche nach der dazu passenden Dateninfrastruktur.…

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN

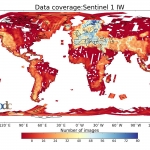

Klimawandel und Big Data: Ein Speichersystem ohne Grenzen für die Erdbeobachtung

Was hat sich durch den Klimawandel auf der Welt verändert? Was bedeutet das für die Menschen? Welche Maßnahmen sind wichtig, um den Klimawandel zu stoppen – oder um zumindest seine Folgen zu bewältigen? Diese Fragen stehen nicht erst seit Greta Thunberg im Fokus des öffentlichen Interesses und werden auch in Zukunft eine zentrale Rolle spielen.…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

Das Potenzial von Machine Learning in einem Data Lake

Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem…

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Vorsprung durch Wissen – Die Ära von Big Data kommt noch

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | INFRASTRUKTUR | OUTSOURCING | ONLINE-ARTIKEL | SERVICES

6 Gründe für ein Cloud-basiertes Data Warehouse

Ein Data Warehouse, das Daten aus verschiedenen Quellen zusammenfasst, um sie analysieren und darauf reagieren zu können, ist heute entscheidend für den Geschäftserfolg. Denn es verarbeitet schnell die enormen Datenmengen, die sich heute in Unternehmen ansammeln. Darauf basierend können Führungskräfte zuverlässige datenbasierte Entscheidungen treffen. Allerdings halten es fast zwei Drittel der kürzlich befragten Experten für…

NEWS | DIGITALISIERUNG | FAVORITEN DER REDAKTION | LÖSUNGEN | ONLINE-ARTIKEL

Wie Automatisierung des Data Warehouse den Wert der Unternehmensdaten erhöhen kann

Volume, Velocity, Variety, Veracity. Im englischen IT-Sprachgebrauch haben sich die vier Vs der Datenspeicherung längst etabliert. Volumen, Geschwindigkeit, Vielfalt und Wahrhaftigkeit gilt es in Einklang zu bringen, um die Daten eines Unternehmens erfolgreich verwalten zu können. Herkömmliche Data-Warehouse-Infrastrukturen sind häufig nicht mehr in der Lage, die enormen Datenmengen, die Vielfalt der Datentypen, die Geschwindigkeit mit…

NEWS | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | DIGITALE TRANSFORMATION | TRENDS SERVICES | TRENDS 2019 | OUTSOURCING

Ertragsoptimierung bei Cloud-Data-Warehouse-Investitionen

Immer mehr datengestützte IT-Systeme werden in die Cloud verlagert und dazu gehört auch das Data Warehouse. Neue Cloud-Data-Warehouse-Lösungen (CDW) sollen noch umfassendere Datenfunktionen, eine bessere Leistung und mehr Flexibilität als herkömmliche lokale Datenbanken bieten. Laut einer neuen Umfrage des TDWI (The Data Warehousing Institute) im Auftrag von Talend bieten neue Cloud-Data-Warehouse-Lösungen (CDW) noch umfassendere…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | INFRASTRUKTUR | ONLINE-ARTIKEL | RECHENZENTRUM

Health-Check: Wie fit ist Ihr Data Warehouse?

In vielen Unternehmen ist das Data Warehouse in die Jahre gekommen. Gleichzeitig wachsen die Anforderungen der Fachabteilungen. Mit IoT und der Digitalisierung kommen zudem neue Herausforderungen hinzu. Ist Ihr Data Warehouse all dem noch gewachsen? Machen Sie den Health-Check. Das Data Warehouse (DWH) bildet das Fundament für Business Intelligence und Data-Analytics-Plattformen. Es dient als zentraler…

NEWS | BUSINESS INTELLIGENCE | CLOUD COMPUTING | DIGITALISIERUNG | ONLINE-ARTIKEL | RECHENZENTRUM | TIPPS

Data- & Analytics-Trends 2018: Flexibel Daten analysieren und integrieren

Business Intelligence, Big Data, IoT und künstliche Intelligenz haben eins gemeinsam: Sie alle drehen sich um Daten und ihre Auswertung. Um bestmöglich von den neuen Technologien zu profitieren, benötigen Unternehmen geeignete Datenplattformen und Analytics-Lösungen. Hier kommen fünf aktuelle Trends, die zeigen, worauf es ankommt. Die Fähigkeit, Daten zu sammeln und auszuwerten, ist heute essenziell für…

NEWS | BUSINESS | BUSINESS INTELLIGENCE | TRENDS INFRASTRUKTUR | BUSINESS PROCESS MANAGEMENT | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | DIGITALISIERUNG | GESCHÄFTSPROZESSE | INFRASTRUKTUR | TRENDS 2018 | INTERNET DER DINGE | LÖSUNGEN | STRATEGIEN

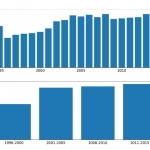

Data-Warehouse-Landschaft 2018: Automatisierung wird entscheidend für Kunden sein

»In der Vergangenheit bauten Entwicklerteams Data Warehouses manuell, und Führungskräfte fokussierten sich nicht primär auf die Effizienz dieses Vorgangs. Doch mittlerweile erkennen sie, dass ein Großteil hiervon automatisiert werden kann, um die Bereitstellung von Entscheidungsdaten, die sie täglich benötigen, zu beschleunigen. Bereits 2017 haben Führungskräfte begonnen, das »Wie« der Daten in Frage zu stellen, und…

NEWS | BUSINESS INTELLIGENCE | CLOUD COMPUTING | TRENDS SERVICES | TRENDS 2017 | SERVICES

Big Data: Analytics as a Service

In der aktuellen Studie »Experton Big Data Vendor Benchmark 2017« wurde die Anbieterlandschaft für Big-Data-Lösungen und -Services in sieben Kategorien untersucht. Eine Kategorie betrachtet die Angebote, bei denen Analytics-Umgebungen im Rahmen von Service-Modellen im Mittelpunkt stehen. Viele Anwenderunternehmen sind mittlerweile mit dem Unterschied zwischen dem unkontrollierten Sammeln von Daten, der Installation einer Hadoop-Distribution, der Verarbeitung…