Wide Data, DataOps, Metadaten-Kataloge, Datenkompetenz und Shazamen sind die wichtigsten Trends im kommenden Jahr.

Für 2020 hat der Data-Analyst-Spezialist Qlik folgende fünf Trends im Zusammenhang mit Big Data und Analytics identifiziert:

- Aus Big Data wird Wide Data

Dank skalierbarer Cloud-Lösungen sind in Big-Data-Umgebungen nicht länger die Kapazitätslimits unternehmensinterner IT-Infrastrukturen ein begrenzender Faktor. Die Herausforderung der Stunde lautet »Wide Data«. Die Aufmerksamkeit wendet sich den fragmentierten, weitverzweigten Datenlandschaften zu, die durch uneinheitliche oder fehlerhaft formatierte Daten sowie für sich stehende Datensilos entstanden sind. Allein in den letzten fünf Jahren hat sich die Anzahl der Datenbanken, die es für unterschiedlichste Datenarten gibt, von 162 auf 342 verdoppelt. »Unternehmen, denen es künftig gelingt, diese Daten in einer Synthese sinnvoll zusammenzuführen, werden klar im Vorteil sein,« erläutert Wolfgang Kobek, Senior Vice President EMEA bei Qlik.

- DataOps & Self Service Analytics: mehr Agilität für die Datennutzung

Während Data Analytics auf der Business-Ebene durch moderne BI-Technologie und Self-Service-Tools längst Einzug gehalten hat, fehlt es für das Datenmanagement immer noch an agilen Möglichkeiten. Die Lösung heißt: »DataOps«. Dieser Ansatz macht es möglich, mit automatisierten und prozessorientierten Technologien die Geschwindigkeit und Qualität des Datenmanagements zu erhöhen. Dafür werden On-Demand IT-Ressourcen genutzt, Tests automatisiert und Daten bereitgestellt. Technologien wie Echtzeit-Datenintegration, Change Data Capture (CDC) und Streaming Data Pipelines sind die Basis dafür. Dank DataOps können 80 Prozent der Kerndaten systematisch an Geschäftsanwender geliefert werden. Kobek: »Mit DataOps im operativen Datenmanagement und Self-Service Analytics auf der Business-Seite lässt sich ein fließender Prozess über die gesamte Informationswertschöpfungskette erreichen. Synthese und Analyse greifen ineinander.«

- Intelligente Metadaten-Kataloge: Bindeglied zwischen Datenbasis und Data Analytics

Die Nachfrage nach Datenkatalogen steigt, um Rohdaten in den verteilten und vielfältigen Datenbeständen zu lokalisieren, zu erfassen und zu synthetisieren. Im kommenden Jahr werden die Metadatenkataloge zunehmend mit KI ausgestattet werden, um eine aktive, adaptive und schnelle Datenbereitstellung zu ermöglichen. Dies ist die Voraussetzung für die Agilität, die durch den Einsatz von DataOps und Self-Service-Analytik ermöglicht wird.

- Aufbau von Datenkompetenz als Service-Leistung

Durch die Verknüpfung von Datensynthese und Datenanalyse lässt sich die Nutzung von Daten weiter vorantreiben. »Allerdings,« so Kobek, »werden noch so gute Technologien oder Prozesse nichts bringen, wenn die Menschen nicht mit an Bord sind. Es reicht nicht aus, den Anwendern die Tools einfach nur zur Verfügung zu stellen und auf das Beste zu hoffen. Erfolgsentscheidend wird sein, den Mitarbeitern dabei zu helfen, sich mit dem Lesen, Arbeiten, Analysieren und Kommunizieren von Daten vertraut zu machen.« Viele Unternehmen möchten im kommenden Jahr die Datenkenntnisse ihrer Mitarbeiter fördern und suchen dafür gezielt nach Partnern, die Software, Training sowie Support im SaaS-Modell (Software as a Serivce) anbieten. Das Ziel: Das Daten-Know-how so zu verbessern, dass DataOps und Self-Service Analytics ineinandergreifen können und sich datengestütztes Entscheiden bei den Mitarbeitern im Alltag durchsetzen kann.

- Shazamen von Daten

Die Fortschritte im Bereich Data-Analytics waren in den letzten Jahrzehnten enorm. Allerdings sehen Experten den größten Meilenstein noch kommen: Das »Shazamen« von Daten. Die meisten von uns kennen Shazam, die berühmte App, die laufende Songs identifizieren und Informationen dazu bereit stellen kann. Dieses Konzept wird derzeit auf zahlreiche Bereiche ausgedehnt. »2020 werden wir ›Shazamen‹ auch für Daten im Unternehmen erleben«, ist sich Kobek sicher. »Es wird möglich sein, das Umfeld von Daten näher in Augenschein zu nehmen: Woher stammen sie, wer hat sie verwendet, welche Qualität haben sie und wie haben sie sich kürzlich verändert?« Algorithmen werden den Analysesystemen helfen, Datenmuster zu erkennen, Anomalien nachzuvollziehen und neue Daten für weitere Analysen vorzuschlagen. Dadurch wird Data und Analytics schlanker werden und wir können zur richtigen Zeit mit den richtigen Daten arbeiten.«

»Eines steht fest: Der Umgang mit Daten wird in Zukunft weit über Suche, Dashboards und Visualisierung hinausgehen. Wir werden in der Lage sein, über alternative Eingabetechniken mit digitalen Geräten zu kommunizieren wie etwa über Gedanken, Bewegungen oder auch auf sensorischer Ebene. Der Kauf von CTRL Labs, dem Start-up für Neuroschnittstellen, durch Facebook oder auch das Neuralink-Projekt von Elon Musk, das an der Mensch-Maschine-Interaktion arbeitet, sind erste Vorboten, was kommen wird. Im Jahr 2020 werden einige dieser bahnbrechenden Innovationen anfangen, unsere Erfahrung im Umgang mit Daten zu verändern. Darin liegen enorme Chancen für uns alle, es birgt aber die Gefahr von Missbrauch. Hier ist Verantwortungsbewusstsein gefragt,« resümiert Kobek. »Eine ganzheitliche Betrachtung von Datenkompetenz und Ethik ist nötig, damit Menschen im Umgang mit Wide Data die richtigen Entscheidungen treffen können. DataOps und Self-Service sind die Trends, die dabei helfen, unternehmensweit verstreute Daten richtig zu nutzen, um im digitalen Zeitalter auch weiterhin erfolgreich zu sein.«

1749 Artikel zu „big data“

NEWS | BUSINESS INTELLIGENCE | TRENDS 2020

Die Trends für Business Intelligence & Big Data 2020

Welche Trends für Business Intelligence (BI), Data & Analytics werden das Jahr 2020 prägen? Im Interview gibt BARC-Chef-Analyst Dr. Carsten Bange seine Prognosen ab. Außerdem stellt er exklusiv die Ergebnisse des BARC BI Trend Monitor 2020 vor, der 2.650 Anwender von BI-Technologie zu ihren persönlichen Trendthemen befragt hat. Dr. Carsten Bange, Gründer und Geschäftsführer von…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | ONLINE-ARTIKEL | STRATEGIEN

Big Data: Wo die wilden Daten leben

Data Lakes, Data Marts, Data Vaults und Data Warehouses. Worin unterscheiden sich die verschiedenen Ansätze der Dateninfrastruktur? Big Data oder Data Analytics sind einige der größten Herausforderungen für die IT unserer Zeit. Viele Unternehmen befinden sich inmitten einer Umstellung auf eine datengesteuerte Ausrichtung ihrer Organisation und sind auf der Suche nach der dazu passenden Dateninfrastruktur.…

AUSGABE 9-10-2019 | NEWS | BUSINESS PROCESS MANAGEMENT | LÖSUNGEN | SERVICES

Von Big Data zu Smart Data – Öl des 21. Jahrhunderts

Wie Lobster aus einer unstrukturierten Datenvielfalt Informationen und Wissen generiert.

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN

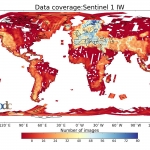

Klimawandel und Big Data: Ein Speichersystem ohne Grenzen für die Erdbeobachtung

Was hat sich durch den Klimawandel auf der Welt verändert? Was bedeutet das für die Menschen? Welche Maßnahmen sind wichtig, um den Klimawandel zu stoppen – oder um zumindest seine Folgen zu bewältigen? Diese Fragen stehen nicht erst seit Greta Thunberg im Fokus des öffentlichen Interesses und werden auch in Zukunft eine zentrale Rolle spielen.…

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Big Data im Alltag – Wie die Analyse großer Datenmengen unser aller Leben beeinflusst

Internetrecherche, Online-Shopping, Online-Verträge, Navi- und Gesundheits-Apps benötigen immense Mengen an Daten, um valide Ergebnisse zu liefern. Nahezu jeder Bereich des täglichen Lebens kann in Zukunft durch Big Data beeinflusst werden.

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Vorsprung durch Wissen – Die Ära von Big Data kommt noch

In zehn Jahren wird man über das was wir heute unter Big Data verstehen nur müde lächeln. Die Datenmengen werden durch das »Allesnetz« in einem unvorstellbaren Ausmaß wachsen. Es gilt den Herausforderungen schon heute zu begegnen.

NEWS | SERVICES | STRATEGIEN | AUSGABE 3-4-2019

Neue datengetriebene Industrie-Services – Von Big Data zu Smart Data zu Smart Services

Datenbasierte Mehrwertdienstleistungen benötigen eine tragfähige Umsetzungsstrategie, um durch die Nutzung veredelter Daten nachhaltig Werte generieren zu können. Es gilt die innerhalb der Prozesskette beteiligten Systeme so zu integrieren, dass diese automatisch miteinander kommunizieren können.

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | LÖSUNGEN | ONLINE-ARTIKEL | RECHENZENTRUM | SERVICES

Die Entwicklung von Big Data zu Fast Data

Das »Warum« der Datenverarbeitung liegt auf der Hand, wenn man die große Anzahl von Sensoren, vernetzten Geräten, Websites oder mobilen Anwendungen betrachtet; oder einfach alle Daten, die sowohl von Menschen als auch von Maschinen erzeugt werden. Die immensen, rasch ansteigenden Datenberge erfordern kontinuierlich leistungsfähigere Ansätze zur Datenverarbeitung. Open Source spielt dabei nach Meinung der data…

NEWS | CLOUD COMPUTING | DIGITALISIERUNG | INFOGRAFIKEN | KÜNSTLICHE INTELLIGENZ | LÖSUNGEN | SERVICES

Big Data killed the Radio Star? Wie künstliche Intelligenz die Musikindustrie beeinflusst

Schon immer war die Musikindustrie eine, die sich konstant weiterentwickelt und an die Gegebenheiten der Welt angepasst hat. Mittlerweile hat mit Streaming, Cloud Computing und Algorithmen eine neue Ära dieser begonnen. Künstliche Intelligenz hat nicht nur die Prozesse in der Branche revolutioniert, sondern hilft uns auch dabei, Musik auf eine neue Art und Weise wahrzunehmen…

TRENDS 2019 | NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | EFFIZIENZ | GESCHÄFTSPROZESSE | INFRASTRUKTUR | KÜNSTLICHE INTELLIGENZ | STRATEGIEN

Trends für 2019 – Stream Processing als Ansatz für Big Data und komplexes Datamanagement

Um vorherzusehen, dass die schiere Masse an Daten auch im kommenden Jahr neue Rekordwerte erklimmen wird, muss man kein Experte sein. Um dieser Entwicklung Herr zu werden und die entstehenden Datenmassen effizient zu nutzen, sind jedoch Experten und neue Technologien gefragt. Ein erfolgsversprechender Ansatz ist dabei Stream Processing. Stream Processing, also Datenstromverarbeitung, ist…

TRENDS 2019 | NEWS | TRENDS INFRASTRUKTUR | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | RECHENZENTRUM | SERVICES

Big Data – nutzlos oder ungenutzt? Verschiebung von kalten zu heißen Daten

Seit vielen Jahren geistert Big Data als Schlagwort durch die Industrie und die Medien. In jüngster Zeit wird dabei immer lauter die Frage gestellt, ob denn Big Data in der Praxis über das reine Anhäufen großer Datenmengen hinausgeht. »Bis 2020 wird jeder Mensch 1,7 MB Daten pro Sekunde erzeugen. Darüber hinaus wird Big Data bald…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALE TRANSFORMATION | INDUSTRIE 4.0 | PRODUKTMELDUNG | VERANSTALTUNGEN

Startklar für Industrie 4.0 und Big Data: Maschinendaten in wenigen Tagen digitalisieren

Endian auf der SPS IPC Drives – Stand 6-150T PM│Endian PoC-Kit – startklar für Industrie 4.0 und Big Data: Maschinendaten in wenigen Tagen digitalisieren Endian bietet ein Proof-of-Concept (PoC)-Kit, um Maschinendaten zu extrahieren und zu visualisieren. Damit können Unternehmen auf Basis ihrer eigenen Daten entscheiden, wie sie Big-Data-Modelle zukünftig für sich nutzen wollen. Endian präsentiert…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALE TRANSFORMATION | GESCHÄFTSPROZESSE | STRATEGIEN | AUSGABE 9-10-2018

Digitalisierung von Geschäftsprozessen – Wenn aus »Big Data« »Smart Data« wird

INFORM ist spezialisiert auf intelligente Software zur optimierten Planung und Echtzeit-Disposition von Geschäftsprozessen. Integriert in die bestehende IT-Umgebung optimieren diese Systeme den Erfolg vieler Planungen, Betriebsprozesse und Dispositionsentscheidungen in Bezug auf Produktivität und Zuverlässigkeit. Wir sprachen mit Jens Siebertz, stellvertretender Leiter des Geschäftsbereichs Produktion bei INFORM.

TRENDS WIRTSCHAFT | NEWS | BUSINESS | BUSINESS INTELLIGENCE | TRENDS KOMMUNIKATION | DIGITALISIERUNG | TRENDS GESCHÄFTSPROZESSE | TRENDS SERVICES | EFFIZIENZ | FAVORITEN DER REDAKTION | TRENDS 2018 | INFOGRAFIKEN | INTERNET DER DINGE | KOMMUNIKATION | KÜNSTLICHE INTELLIGENZ | SERVICES | STRATEGIEN

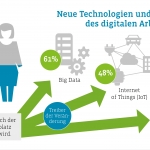

IoT, Big Data und KI erobern den Arbeitsplatz

Trendtechnologien verändern die industrielle Produktion und den Service. Doch auch innerhalb der Unternehmen findet ein Umbruch statt: Neue Technologien und digitale Formen der Kommunikation und Zusammenarbeit lösen analoge erstmals ab. Das zeigt die Deutsche Social Collaboration Studie 2018 [1]. Bereits jetzt setzt über ein Drittel der deutschen Unternehmen Big Data/Data Analytics am Arbeitsplatz ein.…

TRENDS WIRTSCHAFT | NEWS | BLOCKCHAIN | TRENDS CLOUD COMPUTING | BUSINESS INTELLIGENCE | DIGITALISIERUNG | DIGITALE TRANSFORMATION | EFFIZIENZ | TRENDS 2018 | INTERNET DER DINGE | KÜNSTLICHE INTELLIGENZ | STRATEGIEN

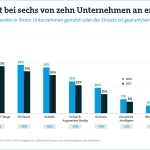

Big Data steht bei sechs von zehn Unternehmen an erster Stelle

■ 57 Prozent planen Investitionen in Big Data oder sind bereits in der Umsetzung. ■ Manager: Internet of Things, Big Data und Robotik haben große Bedeutung für Wettbewerbsfähigkeit deutscher Unternehmen. ■ Aber: Künstliche Intelligenz und Blockchain werden bislang nur selten genutzt. Von Internet of Things über künstliche Intelligenz bis Blockchain: Neue digitale Technologien sind…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | GESCHÄFTSPROZESSE | KOMMENTAR | RECHENZENTRUM | SERVICES

Big Data: Spiegel der Praxis – einfach machen, ganz einfach

Die oftmals propagierten Big-Data- und Analytics-Use-Cases klingen fantastisch und nach dem großen Geld – beim machbaren Profit wie auch beim Investitionsvolumen. Nicht immer sehen diese Use Cases realistisch aus. Einen sehr stark praxisbezogenen und realitätsnahen Blick auf die Thematik lieferte der, vom IT-Branchenverband Bitkom inzwischen um einen Tag erweiterte, Big-Data- und AI-Summit, der Ende Februar…

NEWS | BUSINESS | DIGITALISIERUNG | TRENDS GESCHÄFTSPROZESSE | TRENDS SERVICES | KOMMUNIKATION | OUTSOURCING | SERVICES

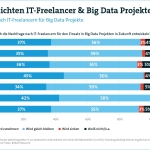

Big Data treibt Nachfrage nach IT-Freelancern – EU-DSGVO erleichtert Projekte

■ Vier von zehn Großunternehmen rechnen mit steigender Nachfrage nach IT-Freelancern für Big-Data-Projekte. ■ Mehrheit geht von positiven Impulsen der EU-DSGVO für Big Data aus. ■ Freiberufler leisten ein Viertel des Arbeitsvolumens in IT-Projekten. Big Data ist in Zeiten des digitalen Wandels ein absolutes Trendthema und steigert den Bedarf an IT-Freelancern. Damit rechnen vier…