Data Lakes, Data Marts, Data Vaults und Data Warehouses. Worin unterscheiden sich die verschiedenen Ansätze der Dateninfrastruktur?

Big Data oder Data Analytics sind einige der größten Herausforderungen für die IT unserer Zeit. Viele Unternehmen befinden sich inmitten einer Umstellung auf eine datengesteuerte Ausrichtung ihrer Organisation und sind auf der Suche nach der dazu passenden Dateninfrastruktur. Verschiedene Ansätze versprechen Vorteile – doch vielerorts hakt es schon beim Verstehen der Begrifflichkeit. Wer weiß schon im Detail, wo der Unterschied zwischen Data Lake, Data Vault und Data Mart liegt? Oder wie genau ein Data Lake und das Data Warehouse zusammenarbeiten?

Generell versuchen alle Ansätze für die Dateninfrastruktur Wege zu finden, effektiv Erkenntnisse aus Daten zu generieren. Um den besten Ansatz für ein Unternehmen in Bezug auf die Dateninfrastruktur zu finden, lohnt es sich, die Optionen und ihre Vorteile genau zu kennen. Was also sind Data Lake, Data Vault, Data Mart und Data Warehouses und wofür werden Sie verwendet?

- Data Lake – Eine große Sammlung von Rohdaten

Data Lakes sind riesige Datensammlungen, die von nicht organisierten oder verarbeiteten Rohdaten bis hin zu unterschiedlichen Ebenen von kurierten Datensätzen reichen. Einer der Vorteile, Daten in einem Data Lake zu speichern, besteht darin, dass unterschiedliche Nutzer auf die für sie geeigneten Daten zugreifen können. Dies macht einen Data Lake perfekt für einige der neueren Anwendungen von Daten wie Data Science, künstliche Intelligenz und Machine Learning.

Data Lakes bieten eine sehr gute Möglichkeit, Massen von Rohdaten auf skalierbaren Speicherlösungen abzulegen, ohne den Versuch zu unternehmen, traditionelles ETL (Extraktion/Transformation/Laden) oder ELT (Extraktion/Laden/Transformation) zu verwenden, die bei diesem Volumen teuer sein können. Für traditionellere Analysen strukturierter Daten kann ein Data Lake jedoch auch etwas unhandlich und verwirrend sein, weshalb viele Unternehmen hierfür andere Lösungen nutzen. In der Hierarchie einer komplexen, mehrschichtigen Dateninfrastruktur werden Data Lakes eher als erste Ebene und Grundlage für einen strukturierteren Ansatz der Datenverarbeitung genutzt, etwa beim Data Warehouse.

- Das Data Warehouse: benutzerfreundlicher Zugang zu Daten

Das Data Warehouse dient als Quelle für Ableitungen aus den Rohdaten und ist für viele Unternehmen heute ein Kernelement ihrer Datenstrategie. Im Gegensatz zum Data Lake, der einfach nur ein großer Pool an Daten ist, ist ein Data Warehouse, oder ein Enterprise Data Warehouse, wie es manchmal genannt wird, ein kurierter Datenspeicher für aktuelle und historische Daten. Ein Data Warehouse ermöglicht Anwendern den Zugang zu den richtigen Informationen in einem benutzerfreundlichen Format, wie etwa monatlichen Reports. Wenn Daten in eine Data-Warehouse-Umgebung gelangen, werden sie bereinigt, transformiert, kategorisiert und gekennzeichnet, je nachdem wie die Nutzer dies benötigen. Dies erleichtert die Verwaltung, Nutzung und Überwachung der Unternehmensdaten. Auch die Automatisierung, ein heute wichtiger Teil der Dateninfrastruktur, kommt auf der Ebene des Data Warehouses ins Spiel.

Die Automatisierung von Datenprozessen ist für die meisten Unternehmen heute eine wichtige Anforderung an das Data Warehouse, da das Volumen und die Geschwindigkeit, mit der Daten generiert werden, die manuelle Verarbeitung in vielen Umgebungen praktisch unmöglich macht. Auch aus Sicht der Compliance bietet die Automatisierung der Datenprozesse in einem Data Warehouse viele Vorteile, genauso wie beim »Time to Value«, also der Zeit von der Entstehung der Daten bis zu deren wertschöpfenden Nutzung.

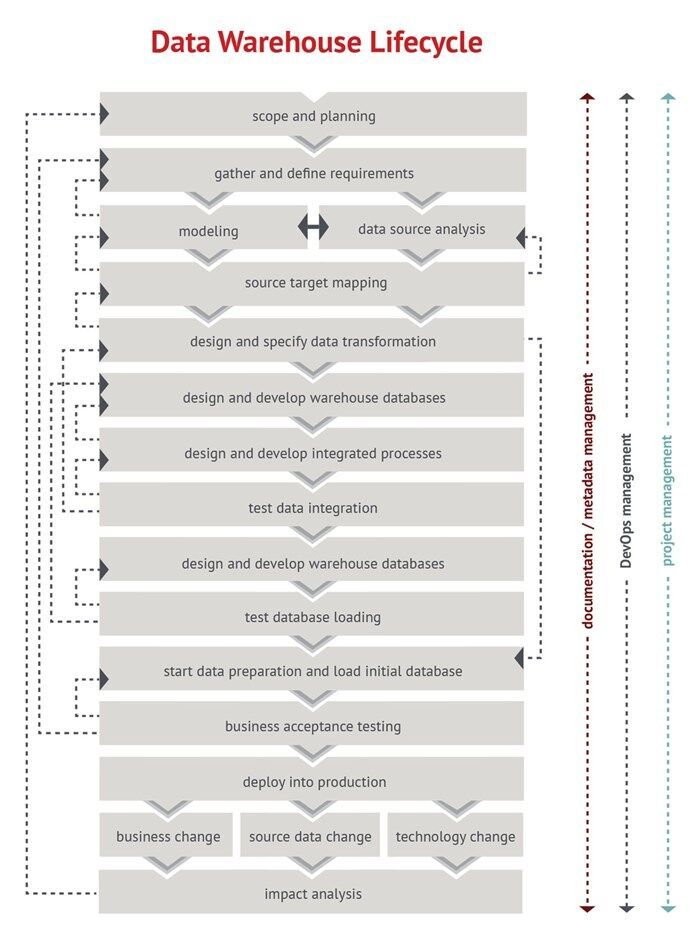

Abbildung 1: Die Data-Warehouse-Automatisierung hilft IT-Teams. Data-Warehouse-Automation-Software kombiniert die Verwendung von Metadaten, Data-Warehouse-Methoden, Mustererkennung und mehr, um Entwicklern zu helfen, Data-Warehouse-Designs und Codierung durch den Einsatz von Data-Warehouse-Design-Tools und zeitsparenden Entwicklungsassistenten und -vorlagen automatisch zu generieren. Insofern bietet Automatisierung viel mehr als bisher, indem sie viel schneller, mit weniger Projektrisiko und niedrigeren Kosten liefert und verwaltet. Zudem entfallen wiederholte Design-, Entwicklungs-, Bereitstellungs- und Betriebsaufgaben innerhalb des Data-Warehouse-Lebenszyklus.

Abbildung 1: Die Data-Warehouse-Automatisierung hilft IT-Teams. Data-Warehouse-Automation-Software kombiniert die Verwendung von Metadaten, Data-Warehouse-Methoden, Mustererkennung und mehr, um Entwicklern zu helfen, Data-Warehouse-Designs und Codierung durch den Einsatz von Data-Warehouse-Design-Tools und zeitsparenden Entwicklungsassistenten und -vorlagen automatisch zu generieren. Insofern bietet Automatisierung viel mehr als bisher, indem sie viel schneller, mit weniger Projektrisiko und niedrigeren Kosten liefert und verwaltet. Zudem entfallen wiederholte Design-, Entwicklungs-, Bereitstellungs- und Betriebsaufgaben innerhalb des Data-Warehouse-Lebenszyklus.

- Data Mart: eine kleinere Teilmenge eines Data Warehouses

Ein Data Mart ist eine spezifische Teilmenge eines Data Warehouse, die oft für kuratierte Daten zu einem bestimmten Themenbereich verwendet wird und die in kurzer Zeit leicht zugänglich sein müssen. Aufgrund seiner geringeren Größe und Komplexität ist ein Data Mart oft schneller und kostengünstiger zu bauen als ein komplettes Data Warehouse. Durch diese limitierte Größe kann ein Data Mart aber keine Daten aus dem gesamten Unternehmen erstellen und verwalten.

Abbildung 2: Data Marts: Durch die Automatisierung von Design, Entwicklung, Bereitstellung und Betrieb von Data Marts können Unternehmen schnell Business-Intelligence-Lösungen bereitstellen, ohne Qualität, Leistung, Agilität oder Governance einzubüßen.

- Data Vault: ein weiterentwickelter Ansatz für das Data Warehouse

Ein Data Vault ist ein spezieller Ansatz des Data Warehouses, der einige Herausforderungen des Data Warehouse löst, die bei der Verarbeitung von Daten innerhalb des Data Warehouses entstehen. Der Unterschied eines Data Vaults zu einem Data Warehouse besteht darin, dass Data Vaults bei der Verarbeitung keine Bewertung vornehmen, welche Daten »wertvoll« sind und welche nicht. In einem Data Warehouse wird eine solche Entscheidung typischerweise bei der Datenaufnahme getroffen. Dies bietet mehr Flexibilität, was bei der Verarbeitung von Daten aus sich ändernden Datenquellen hilft. Ein Data Vault kann somit einen ungefilterten Blick auf die Fakten liefern.

Für Unternehmen mit großen, wachsenden und vielen unterschiedlichen Datensätzen kann der Ansatz eines Data Vaults für ihr Data Warehouse dabei helfen, das Ungetüm großer Datenmengen zu einer verwaltbaren Lösung zu zähmen. Die Einrichtung eines Data Vaults kann jedoch sehr komplex und zeitaufwändig sein. Hier setzt die Automatisierung von Data Vaults an, die sich automatisch um einen Großteil der Dateninfrastruktur eines Unternehmens kümmern kann.

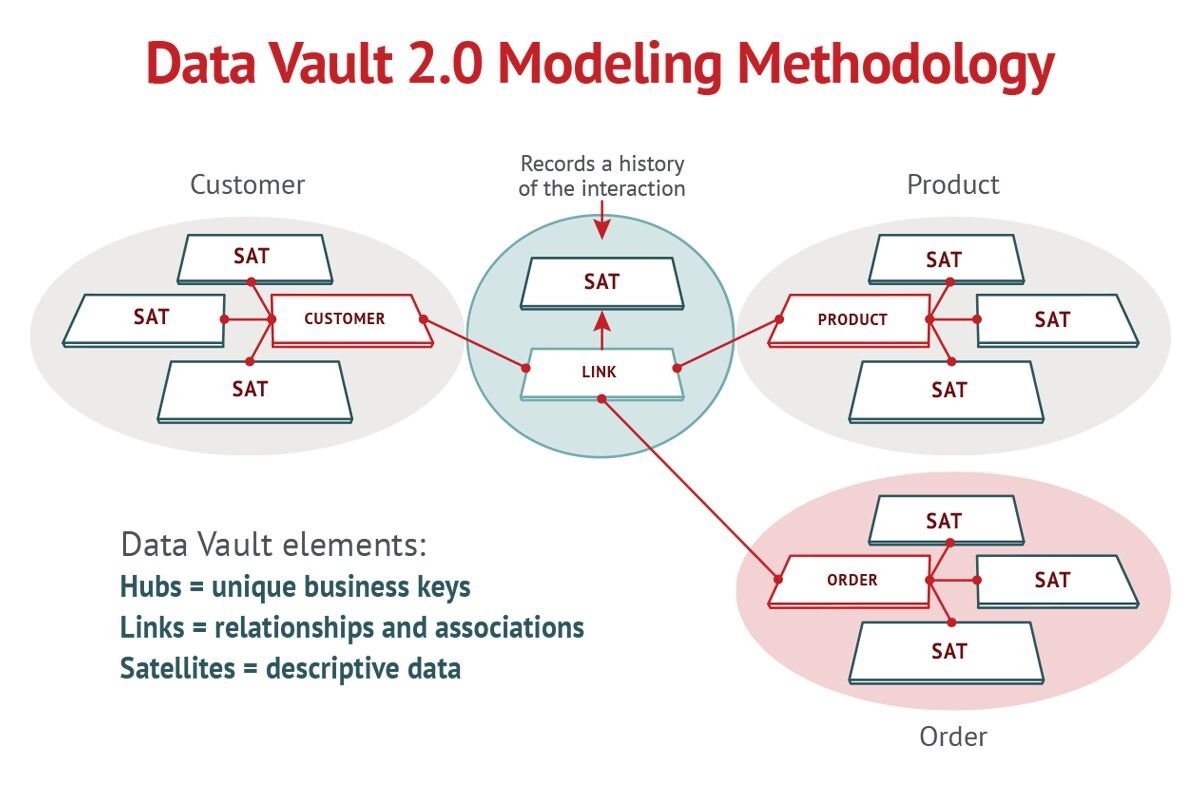

Um den strengen Anforderungen der Methodik zu entsprechen, ist die Automatisierung von Data Vaults eine wichtige Komponente. Damit die Automatisierung des Data Vaults einen hohen Prozentsatz der Dateninfrastruktur eines Unternehmens abdecken kann, werden heutzutage die standardisierten Vorlagen und die hohen Anforderungen der Data-Vault-2.0-Methodik genutzt. Diese Methodik stellt den Kern eines Data Vaults dar, der zuverlässige und konsistente Metadaten verwendet, um sicherzustellen, dass alle Informationen, einschließlich personenbezogener Daten jederzeit überwacht werden können.

Abbildung 3: Die Methode des Data Vault 2.0 Modellings ist ein hybrider Ansatz, der die besten Aspekte des Designs von Third Normal Form (3NF) und Sternschema kombiniert. Obwohl fertige Datenspeicher viele Vorteile bieten, erfordert das Entwerfen und Entwickeln von Hand viel Zeit, Aufwand und Geld. Die Automatisierung von Datentresoren hilft, schnell und risikoarm in die Produktion zu gelangen. Das IT-Team kann neue Lösungen liefern und bestehende so schnell ändern, wie das Unternehmen sie benötigt.

Zusammenfassung

Es gibt zahlreiche Ansätze für eine Dateninfrastruktur, die Unternehmen wählen können, um ihre Daten nicht nur sicher, sondern auch gewinnbringend zu speichern. In modernen Unternehmen kommt es heute vornehmlich darauf an, dass alles den schärferen Richtlinien entspricht und das Unternehmen gleichzeitig schnell Mehrwert aus den Daten schöpfen kann.

Ein umfassendes Verständnis dafür, wie verschiedene Ansätze zusammenpassen, kann für IT-Manager und Führungskräfte von unschätzbarem Wert sein.

Rob Mellor, Vice President und General Manager EMEA, WhereScape

Weitere Informationen zum Data Warehousing – Glossar: https://www.wherescape.com/resources/data-warehousing-faq/

1732 Artikel zu „Big Data“

AUSGABE 9-10-2019 | NEWS | BUSINESS PROCESS MANAGEMENT | LÖSUNGEN | SERVICES

Von Big Data zu Smart Data – Öl des 21. Jahrhunderts

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN

Klimawandel und Big Data: Ein Speichersystem ohne Grenzen für die Erdbeobachtung

Was hat sich durch den Klimawandel auf der Welt verändert? Was bedeutet das für die Menschen? Welche Maßnahmen sind wichtig, um den Klimawandel zu stoppen – oder um zumindest seine Folgen zu bewältigen? Diese Fragen stehen nicht erst seit Greta Thunberg im Fokus des öffentlichen Interesses und werden auch in Zukunft eine zentrale Rolle spielen.…

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Big Data im Alltag – Wie die Analyse großer Datenmengen unser aller Leben beeinflusst

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Vorsprung durch Wissen – Die Ära von Big Data kommt noch

NEWS | SERVICES | STRATEGIEN | AUSGABE 3-4-2019

Neue datengetriebene Industrie-Services – Von Big Data zu Smart Data zu Smart Services

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | LÖSUNGEN | ONLINE-ARTIKEL | RECHENZENTRUM | SERVICES

Die Entwicklung von Big Data zu Fast Data

Das »Warum« der Datenverarbeitung liegt auf der Hand, wenn man die große Anzahl von Sensoren, vernetzten Geräten, Websites oder mobilen Anwendungen betrachtet; oder einfach alle Daten, die sowohl von Menschen als auch von Maschinen erzeugt werden. Die immensen, rasch ansteigenden Datenberge erfordern kontinuierlich leistungsfähigere Ansätze zur Datenverarbeitung. Open Source spielt dabei nach Meinung der data…

NEWS | CLOUD COMPUTING | DIGITALISIERUNG | INFOGRAFIKEN | KÜNSTLICHE INTELLIGENZ | LÖSUNGEN | SERVICES

Big Data killed the Radio Star? Wie künstliche Intelligenz die Musikindustrie beeinflusst

Schon immer war die Musikindustrie eine, die sich konstant weiterentwickelt und an die Gegebenheiten der Welt angepasst hat. Mittlerweile hat mit Streaming, Cloud Computing und Algorithmen eine neue Ära dieser begonnen. Künstliche Intelligenz hat nicht nur die Prozesse in der Branche revolutioniert, sondern hilft uns auch dabei, Musik auf eine neue Art und Weise wahrzunehmen…

TRENDS 2019 | NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | EFFIZIENZ | GESCHÄFTSPROZESSE | INFRASTRUKTUR | KÜNSTLICHE INTELLIGENZ | STRATEGIEN

Trends für 2019 – Stream Processing als Ansatz für Big Data und komplexes Datamanagement

Um vorherzusehen, dass die schiere Masse an Daten auch im kommenden Jahr neue Rekordwerte erklimmen wird, muss man kein Experte sein. Um dieser Entwicklung Herr zu werden und die entstehenden Datenmassen effizient zu nutzen, sind jedoch Experten und neue Technologien gefragt. Ein erfolgsversprechender Ansatz ist dabei Stream Processing. Stream Processing, also Datenstromverarbeitung, ist…

TRENDS 2019 | NEWS | TRENDS INFRASTRUKTUR | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | RECHENZENTRUM | SERVICES

Big Data – nutzlos oder ungenutzt? Verschiebung von kalten zu heißen Daten

Seit vielen Jahren geistert Big Data als Schlagwort durch die Industrie und die Medien. In jüngster Zeit wird dabei immer lauter die Frage gestellt, ob denn Big Data in der Praxis über das reine Anhäufen großer Datenmengen hinausgeht. »Bis 2020 wird jeder Mensch 1,7 MB Daten pro Sekunde erzeugen. Darüber hinaus wird Big Data bald…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALE TRANSFORMATION | INDUSTRIE 4.0 | PRODUKTMELDUNG | VERANSTALTUNGEN

Startklar für Industrie 4.0 und Big Data: Maschinendaten in wenigen Tagen digitalisieren

Endian auf der SPS IPC Drives – Stand 6-150T PM│Endian PoC-Kit – startklar für Industrie 4.0 und Big Data: Maschinendaten in wenigen Tagen digitalisieren Endian bietet ein Proof-of-Concept (PoC)-Kit, um Maschinendaten zu extrahieren und zu visualisieren. Damit können Unternehmen auf Basis ihrer eigenen Daten entscheiden, wie sie Big-Data-Modelle zukünftig für sich nutzen wollen. Endian präsentiert…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALE TRANSFORMATION | GESCHÄFTSPROZESSE | STRATEGIEN | AUSGABE 9-10-2018

Digitalisierung von Geschäftsprozessen – Wenn aus »Big Data« »Smart Data« wird

INFORM ist spezialisiert auf intelligente Software zur optimierten Planung und Echtzeit-Disposition von Geschäftsprozessen. Integriert in die bestehende IT-Umgebung optimieren diese Systeme den Erfolg vieler Planungen, Betriebsprozesse und Dispositionsentscheidungen in Bezug auf Produktivität und Zuverlässigkeit. Wir sprachen mit Jens Siebertz, stellvertretender Leiter des Geschäftsbereichs Produktion bei INFORM.

TRENDS WIRTSCHAFT | NEWS | BUSINESS | BUSINESS INTELLIGENCE | TRENDS KOMMUNIKATION | DIGITALISIERUNG | TRENDS GESCHÄFTSPROZESSE | TRENDS SERVICES | EFFIZIENZ | FAVORITEN DER REDAKTION | TRENDS 2018 | INFOGRAFIKEN | INTERNET DER DINGE | KOMMUNIKATION | KÜNSTLICHE INTELLIGENZ | SERVICES | STRATEGIEN

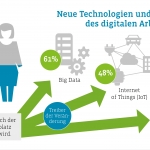

IoT, Big Data und KI erobern den Arbeitsplatz

Trendtechnologien verändern die industrielle Produktion und den Service. Doch auch innerhalb der Unternehmen findet ein Umbruch statt: Neue Technologien und digitale Formen der Kommunikation und Zusammenarbeit lösen analoge erstmals ab. Das zeigt die Deutsche Social Collaboration Studie 2018 [1]. Bereits jetzt setzt über ein Drittel der deutschen Unternehmen Big Data/Data Analytics am Arbeitsplatz ein.…

TRENDS WIRTSCHAFT | NEWS | BLOCKCHAIN | TRENDS CLOUD COMPUTING | BUSINESS INTELLIGENCE | DIGITALISIERUNG | DIGITALE TRANSFORMATION | EFFIZIENZ | TRENDS 2018 | INTERNET DER DINGE | KÜNSTLICHE INTELLIGENZ | STRATEGIEN

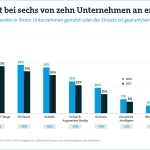

Big Data steht bei sechs von zehn Unternehmen an erster Stelle

■ 57 Prozent planen Investitionen in Big Data oder sind bereits in der Umsetzung. ■ Manager: Internet of Things, Big Data und Robotik haben große Bedeutung für Wettbewerbsfähigkeit deutscher Unternehmen. ■ Aber: Künstliche Intelligenz und Blockchain werden bislang nur selten genutzt. Von Internet of Things über künstliche Intelligenz bis Blockchain: Neue digitale Technologien sind…