Was hat sich durch den Klimawandel auf der Welt verändert? Was bedeutet das für die Menschen? Welche Maßnahmen sind wichtig, um den Klimawandel zu stoppen – oder um zumindest seine Folgen zu bewältigen? Diese Fragen stehen nicht erst seit Greta Thunberg im Fokus des öffentlichen Interesses und werden auch in Zukunft eine zentrale Rolle spielen. Aktuelle Studien zum Thema gibt es zahlreich: Diese zeigen unter anderem, dass die Menge an Kohlendioxid, die ausgestoßen wird, von Jahr zu Jahr ansteigt und immer höhere Temperaturen zu Hitzewellen und Luftverschmutzung führen, die am Ende Auswirkungen auf die Gesundheit der Menschen hat.

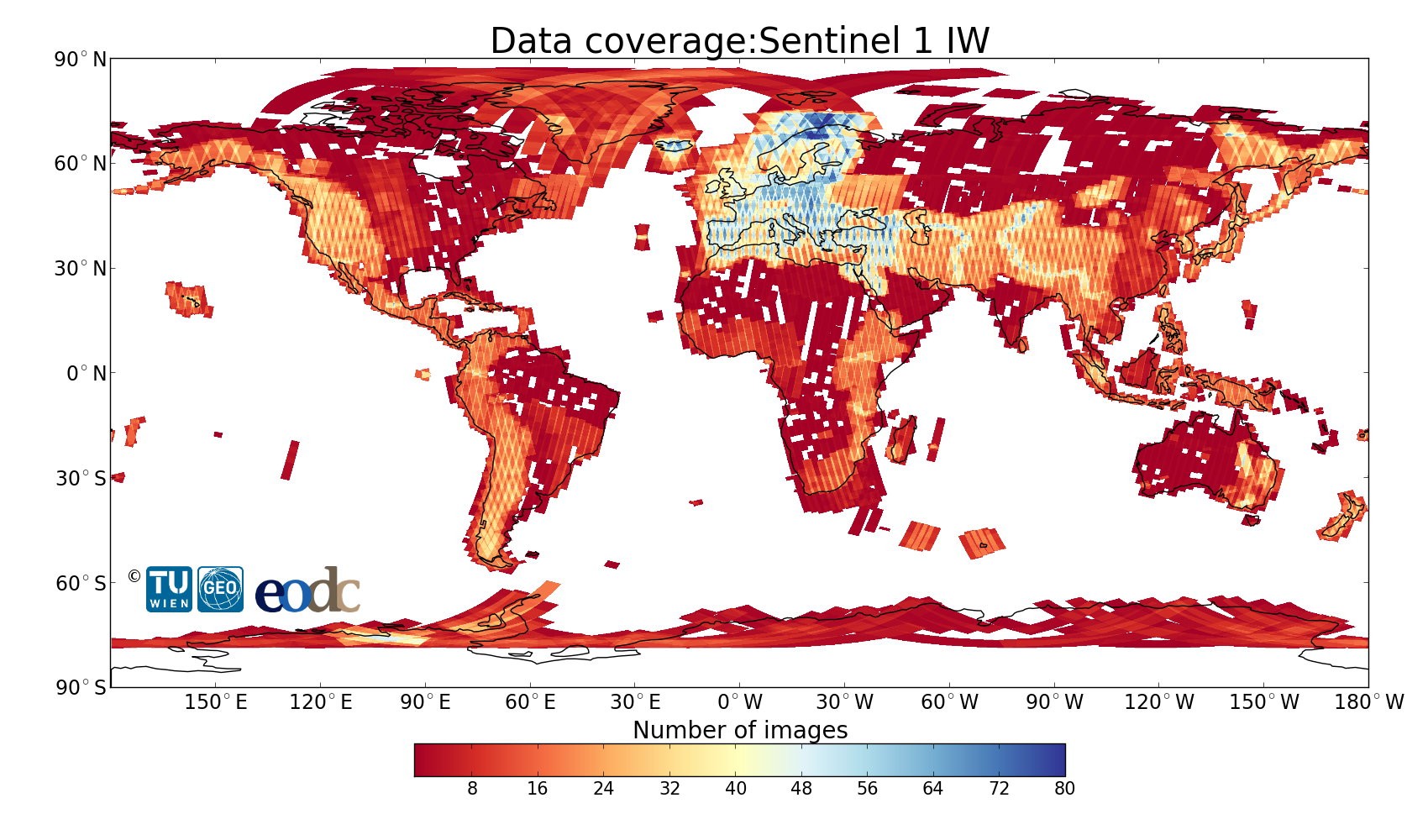

Was genau kann man aber nun tun, um den Klimawandel zu begreifen und zu fassen? Das Earth Observation Data Centre (EODC) beantwortet diese Frage folgendermaßen: Satellitendaten und Bodenbeobachtungen sammeln und speichern, langfristig vergleichen und analysieren – Big Data für die Klima- und Umweltforschung. Doch wie genau gelingt das auf technischer Ebene? EDV-Design, ein Informationstechnologie-Unternehmen aus Wien, hat sich im Auftrag der TU Wien und des EODC dieser Herausforderung gestellt.

EODC: Gründung eines Erdbeobachtungszentrums

Das EODC wurde 2014 von der TU Wien, der Zentralanstalt für Meteorologie und Geodynamik (ZAMG), Firmenpartnern und einzelnen Wissenschaftlern am Standort Arsenal in Wien gegründet. Mit dem EODC schuf man ein Erdbeobachtungsdatenzentrum, in dem eine mächtige, kollaborative IT-Infrastruktur zu finden ist, die die Archivierung, Prozessierung und Verteilung von Sentinel-Satellitendaten möglich macht. Das große Ziel des EODC ist: Diese Daten zu speichern, um sie noch in ferner Zukunft der Klimaforschung – also Unternehmen, für wissenschaftliche Zwecke oder auch der interessierten Öffentlichkeit – zur Verfügung stellen zu können. Den Klimawandel beobachten, bedeutet in diesem Fall konkret: Satelliten umkreisen die Erde und machen Aufnahmen. Diese Bildinformationen geben Aufschluss über die Erdveränderungen, wie zum Beispiel: Wie sah der Gletscher noch vor einem Jahr aus? Wie steht es um den Meeresspiegel an Stelle X? Und wie ist es um die Schneelage an Ort Y bestellt? Die Gebiete werden regelmäßig von den Satelliten erfasst – und anhand der Aufnahmen lassen sich genau diese Fragen beantworten, Vergleiche ziehen und Prognosen aufstellen. Zum Beispiel sind anschließend Umsiedlungspläne auf Inseln oder an Küstengebieten möglich.

Das große Ziel: ewig verfügbare Daten

Je mehr Informationen zusammenkommen, umso granularer können die Analysen und Auswertungen für die Klima- und Umweltforschung erfolgen. Dieser nie endenden Erdbeobachtung stand auf technischer Ebene jedoch eine Herausforderung im Weg: die Frage, wie und wo man diese endlose Datenmasse speichern kann – ohne sie überschreiben zu müssen und stets auf sie zugreifen zu können. Nicht zuletzt auch, weil die Technik immer weiter voranschreitet und bessere Bildauflösungen, Software-Updates sowie Geo-Referenzierungen der Aufnahmen immer mehr Speicherplatz erfordern. Die bereits bestehenden Archive verfügten nicht über genügend Speicherplatz, um dem großen Ziel des EODC gerecht zu werden. »Bei einem Speicherbedarf von 15 bis 25 Terabyte pro Tag konnte man die Rohdaten vielleicht für wenige Tage speichern, bevor sie überschrieben wurden«, sagt Martin Vlcsek, Prokurist bei EDV-Design. »Angesichts einer 24/7-Informationsflut durch die Sentinel-Satelliten war schnell klar, dass diese Kapazität für eine langfristige Datenspeicherung nicht ausreicht.«

Ein Speicher ohne Grenzen

Man benötigte also von Anfang an ein immens großes Speichersystem, das sich zudem dynamisch und ohne Unterbrechung vergrößern lässt. Der Auftrag für ein entsprechendes kosteneffizientes Speicherkonzept wurde in einem speziellen und sehr aufwändigen Verhandlungsverfahren mit dafür in Frage kommenden Firmen vergeben. Neben der Anforderung, ein großes Datenvolumen in nur einem System unterzubringen, musste sich der zukünftige Dienstleister auch um die hochperformante Anbindung an den Supercomputer VSC (Vienna Scientific Cluster) kümmern können. »Zudem wünschten wir uns eine moderne Architektur mit kurzen Datenwegen – im Idealfall alles in einem Gebäude – um die schnelle und ständige Verfügbarkeit der Rechenressourcen zu gewährleisten. Es sollte keine Grenzen geben, aber trotzdem ein gutes Preis-Leistungs-Verhältnis bestehen«, erklärt Wolfgang Wagner, Leiter des Departments für Geodäsie und Geoinformation an der TU Wien. EDV-Design ist langjähriger IBM Business Partner im Bereich Storage und auf High Performance Computing sowie Hochverfügbarkeit spezialisiert. Mit ihrem Konzept eines Speichers ohne Grenzen konnte EDV-Design im Jahr 2016 in dem höchst kompetitivem Auswahlverfahren überzeugen. Unter anderem auch, weil Soft- und Hardware von einem einzigen Hersteller stammten. »Wir liefern eine solide Basis, sowohl im technischen als auch im Service-Bereich, auf die man immer zurückgreifen kann. Dieses Alles-aus-einer-Hand-Konzept ist der Hauptvorteil für unsere Kunden«, sagt Martin Vlcsek.

Ein gigantisches Storage-System ergänzt den Supercomputer VSC

In einem ersten Schritt wurde an der TU Wien eine Speicherkapazität von zwei Petabyte für Satellitendaten von der gesamten Erdoberfläche aufgebaut und an den VSC angebunden. Die Infrastruktur des EODC besteht insgesamt aus drei Komponenten: einer Cloud-Umgebung (OpenStack), einer Prozessierungseinheit (derzeit VSC-3) und dem Storage für das Speichern und Archivieren der Rohdaten und der prozessierten Daten. »Wir empfahlen aus technischen und preislichen Gründen, Tier-0 und Tier-1 zusammenzulegen, um somit ein administrativ vereinfachtes Gesamtsystem umzusetzen«, erläutert Martin Vlcsek. Tier-0 und Tier-1 sind mit einer Gesamtkapazität von 2 Petabyte netto mittels ESS-System aufgebaut. Diese sind sowohl über mehrfache 10 Gigabit Ethernet-Connections mit der EODC-OpenStack-Cloud-Umgebung als auch über ein Highspeed-Netzwerk mit mehreren Infiniband-Connections zum VSC-3-Cluster der TU Wien verbunden. Das ESS-System schafft einen Datendurchsatz von bis zu 26 GB/Sekunde (12 FDR Infiniband). »Als zweites beziehungsweise drittes Tier in dieser Storage-Lösung verwenden wir eine Enterprise Tape Library. Das gesamte System verwendet IBM Spectrum Scale und Spectrum Protect für das automatisierte Information Lifecycle Management. Aktuell besteht eine Gesamt-Nettokapazität von 12 Petabyte«, führt Vlcsek weiter aus.

EDV-Design betreute den gesamten Prozess – von Planung bis Policy

»Die Vorbereitung beziehungsweise Vorarbeit für das Projekt war das Wichtigste«, sagt Martin Vlcsek. 2014 begann diese Vorarbeit in Form von Präsentationen, Diskussionen zwischen den Beteiligten, Systemvorstellungen sowie konkreteren Planungen und Konzepten. »Unsere primäre Kontaktschnittstelle war und ist die TU Wien, die die technischen Ressourcen und ebenfalls das entsprechende Know-how zur Verfügung stellt«, erklärt Vlcsek. Von Juli bis November 2016 erfolgte die erste Ausbaustufe, um die ersten Sentinel-Satellitendaten abzuspeichern. 2018 folgte die zweite. Mittelfristig ist geplant, die Daten von mehreren europäischen Satelliten zu speichern, was täglich eine Speicherkapazität von ca. 15 Terabyte erfordern wird. EDV-Design fungiert als Generalunternehmen, das alle Phasen des Projektes betreut – von Planung und Präsentation über Aufbau und Adaption der Infrastruktur bis zur Installation und Anbindung an den VSC, Konfiguration und Inbetriebnahme. Des Weiteren erarbeitete EDV-Design gemeinsam mit dem Kunden das Layout und stellte Richtlinien zur Nutzung des Storage-Systems auf.

Leistungsstarkes Mischsystem mit idealem Preis-Leistungs-Verhältnis

»Ein Mischsystem aus Disc und Tape war die beste und preiswerteste Lösung für das EODC«, sagt Vlcsek. Zudem sei das System für Kunden durch und durch transparent, unter anderem durch die gemeinsam mit EDV-Design aufgestellte Policy zur Datensichtbarkeit: Daten, die älter als ein Jahr sind, werden auf kostengünstigere Tapes ausgelagert, damit die neuen Satelliteninformationen auf der leistungsstarken Disc Platz haben. Aktuell befinden sich 50 Prozent der Daten auf Tape. Dies kann bis zu 90 Prozent ausgedehnt werden, auch um den Energieaufwand für das Speicherarchiv im Sinne von »Green IT« gering zu halten. Die auf Tape gespeicherten Daten sind stets verfügbar und absolut übersichtlich für den Benutzer – er kann so bei speziellen Projekten ganz einfach auf historische Daten zugreifen.

»Wir haben hier einen soliden Storage-Grundstein erschaffen, der immer wieder erweitert werden kann. An der Grundstruktur ändert sich nichts mehr«, erläutert Vlcsek weiterhin. Je nach Kundenwünschen kommen neue Features, Updates oder Backups dazu oder es kommt zu zusätzlichen Netzwerkanbindungen oder örtlichen Trennungen. »Aber das Speichersystem an sich lässt sich einfach immer mehr erweitern, indem man mit neuen Tapes nachrüstet.« Eine technische Herausforderung während der Installation und Inbetriebnahme sei gewesen, die Schnittstellen zu den bestehenden Systemen korrekt einzurichten. »Aber auch diese Herausforderung konnten wir schnell erfolgreich meistern«, sagt Vlcsek.

Solides und erfolgreiches System für Forschungszwecke

»Wir sind sehr zufrieden mit der Arbeit von EDV-Design, die ein zuverlässiger und motivierter Dienstleister bei der Umsetzung war«, sagt Wolfgang Wagner. Das überaus performante Storage-System und der schnelle Support seien dabei die Hauptvorteile. Zudem wird das EODC umfassend angenommen und erfolgreich von Universitäten, Unternehmen und Forschungseinrichtungen (zu finden auf der Website des EODC unter https://www.eodc.eu/partners/) aus dem In- und Ausland genutzt, mit wachsenden Anwenderzahlen. Insgesamt 20 Kooperationspartner des EODC auf internationaler Ebene – unter anderem aus Österreich, Deutschland, Belgien, Italien, Australien und der Schweiz – arbeiten bereits mit den Sentinel-Daten und profitieren dabei von dem schnellen Storage. Beim jährlich stattfindenden EODC Forum kommen die Partner zusammen, um sich über ihre Projekte, Projektentwicklungen und -fortschritte im Rahmen des EODC auszutauschen. Dabei kommen die unterschiedlichsten Themen und Anwendungsbeispiele zur Sprache, wie zum Beispiel die Erkennung von Sturmschäden in alpinen Wäldern, Luft-Schadstoffemissionen, Dürreüberwachung oder die Rolle von Satellitendaten für Versicherungen.

Ein Blick in die Zukunft des EODC

»Es ist weltweit einmalig, ein riesiges Erddatenarchiv unmittelbar an enorme Rechenleistung gekoppelt zur Verfügung zu haben. Mit den oftmals verwendeten, vergleichsweise teuren Cloud-Rechenkapazitäten kann über begrenzte Datenströme niemals so schnell auf die Datenquellen zugegriffen werden wie das im Arsenal in Wien, in lokaler Kombination möglich ist«, sagt auch Robert Kibler, Geschäftsführer von EDV-Design über den Erfolg des Systems. Die nächste Ausbaustufe des Vienna Scientific Clusters ist in der Finalphase, sodass VSC-3 bald durch VSC-4 abgelöst wird. Wolfgang Wagner ergänzt mit Blick in die Zukunft: »Wir hoffen, durch die Daten und Infrastruktur des EODCs in Zukunft eine bedeutende Rolle für internationale Initiativen spielen zu können, wie die European Open Science Cloud (EOSC), oder WEkEO, das von EUMETSAT, ECMWF und Mercator Ocean betriebene Copernicus Data Information and Access System (DIAS). Am Ende geht es darum, anhand fundierter Daten rechtzeitig einzugreifen, um im Rahmen des Klimawandels die Lebensqualität zu erhöhen. Und das ist eine nie endende Aufgabe, der wir durch das leistungsstarke Storage-System gewachsen sind.«

414 Artikel zu „Big Data Speicher“

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

Das Potenzial von Machine Learning in einem Data Lake

Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem…

TRENDS 2019 | NEWS | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | TRENDS SERVICES | INFRASTRUKTUR | SERVICES

2020 überholt die Cloud lokale Speichermedien

Das weltweite Datenaufkommen explodiert und bringt traditionelle Speichermedien an die Grenzen ihrer Kapazität. Die Lösung ist die Cloud. Wie die Grafik auf Basis des Statista Digital Economy Compass zeigt, werden bereits im kommenden Jahr mehr Daten via Internet auf großen Serverfarmen gespeichert und bereitgestellt als auf lokalen Geräten. Das bietet für Privatverbraucher und Geschäftskunden einige…

TRENDS 2019 | TRENDS SECURITY | NEWS | BUSINESS | FAVORITEN DER REDAKTION | IT-SECURITY | WHITEPAPER

Schwarzes Loch im Daten-Universum: 52 Prozent der Informationen in Unternehmen sind »Dark Data«

Trotz zunehmender Sicherheitsvorfälle und strenger Datenschutzbestimmungen sind mehr als die Hälfte der Unternehmensdaten nicht klassifiziert. Unternehmen weltweit ziehen unwissentlich Cyberkriminelle an. Grund dafür sind die sogenannten »Dark Data«, also Informationen, deren Inhalt und Geschäftswert unbekannt sind. Das ergab eine aktuelle Erhebung von Veritas Technologies. Im Rahmen der Value-of-Data-Studie hatte Vanson Bourne im Auftrag von Veritas…

TRENDS 2019 | NEWS | BLOCKCHAIN

Ist Blockchain ein kurzlebiger Trend?

Die Hälfte der deutschen Unternehmen sehen die Blockchain nicht als »Game Changer«. Rund 50 Prozent aller hierzulande im Zuge einer Erhebung Befragten glauben, dass die Blockchain-Technologie keinen tiefgreifenden Umbruch mit sich bringen wird. Dementsprechend schleppend läuft auch die Umsetzung zugehöriger Projekte: Zwei Drittel der Studienteilnehmer in Deutschland gaben an, dass ihr Unternehmen noch keine relevanten…

TRENDS 2019 | TRENDS WIRTSCHAFT | NEWS | TRENDS INFRASTRUKTUR | BUSINESS | DIGITALISIERUNG| EFFIZIENZ | GESCHÄFTSPROZESSE | INFOGRAFIKEN | TRENDS 2020 | INTERNET DER DINGE | TRENDS 2022| TRENDS 2025 | LÖSUNGEN | SERVICES

Energieintelligenz für Speichersysteme erhöht die Wachstumschancen der Hersteller

Partnerschaften über die Wertschöpfungskette hinweg haben sich als entscheidend erwiesen, um das Potenzial zahlreicher umsatzgenerierender Möglichkeiten auszuschöpfen. Aufgrund der Einspeisevergütungs- und Netto-Messungs-Revisionen in kommerziellen Photovoltaik-(PV)-Hotspots sowie Subventionen, Steueranreizen, immer erschwinglicher werdenden Lithium-Ionen-Batterien und steigenden Strompreisen hat sich der Anreiz erhöht, den Markt für gewerbliche Batteriespeicher weiter zu erschließen. Die Zunahme von Eigenverbrauchsmodellen und Digitalisierung ermutigen…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | STRATEGIEN| AUSGABE 3-4-2019

Advanced, predictive, preventive: Data Analytics – Trend oder Zukunft?

Die Themen Digitalisierung und Big Data stehen bereits seit Jahren auf der »To-do-Liste« der Unternehmen und sind auch in den Fachmedien mehr als präsent. Allerdings steckt die Umsetzung in der Realität bei vielen Unternehmen noch in den Kinderschuhen. Das Potenzial, das Daten bieten, ist häufig nicht auf den ersten Blick ersichtlich. Erst durch eine detaillierte Analyse der Daten lassen sich diese optimal nutzen. Mittlerweile eröffnen sich hier mit Data Analytics ganz neue Möglichkeiten.

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Vorsprung durch Wissen – Die Ära von Big Data kommt noch

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | INFRASTRUKTUR | OUTSOURCING | ONLINE-ARTIKEL | SERVICES

6 Gründe für ein Cloud-basiertes Data Warehouse

Ein Data Warehouse, das Daten aus verschiedenen Quellen zusammenfasst, um sie analysieren und darauf reagieren zu können, ist heute entscheidend für den Geschäftserfolg. Denn es verarbeitet schnell die enormen Datenmengen, die sich heute in Unternehmen ansammeln. Darauf basierend können Führungskräfte zuverlässige datenbasierte Entscheidungen treffen. Allerdings halten es fast zwei Drittel der kürzlich befragten Experten für…

NEWS | DIGITALISIERUNG | FAVORITEN DER REDAKTION | LÖSUNGEN | ONLINE-ARTIKEL

Wie Automatisierung des Data Warehouse den Wert der Unternehmensdaten erhöhen kann

Volume, Velocity, Variety, Veracity. Im englischen IT-Sprachgebrauch haben sich die vier Vs der Datenspeicherung längst etabliert. Volumen, Geschwindigkeit, Vielfalt und Wahrhaftigkeit gilt es in Einklang zu bringen, um die Daten eines Unternehmens erfolgreich verwalten zu können. Herkömmliche Data-Warehouse-Infrastrukturen sind häufig nicht mehr in der Lage, die enormen Datenmengen, die Vielfalt der Datentypen, die Geschwindigkeit mit…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | EFFIZIENZ | LÖSUNGEN | ONLINE-ARTIKEL | STRATEGIEN | TIPPS

Master Data Management per Open-Source-Plattform: Ein Unternehmen, eine Datenplattform

Auf dem Weg zur Digitalisierung stehen Unternehmen auch vor der Aufgabe, ihre Stammdaten effizienter zu organisieren. Dafür braucht es ein unternehmensübergreifendes Stammdaten-System, in dem alle Daten in hoher Qualität, einschließlich ihrer Relationen untereinander, hinterlegt und abgerufen werden können. Für die technische Umsetzung bieten sich Open-Source-Plattformen als zukunftsfähige und kostengünstige Lösung an. Daten werden…

NEWS | BUSINESS INTELLIGENCE | ONLINE-ARTIKEL | SERVICES | STRATEGIEN

Fünf Vorurteile über Data Analytics

Die Entwicklungen von Big Data, Machine Learning und künstlicher Intelligenz werden 2019 wieder zu einem spannenden Jahr machen. Dank der Zukunftstechnologien gewinnt vor allem die Datenanalyse an Fahrt und Unternehmen werden noch weniger um die effektive Auswertung ihrer Informationen herumkommen. Manch einer tut sich aber schwer mit dieser neuen, tragenden Säule im Geschäftsalltag. IT-Experten sehen…

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | LÖSUNGEN | ONLINE-ARTIKEL

Testautomatisierung im ERP-Umfeld: Wie myToys mit DataOps agile Prozesse vorantreibt

Erfolg im E-Commerce steht und fällt mit einer agilen Softwareentwicklung und einer flexiblen IT-Infrastruktur. Unternehmen müssen heute in der Lage sein, schnell neue Features umzusetzen – nicht nur im Shop, sondern auch im ERP-System. Gerade bei Letzterem fallen allerdings riesige Datenmengen an. Testdaten zu generieren wird damit zum Problem. Wie eine DataOps-Plattform helfen kann, den…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | LÖSUNGEN | ONLINE-ARTIKEL | RECHENZENTRUM | SERVICES

Die Entwicklung von Big Data zu Fast Data

Das »Warum« der Datenverarbeitung liegt auf der Hand, wenn man die große Anzahl von Sensoren, vernetzten Geräten, Websites oder mobilen Anwendungen betrachtet; oder einfach alle Daten, die sowohl von Menschen als auch von Maschinen erzeugt werden. Die immensen, rasch ansteigenden Datenberge erfordern kontinuierlich leistungsfähigere Ansätze zur Datenverarbeitung. Open Source spielt dabei nach Meinung der data…

TRENDS 2019 | NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | EFFIZIENZ | GESCHÄFTSPROZESSE | INFRASTRUKTUR | KÜNSTLICHE INTELLIGENZ | STRATEGIEN

Trends für 2019 – Stream Processing als Ansatz für Big Data und komplexes Datamanagement

Um vorherzusehen, dass die schiere Masse an Daten auch im kommenden Jahr neue Rekordwerte erklimmen wird, muss man kein Experte sein. Um dieser Entwicklung Herr zu werden und die entstehenden Datenmassen effizient zu nutzen, sind jedoch Experten und neue Technologien gefragt. Ein erfolgsversprechender Ansatz ist dabei Stream Processing. Stream Processing, also Datenstromverarbeitung, ist…