Illustration: Geralt Absmeier

Im Zeitalter von Big Data könnte man davon ausgehen, dass man gar nicht genug Daten haben kann. Denn aus Daten lassen sich in der Theorie wichtige Erkenntnisse ziehen, die Unternehmen zu ihrem Vorteil nutzen können. Und so sammeln Unternehmen seit Jahren fleißig Daten aus immer mehr Quellen ein – und stehen damit auch vor der immer komplexeren Aufgabe diese Daten sinnvoll verarbeiten zu müssen. In der Praxis macht sich schon lange vielerorts Ernüchterung breit: Denn oft führen mehr Daten nicht zwangsläufig zu besseren Ergebnissen. Das grundlegende Problem ist, dass es vielen Unternehmen einfach an einer grundlegenden Datenstrategie fehlt. Ohne diese ist es schwer zeitnah Wert aus Daten ziehen zu können. Eine passende Datenstrategie für sein Unternehmen zu haben oder diese zu erstellen, wenn es noch keine gibt, ist also ein wichtiges Element jedes Unternehmens das große Datenmengen verarbeitet.

Kern jeder Datenstrategie: Das Data Warehouse

Eine passende Datenstrategie muss an eine Organisation und ihre Zielsetzung angepasst sein. Wenn man schnell Ergebnisse benötigt, braucht man auch eine entsprechend schnelle und agile Strategie. Wenn es aber nur darum geht, so viele Daten wie möglich zu verarbeiten, benötigt man eine Strategie, die möglichst viel Verarbeitungsleistung bietet. Doch ganz egal, wofür man seine Daten benötigt und wie man seine Datenstrategie letzten Endes erstellt, jede moderne Organisation mit vielen Daten benötigt ein modernes Data Warehousing. Das Data Warehouse ist der universelle Ort, an dem Daten aus vielen unterschiedlichen Quellen gesammelt werden – und der Ort, aus dem man im besten Fall die gewünschten Erkenntnisse erhält. Plant man also eine passende Datenstrategie, so ist das Data Warehouse eines der wichtigsten Kernelemente. Ein weiterer wichtiger Bestandteil jeder modernen Datenstrategie sind Metadaten.

Verarbeitung von Metadaten wird immer wichtiger

Metadaten sind Daten, die Informationen über »andere Daten« liefern. Metadaten haben verschiedene Zwecke. Sie helfen den Benutzern, relevante Informationen und Ressourcen zu finden und helfen der IT bei der Identifizierung und Archivierung ihrer Daten. Metadaten ermöglichen es, Daten anhand relevanter Kriterien zu finden. Mit ihnen lassen sich beispielsweise verschiedene Daten zusammenführen, ungleiche Daten unterscheiden oder Ortsangaben machen. Saubere Daten inklusive der passenden Metadaten machen es Organisationen einfacher einen Wert aus den Daten zu ziehen. Selbstredend muss ein modernes Data Warehouse also nicht nur Daten aus vielen verschiedenen Kanälen und Quellen verarbeiten können, sondern auch die zugehörigen Metadaten. Dies betrifft auch verwandte Prozesse wie das Änderungsmanagement und die Systemdokumentation.

Hat ein Unternehmen die Verwaltung der wichtigen Metadaten erfolgreich bewältigt, profitiert davon nicht nur das Unternehmensmanagement, sondern auch die immer wichtiger werdenden Entwickler. Diese arbeiten fortan deutlich produktiver mit aktuellen und sauberen Datensätzen, auf die sie sich verlassen können.

Automatisierung des Data Warehouse ist notwendig

Bei immer mehr Daten und Datenquellen, ist die effektive Verwaltung des Data-Warehouse für viele IT-Abteilungen eine immer größer werdende Herausforderung. Doch wie auch in vielen anderen Bereichen des Rechenzentrums kann Automatisierung bei der Bewältigung dieser Herausforderung ein wichtiger Teil der Lösung sein. Denn das grundlegende Problem bei immer mehr Daten und komplexeren Prozessen ist, dass es einfach nicht mehr möglich ist die Dateninfrastruktur bei jeder neu hinzugefügten IT-Lösung oder Migration neu manuell zu verändern. Ein automatisiertes Data Warehouse lässt sich hingegen relativ schnell und einfach verwalten – der Großteil der Prozesse ist ja automatisiert. Damit nimmt die Automatisierung eine große Last von den Schultern der IT und hat damit das Potenzial eine Big-Data-Strategie einfacher, billiger und konformer mit Vorschriften wie der DSGVO zu machen.

Modernisierung des Data Warehouse bedeutet zuerst: Automatisierung

Im Zeitalter von Big Data hat sich vielerorts Ernüchterung breitgemacht: Es gibt immer mehr Daten, Datenquellen und höhere Anforderungen an die Qualität der Rohdaten und deren Erkenntnisse. In der Realität ist die IT mehr damit beschäftigt Probleme beim Datenmanagement zu lösen, als Lösungen zu präsentieren. Gesucht wird vielerorts eine passende Datenstrategie, die die Verwaltung vereinfacht und dabei hilft einen Wert aus all den vorhandenen Daten ziehen zu können. Teil einer erfolgreichen Datenstrategie muss also Fundament ein modernes Data Warehouse sein. Unternehmen, die an einer Datenstrategie arbeiten, kommen nicht um die Modernisierung ihres Data Warehouse herum. Und eine der wichtigsten Aufgaben bei dieser Modernisierung ist die Automatisierung des Data Warehouse.

Rob Mellor, VP und GM EMEA bei WhereScape

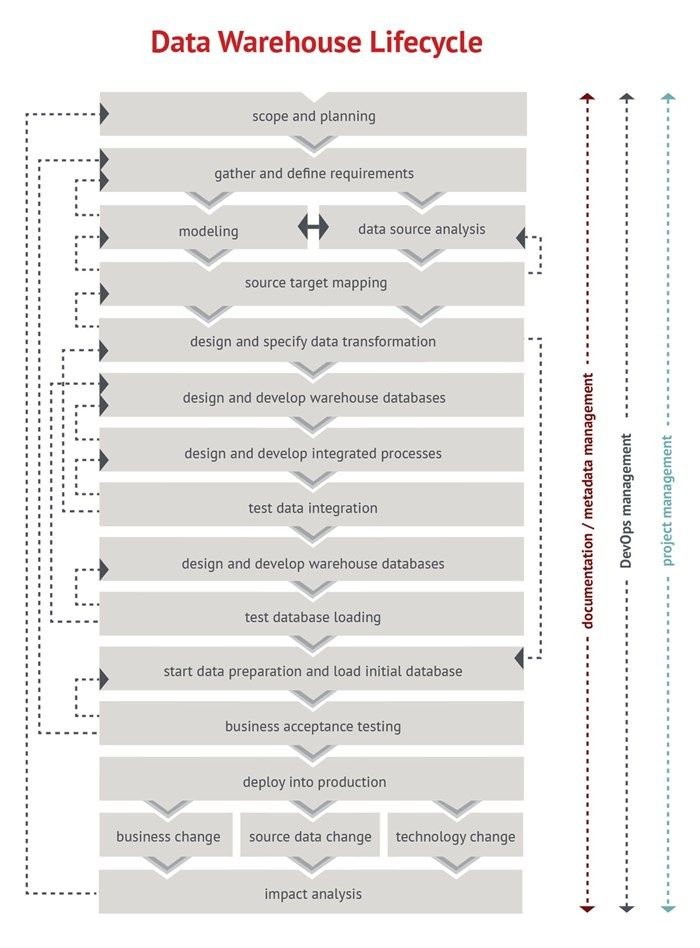

Die Data-Warehouse-Automatisierung hilft IT-Teams, Data-Warehouse-Automation-Software kombiniert die Verwendung von Metadaten, Data-Warehouse-Methoden, Mustererkennung und mehr, um Entwicklern zu helfen, Data-Warehouse-Designs und Codierung durch den Einsatz von Data-Warehouse-Design-Tools und zeitsparenden Entwicklungsassistenten und -vorlagen automatisch zu generieren. Insofern bietet Automatisierung viel mehr als bisher, indem sie viel schneller, mit weniger Projektrisiko und niedrigeren Kosten liefert und verwaltet. Zudem entfallen wiederholte Design-, Entwicklungs-, Bereitstellungs- und Betriebsaufgaben innerhalb des Data-Warehouse-Lebenszyklus.

121 Artikel zu „Data Warehouse Big Data“

NEWS | BUSINESS INTELLIGENCE | TRENDS CLOUD COMPUTING | BUSINESS PROCESS MANAGEMENT | TRENDS GESCHÄFTSPROZESSE | EFFIZIENZ | TRENDS SERVICES | INFOGRAFIKEN

Big Data vs. Data Warehouse: Zeit für die Modernisierung

Laut eines TDWI-Berichts ist es in den meisten Unternehmen Zeit für die Modernisierung der Data-Warehouse-Lösung [1]. Die Gründe dafür lassen sich in vier Kategorien einteilen: Unternehmen wollen echte Werte aus Big Data generieren Wir sind endgültig im Analytics-Zeitalter angekommen Es gibt neue Anforderungen an Echtzeitdaten Open-Source-Software ist mittlerweile Teil des Data Warehouse Die Bereithaltung, zentrale,…

BUSINESS INTELLIGENCE | TOP-THEMA | AUSGABE 3-4-2015

Data Lake statt Data Warehouse – Im Zuhause für Big Data erfolgreich fischen

Daten, so war auf der CeBIT immer mal wieder zu hören, seien doch ein recht dröges Thema. Big Data hingegen, das sei eine spannende Sache. Nicht zuletzt wegen seiner engen Verbindung mit dem Internet der Dinge. Also eine wichtige Zukunftstechnologie. Tatsächlich geht es aber auch bei Big Data um nichts anderes als das Zusammenführen von strukturierten und unstrukturierten Daten beispielsweise aus dem Internet of Things oder Social Media.

LÖSUNGEN | AUSGABE 7-8-2014

Big Data und Data Warehouse – Datenmanagement wieder im Fokus

NEWS | DIGITALISIERUNG | SERVICES | STRATEGIEN

Open-Data-Initiative: Mit Datenkooperationen gegen die »Daten-Kluft«

Durch die Nutzung und den Austausch öffentlich zugänglicher Daten können fundierte Entscheidungen getroffen und sogar einige der weltweit drängendsten sozialen Herausforderungen besser bewältigt werden. So heißt es in der neuen Datenstrategie der Bundesregierung, »Daten sind eine Schlüsselressource«, etwa für die Verbesserung der Gesundheitsversorgung. Die Fähigkeit Daten verantwortungsvoll und selbstbestimmt zu nutzen, zu verknüpfen und auszuwerten,…

NEWS | BUSINESS INTELLIGENCE | DIGITALISIERUNG | FAVORITEN DER REDAKTION | TIPPS | WHITEPAPER

Data Preparation: In 4 Schritten zum Data-Science-Projekt

Die richtige Data Preparation erhöht die Vorhersagequalität von Datenmodellen und steigert die Wirksamkeit von Machine Learning-Zyklen. Die meisten Daten sind ohne eine vorher durchgeführte Data Preparation für KI-gestützte Prognosen ungeeignet: ihre Qualität ist unzureichend, sie liegen nicht in numerischer Form vor, oder es fehlen Werte. Diese Handlungsempfehlungen unterstützen bei der Datenvorbereitung und helfen, den…

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | SERVICES | TIPPS | WHITEPAPER

Wie gelangt man zu einem effektiven Data Lake?

Die schnelle Entscheidungsfindung auf Basis digitaler Daten verändert die Art und Weise, wie Unternehmen und IT arbeiten. Da Unternehmen auf alle Arten von Informationen zugreifen wollen, haben sie einen Bedarf an Infrastrukturexperten erkannt, die ihnen helfen, aus ihren Daten neue Werte zu erschließen. Rubrik, Anbieter einer Plattform für Multi-Cloud Data-Control, erläutert jüngste Entwicklungen in diesem…

NEWS | EFFIZIENZ | LÖSUNGEN | SERVICES | AUSGABE 11-12-2019

Data Quality: HELM AG modernisiert und zentralisiert Datenhaltung

Dezentral organisierte Unternehmen tun sich oft schwer, Informations- und Datenprozesse schlank, einheitlich und transparent zu organisieren. Die Digitalisierung verstärkt den Erneuerungsdruck. Die global tätige HELM AG hat es mit Hilfe einer Data-Quality-Lösung geschafft, ihre vertrieblichen und kaufmännischen Arbeitsabläufe zu optimieren. Die Software sorgt dafür, dass die neu erstellte zentrale Stammdatenbasis von Dubletten und Inkonsistenzen befreit wird und im Tagesgeschäft dauerhaft »sauber« bleibt.

TRENDS 2020 | NEWS | BUSINESS | BUSINESS INTELLIGENCE | TRENDS CLOUD COMPUTING | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | TRENDS SERVICES | FAVORITEN DER REDAKTION | KÜNSTLICHE INTELLIGENZ

Analytics reicht nicht mehr aus: Top-Trends im Big-Data-Umfeld 2020

Wide Data, DataOps, Metadaten-Kataloge, Datenkompetenz und Shazamen sind die wichtigsten Trends im kommenden Jahr. Für 2020 hat der Data-Analyst-Spezialist Qlik folgende fünf Trends im Zusammenhang mit Big Data und Analytics identifiziert: Aus Big Data wird Wide Data Dank skalierbarer Cloud-Lösungen sind in Big-Data-Umgebungen nicht länger die Kapazitätslimits unternehmensinterner IT-Infrastrukturen ein begrenzender Faktor. Die Herausforderung…

TRENDS 2020 | NEWS | BUSINESS INTELLIGENCE

Die Trends für Business Intelligence & Big Data 2020

Welche Trends für Business Intelligence (BI), Data & Analytics werden das Jahr 2020 prägen? Im Interview gibt BARC-Chef-Analyst Dr. Carsten Bange seine Prognosen ab. Außerdem stellt er exklusiv die Ergebnisse des BARC BI Trend Monitor 2020 vor, der 2.650 Anwender von BI-Technologie zu ihren persönlichen Trendthemen befragt hat. Dr. Carsten Bange, Gründer und Geschäftsführer von…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | ONLINE-ARTIKEL | STRATEGIEN

Big Data: Wo die wilden Daten leben

Data Lakes, Data Marts, Data Vaults und Data Warehouses. Worin unterscheiden sich die verschiedenen Ansätze der Dateninfrastruktur? Big Data oder Data Analytics sind einige der größten Herausforderungen für die IT unserer Zeit. Viele Unternehmen befinden sich inmitten einer Umstellung auf eine datengesteuerte Ausrichtung ihrer Organisation und sind auf der Suche nach der dazu passenden Dateninfrastruktur.…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | TRENDS GESCHÄFTSPROZESSE | TRENDS SERVICES | TRENDS 2019

Datenintegration ist entscheidend für die Data-Warehouse-Modernisierung

Das Business Application Research Center (BARC) veröffentlicht »The Data Management Survey 19«, eine neue Studie, die auf einer aktuellen weltweiten Umfrage unter 782 Nutzern von Datenmanagementsoftware basiert. Die Umfrageergebnisse geben Einblicke in aktuelle Ansätze zur Modernisierung des Data Warehouse sowie einen Vergleich von elf führenden Datenmanagement-Produkten. Bekanntlich fallen etwa 70 bis 80 Prozent des Aufwandes…

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN

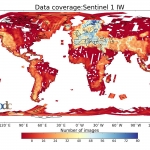

Klimawandel und Big Data: Ein Speichersystem ohne Grenzen für die Erdbeobachtung

Was hat sich durch den Klimawandel auf der Welt verändert? Was bedeutet das für die Menschen? Welche Maßnahmen sind wichtig, um den Klimawandel zu stoppen – oder um zumindest seine Folgen zu bewältigen? Diese Fragen stehen nicht erst seit Greta Thunberg im Fokus des öffentlichen Interesses und werden auch in Zukunft eine zentrale Rolle spielen.…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

Das Potenzial von Machine Learning in einem Data Lake

Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | STRATEGIEN | AUSGABE 3-4-2019

Advanced, predictive, preventive: Data Analytics – Trend oder Zukunft?

Die Themen Digitalisierung und Big Data stehen bereits seit Jahren auf der »To-do-Liste« der Unternehmen und sind auch in den Fachmedien mehr als präsent. Allerdings steckt die Umsetzung in der Realität bei vielen Unternehmen noch in den Kinderschuhen. Das Potenzial, das Daten bieten, ist häufig nicht auf den ersten Blick ersichtlich. Erst durch eine detaillierte Analyse der Daten lassen sich diese optimal nutzen. Mittlerweile eröffnen sich hier mit Data Analytics ganz neue Möglichkeiten.

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Vorsprung durch Wissen – Die Ära von Big Data kommt noch

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | INFRASTRUKTUR | OUTSOURCING | ONLINE-ARTIKEL | SERVICES

6 Gründe für ein Cloud-basiertes Data Warehouse

Ein Data Warehouse, das Daten aus verschiedenen Quellen zusammenfasst, um sie analysieren und darauf reagieren zu können, ist heute entscheidend für den Geschäftserfolg. Denn es verarbeitet schnell die enormen Datenmengen, die sich heute in Unternehmen ansammeln. Darauf basierend können Führungskräfte zuverlässige datenbasierte Entscheidungen treffen. Allerdings halten es fast zwei Drittel der kürzlich befragten Experten für…

NEWS | DIGITALISIERUNG | FAVORITEN DER REDAKTION | LÖSUNGEN | ONLINE-ARTIKEL

Wie Automatisierung des Data Warehouse den Wert der Unternehmensdaten erhöhen kann

Volume, Velocity, Variety, Veracity. Im englischen IT-Sprachgebrauch haben sich die vier Vs der Datenspeicherung längst etabliert. Volumen, Geschwindigkeit, Vielfalt und Wahrhaftigkeit gilt es in Einklang zu bringen, um die Daten eines Unternehmens erfolgreich verwalten zu können. Herkömmliche Data-Warehouse-Infrastrukturen sind häufig nicht mehr in der Lage, die enormen Datenmengen, die Vielfalt der Datentypen, die Geschwindigkeit mit…

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALE TRANSFORMATION

Automation vereinfacht Data-Warehouse-Migration in die Cloud

Die Migration des Data Warehouse in die Cloud ist für Unternehmen, die Teile ihrer Infrastruktur in die Cloud verlegen, ein wichtiger und über kurz oder lang auch notwendiger Schritt. Als eines der wichtigsten Puzzleteile der Infrastruktur, ist er leider auch meist sehr komplex und mit hohen Kosten verbunden. Anstatt die Migration dieses wichtigen Bestandteils der…

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | INFRASTRUKTUR | ONLINE-ARTIKEL | RECHENZENTRUM

Health-Check: Wie fit ist Ihr Data Warehouse?

In vielen Unternehmen ist das Data Warehouse in die Jahre gekommen. Gleichzeitig wachsen die Anforderungen der Fachabteilungen. Mit IoT und der Digitalisierung kommen zudem neue Herausforderungen hinzu. Ist Ihr Data Warehouse all dem noch gewachsen? Machen Sie den Health-Check. Das Data Warehouse (DWH) bildet das Fundament für Business Intelligence und Data-Analytics-Plattformen. Es dient als zentraler…