Die schnelle Entscheidungsfindung auf Basis digitaler Daten verändert die Art und Weise, wie Unternehmen und IT arbeiten. Da Unternehmen auf alle Arten von Informationen zugreifen wollen, haben sie einen Bedarf an Infrastrukturexperten erkannt, die ihnen helfen, aus ihren Daten neue Werte zu erschließen. Rubrik, Anbieter einer Plattform für Multi-Cloud Data-Control, erläutert jüngste Entwicklungen in diesem Zusammenhang und beschreibt, wie Unternehmen effektive Data Lakes nutzen können.

»Datenbankadministratoren haben jetzt die Möglichkeit, sich als interne Experten in Stellung zu bringen. Dies bedeutet, als strategischer Geschäftspartner zu agieren, um diese Daten zu verwalten und sicherzustellen, dass sie denjenigen zur Verfügung stehen, die sie benötigen. Zu diesem Zweck bauen viele DBAs nicht nur ihre Cloud- und DevOps-Fähigkeiten aus, sondern wagen sich auch an das Thema Data Lake heran«, erklärt Roland Rosenau, Systems Engineering Manager bei Rubrik. »Hierbei handelt es sich um ein großes Repository, in welchem viele Daten – in ihrer rohen, ursprünglichen Form – aus verschiedenen Quellen zusammenfließen. Benutzer innerhalb eines Unternehmens können dann auf die zentralisierten Daten zugreifen und sie analysieren.«

Die wahre Stärke eines Data Lake zeigt sich nach Meinung von Rubrik, wenn eine maximale Akzeptanz im gesamten Unternehmen gegeben ist, das Potenzial von Big Data für möglichst viele Geschäftsentscheidungen zu nutzen. Um einen solchen Data Lake oder Datenpool zu erstellen, müssen Unternehmen sich für bestimmte Plattformen und Datenquellen entscheiden. Vor allem müssen sie festlegen, wie sie diesen Datenpool den Beteiligten präsentieren, um die Akzeptanz im gesamten Unternehmen zu erhöhen.

Wann kommt ein Data Lake in Frage?

Data Lakes kommen für Unternehmen aller Branchen und Größen infrage, die künftig stärker datenbasierte Geschäftsentscheidungen treffen wollen. Die Menge der gesammelten Daten – zusammen mit den Anforderungen an die Analyse durch die verschiedenen Geschäftsbereiche – hat jedoch zugenommen. Traditionell würde die IT-Abteilung die Analyse und Verarbeitung durchführen, aber sie hat vielerorts einfach nicht die nötigen Ressourcen. Dies führt dazu, dass Entscheidungen in vielen Unternehmen nach wie vor nicht auf Basis aller verfügbaren Informationen getroffen werden. Die Lösung besteht darin, möglichst vielen Benutzern den Zugriff auf die Daten in Rohform zu ermöglichen und ihre eigenen spezifischen Analysen durchzuführen, wenn sie sie brauchen.

Der Ansatz des Data Lake wurde geschaffen, um alle Rohdaten eines Unternehmens zu erfassen und gleichzeitig mehreren Benutzern die Möglichkeit zu geben, auf das Repository zuzugreifen und ihre eigenen Erkenntnisse zu gewinnen. Data Lakes ermöglichen quasi Selbstbedienung. Da sich die Analyse-Tools ständig verbessern, ist ein akademischer datenwissenschaftlicher Background nicht mehr unbedingt erforderlich, um die Rohdaten sinnvoll zu nutzen und die von den Geschäftsbereichen benötigten Informationen zu sammeln. Somit erweist sich ein Data Lake als attraktiver Ansatz für zeitgemäßes Datenmanagement und wertschöpfende Datenanalyse.

Mehr herausholen aus Big Data

»Um sicherzustellen, dass die Mitarbeiter den Data Lake annehmen, empfiehlt es sich, eine Schnittstelle zu wählen, die unterschiedliche Fachkenntnisse anspricht. So können Optionen zur Einstufung der Daten nach ihrer Qualität eingefügt werden. Benutzer sollten zudem den gewünschten Datensatz auf der Grundlage der verfügbaren Felder oder Datenmerkmale auswählen können«, so Roland Rosenau.

Ohne Benutzerfreundlichkeit lässt sich keine vollständige Akzeptanz erzielen. Der Data Lake würde dann zu einem Data Swamp, also Datensumpf, degradiert werden – mit riesigen Mengen an unberührten, undefinierten und unorganisierten Daten, die von den Benutzern nicht vernünftig zu handhaben sind. Data Swamps sind in der Regel ein Symptom für eine schlechte Datenverwaltung und fehlende kontextbezogene Metadaten, die helfen, die Daten zu kuratieren.

Ohne Benutzerfreundlichkeit lässt sich keine vollständige Akzeptanz erzielen. Der Data Lake würde dann zu einem Data Swamp, also Datensumpf, degradiert werden – mit riesigen Mengen an unberührten, undefinierten und unorganisierten Daten, die von den Benutzern nicht vernünftig zu handhaben sind. Data Swamps sind in der Regel ein Symptom für eine schlechte Datenverwaltung und fehlende kontextbezogene Metadaten, die helfen, die Daten zu kuratieren.

Zusätzlich zur Schnittstelle gilt es die zum Unternehmen passende Datenmanagementplattform und die Datenquellen aus den einzelnen Silos im Unternehmen auszuwählen. Viele Cloud-Lösungen stehen als Plattform für den Datenpool zur Verfügung. Auf einen Cloud-Service-Provider zurückzugreifen, ist nach Meinung von Rubrik hinsichtlich der Skalierbarkeit und Kosteneffizienz vorteilhaft im Vergleich zur Alternative, alle Daten vor Ort vorzuhalten.

Bei der Erfassung der maximalen Anzahl von Datenquellen sind mitunter einige Hindernisse zu überwinden. Einige Geschäftseinheiten neigen dazu, Daten zu horten und zurückzuhalten. Deshalb gilt es sicherzustellen, dass alle potenziellen Datenquellen in den Datenpool fließen. Es gibt bewährte Strategien zur Optimierung des Datenmanagements im Unternehmen. Eine nützliche Roadmap bietet Alex Gorelik in seinem E-Book Strategies for Building an Enterprise Data Lake [1]. Gorelik zeigt auf, wie sich die Anzahl der Entscheidungen, die auf der Grundlage von Daten getroffen werden, maximieren lässt, sich Einsparungen erzielen lassen und der tägliche Aufwand für das Datenmanagement um bis zu 60 Prozent reduziert werden kann.

[1] https://pages.rubrik.com/2019.Q3-Content-WP-WW-OReillyDigitalBook-LP.html

68 Artikel zu „Data Lake“

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

Das Potenzial von Machine Learning in einem Data Lake

Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem…

BUSINESS INTELLIGENCE | TOP-THEMA | AUSGABE 3-4-2015

Data Lake statt Data Warehouse – Im Zuhause für Big Data erfolgreich fischen

Daten, so war auf der CeBIT immer mal wieder zu hören, seien doch ein recht dröges Thema. Big Data hingegen, das sei eine spannende Sache. Nicht zuletzt wegen seiner engen Verbindung mit dem Internet der Dinge. Also eine wichtige Zukunftstechnologie. Tatsächlich geht es aber auch bei Big Data um nichts anderes als das Zusammenführen von strukturierten und unstrukturierten Daten beispielsweise aus dem Internet of Things oder Social Media.

NEWS | AUSGABE 11-12-2019 | EFFIZIENZ | LÖSUNGEN | SERVICES

Data Quality: HELM AG modernisiert und zentralisiert Datenhaltung

Dezentral organisierte Unternehmen tun sich oft schwer, Informations- und Datenprozesse schlank, einheitlich und transparent zu organisieren. Die Digitalisierung verstärkt den Erneuerungsdruck. Die global tätige HELM AG hat es mit Hilfe einer Data-Quality-Lösung geschafft, ihre vertrieblichen und kaufmännischen Arbeitsabläufe zu optimieren. Die Software sorgt dafür, dass die neu erstellte zentrale Stammdatenbasis von Dubletten und Inkonsistenzen befreit wird und im Tagesgeschäft dauerhaft »sauber« bleibt.

NEWS | AUSGABE 11-12-2019 | SERVICES | STRATEGIEN

Wissen in Datenbanken entdecken – 5 Mythen rund um Data Mining

Data Mining ist kompliziert, ein vorübergehender Trend, benötigt enormes Fachwissen, erfordert riesige Datenbanken und eignet sich zudem nur für bestimmte Branchen. Alles Vorurteile, die leicht zu revidieren sind.

NEWS | TRENDS 2020 | BUSINESS | TRENDS CLOUD COMPUTING | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | TRENDS SERVICES | FAVORITEN DER REDAKTION | KÜNSTLICHE INTELLIGENZ

Analytics reicht nicht mehr aus: Top-Trends im Big-Data-Umfeld 2020

Wide Data, DataOps, Metadaten-Kataloge, Datenkompetenz und Shazamen sind die wichtigsten Trends im kommenden Jahr. Für 2020 hat der Data-Analyst-Spezialist Qlik folgende fünf Trends im Zusammenhang mit Big Data und Analytics identifiziert: Aus Big Data wird Wide Data Dank skalierbarer Cloud-Lösungen sind in Big-Data-Umgebungen nicht länger die Kapazitätslimits unternehmensinterner IT-Infrastrukturen ein begrenzender Faktor. Die Herausforderung…

NEWS | TRENDS 2020 | BUSINESS INTELLIGENCE

Die Trends für Business Intelligence & Big Data 2020

Welche Trends für Business Intelligence (BI), Data & Analytics werden das Jahr 2020 prägen? Im Interview gibt BARC-Chef-Analyst Dr. Carsten Bange seine Prognosen ab. Außerdem stellt er exklusiv die Ergebnisse des BARC BI Trend Monitor 2020 vor, der 2.650 Anwender von BI-Technologie zu ihren persönlichen Trendthemen befragt hat. Dr. Carsten Bange, Gründer und Geschäftsführer von…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | ONLINE-ARTIKEL | STRATEGIEN

Big Data: Wo die wilden Daten leben

Data Lakes, Data Marts, Data Vaults und Data Warehouses. Worin unterscheiden sich die verschiedenen Ansätze der Dateninfrastruktur? Big Data oder Data Analytics sind einige der größten Herausforderungen für die IT unserer Zeit. Viele Unternehmen befinden sich inmitten einer Umstellung auf eine datengesteuerte Ausrichtung ihrer Organisation und sind auf der Suche nach der dazu passenden Dateninfrastruktur.…

NEWS | BUSINESS PROCESS MANAGEMENT | LÖSUNGEN | SERVICES | AUSGABE 9-10-2019

Von Big Data zu Smart Data – Öl des 21. Jahrhunderts

Wie Lobster aus einer unstrukturierten Datenvielfalt Informationen und Wissen generiert.

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN

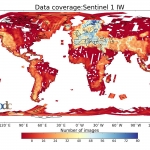

Klimawandel und Big Data: Ein Speichersystem ohne Grenzen für die Erdbeobachtung

Was hat sich durch den Klimawandel auf der Welt verändert? Was bedeutet das für die Menschen? Welche Maßnahmen sind wichtig, um den Klimawandel zu stoppen – oder um zumindest seine Folgen zu bewältigen? Diese Fragen stehen nicht erst seit Greta Thunberg im Fokus des öffentlichen Interesses und werden auch in Zukunft eine zentrale Rolle spielen.…

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Vorsprung durch Wissen – Die Ära von Big Data kommt noch

In zehn Jahren wird man über das was wir heute unter Big Data verstehen nur müde lächeln. Die Datenmengen werden durch das »Allesnetz« in einem unvorstellbaren Ausmaß wachsen. Es gilt den Herausforderungen schon heute zu begegnen.

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | INFRASTRUKTUR | OUTSOURCING | ONLINE-ARTIKEL | SERVICES

6 Gründe für ein Cloud-basiertes Data Warehouse

Ein Data Warehouse, das Daten aus verschiedenen Quellen zusammenfasst, um sie analysieren und darauf reagieren zu können, ist heute entscheidend für den Geschäftserfolg. Denn es verarbeitet schnell die enormen Datenmengen, die sich heute in Unternehmen ansammeln. Darauf basierend können Führungskräfte zuverlässige datenbasierte Entscheidungen treffen. Allerdings halten es fast zwei Drittel der kürzlich befragten Experten für…