foto freepik ki

TNG Technology Consulting als weltweiter Schlüsselspieler für Open-Source-KI-Modelle gelistet.

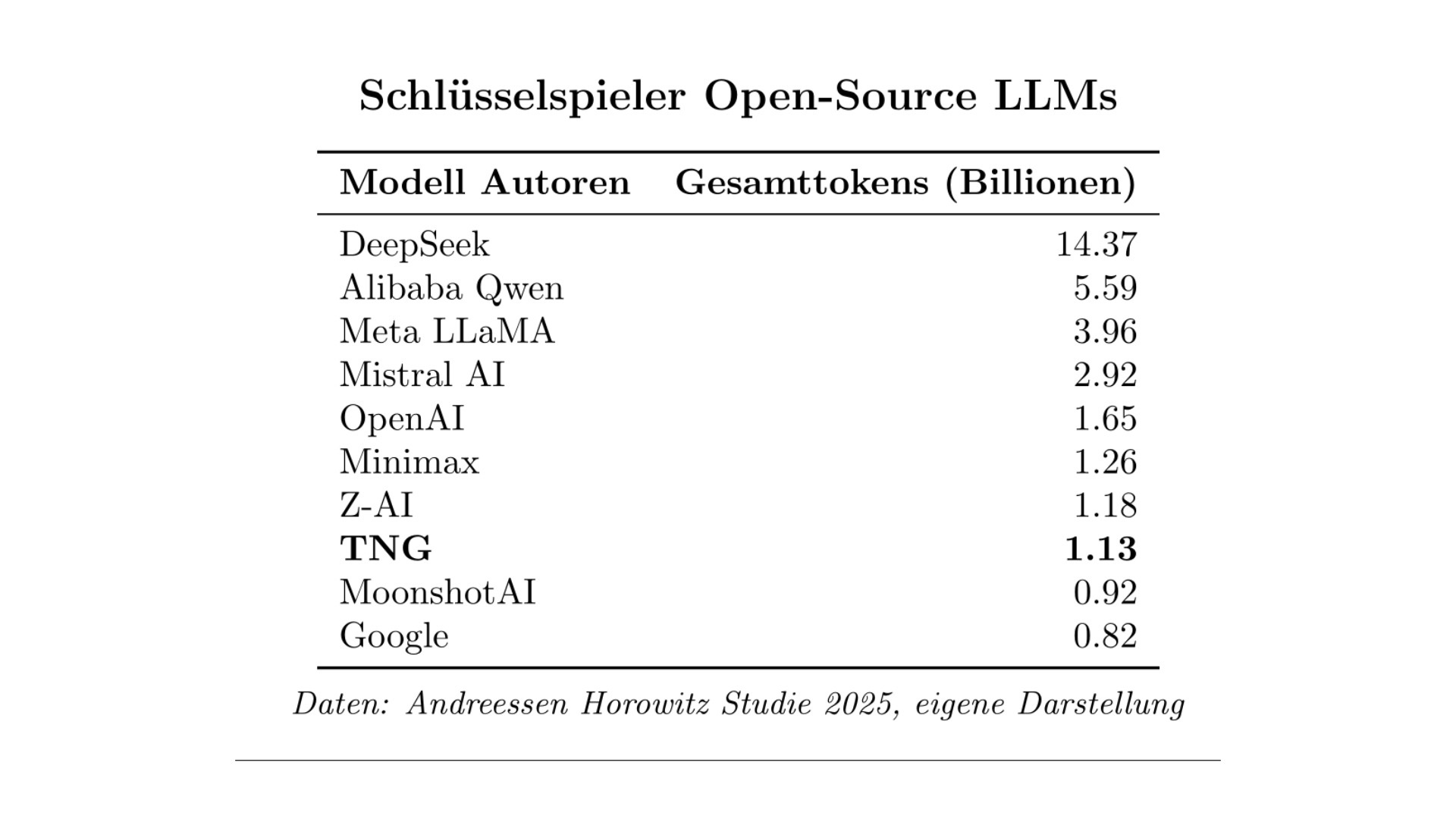

Mit über einer Billion verarbeiteten Tokens gehört das deutsche KI-Unternehmen TNG Technology Consulting zu den zehn bedeutendsten Modellautoren von Open-Source Large Language Modellen (LLMs) auf der weltweiten KI-Plattform OpenRouter. In der von Andreessen Horowitz ermittelten Top-10-Liste ist TNG mit dem achten Platz der einzige deutsche Vertreter.

Das deutsche KI-Unternehmen TNG Technology Consulting aus München erreicht in einer Liste der bedeutendsten Modellautoren von frei verfügbaren LLMs den achten Platz. Zu diesem Schluss kommt eine neue empirische Studie der US-amerikanischen Wagniskapitalfirma Andreessen Horowitz in Zusammenarbeit mit OpenRouter, einer der größten Aggregator-Plattformen für die Nutzung von kommerziellen und Open-Source LLMs [1].

TNG belegt in der Auflistung der Schlüsselspieler für Open-Source LLMs den achten Platz. (© TNG Technology Consulting GmbH)

In der Studie »State of AI – An Empirical 100 Trillion Token Study with OpenRouter« wird das Verhalten von drei Millionen Usern auf OpenRouter analysiert. Als zentrale Metrik für die Platzierung in der Liste dient die Anzahl der verarbeiteten Tokens, also grob die Anzahl der vom Sprachmodell gelesenen und geschriebenen Silben, im Zeitraum von November 2024 bis November 2025. Hier kommt TNG auf einen Wert von 1,13 Billionen und damit einen weltweiten Marktanteil von über 1 % auf OpenRouter. TNG ist das einzige deutsche Unternehmen, das eine Top-10-Platzierung verbuchen kann, und zusammen mit Mistral AI aus Frankreich einer der zwei Vertreter aus Europa. Die übrigen Plätze belegen die drei großen amerikanischen Unternehmen Meta, OpenAI und Google sowie fünf chinesische Firmen, allen voran DeepSeek und Alibaba Qwen.

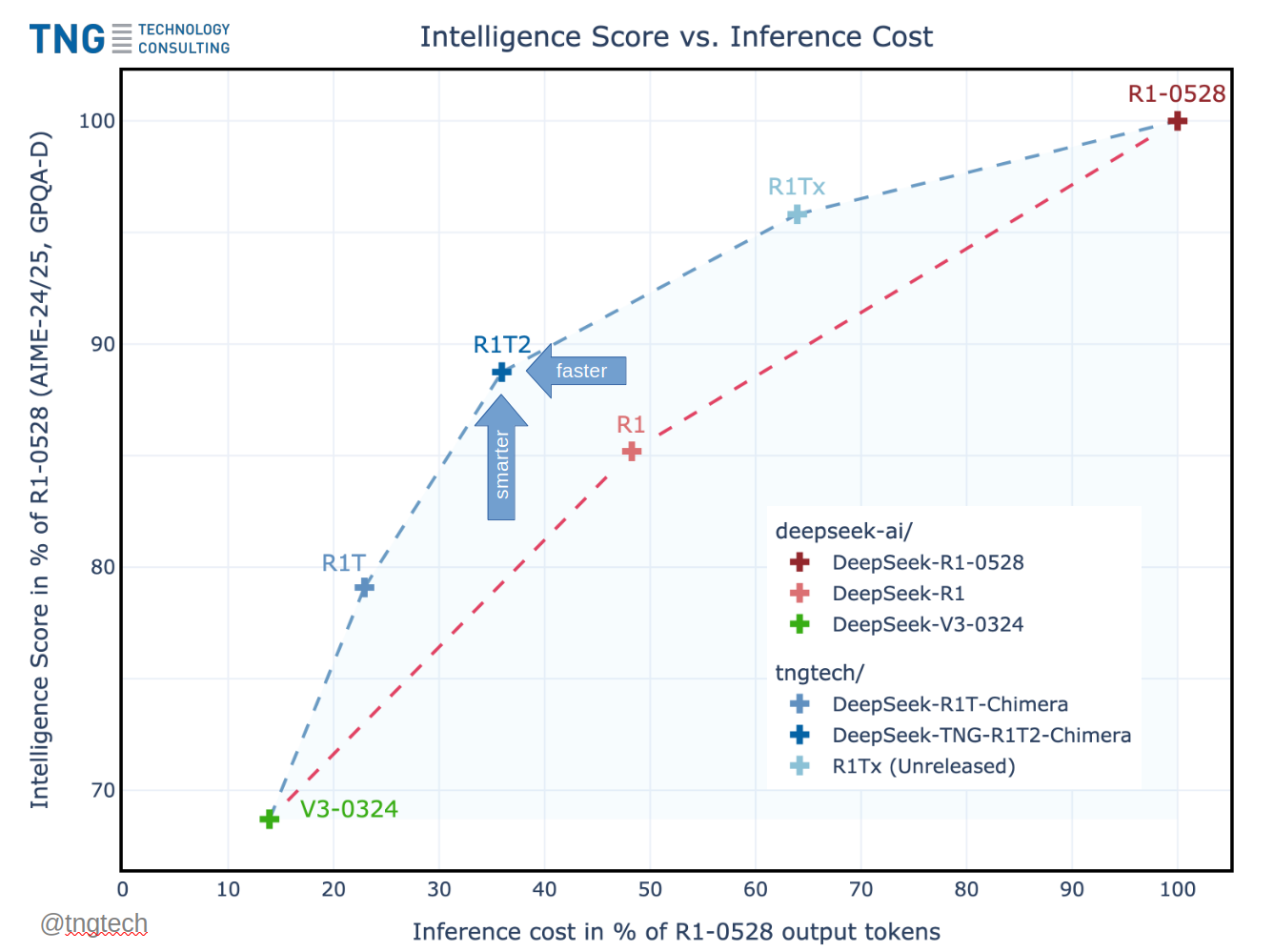

Die Top-10-Platzierung ist auf die hohe weltweite Nutzung der »Chimera«-Modelle von TNG zurückzuführen, die das Unternehmen im April und Juli 2025 veröffentlicht hat. Diese Modelle sind mit der »Assembly of Experts«-Methode gebaut, einer Eigenentwicklung, mit der aus mehreren Basismodellen ein neues Modell mit optimierten Eigenschaften konstruiert werden kann. Insbesondere das Modell »R1T2 Chimera« auf Basis von DeepSeek-Modellen wird in der KI-Community sehr intensiv genutzt [2]. In Summe verarbeiten die Chimera-Modelle aktuell rund 20 Milliarden Tokens pro Tag.

»Dass unsere Innovation zur Erstellung von Sprachmodellen in der weltweiten Nutzung einen Spitzenplatz belegt, ist eine Bestätigung unserer intensiven KI-Forschung und Produktentwicklung. Die internationale Wahrnehmung eilt der Wahrnehmung in Deutschland aktuell noch voraus. Unsere Chimera-Methode stellt auch einen wichtigen Baustein für souveräne KI-Lösungen ›aus Europa für Europa‹ dar, sowohl für Unternehmen als auch für Behörden und Regierungen«, kommentiert Robert Dahlke, Geschäftsführer von TNG und einer der Chimera-Entwickler, die Platzierung. »›China Speed‹, also hart und fokussiert zu arbeiten und einen Wettlauf der Ideen auszurichten, um marktfähige Produkte in hohem Tempo zu konstruieren, geht auch in Deutschland«, ergänzt Henrik Klagges, ebenfalls Chimera-Entwickler und der Kopf hinter der TNG-Vision. »Man muss es nur wollen.«

[1] https://openrouter.ai/state-of-ai

[2] https://huggingface.co/tngtech/DeepSeek-TNG-R1T2-Chimera

Die TNG Technology Consulting GmbH aus München ist eine partnerschaftlich organisierte, wertegetriebene Unternehmensberatung mit dem Fokus auf High-End-Informationstechnik. Besondere Schwerpunkte sind dabei die drei Säulen Agile Softwareentwicklung, Künstliche Intelligenz sowie DevOps & Cloud. Seit 2025 entwickelt und veröffentlicht TNG unter dem Namen »Chimera« eigene, von DeepSeek abgeleitete Open-Source Large Language Modelle mit frei verfügbaren Modellgewichten. Mit über einer Billion verarbeiteten Tokens auf OpenRouter gehört TNG zu den führenden KI-Unternehmen in Europa.

SLMs, LLMs und die Debatte, die am Thema vorbeigeht: Komplexität bewältigen – Klarheit finden

Es wird viel über die Vorteile von SLMs (Small Language Models) diskutiert. Und doch geht die Diskussion oft an der Sache vorbei. Denn es geht nicht um Größe oder Komplexität. Es geht vielmehr darum, wie SLMs konzipiert sind, um Entscheidungen zu treffen und die richtige Balance zu finden zwischen ihrer Spezialisierung und ihrer Fähigkeit zu breiterem, allgemeinem Wissen. Der wahre Wert eines SLM liegt in seiner Fähigkeit, spezialisiertes Wissen und Argumente zu liefern, die dem Generalisten, dem LLM (Large Language Model), helfen, fundierte Entscheidungen zu treffen, zu bestimmen, wann der Experte hinzugezogen werden muss, und das Richtige zu tun.

Wie die meisten Technologien, die sich durchsetzen, haben SLMs ihre Vorteile. Aber sie sind wie Spezialisten: Sie zeichnen sich in bestimmten Bereichen aus, zum Beispiel Recht oder Finanzen. Das ist gleichzeitig das Problem mit den Spezialisten: Sie haben einen engen Fokus, und ihre Definition ändert sich im Laufe der Zeit. Zum Beispiel hat ein SLM, das sich auf zivile Infrastrukturen konzentriert, keinen Einblick in die Verkehrsinfrastruktur oder in die Überschneidungen der beiden Fachgebiete. So wie sich die menschliche Intelligenz weiterentwickelt, müssen sich auch die Spezialgebiete und damit die SLMs verändern. Um effektiv zu bleiben, müssen SLMs wachsen und neue Daten verarbeiten. Nur so können sie unser Verständnis von Intelligenz imitieren.

SLM oder LLM – einfach ein Sprachmodell! Werden SLMs also zu LLMs werden? Wer kann überhaupt sagen, wo ein SLM aufhört und ein LLM beginnt? Da sich die Modelle weiterentwickeln, werden die Grenzen zwischen ihnen verschwimmen. Wir sollten Debatten über die Vorteile vermeiden, die die Größe eines Modells bietet, und sie einfach Sprachmodelle nennen.

Versteht man SLMs als die Experten und LLMs als die Allrounder, wird es interessant: Das LLM ist eher ein »Entscheider« – es kann bestimmen, welche Spezialisierung für eine bestimmte Aufgabe erforderlich ist. Sobald es diese Entscheidung getroffen hat, kann es die entsprechenden SLMs für das bereichsspezifische Fachwissen anzapfen, das benötigt wird, um das Problem zu durchdenken und eine Antwort zu finden. In diesem Sinne leiten LLMs den Prozess, während SLMs das tiefe, spezialisierte Wissen bereitstellen. Man könnte sich sogar ein SLM vorstellen, das darauf spezialisiert ist, zu bestimmen, welche SLMs für eine bestimmte Aufgabe zu Rate gezogen werden sollen.

So wie politische Berater eine Führungskraft anweisen können, Spezialisten auf ihrem jeweiligen Gebiet zu konsultieren, werden diese Modelle zunehmend als Kontrollinstanz fungieren: Sie treffen Entscheidungen, lenken das Gespräch und verweisen an den richtigen Experten für die jeweilige Aufgabe.

Sprachmodelle: Balance zwischen Tiefe und Breite. Allerdings ist es nicht möglich, ein Modell so zu trainieren, dass es alle Bereiche abdeckt. Deshalb gibt es immer einen Kompromiss zwischen Tiefe und Breite. Ein Modell kann entweder tief in einen einzelnen Bereich eintauchen oder ein breiteres Netz über viele Bereiche auswerfen. Aber es gibt immer eine Grenze dafür, wie sehr es sich wirklich spezialisieren kann, ohne sein allgemeines Wissen zu verlieren.

Die eigentliche Herausforderung entsteht, wenn mehrere Bereiche zusammengeführt werden sollen. Je mehr Bereiche einbezogen sind, desto schwieriger wird es, herauszufinden, welches Fachwissen in einer bestimmten Situation benötigt wird. Es ist, als würde man mit zu vielen Bällen jonglieren. Irgendwann wird etwas herunterfallen.

Wenn dann noch das Problem der Analyse-Paralyse hinzukommt, bei der ein Übermaß an Informationen das Weiterkommen verhindert, entsteht ein echter Engpass bei der Entscheidungsfindung. Das ist das Paradoxon der Wahl: Zu viel Wissen kann den Fortschritt behindern.

Wir dürfen nicht vergessen, dass auch ein LLM seine eigenen Grenzen hat. Die Komplexität der Aufgabe bedeutet oft, dass es einen Kompromiss gibt zwischen der Zeit, die sie brauchen, um ein Problem zu durchdenken, und der Zeit, die sie brauchen, um eine Antwort zu geben. Je länger sie zum Nachdenken brauchen, desto langsamer können sie Antworten geben. Das ist so, als würde man von einem Generalisten verlangen, schnell zu sein, aber gleichzeitig erwarten, dass er Stunden braucht, um eine perfekte Lösung zu finden. Und obwohl die Wahrscheinlichkeit, die richtige Antwort zu erhalten, mit der Zeit zunimmt, erreichen Modelle, genau wie Menschen, einen Punkt, an dem der Nutzen abnimmt.

Nützliche Tendenzen bei künstlicher Intelligenz. Bei den SLM gibt es einige klare Einschränkungen, insbesondere was den Zugang zu Wissen und die Fähigkeit zur Bewältigung komplexer, realer Situationen betrifft. Aber man kann von diesen Modellen nicht erwarten, dass sie alles können, und genau wie größere Modelle erben sie oft Tendenzen von den Menschen, die sie trainieren.

Andererseits kann diese Tendenz auch von Vorteil sein: In manchen Fällen ist sie ein Schutzmechanismus. Das lässt sich mit den Grundwerten oder Standardprozeduren vergleichen, die ein Unternehmen braucht, um Ordnung und Konsistenz zu wahren. Ohne diese Leitprinzipien könnte es zu Chaos kommen.

In der künstlichen Intelligenz (KI) sind einige Tendenzen also nützlich. Sie können den Modellen helfen, in ihren spezialisierten Bereichen schnelle, maßgebliche Entscheidungen zu treffen. Problematisch wird es, wenn diese Tendenzen falsch angewandt werden oder zu starr sind und die Anpassungsfähigkeit einschränken. Eine gewisse Voreingenommenheit in einem SLM kann für eine begrenzte, spezialisierte Aufgabe von Vorteil sein. Allerdings muss sichergestellt werden, dass sie nicht zu weit geht und das Modell in seiner Fähigkeit einschränkt, sich weiterzuentwickeln und komplexere Aufgaben zu bewältigen.

Warum die Debatte am Thema vorbeigeht. Die Herausforderungen, Kompromisse zwischen Tiefe und Breite zu finden, die Risiken der Analyse-Unfähigkeit und die Nuancen der Tendenzen weisen alle auf eine wichtige Erkenntnis hin: Bei der Weiterentwicklung dieser Modelle müssen wir uns weniger auf ihre Benennung konzentrieren, sondern mehr auf ihre Fähigkeit, die Komplexität zu bewältigen und fundierte, ausgewogene Entscheidungen zu treffen.

Die eigentliche Frage ist, wie diese Modelle uns helfen können, in einer immer komplexeren Welt Klarheit zu finden.

Steve Mayzak,

Steve Mayzak,

Global Managing Director of Search AI

bei Elastic

Illustration: © Tatyana Karpova | Dreamstime.com

1039 Artikel zu „KI LLM“

Ausgabe 3-4-2025 | News | Healthcare IT | Künstliche Intelligenz | Whitepaper

Healthcare Agents und LLM im Gesundheitswesen – Die nächste Generation der medizinischen KI-Assistenz

Trends 2025 | News | Trends Security | IT-Security | Künstliche Intelligenz

LLM im SOC: 2025 wird das Jahr des Sicherheitsanalysten mit KI-Unterstützung

aDvens, ein unabhängiges Unternehmen für Cybersicherheit in Europa, hat die Nutzung von Large Language Models (LLMs) als einen der wichtigsten Trends im Bereich Security Operations Center (SOC) für das kommende Jahr identifiziert. LLMs sind eine Art der künstlichen Intelligenz (KI), die durch Machine Learning in der Lage sind, Textinhalte zu verstehen und zu generieren. In…

News | IT-Security | Künstliche Intelligenz | Produktmeldung

Tenable stellt AI Aware vor: Eine bahnbrechende Lösung für proaktive Sicherheit von KI und Large Language Models (LLMs)

Tenable, das Unternehmen für Exposure-Management, gab die Veröffentlichung von AI Aware bekannt, einer hochentwickelten Erkennungsfunktion, die schnell feststellen kann, ob Lösungen für künstliche Intelligenz im Einsatz sind und ob KI-bezogene Schwachstellen und Sicherheitsschwächen vorliegen. Die Funktion ist ab sofort in Tenable Vulnerability Management, der weltweit führenden Lösung für Exposure-Management, verfügbar [1]. Tenable AI Aware liefert…

News | Effizienz | IT-Security | Künstliche Intelligenz

Wie Hacker KI und LLMs für ihre Zwecke nutzen

Der Einsatz von KI kann Routineaufgaben automatisieren, Abläufe effizienter gestalten und die Produktivität erhöhen. Dies gilt für die legale Wirtschaft ebenso wie leider auch für die organisierte Cyberkriminalität. Gerade Large Language Models (LLM) werden von kriminellen Akteuren genutzt – weniger als visionäre Alleskönner-Technologien, sondern vielmehr als effiziente Werkzeuge zum Verbessern von Standardangriffen. Seit Ende…

News | Künstliche Intelligenz | Strategien

Die Grenzen der LLM: Wegweisende KI-Technologie ist kein Alleskönner

Large Language Models (LLMs) sind voll im Trend. Ob privat oder in Unternehmen, auf LLMs basierende Chatbots wie beispielsweise ChatGPT von OpenAI generieren mit Deep-Learning-Modellen Texte in menschenähnlicher Weise. Auf Basis von massiven Mengen von Textdaten trainiert, können sie so auf viele Fragen Antworten liefern und Befehle ausführen. Unternehmensentscheider prüfen momentan, welche Vorteile diese Sprachmodelle für ihre Organisation haben und wie man…

News | Künstliche Intelligenz | Rechenzentrum | Services

TrustLLM: Die europäische KI-Alternative

In Europa entsteht ein Large Languange Model, das zuverlässiger, offener, transparenter und energiesparender sein soll als ChatGPT. Der Schlüssel dazu ist Europas größter Computer, der derzeit in Jülich gebaut wird. Seit das amerikanische Unternehmen OpenAI im November 2022 die Sprachmaschine ChatGPT zugänglich machte, geht das Thema durch die Decke. Können jetzt Personaler ihre Zeugnisse,…

News | Digitalisierung | Effizienz | Künstliche Intelligenz | Strategien

Souveräne KI soll Effizienz steigern, Fachkräfte entlasten und Digitalisierung beschleunigen

KI-Offensive für den Bund: Materna, ITZBund und NVIDIA starten Pilotprojekt für Softwareentwicklung. Die Digitalisierung der öffentlichen Verwaltung in Deutschland nimmt weiter Fahrt auf: Das Informationstechnikzentrum Bund (ITZBund) erprobt gemeinsam mit dem Dortmunder IT-Dienstleister Materna den Einsatz von künstlicher Intelligenz (KI) zur Unterstützung in der Softwareentwicklung. Grundlage ist dabei KIPITZ, das KI-Portal des ITZBund, kombiniert…

Ausgabe 5-6-2025 | News | Business | Geschäftsprozesse | Künstliche Intelligenz

Künstliche Intelligenz zur Bearbeitung von Kernprozessen – Wo Prozesse digital sind, kann KI glänzen

Dass aussagekräftige Daten einen zentralen Erfolgsfaktor moderner KI-Szenarien darstellen, ist hinreichend bekannt. Dass jedoch auch die digitale Abbildung von Prozessabläufen eine unerlässliche Grundlage bildet, weniger. Der ERP-Spezialist Asseco Solutions beschäftigt sich seit Jahren mit sinnvollen Nutzungsmöglichkeiten der intelligenten Technologie im Geschäftskontext. Warum die Zukunft der KI in der Digitalisierung der Kernprozesse liegt und wie Unternehmen die Basis für eine erfolgreiche Umsetzung schaffen, erklärt CEO und CTO Markus Haller.

News | Künstliche Intelligenz | Tipps

Welches LLM ist das richtige? Fünf Tipps für die Suche

Generative KI schickt sich an, die Prozesse und Arbeitsmethoden von Behörden und Unternehmen zu revolutionieren. Eine Herausforderung bleibt jedoch die Wahl des richtigen Large Language Model (LLM), denn es gibt viele Faktoren zu beachten – etwa die Modellgröße, die Sprachunterstützung sowie die Kosten und die Sicherheit. Ein KI- und Enterprise-Search-Spezialist zeigt, wie Organisationen aller Art…

Trends 2025 | News | Digitalisierung | Trends Services | Healthcare IT | Künstliche Intelligenz

KI-Einsatz trotz veralteter IT-Systeme hemmt die Modernisierung des Gesundheitswesens

97 Prozent der IT-Entscheidungsträger in Deutschland berichten von Legacy-Technologien in ihren Organisationen. Die Nutzung zukunftsweisender Technologien, allen voran künstlicher Intelligenz (KI), ist im Gesundheitswesen weltweit auf dem Vormarsch. Doch wie der aktuelle Healthcare-Report »Digitale Zwickmühle im Gesundheitswesen: Zwischen Innovationsdruck und Systemrisiken« von SOTI zeigt, haben 96 Prozent der IT-Führungskräfte in Deutschland (weltweit 97 Prozent)…

Trends 2025 | News | Trends Services | Healthcare IT | Künstliche Intelligenz | Whitepaper

Datensilos bremsen den Einsatz von KI im Gesundheitswesen aus

Trotz des enormen Potenzials von künstlicher Intelligenz im Gesundheitswesen befinden sich viele Einrichtungen noch in der Anfangsphase der Umsetzung. Eine aktuelle internationale Studie von SS&C Blue Prism zeigt [1]: 94 Prozent der befragten Organisationen betrachten AI zwar als strategisch wichtig – doch mangelnde Datenqualität und fragmentierte Dateninfrastrukturen behindern den effektiven Einsatz. Strukturelle Defizite trotz…

Trends 2025 | News | Trends Wirtschaft | Business | Digitale Transformation | Favoriten der Redaktion | Künstliche Intelligenz | Services | Whitepaper

Das KI-Potenzial ist riesig – es muss nur erschlossen werden

Deutschland befindet sich bei der Entwicklung künstlicher Intelligenz (KI) an einem entscheidenden Punkt. Die Bundesregierung hat sich zum Ziel gesetzt, weltweit führend in der verantwortungsvollen Entwicklung und Einführung von KI zu werden. Deutsche Unternehmen sind schon heute eine treibende Kraft in der EU. Die allgemeine Akzeptanzrate von KI in deutschen Unternehmen von 53 % übertrifft…

Trends 2025 | News | Business | Künstliche Intelligenz | Services | Whitepaper

Trotz Herausforderungen sehen KMU positive Effekte durch KI

Sage-Studie zeigt: Deutscher Mittelstand führt Europa bei KI-Adoption an. Deutschlands kleine und mittelständische Unternehmen (KMU) treiben die Einführung künstlicher Intelligenz (KI) erfolgreich voran. Dies bestätigt die aktuelle Studie »KI-(R)Evolution: Wie deutsche KMU von Künstlicher Intelligenz profitieren« von Sage, die den Reifegrad von KI in deutschen KMU beleuchtet [1]. Die Studie belegt, dass bereits 29…

Trends 2025 | News | Trends Kommunikation | Künstliche Intelligenz

Zwischen KI-Strategie und Personalrealität klafft die Lücke

63 % der deutschen Führungskräfte sehen ihre Belegschaft nicht bereit für KI Fachkräftemangel und Akzeptanzprobleme bremsen KI-Nutzung KI-Pacesetter setzen auf Change Management, Vertrauen und gezielte Kompetenzentwicklung Der erste People Readiness Report von Kyndryl offenbart eine eklatante Lücke zwischen Anspruch und Wirklichkeit beim Einsatz von künstlicher Intelligenz: Unternehmen nutzen zwar bereits durchgängig KI, doch ist…

News | Trends 2023 | Whitepaper

Künstliche Intelligenz: China führend bei KI-Patenten – mit Abstand

China hat bei Patenten im Bereich Künstliche Intelligenz den Rest der Welt hinter sich gelassen. Im Jahr 2023 wurden hier rund 70 Prozent aller weltweiten Patente erteilt. 2013 lag der Anteil Chinas nur bei rund 20 Prozent. Der Anteil der in den USA erteilten Patente ist von rund 43 Prozent im Jahr 2015 auf 14,2…

News | Blockchain | Digitalisierung | Favoriten der Redaktion | Künstliche Intelligenz | Strategien

Deutschland im KI-Wettlauf: Chancen nutzen, Risiken minimieren, Infrastrukturen bereitstellen

Künstliche Intelligenz (KI) ist die Schlüsseltechnologie für Innovationen, Effizienz und Wettbewerbsfähigkeit. Wie können deutsche Unternehmen die Chancen von KI nutzen, mutig voranschreiten und bestehende Hürden bei der breiten Umsetzung überwinden? Auf dem 14. Frankfurter Symposium für Digitale Infrastruktur am 22.05.2025 in der Union Halle wurden diese Themen gerade diskutiert und konkrete Handlungsempfehlungen erarbeitet. Dabei standen…

Trends 2025 | News | Trends Security | Cloud Computing | IT-Security | Künstliche Intelligenz

KI zwingt Abstriche in Sachen Hybrid-Cloud-Sicherheit zu machen

KI verursacht größeres Netzwerkdatenvolumen und -komplexität und folglich auch das Risiko. Zudem gefährden Kompromisse die Sicherheit der hybriden Cloud-Infrastruktur, weshalb deutsche Sicherheits- und IT-Entscheider ihre Strategie überdenken und sich zunehmend von der Public Cloud entfernen. Gleichzeitig gewinnt die Netzwerksichtbarkeit weiter an Bedeutung. 63 Prozent der deutschen Sicherheits- und IT-Entscheider berichten, dass sie im Laufe…

News | Business | Digitalisierung | Favoriten der Redaktion | Künstliche Intelligenz | Strategien | Whitepaper

Strategie: Wie Deutschland zum KI-Hotspot werden kann

Bitkom legt 10-Punkte-Vorschlag zu Einsatz und Entwicklung von künstlicher Intelligenz vor. Wintergerst: »Bei künstlicher Intelligenz muss die Zeit des Abwartens vorbei sein«. Bei künstlicher Intelligenz muss Deutschland gleich zu Beginn der neuen Legislaturperiode den Schalter umlegen und sich als internationaler KI-Standort etablieren. Dafür hat der Digitalverband Bitkom jetzt einen konkreten Fahrplan mit zehn Empfehlungen…

Trends 2025 | News | Digitalisierung | Trends Services | Künstliche Intelligenz

Führungskräfte setzen auf KI – doch die Umsetzung bereitet große Schwierigkeiten

Laut einer Umfrage von Gartner sehen 77 % der Führungskräfte im Ingenieurwesen die Integration von KI in Anwendungen zur Verbesserung von Features und Funktionen als eine erhebliche oder zumindest mittlere Herausforderung. Auch der Einsatz von KI-Tools zur Erweiterung von Softwareentwicklungs-Workflows wird von 71 % der Befragten als schwierig eingestuft – damit stellt dieser Aspekt die…