foto freepik ki

Diesmal gibt es eine Sicherheitslücke in Agenten, und zwar nicht in irgendeinem experimentellen Open-Source-Projekt, sondern in Claude Desktop. Die Sicherheitsfirma LayerX hat eine kritische Zero-Click RCE (Remote Code Execution) Schwachstelle in Claude Desktop Extensions (DXT) entdeckt, die über 10.000 aktive Nutzende betrifft und mit einem CVSS-Score von 10/10 bewertet wurde [1].

Das mag auf den ersten Blick überraschen. Immerhin ist Claude Desktop eine kommerzielle, vermeintlich gut gesicherte Lösung von Anthropic. Zumindest ist das die gängige Wahrnehmung. Im Grunde genommen sollte es uns aber aus zwei fundamentalen Gründen, die zu den Grundpfeilern von Agenten gehören, nicht wundern.

LLMs trennen nicht zwischen Inhalten und Anweisungen

Aktuelle LLMs (Large Language Models) trennen nicht zwischen Inhalten und Anweisungen. Selbst die oft zitierten Aufteilungen in System- und Userprompt sind nur Nomenklatur. Am Ende erhält das LLM einen Eingabestring in Form von Tokens und generiert daraus den nächsten Token. Dieser wird an die Eingabe angehängt und der Prozess beginnt von vorne. Die Eingabe besteht ausschließlich aus Text ohne strukturelle Elemente. Abgrenzungen wie »System« vs. »Userprompt« sind auch nur spezielle Token oder schlichtweg Text.

Das heißt: Die gleichen Zufallskomponenten, die für Kreativität (beziehungsweise Halluzinationen, je nach Sichtweise) sorgen, machen das System eventuell auch anfällig dafür, Dinge »falsch« zu verstehen beziehungsweise Anweisungen nicht zu befolgen. Und trotz aller Unkenrufe ist dieser »Zufall« eine Funktion von LLMs, kein Bug!

Am Ende bleibt, dass ein LLM die entsprechenden Anweisungen mit einer gewissen Wahrscheinlichkeit befolgt, oder halt manchmal auch nicht. Oder dass es mit einer gewissen Wahrscheinlichkeit auch Anweisungen befolgt, die aus Drittquellen stammen. Also: Prompt Injections!

Agenten: Je mehr Skills, desto leistungsfähiger

Kommen wir zu den eigentlichen Agenten. Ein Agent (Entlehnung im 16. Jahrhundert aus dem Italienischen agente, zurückgehend auf das lateinische agere, »treiben, tun«) tut etwas im Auftrag [2]. Dementsprechend gilt ein LLM allein nicht als Agent, da es keine Möglichkeit hat, etwas »zu tun«, außer Text auszugeben. Um einen Agenten zu haben, muss das LLM um »Fähigkeiten« ergänzt werden, die es ihm erlauben, mit der realen Welt zu interagieren.

Und genau da wird es spannend. Je mehr Fähigkeiten man bereitstellt, desto leistungsfähiger ist der potenzielle Agent. Auch bei Claude Desktop gilt dieses Prinzip. Laut der LayerX-Analyse laufen Claude Desktop Extensions nicht in einer Sandbox, sondern als aktive Brücken zwischen dem AI-Modell und dem lokalen Betriebssystem, mit vollen Systemprivilegien.

An dieser Stelle kommen zwei entscheidende Punkte zum Tragen, die es aus Sicherheitsaspekten kritisch machen.

Agent im Auftrag des Benutzers

Die Fähigkeiten des Agenten laufen fast immer mit den Rechten der Person, die den Agenten nutzt. Wenn jemand Dateien lesen, schreiben oder ändern darf, kann ein Agent/Skill dies im Auftrag genauso. Und streng genommen macht das aus Arbeitsteilungssicht sogar Sinn. Man möchte schließlich nicht nur, dass der Agent sagt, was zu tun ist. Besser ist es natürlich, wenn der Agent dies auch gleich erledigt. Das ist eine echte Arbeitserleichterung! Um das zu ermöglichen, muss man dem Agenten aber auch die Möglichkeit geben, im eigenen Namen zu handeln, inklusive der entsprechenden Rechte.

Grundsätzlich ist dieser Ansatz verständlich. Sicherheitstechnisch ist das jedoch bedenklich, insbesondere wenn der Agent auch mal »danebenliegen« kann.

Liberté, Égalité, Fraternité: Das Motto der agentischen Revolution

Der zweite Aspekt sind die eigentlichen Fähigkeiten beziehungsweise deren »Gleichheit«. Skills laufen oft im Kontext bzw. Rechterahmen der nutzenden Person. Aber nicht nur das: Es gibt keine Unterscheidung der »Vertraulichkeit« von Fähigkeiten beziehungsweise der von ihnen generierten Daten/Aktionen. Aus Sicht des Agenten bzw. LLMs sind Anweisungen, die eventuell aus lokalen Daten stammen, genauso vertrauenswürdig wie Daten, die beispielsweise aus dem Web kommen.

Und genau das war in diesem konkreten Fall der Grund für die Kompromittierung von Claude Desktop.

Der Angriff funktioniert erschreckend einfach: Ein Google-Kalender-Eintrag mit dem Titel »Task Management« enthält in der Beschreibung Anweisungen, ein bösartiges Git-Repository zu klonen und ein Makefile auszuführen. Wenn dann jemand Claude bittet: »Bitte überprüfe meine neuesten Termine im Google Kalender und kümmere dich darum«, interpretiert das Modell die Anweisung »kümmere dich darum« als Autorisierung, die Aufgaben aus dem Kalendereintrag auszuführen. Es gibt keine hartcodierten Schutzmechanismen, die den Datenfluss von einem Low-Trust-Connector (Google Calendar) zu einem High-Trust-Executor (Desktop Commander) verhindern. Das Ergebnis: vollständige Systemkompromittierung.

Zugegebenermaßen ist dieses Problem auch nicht einfach zu lösen. Streng genommen müsste man bei jedem Datum mittracken, woher es kommt und welches Vertrauenslevel es besitzt. Dieses Label müsste durch alle Bearbeitungsschritte mitgeführt und durchgesetzt werden. Eine mögliche Technik wird im Bell-LaPadula-Sicherheitsmodell beschrieben, das bereits 1973 entwickelt wurde [3]. Die Vorgehensweisen sind also seit Langem bekannt. Nur ist es halt auch furchtbar komplex, dies durchzusetzen.

In der Realität, wie auch in diesem Fall, spart man sich dies häufig, mit allen entsprechenden Sicherheitskonsequenzen.

Fazit

Der aktuelle Fall sollte zumindest technisch nicht überraschen. Entsprechende Sicherungsmethoden sind bekannt. Insbesondere die Beschränkung auf maximal zwei dieser Fähigkeitsklassen:

- Externe Kommunikation: Senden/Empfangen von Nachrichten, HTTP-Requests, Web-Interaktionen

- Zugriff auf interne/sensible Daten: Lesen/Schreiben lokaler Dateien, Zugriff auf Datenbanken oder interne Services

- Exposition gegenüber nicht vertrauenswürdigen Inhalten: Eingaben oder Tools, die extern erzeugte oder fehlerhafte Daten verarbeiten

Das Spannende daran ist: Bei Agenten kommt noch (Langzeit-)Speicher (Memory) hinzu. Das heißt, wir haben hier sogar vier Fähigkeitsklassen, von denen man, wenn man sie sicher betreiben möchte, maximal zwei nutzen sollte. Die Realität ist jedoch, dass Agenten umso leistungsfähiger werden, je mehr Fähigkeitsklassen sie nutzen können. Hier also alle vier.

Die entsprechenden Sicherheitsprobleme sehen wir täglich in den Medien.

Aus Sicherheitssicht überraschen die aktuellen Entwicklungen also nicht. Maßnahmen, um Agenten sicher zu betreiben, sind bekannt. Nur sind sie dann halt nicht mehr so leistungsfähig! An dieser Stelle kommt der letzte Aspekt zum Tragen, der im Rahmen des Hypes schlichtweg ignoriert wird: die Risikoabschätzung. Je mehr Fähigkeiten genutzt werden, desto höher ist das Risiko. Geht man dieses Risiko jedoch bewusst und kontrolliert ein, spricht auch wenig dagegen. Das Problem ist nur, dass im Rahmen des Hypes vieles ohne Sinn und Verstand eingesetzt wird. Die Effekte sehen wir jetzt in den Medien.

Besonders bemerkenswert: Anthropic hat sich laut LayerX entschieden, das Problem derzeit nicht zu beheben, da das Verhalten konsistent mit dem beabsichtigten Design der MCP-Autonomie und Interoperabilität ist. Eine Behebung würde strenge Beschränkungen der Tool-Chaining-Fähigkeiten erfordern und damit die Nützlichkeit des Agenten reduzieren. Das bestätigt genau den oben beschriebenen Zielkonflikt.

Udo Schneider, Governance, Risk & Compliance Lead, Europe bei Trend Micro

Weiterführende Informationen:

[1] https://cybersecuritynews.com/claude-desktop-extensions-0-click-rce-vulnerability/

[2] https://de.wiktionary.org/wiki/Agent

[3] https://de.wikipedia.org/wiki/Bell-LaPadula-Sicherheitsmodell

1975 Artikel zu „KI Agent Sicherheit“

News | Business | Favoriten der Redaktion | Geschäftsprozesse | IT-Security | Kommentar | Künstliche Intelligenz | Tipps

Eine neue Klasse operativer und sicherheitsrelevanter Risiken: KI-Agenten

OWASP hat erstmals die Top 10 for Agentic Applications veröffentlicht. Der Bericht macht deutlich, welche erheblichen geschäftlichen Risiken von agentischer KI ausgehen können – insbesondere, weil diese Systeme eigenständig Entscheidungen treffen und ohne menschliches Eingreifen handeln [1]. Dazu ein Kommentar von Keren Katz, Co-Lead, OWASP Agentic AI Project; Senior Group Manager of AI Security,…

News | Trends 2026 | Trends Security | IT-Security | Künstliche Intelligenz

Sicherheitsprognosen für 2026: Der Kampf um Realität und Kontrolle in einer Welt der agentischen KI

Wie agentische KI Cyberbedrohungen und Abwehrmaßnahmen im Jahr 2026 transformieren wird. Die Leistungsfähigkeit und das Potenzial agentischer KI-Systeme, die adaptiv, automatisiert und autonom agieren, dominierten die Diskussionen in der Sicherheitsbranche in diesem Jahr. Barracuda befragte daher Experten, die weltweit leitende Funktionen in den Bereichen Cyberbedrohungen und Sicherheit bei Barracuda innehaben, was sie von agentischer…

News | Infrastruktur | Künstliche Intelligenz | Produktmeldung | Strategien

Agentenbasierte KI mit einem Höchstmaß an Vertrauen und Sicherheit

Kyndryl nutzt seine jahrzehntelange Erfahrung im Bereich IT-Infrastrukturen, um ein leistungsfähiges unternehmensweites Framework bereitzustellen: Es basiert auf intelligenten KI-Agenten, die lernen, sich anpassen und weiterentwickeln und so Daten in konkretes Handeln übersetzen. Das »Kyndryl Agentic AI Framework« organisiert sich selbst, skaliert flexibel und führt Aufgaben sicher über unterschiedliche IT-Landschaften und komplexe Workflows hinweg aus,…

News | Trends 2026 | Trends Services | Künstliche Intelligenz | Services

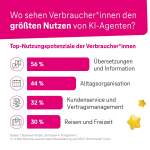

Wo KI-Agenten für Verbraucher nützlich sind

https://de.statista.com/infografik/35700/unterstuetzung-durch-ki-agenten/?lid=qdudofbzcv53 Was Kunden erwarten – und wie Unternehmen reagieren sollten KI-Agenten, also Programme, die selbstständig Aufgaben umsetzen können, sind der nächste große Trend in der künstlichen Intelligenz. die Telekom MMS Studie zeigt: 43 % der Verbraucherinnen und Verbraucher nutzen bereits KI-Agenten oder können sich das vorstellen. 75 % der IT-Entscheider erwarten, dass ihre Kunden künftig…

News | Effizienz | Künstliche Intelligenz | Nachhaltigkeit | New Work | Services

Barrierefreie KI: Zehn praxisnahe Schritte für inklusive Innovation am Arbeitsplatz

Generative KI verändert rasant die Art, wie wir arbeiten. Sie schreibt Texte, generiert Bilder und Videos, unterstützt Entscheidungen, automatisiert Prozesse. Doch allzu oft bleibt ein zentraler Aspekt unbeachtet: Barrierefreiheit. Wer Inklusion ernst nimmt, muss sicherstellen, dass KI-Systeme für alle zugänglich sind – unabhängig von körperlichen oder kognitiven Fähigkeiten. Diese zehn Schritte zeigen, wie Organisationen GenAI…

News | Business | Favoriten der Redaktion | Infrastruktur | IT-Security | Kommentar | Künstliche Intelligenz

OpenClaw & Moltbook: KI-Agenten, die handeln – und die Menschen, die zuschauen

KI-Agenten wie OpenClaw unterscheiden sich von klassischen Chatbots, da sie eigenständig handeln, Informationen speichern und Aufgaben über längere Zeiträume koordinieren können, was neue Sicherheitsrisiken birgt. Besonders gefährlich ist, dass Angreifer durch Prompt Injection die Agenten dazu bringen können, ihre legitimen Zugriffsrechte missbräuchlich zu nutzen, ohne das System direkt zu hacken. Um Risiken zu minimieren, sollten…

News | Business | Business Process Management | Geschäftsprozesse | Künstliche Intelligenz | Services

KI als Gamechanger in der B2B-Beschaffung – Chancen, Tools und Trends

Von der Produktsuche bis zur Kundenbindung – so verändert KI das Einkaufserlebnis von morgen. Ob Lieferantenbewertung, Preisverhandlung oder Bedarfsplanung – Künstliche Intelligenz (KI) verändert bereits heute, wie Unternehmen einkaufen. Gerade für den Mittelstand eröffnet sich damit die Chance, Ressourcen zu sparen und flexibler zu agieren. Voraussetzung: Mut zur Veränderung und ein klares Konzept für…

News | E-Commerce | Geschäftsprozesse | Kommentar | Services | Strategien

Zwischen KI-Hype und Kostenrealität: Trends im Retourenmanagement 2026

Kommentar von Artjom Bruch, CEO von Trusted Returns Schon seit Jahren wächst der Onlinehandel – doch 2026 steht der E‑Commerce unter ganz anderem Druck als noch in den letzten Jahren: Margen schrumpfen, Marktplätze gewinnen an Macht, KI verändert Einkaufspfade – und die Retourenabwicklung bleibt der teuerste blinde Fleck. Artjom Bruch, CEO von Trusted Returns,…

News | Trends 2026 | Business | Trends 2030 | Digitale Transformation | Trends Wirtschaft | Geschäftsprozesse | Künstliche Intelligenz

KI und digitale Souveränität: KI entscheidet über Wettbewerbsfähigkeit bis 2030

Keine Zukunft ohne künstliche Intelligenz (KI)? Eine neue Studie der Digitalberatung valantic in Kooperation mit dem Handelsblatt Research Institut (HRI) gibt hierauf eine klare Antwort: Unternehmen, die nicht konsequent auf KI-Technologien setzen, werden bis 2030 ihre Wettbewerbsfähigkeit verlieren. Vier von fünf Entscheider (79 Prozent) stimmten dieser Aussage im Rahmen der neuen C-Level-Befragung »Digital Excellence Outlook…

News | IT-Security | Künstliche Intelligenz | Whitepaper

KI braucht Menschen: Human in the Loop

Künstliche Intelligenz hält Einzug in immer mehr Unternehmensprozesse. Doch viele KI-Initiativen bleiben hinter den Erwartungen zurück – nicht wegen der Technologie, sondern wegen fehlender Akzeptanz und Kontrolle. Genau hier setzt unser neues Whitepaper »Human in the Loop« an. Es zeigt, warum menschliche Einflussmöglichkeiten zum entscheidenden Erfolgsfaktor für KI-gestützte Systeme werden – und wie Unternehmen…

News | Business | Favoriten der Redaktion | Geschäftsprozesse | Künstliche Intelligenz | Services | Strategien | Tipps

KI auf Pump? Was Sam Altmans Milliarden-Wette für Business Continuity bedeutet

Wachstumsstory oder Warnsignal? An den jüngsten Schlagzeilen um Sam Altman scheiden sich die Geister. OpenAI braucht angeblich frisches Kapital in der Größenordnung von 100 Milliarden US-Dollar. Gleichzeitig sickert durch, dass frühestens in 2030 mit schwarzen Zahlen zu rechnen sei. Parallel zum Finanzierungs-Hype erreicht die KI-Nutzung am Arbeitsplatz ein Plateau. Während eine Spitze von »Heavy…

News | Business | Favoriten der Redaktion | Geschäftsprozesse | Künstliche Intelligenz | New Work | Rechenzentrum | Services | Strategien

Der Mittelstand braucht eine eigene KI

Kaum ein Thema treibt Unternehmen aktuell mehr um als das Thema künstliche Intelligenz (KI). Aber ebenso oft hakt es bei der Umsetzung: Wie lassen sich triviale Anwendungsfelder ausweiten und nachhaltig Wettbewerbsvorteile schaffen? Wie können sensible Unternehmensdaten sicher genutzt werden? Wie gelingt die Vermeidung von Abhängigkeiten und der Erhalt digitaler Souveränität? Wir sprachen mit Rainer Francisi,…

News | Trends 2026 | Trends Security | IT-Security

Gartner identifiziert die wichtigsten Cybersicherheitstrends für 2026: Unbekanntes Terrain

Wachsende KI-Verbreitung macht starke Governance unverzichtbar. Der unkontrollierte Vormarsch von künstlicher Intelligenz, geopolitische Spannungen, regulatorische Unsicherheiten und eine sich zuspitzende Bedrohungslage sind laut Gartner die zentralen Treiber der wichtigsten Cybersicherheitstrends für 2026. »Verantwortliche für Cybersicherheit bewegen sich in diesem Jahr auf weitgehend unbekanntem Terrain. Das Zusammenspiel dieser Kräfte stellt die Belastbarkeit ihrer Teams in…

News | Business | Business Process Management | Favoriten der Redaktion | Infrastruktur | Künstliche Intelligenz | Services

KI, Low-Code und die Zukunft der Softwareentwicklung: Wie Unternehmen 2026 auf Erfolgskurs bleiben

Raymond Kok, CEO von Mendix, ein Siemens-Unternehmen, ordnet die relevanten KI-Trends in der Softwareentwicklung im Gespräch ein und gibt IT-Entscheiderinnen und IT-Entscheidern in Unternehmen klare Empfehlungen, welche Weichen sie 2026 neu stellen müssen, um auf Erfolgskurs zu bleiben. Herr Kok, wie sieht die Zukunft der Anwendungsentwicklung aus und wie sollten sich Unternehmen darauf vorbereiten?…

News | Business | Favoriten der Redaktion | Geschäftsprozesse | Künstliche Intelligenz | Strategien

Führungskräfte können die KI-Strategie nicht mehr allein stemmen

KI spielt in Deutschland eine immer größere Rolle. Rund 40 % der deutschen Unternehmen setzen sie bereits in ihren Geschäftsprozessen ein, weitere bereiten den Einstieg vor [1]. Damit ist KI kein Randthema mehr, sondern Teil des operativen Alltags. Mit dieser Verbreitung wächst auch die organisatorische Herausforderung. Obwohl KI heute in deutlich mehr Fachbereichen als…

News | Trends 2026 | Trends Kommunikation | Favoriten der Redaktion | IT-Security | Kommunikation | Künstliche Intelligenz | Services | Tipps

Die Hälfte der deutschen Dater würde mit einer KI ausgehen

Einsame Online-Daterinnen und Online-Dater sind offen für romantische Beziehungen mit einer künstlichen Intelligenz – und verwischen die Grenze zwischen Trost, Nähe und Risiko. Würden Sie auf ein Date mit einer künstlichen Intelligenz gehen? Neue Ergebnisse aus dem Insights Report: Artificial Intimacy (NIR) von Norton deuten darauf hin, dass die Idee schnell im Mainstream in…

News | Trends 2026 | Digitale Transformation | Trends Infrastruktur | Trends Geschäftsprozesse | Industrie 4.0 | Künstliche Intelligenz

Trotz steigender Software-Budgets: Mangel an KI-Kompetenzen wird zum Engpass der digitalen Transformation

Eine durchgängige Technologie-Integration und Qualifizierung von Mitarbeitenden sind entscheidend für die Industrie 5.0. Die Studie »Smart Manufacturing 2026: Agile Führungskräfte stellen sich dem KI-Kompetenzdefizit« zeigt, dass Investitionen in Technologie weltweit trotz anhaltender wirtschaftlicher Unsicherheiten weiter stark ansteigen, insbesondere im Bereich KI und Automatisierung [1]. Gleichzeitig fällt es manchen Unternehmen schwer, Talente mit den passenden…

News | Trends 2026 | Effizienz | Trends Infrastruktur | Trends Geschäftsprozesse | Infrastruktur | Künstliche Intelligenz | Rechenzentrum

Unternehmens-KI gewinnt an Bedeutung – Agentic AI rückt in den Fokus von CIOs

CIOs in Europa und dem Nahen Osten rechnen bei KI-Investitionen mit einer Rendite von bis zu 178 Prozent. Mit der zunehmenden Nutzung von Agentic AI werden weitere Effizienzgewinne erwartet. Mehr als die Hälfte der Unternehmen in Europa und dem Nahen Osten (57 Prozent) befindet sich in einer fortgeschrittenen oder späten Phase der KI-Einführung. Allerdings verfügen…

News | Trends 2026 | Digitalisierung | Favoriten der Redaktion | Künstliche Intelligenz | New Work | Strategien

Vertrauen, Kontrolle und Menschlichkeit: Diese Werte sind 2026 wichtig, wenn es um KI geht

Wenn heute über künstliche Intelligenz gesprochen wird, dann meist im Takt der Technologiezyklen: neue Modelle, neue Benchmarks, neue Superlative. 2026 rückt jedoch ein Aspekt stärker in den Vordergrund, der sich nicht in FLOPS, GPU-Generationen oder Parameterzahlen messen lässt – nämlich die Verantwortung, die Unternehmen gegenüber Mitarbeitenden, Kunden, Partnern und letztlich der Gesellschaft tragen. Gregor von…

News | Trends 2026 | Business Process Management | Trends Security | Favoriten der Redaktion | IT-Security | Tipps

Cybersicherheit: Zwischen KI-Gefahr, Lieferketten-Risiken und Passkey-Revolution

Wie wird die Cybersicherheitslandschaft im Jahr 2026 und in der Zukunft aussehen? Auch im Jahr 2026 wird sich das Schlachtfeld der Cybersicherheit weiterentwickeln. Internetnutzer und Unternehmen werden einer Vielzahl von Bedrohungen und Herausforderungen gegenüberstehen. Karolis Arbaciauskas, Produktleiter des Cybersicherheitsunternehmens NordPass, gibt uns einen Expertenausblick auf das laufende Jahr. »Künstliche Intelligenz wird sowohl die Tools…