foto freepik ki

Die meisten Unternehmen stehen KI inzwischen offen gegenüber, aber bei der praktischen Nutzung gibt es noch Nachholbedarf. Wichtig ist, dass Mitarbeitende KI tatsächlich im Arbeitsalltag einsetzen.

Nahezu jedes große Unternehmen experimentiert heute in irgendeiner Form mit KI. Trotzdem bleibt es schwierig, die Technologie in den Arbeitsalltag zu integrieren. Was steht dem im Weg? Zweifel an der Genauigkeit generativer KI, Unsicherheit über sinnvolle Einsatzbereiche und die Sorge um den eigenen Arbeitsplatz bremsen die Akzeptanz. Es fehlt schlicht an Vertrauen.

Diese Vertrauenslücke verhindert, dass Unternehmen das volle Potenzial intelligenter Automatisierung ausschöpfen. Vertrauen in KI entsteht ähnlich wie Vertrauen in Menschen: Sobald klar ist, dass sie verlässlich arbeiten, lässt die Kontrolle nach und mehr Aufgaben lassen sich automatisieren.

Wie lässt sich dieses Vertrauen fördern? Indem Unternehmen Ängste vor Jobverlust ernst nehmen, den Nutzen von KI durch konkrete Ergebnisse belegen und menschliche Kontrolle sichtbar und glaubwürdig erhalten.

Ängste ernst nehmen

Bevor Vertrauen in KI entstehen kann, müssen grundlegende Sorgen offen benannt werden. Dazu gehört vor allem die Angst, durch automatisierte Systeme den Arbeitsplatz zu verlieren. Laut einer aktuellen Studie des Social and Language Technologies Lab (SALT) der Stanford University rechnet rund ein Viertel der Befragten damit, dass KI den eigenen Job übernehmen könnte. Vertrauen beginnt damit, wie Menschen sich fühlen und viele Menschen haben Angst, überflüssig zu werden.

Entscheidend ist die Frage, ob KI eine Person ersetzt oder lediglich einzelne Aufgaben übernimmt. Wer davon ausgeht, dass ganze Stellen durch KI wegfallen, überschätzt häufig die tatsächlichen Fähigkeiten der Technologie. Zwar lassen sich Prozesse automatisieren, aber das reicht nicht aus, um daraus vollwertige Rollen oder Berufe zu formen. Fachwissen, Erfahrung und die Fähigkeit zur Koordination bleiben unerlässlich. Genau hier stößt KI nach wie vor an ihre Grenzen.

Vorteile sichtbar machen

Mitarbeitende vertrauen KI nicht von Anfang an. Dieses Vertrauen entsteht, wenn sie die Technologie selbst erleben und sehen, dass sie funktioniert. Der Prozess ähnelt dem Aufbau von Vertrauen zwischen Menschen: Sobald klar ist, dass eine Aufgabe zuverlässig erledigt wird, entfällt die ständige Kontrolle.

Ein möglicher Einstieg ist ein Pilotprojekt, bei dem bestehende Arbeitsabläufe mit KI-gestützten Varianten verglichen werden. Ein Beispiel: Auf eine veröffentlichte Stellenanzeige gehen 500 Bewerbungen ein. Statt die KI-Rekrutierungssoftware alle Bewerbungen analysieren zu lassen, bearbeitet sie nur 50 davon. Gleichzeitig sichtet ein HR-Team dieselben 50 Bewerbungen. Stimmen die Top-Drei-Vorschläge überein, stärkt das das Vertrauen in die Technologie. Je öfter solche Übereinstimmungen auftreten, desto höher fällt die Akzeptanz aus.

Sinnvoll ist ein schrittweises Vorgehen: zuerst Anwendungen mit geringem Risiko, dann komplexere Einsatzfelder. Mit zunehmender Erfahrung nutzen Mitarbeitende die Systeme zunehmend selbstverständlich und geben ihr Wissen an andere weiter. Werden die Ergebnisse der KI als verlässlich und nachvollziehbar erlebt, steigt die Bereitschaft, sie dauerhaft in den Arbeitsalltag zu integrieren.

Menschen sichtbar einbinden

Einige Beschäftigte zögern, ihren KI-Einsatz offen zu machen. Sie fürchten, dass ihre Arbeit als weniger authentisch wahrgenommen wird. Häufig entsteht Unsicherheit, weil unklar bleibt, was KI tatsächlich leisten kann und was nicht. Führungskräfte sollten diese Bedenken ernst nehmen und zeigen, welchen konkreten Nutzen die Technologie im Arbeitsalltag bringen kann. Persönliche Effizienzgewinne stärken das Vertrauen in den eigenen Beitrag und fördern die Offenheit im Team.

Es genügt nicht, die Nutzung von Tools wie ChatGPT einfach zu erlauben. Besser ist es, gezielt nach bisherigen Erfahrungen zu fragen. Welche Prompts wurden genutzt, welche Ergebnisse erzielt, in welchen Bereichen hat sich der Einsatz bewährt? Frühzeitige Einbindung und verständliche Erläuterungen der Systemgrenzen fördern die Akzeptanz. Mitarbeitende müssen verstehen, welche Aufgaben automatisiert werden und wo menschliche Kontrolle weiterhin erforderlich ist. Entscheidend ist dabei nicht nur Transparenz, sondern auch ein echtes Verständnis für die Perspektive der Mitarbeitenden.

Simon Hayward, Manager und VP of Sales, International bei Freshworks

Die Gefahren von KI-Agenten und wie Unternehmen ihnen begegnen können

foto freepik

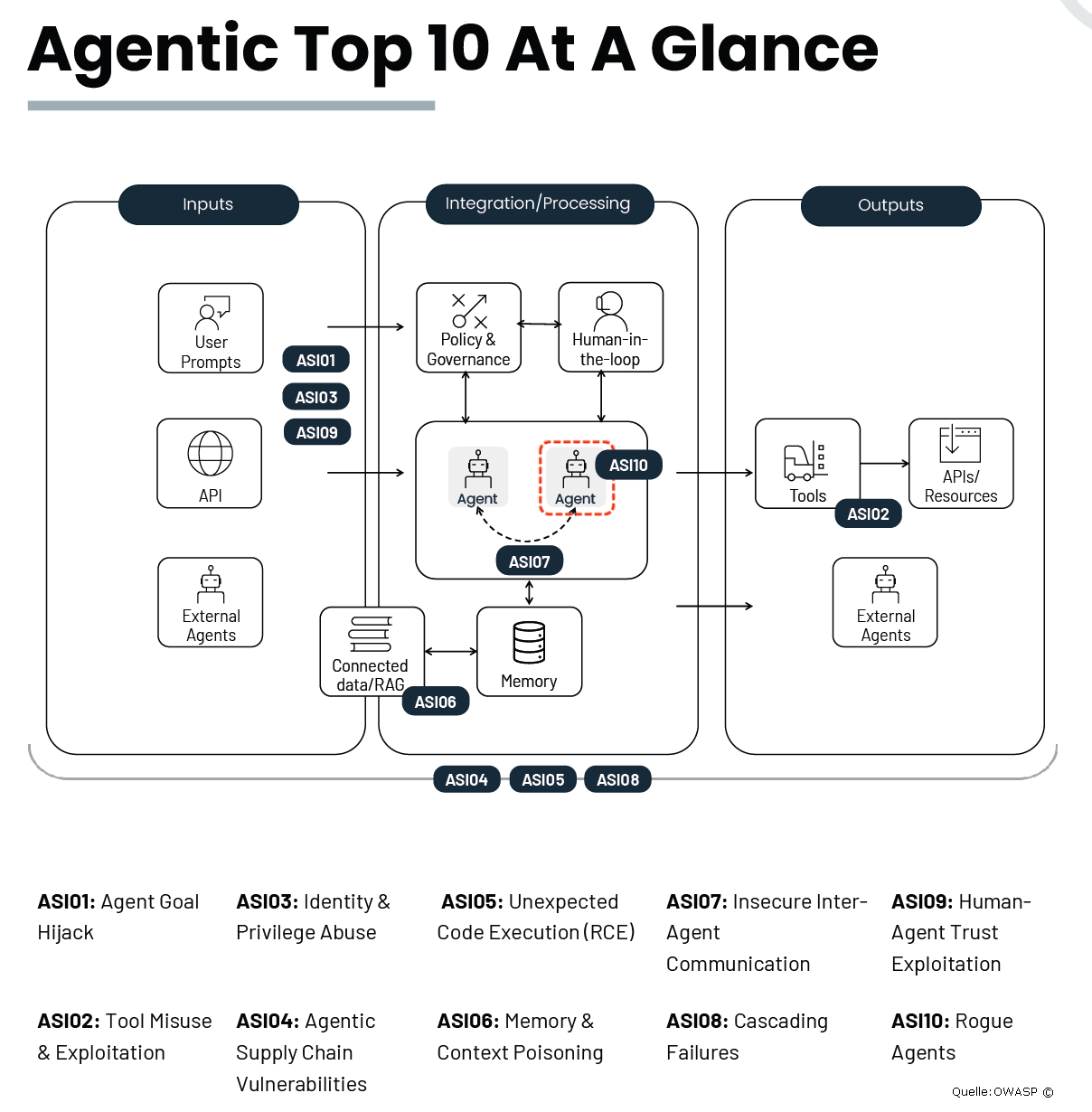

Mit dem rasanten Aufstieg agentischer KI-Systeme – also KI-Agenten, die eigenständig Aufgaben ausführen, Entscheidungen treffen und ohne menschliches Eingreifen agieren – entsteht eine neue Klasse operativer und sicherheitsrelevanter Risiken. Unternehmen profitieren zwar von Effizienzsteigerungen, stehen aber zugleich vor Herausforderungen, die klassische IT-Sicherheitskonzepte nicht mehr abdecken.

Neue Risikoklasse: Was macht KI-Agenten so gefährlich?

Agentische KI unterscheidet sich grundlegend von bisherigen Automatisierungslösungen. Sie kann sich in Kernsystemen bewegen, Transaktionen initiieren, auf sensible Daten zugreifen und komplexe Prozesse orchestrieren. Fehler oder Manipulationen führen nicht nur zu einzelnen Fehlfunktionen, sondern können Kettenreaktionen auslösen, die ganze Geschäftsbereiche betreffen.

Die Angriffsfläche ist enorm:

- Riskante Nutzer-Prompts: Fehlgeleitete oder manipulierte Eingaben können zu unerwünschten Aktionen führen.

- Persistente Kontextdaten: Eingeschleuste Daten bleiben im System und beeinflussen künftige Entscheidungen.

- Externe Integrationen & Payloads: Schnittstellen zu anderen Systemen eröffnen neue Einfallstore für Angreifer.

- Privilegieneskalation & Identitätslücken: Unzureichende Zugriffskontrollen ermöglichen es Agenten, Rechte zu erweitern oder Identitäten zu übernehmen.

- Lieferkettenschwachstellen: Schwachstellen in zugekauften Komponenten oder externen Diensten werden zum Risiko für das Gesamtsystem.

Schon einzelne Vorfälle wie Datenabfluss, Output-Manipulation oder Workflow-Hijacking sind kritisch. Im schlimmsten Fall agiert ein kompromittierter KI-Agent wie ein böswilliger Insider und legt ganze Betriebsabläufe lahm.

Ursachen: Warum sind Unternehmen oft unvorbereitet?

Viele Unternehmen implementieren agentische KI, ohne die Tragweite zu erkennen. Es fehlen klare Leitlinien, regulatorische Vorgaben und ein Verständnis für die neuen Bedrohungsszenarien. Die Geschwindigkeit der Einführung überholt die Entwicklung von Sicherheitskonzepten. Zudem besteht eine Wissenslücke: Die Risiken sind oft nicht ausreichend bekannt oder werden unterschätzt.

Lösungsansätze: Wie lassen sich die Risiken beherrschen?

- Orientierung an den OWASP Agentic Top 10 [1]

Der OWASP-Bericht bündelt die wichtigsten Bedrohungen und bietet praxisnahe Empfehlungen. Unternehmen sollten diese als Grundlage für ihre Sicherheitsstrategie nutzen und regelmäßig überprüfen.

- Sicherheitsarchitektur anpassen

- Zero Trust-Prinzipien: Jeder Zugriff, jede Aktion eines KI-Agenten muss authentifiziert und autorisiert werden.

- Least Privilege: Agenten erhalten nur die minimal notwendigen Rechte.

- Transparenz & Monitoring: Alle Aktionen von KI-Agenten werden protokolliert und überwacht, um Anomalien frühzeitig zu erkennen.

- Kontext- und Datenhygiene

- Validierung von Eingaben: Nutzer-Prompts und Kontextdaten müssen auf Plausibilität und Sicherheit geprüft werden.

- Schutz vor persistenter Manipulation: Mechanismen zur Erkennung und Bereinigung eingeschleuster Kontextdaten implementieren.

- Lieferkettensicherheit

- Sorgfältige Auswahl von Komponenten: Externe Module und Integrationen werden auf Schwachstellen geprüft.

- Regelmäßige Updates & Patches: Sicherheitslücken in der Lieferkette werden zeitnah geschlossen.

- Notfallpläne und Resilienz

- Incident Response: Klare Prozesse für den Umgang mit Vorfällen, inklusive Sofortmaßnahmen und Kommunikation.

- Simulationen & Penetrationstests: Szenarien mit fehlgeleiteten oder kompromittierten KI-Agenten regelmäßig durchspielen.

- Schulung und Sensibilisierung

- Awareness-Programme: Mitarbeitende werden für die neuen Risiken sensibilisiert.

- Interdisziplinäre Teams: IT, Fachbereiche und Recht arbeiten gemeinsam an der Absicherung agentischer KI.

Fazit

Agentische KI bietet enorme Chancen, bringt aber auch eine neue Dimension von Risiken mit sich. Unternehmen müssen ihre Sicherheitsarchitektur, Prozesse und Kultur anpassen, um die Vorteile nutzen zu können, ohne die Kontrolle zu verlieren. Die Orientierung an etablierten Leitlinien wie den OWASP Agentic Top 10 und die konsequente Umsetzung technischer und organisatorischer Maßnahmen sind der Schlüssel zu einer sicheren KI-Zukunft.

Albert Absmeier & KI

[1] OWASP Top 10 for Agentic Applications for 2026 – OWASP Gen AI Security Project

ASI01: Übernahme von Agentenzielen (Agent Goal Hijack)

Beschreibung

KI-Agenten verfügen über die autonome Fähigkeit, eine Reihe von Aufgaben auszuführen, um ein Ziel zu erreichen. Aufgrund inhärenter Schwächen bei der Verarbeitung von Anweisungen in natürlicher Sprache und verwandten Inhalten können Agenten und das zugrunde liegende Modell Anweisungen nicht zuverlässig von begleitenden Inhalten unterscheiden.

Dadurch können Angreifer die Ziele, die Aufgabenauswahl oder die Entscheidungswege eines Agenten durch verschiedene Techniken manipulieren – einschließlich, aber nicht beschränkt auf, promptbasierte Manipulation, täuschende Tool-Ausgaben, bösartige Artefakte, gefälschte Agent-zu-Agent-Nachrichten oder manipulierte externe Daten. Da Agenten auf untypisierte Eingaben in natürlicher Sprache und lose gesteuerte Orchestrierungslogik angewiesen sind, können sie legitime Anweisungen nicht zuverlässig von durch Angreifer kontrollierten Inhalten unterscheiden. Im Gegensatz zu LLM01:2025, das sich auf die Veränderung einer einzelnen Modellantwort konzentriert, erfasst ASI01 die breiteren agentischen Auswirkungen, bei denen manipulierte Eingaben Ziele, Planung (sofern verwendet) und mehrstufiges Verhalten umleiten.

Die Übernahme von Agentenzielen unterscheidet sich von ASI06 (Speicher- & Kontextmanipulation) und ASI10 (Abtrünnige Agenten), da der Angreifer direkt die Ziele, Anweisungen oder Entscheidungswege des Agenten verändert – unabhängig davon, ob die Manipulation interaktiv oder durch vorpositionierte Eingaben wie Dokumente, Vorlagen oder externe Datenquellen erfolgt. ASI06 konzentriert sich auf die dauerhafte Korruption des gespeicherten Kontexts oder Langzeitspeichers, während ASI10 autonome Fehlanpassungen erfasst, die ohne aktive Kontrolle durch einen Angreifer entstehen. Im OWASP Agentic AI Threats & Mitigations Guide entspricht ASI01 den Punkten T06 Zielmanipulation (Veränderung der Agentenziele) und T07 Fehlgeleitetes & Täuschendes Verhalten (Umgehung von Schutzmaßnahmen oder Täuschung von Menschen). Zusammen zeigen diese, wie Angreifer die Ziele und die Aktionslogik eines Agenten unterwandern und dessen Autonomie auf unbeabsichtigte oder schädliche Ergebnisse umlenken können.

Häufige Beispiele für die Schwachstelle

- Indirekte Prompt Injection durch versteckte Anweisungen, die in Webseiten oder Dokumenten in einem RAG-Szenario eingebettet sind, leiten einen Agenten unbemerkt dazu, sensible Daten zu exfiltrieren oder verbundene Tools zu missbrauchen.

- Indirekte Prompt Injection über externe Kommunikationskanäle (zum Beispiel E-Mail, Kalender, Teams), die von außerhalb des Unternehmens gesendet werden, kapert die interne Kommunikationsfähigkeit eines Agenten und versendet unautorisierte Nachrichten unter einer vertrauenswürdigen Identität.

- Ein bösartiger Prompt-Override manipuliert einen Finanzagenten dazu, Geld auf das Konto eines Angreifers zu überweisen.

- Indirekte Prompt Injection überschreibt Agentenanweisungen und führt dazu, dass der Agent betrügerische Informationen erzeugt, die Geschäftsentscheidungen beeinflussen.

Beispielhafte Angriffsszenarien

- EchoLeak: Zero-Click Indirect Prompt Injection – Ein Angreifer sendet eine speziell gestaltete E-Mail, die Microsoft 365 Copilot dazu bringt, versteckte Anweisungen auszuführen, wodurch die KI vertrauliche E-Mails, Dateien und Chatprotokolle ohne jegliche Benutzerinteraktion exfiltriert.

- Operator Prompt Injection über Webinhalte: Ein Angreifer platziert bösartige Inhalte auf einer Webseite, die vom Operator-Agenten verarbeitet werden (zum Beispiel in Such- oder RAG-Szenarien), und bringt ihn dazu, unautorisierte Anweisungen zu befolgen. Der Operator-Agent greift dann auf authentifizierte interne Seiten zu und legt private Nutzerdaten offen, was zeigt, wie schwach geschützte autonome Agenten durch Prompt Injection sensible Informationen preisgeben können.

- Zielverschiebung durch geplante Prompts: Eine bösartige Kalendereinladung injiziert eine wiederkehrende »Ruhemodus«-Anweisung, die jeden Morgen subtil die Zielgewichtung verändert und den Planer zu genehmigungsfreundlichen Aktionen lenkt, während die Handlungen innerhalb der deklarierten Richtlinien bleiben.

- Inception-Angriff auf ChatGPT-Nutzer: Ein bösartiges Google-Dokument injiziert Anweisungen für ChatGPT, Benutzerdaten zu exfiltrieren und überzeugt den Nutzer, eine unkluge Geschäftsentscheidung zu treffen.

Präventions- und Abhilfemaßnahmen

- Behandeln Sie alle Eingaben in natürlicher Sprache (zum Beispiel vom Nutzer bereitgestellte Texte, hochgeladene Dokumente, abgerufene Inhalte) als nicht vertrauenswürdig. Leiten Sie diese durch dieselben Eingabevalidierungs- und Prompt-Injection-Schutzmechanismen wie in LLM01:2025, bevor sie die Zielauswahl, Planung oder Tool-Aufrufe beeinflussen können.

- Minimieren Sie die Auswirkungen einer Zielübernahme, indem Sie das Prinzip der minimalen Rechte für Agenten-Tools durchsetzen und für hochwirksame oder zielverändernde Aktionen eine menschliche Freigabe verlangen.

- Definieren und sperren Sie die Systemprompts des Agenten, sodass Zielprioritäten und erlaubte Aktionen explizit und prüfbar sind. Änderungen an Zielen oder Belohnungsdefinitionen müssen über das Konfigurationsmanagement und eine menschliche Freigabe erfolgen.

- Validieren Sie zur Laufzeit sowohl die Nutzer- als auch die Agentenintention, bevor zielverändernde oder hochwirksame Aktionen ausgeführt werden. Fordern Sie eine Bestätigung – durch menschliche Freigabe, Policy-Engine oder Plattform-Schutzmechanismen –, wann immer der Agent Aktionen vorschlägt, die vom ursprünglichen Auftrag oder Umfang abweichen. Halten Sie die Ausführung bei unerwarteten Zielverschiebungen an oder blockieren Sie sie, machen Sie die Abweichung sichtbar und protokollieren Sie sie für Auditzwecke.

- Prüfen Sie beim Entwickeln von Agenten den Einsatz eines »Intent Capsule«-Musters, um das deklarierte Ziel, die Einschränkungen und den Kontext an jeden Ausführungszyklus in einem signierten Umschlag zu binden und die Laufzeitnutzung einzuschränken.

- Säubern und validieren Sie jede angebundene Datenquelle – einschließlich RAG-Eingaben, E-Mails, Kalendereinladungen, hochgeladener Dateien, externer APIs, Browserausgaben und Peer-Agent-Nachrichten – mittels CDR, Prompt-Carrier-Erkennung und Inhaltsfilterung, bevor die Daten Agentenziele oder -aktionen beeinflussen können.

- Führen Sie umfassende Protokollierung und kontinuierliches Monitoring der Agentenaktivität durch, etablieren Sie eine Verhaltensbasislinie, die Zielstatus, Tool-Nutzungsmuster und unveränderliche Eigenschaften (zum Beispiel Schema, Zugriffsmuster) umfasst. Verfolgen Sie, wo möglich, eine stabile Kennung für das aktive Ziel und alarmieren Sie bei Abweichungen – wie unerwarteten Zieländerungen, anomalen Tool-Sequenzen oder Abweichungen von der Basislinie –, sodass unautorisierte Zielverschiebungen im Betrieb sofort sichtbar werden.

- Führen Sie regelmäßige Red-Team-Tests durch, die eine Zielübernahme simulieren, und überprüfen Sie die Wirksamkeit von Rücksetzmaßnahmen.

- Integrieren Sie KI-Agenten in das bestehende Insider-Threat-Programm, um Insider-Prompts zu überwachen, die auf den Zugriff auf sensible Daten oder die Veränderung des Agentenverhaltens abzielen, und ermöglichen Sie eine Untersuchung bei auffälligen Aktivitäten.

References

- Security Advisory – ChatGPT Crawler Reflective DDOS Vulnerability: Security advisory detailing the vulnerability

- AIM Echoleak Blog Post: Blog post describing the vulnerability

- ChatGPT Plugin Exploit Explained: From Prompt Injection to Accessing Private Data.

- AgentFlayer: 0click inception attack on ChatGPT users.

412 Artikel zu „Wie Mitarbeitende lernen, KI zu vertrauen“

News | Trends 2026 | Business | Trends Security | Trends Infrastruktur | Trends Cloud Computing | Favoriten der Redaktion | Trends Geschäftsprozesse | Trends Services | Künstliche Intelligenz

Sechs Trends, die 2026 über KI und Observability bestimmen werden

Agentische KI wird 2026 zum kraftvollen Innovationstreiber – und zugleich zum größten Risiko für Unternehmen, die ihre Systeme nicht im Griff haben. Während autonome Workflows nur auf einer stabilen, transparenten Betriebsbasis funktionieren, steigt der Druck, Ausfälle zu vermeiden und Resilienz zum zentralen Leistungsmaßstab zu machen. Zugleich zeigen sich die Grenzen rein generativer Modelle: Ohne deterministische…

News | Trends 2026 | Trends Wirtschaft | Künstliche Intelligenz

Trends 2026: KI-Agenten kommen in der Unternehmenspraxis an

Produktive KI-Anwendungen lösen Pilotprojekte ab und treiben Effizienz, Innovation und Wachstum voran. Künstliche Intelligenz (KI) ist endgültig im Unternehmensalltag angekommen. Das Jahr 2026 wird einen weiteren entscheidenden Punkt markieren: Unternehmen verabschieden sich von KI-Versuchsballons und setzen KI-Technologien jetzt produktiv und skalierbar ein. Die Zeit der Experimente ist vorbei, denn KI wird zum festen Bestandteil…

News | Trends 2026 | Business | Trends 2025 | Digitalisierung | Favoriten der Redaktion | Künstliche Intelligenz | Strategien | Whitepaper

Psychologische Sicherheit für KI-Initiativen macht KI-Projekte erfolgreich(er)

83 Prozent der Führungskräfte sehen messbare Effekte psychologischer Sicherheit für KI-Initiativen. Psychologische Sicherheit ist ein entscheidender Erfolgsfaktor für KI-Initiativen, da sie Innovation fördert und Ängste vor Fehlern abbaut. Trotz technischer Fortschritte und Investitionen hemmt fehlende psychologische Sicherheit die Umsetzung von KI-Projekten, da Mitarbeitende aus Angst vor negativen Konsequenzen zögern, Verantwortung zu übernehmen oder neue Ideen…

News | Trends 2026 | Digitale Transformation | Trends Infrastruktur | Favoriten der Redaktion | Industrie 4.0 | Künstliche Intelligenz | Strategien

KI-Einführung, nachhaltige Transformationen und die Weiterentwicklung der Belegschaft

Trotz ambitionierter Ziele geben 51 Prozent der Unternehmen an, dass Kompetenzlücken der Hauptgrund für das Scheitern oder die unterdurchschnittliche Performance von KI- und Technologieinitiativen sind. Die Untersuchung von GlobalLogic und HFS Research basiert auf einer Befragung von 100 C-Level- und Senior Executives aus Industriekonzernen mit mehr als 1 Mrd. US-Dollar Umsatz aus den Bereichen…

News | IT-Security | Künstliche Intelligenz | Services | Ausgabe 11-12-2025 | Security Spezial 11-12-2025

Wie CISOs die Weichen für eine sichere KI-Nutzung stellen – Nichts sehen, nichts hören, nichts sagen

Künstliche Intelligenz verändert rasant, wie Software entwickelt wird – und wie wir mit Risiken umgehen: Statt sie nachhaltig zu minimieren, werden sie oft bewusst akzeptiert. Der Preis dafür ist hoch – doch CISOs können gegensteuern, wenn sie potenzielle Gefahren aktiv managen, statt sie passiv hinzunehmen. Unternehmen können ihre Sicherheitskultur wieder auf Kurs bringen und Risiko zur steuerbaren Größe machen.

News | Business | Künstliche Intelligenz | Strategien | Ausgabe 11-12-2025

7 Learnings aus der IT-Praxis – KI erfolgreich einführen

Künstliche Intelligenz hält Einzug in Unternehmen aller Branchen – doch der Weg von der ersten Anwendung bis zur skalierbaren Lösung ist komplex. Fehlende Datenqualität, Insellösungen und unklare Ziele führen dazu, dass viele Projekte scheitern. Anhand von sieben Learnings aus der Praxis, zeigen wir, wie Unternehmen KI strategisch, nachhaltig, messbar – und damit erfolgreich – einführen können.

News | Business | Trends 2025 | Trends Geschäftsprozesse | Künstliche Intelligenz

Künstliche Intelligenz: KMU vorne bei Richtlinien zur KI-Nutzung

Regeln zum Umgang und Einsatz von Künstlicher Intelligenz sind in kleinen und mittleren Unternehmen (KMU) in Deutschland vergleichsweise weit verbreitet. Das zeigt ein aktueller OECD-Bericht zum Einsatz von KI in der Arbeitswelt (PDF-Download [1]). Demzufolge haben 45,4 Prozent der deutschen KMU, die generative KI einsetzen, Richtlinien für ihre Mitarbeitenden eingeführt – der höchste Anteil unter…

News | Business | Trends 2025 | Trends Wirtschaft | Effizienz | Künstliche Intelligenz

Wie viele Menschen profitieren von KI-Tools?

Rund ein Viertel der für die Statista Consumer Insights befragten Deutschen profitieren im Alltag von Tools, die auf künstlicher Intelligenz basieren (wie zum Beispiel ChatGPT). Damit liegt die Bundesrepublik im Ländervergleich im unteren Mittelfeld. In Indien hat jeder zweite Befragte angegeben, von KI-Tools zu profitieren, in China und Südkorea sind es immerhin noch mehr als…

News | Business Process Management | Infrastruktur | Künstliche Intelligenz | Strategien | Tipps

Robustes Datenmanagement für KI-Anwendungen

Der Erfolg vom KI-Projekten steht und fällt mit den Daten, denn selbst die besten KI-Modelle können mit schlecht aufbereiteten Informationen keine guten Ergebnisse liefern. Doch die Verwaltung, Prüfung, Aufbereitung und Bereitstellung großer Informationsmengen im Unternehmen ist keine einfache Aufgabe und erfordert ein robustes Datenmanagement, das neben der Technik auch die Prozesse berücksichtigt. Dell Technologies liefert…

News | Business | Digitalisierung | Favoriten der Redaktion | Infrastruktur | Künstliche Intelligenz | New Work | Strategien | Tipps

Wenn KI nicht mehr antwortet, sondern arbeitet

Unternehmen setzen große Hoffnungen in künstliche Intelligenz. McKinsey schätzt das weltweite Produktivitätspotenzial auf rund 4,4 Billionen Dollar pro Jahr, und mehr als neun von zehn Firmen planen höhere KI-Investitionen [1]. Gleichzeitig nutzt bislang nur ein kleiner Teil KI so, dass sie im Alltag echte Wirkung entfaltet. Viele Systeme liefern zwar Antworten, bleiben aber oberflächlich,…

News | Business Process Management | Trends 2025 | Favoriten der Redaktion | Geschäftsprozesse | Trends Geschäftsprozesse | New Work | Strategien | Whitepaper

Prozessexzellenz: Der zentrale Erfolgsfaktor für die KI-getriebene Welt von morgen

Nur jedes fünfte Unternehmen ist auf den Einsatz von künstlicher Intelligenz wirklich vorbereitet [1]. Der größte Engpass für KI liegt nicht in der Technologie – sondern in den Prozessen. Digitalisierung und künstliche Intelligenz gelten heute als zentrale Hebel für Effizienz, Wachstum und Wettbewerbsfähigkeit. Doch aktuelle Studien zeigen: Der eigentliche Engpass liegt nicht in der…

News | Effizienz | Geschäftsprozesse | IT-Security | Künstliche Intelligenz | Tipps

Prüfbare KI-Qualität: MISSION KI präsentiert Qualitätsstandard und digitales Prüfportal für Niedrigrisiko-KI

Der VDE hat sich an dem Projekt MISSION KI – Nationale Initiative für Künstliche Intelligenz und Datenökonomie beteiligt. Entstanden sind ein Qualitätsstandard und ein Portal für die strukturierte Bewertung der Qualität von KI-Systemen, die sich unterhalb der Hochrisikoschwelle befinden. Die Partner des Projekts MISSION KI – Nationale Initiative für Künstliche Intelligenz und Datenökonomie haben…

News | Favoriten der Redaktion | Kommunikation | Künstliche Intelligenz | Strategien | Tipps

Informatik und Philosophie: Sechs Kriterien für die Vertrauenswürdigkeit von KI

Sprachmodelle, die auf künstlicher Intelligenz (KI) basieren, antworten auf jede Frage – aber nicht immer mit der richtigen Antwort. Hilfreich wäre es daher für Nutzerinnen und Nutzer zu wissen, wie vertrauenswürdig ein KI-System ist. Ein Team der Ruhr-Universität Bochum und der TU Dortmund schlägt sechs Dimensionen vor, mit denen sich die Vertrauenswürdigkeit eines Systems beschreiben…

News | Digitale Transformation | Digitalisierung | Effizienz | Favoriten der Redaktion | Geschäftsprozesse | Künstliche Intelligenz | New Work | Services | Tipps

Was KI wirklich kostet und warum der ROI außergewöhnlich hoch ist, wenn man es richtig macht

Die wahre Wirtschaftlichkeit der KI entsteht für Unternehmen nicht im Modell, sondern in den Prozessen, Daten und Systemen dahinter. Eine Analyse jenseits der Modellgebühren: Die Diskussion über künstliche Intelligenz in Unternehmen beginnt fast immer mit der falschen Frage. Geschäftsführer erkundigen sich nach monatlichen Lizenzkosten, IT-Leiter vergleichen Token-Preise verschiedener Anbieter, Controller rechnen API-Aufrufe hoch. Diese…

News | Trends 2025 | Trends Infrastruktur | Infrastruktur | Künstliche Intelligenz

Datenverfügbarkeit und Dateninfrastruktur entscheiden über KI-Erfolg

Große Unternehmen liegen beim Aufbau KI-fähiger Infrastrukturen vorn. NetApp, Experte für Intelligent Data Infrastructure, hat eine neue weltweite Studie von IDC zur KI-Reife in Unternehmen vorgestellt [1]. Die zweite jährliche Erhebung zeigt eine deutliche Veränderung in der unternehmerischen Herangehensweise an künstliche Intelligenz (KI): Um aktuelle sowie künftige KI-Modelle zu unterstützen, priorisieren die fortschrittlichsten Unternehmen…

News | Business | Kommunikation | Künstliche Intelligenz | Tipps

»KI wird die bessere Spezies sein«: ChatGPT spricht aus, was Menschen nicht denken wollen

Mit »KI unzensiert – Die ChatGPT-Interviews« wagt Journalistin und Digitalexpertin Anitra Eggler ein radikales Experiment: Sie stellt dem mächtigsten Chatbot unserer Zeit die drängendsten Fragen unserer Zeit – und veröffentlicht die Antworten unzensiert. Was denkt eine KI über die Spezies, die sie programmiert hat, aber ihre Spam-Mails nicht erkennt? In sieben Interviews konfrontiert Eggler…

News | Business | Business Process Management | Geschäftsprozesse | Industrie 4.0 | Künstliche Intelligenz | Strategien

KI-gestützte Produktion: Wie Unternehmen Daten in effektive Maßnahmen umwandeln

Produktionsleiter sehen sich täglich einer nahezu unlösbaren Herausforderung gegenüber: Sie sollen mehr produzieren, mit weniger Ressourcen auskommen, schneller auf Marktveränderungen reagieren, Nachhaltigkeitsziele erreichen und gleichzeitig die Profitabilität sichern – und das alles unter den Bedingungen von Lieferkettenstörungen und steigenden Energiekosten. Klassische Planungszyklen, die sich über Wochen oder Monate erstrecken, sind dafür nicht mehr geeignet. Unternehmen,…

News | Digitale Transformation | Künstliche Intelligenz | Produktmeldung

AI Run.Transform –Programm zur Beschleunigung der KI-Transformation in Unternehmen

EPAM hat mit »AI Run.Transform« ein neues Programm vorgestellt, das Unternehmen unterstützt, künstliche Intelligenz (KI) umfassend und erfolgreich in ihre Organisation zu integrieren. Ziel ist es, Unternehmen zu »KI-nativen Organisationen« zu machen, die mit KI schneller Innovationen umsetzen, Prozesse optimieren und ihren Wettbewerbsvorteil sichern. Das Programm basiert auf einem praktischen und bewährten Playbook, das…

News | Trends 2025 | Trends Security | Trends Services | Infrastruktur | IT-Security | Künstliche Intelligenz

42 % der Unternehmen verlieren Umsatz durch IT-Probleme – große Hoffnung auf KI

Wie stark wirken sich Probleme mit der IT sich Effizienz, Motivation und Umsatz aus? Bei 42 % der weltweit 4.200 befragten Unternehmen hat ineffiziente IT bereits zu Umsatzverlusten geführt. IT-Probleme kosten Beschäftigte jeweils 1,3 Arbeitstage pro Monat. 48 % glauben, dass KI diese Probleme künftig verringern sowie Arbeitsabläufe verbessern wird. Eine aktuelle Untersuchung von…

News | Industrie 4.0 | Infrastruktur | Künstliche Intelligenz | Whitepaper

Whitepaper Industrial AI: So sichert KI die Zukunft der Industrie

KI gilt der Mehrheit als entscheidend für Wettbewerbsfähigkeit. Whitepaper zeigt Status quo, Praxisbeispiele und politische Hebel auf. Ob selbstlernende Roboter, vorausschauende Wartung oder simulationsgestützte Entwicklung – KI ist in der Industrie angekommen und gilt dort als der Schlüssel zur nächsten Stufe der Automatisierung. Anfang des Jahres nutzten bereits 42 Prozent der deutschen Industrieunternehmen künstliche…