Illustration Absmeier foto freepik

2026 wird das Jahr, in dem Leistung, Compliance und Innovation zusammenkommen. Für IT-Führungskräfte und Architekten signalisiert dies einen Paradigmenwechsel: Weg von der reinen Beschleunigung von Systemen, hin zu nachweislich kontrollierbaren Architekturen, in denen Transparenz und Steuerbarkeit die neuen Leistungskennzahlen sind. Mit Blick auf die Infrastrukturlandschaft der Daten sieht Scality in 2026 folgende Trends:

- Die Tokenökonomie der KI macht Speicher zur nächsten Quelle von Effizienzgewinnen

Generative KI wird jedem produzierten KI-Token einen quantifizierbaren Wert zuordnen. 2026 wird die Kennzahl »Kosten pro Token« zu einer zentralen Planungsmetrik, die Unternehmen zwingt, Datenkosten auf detaillierter Ebene zu erfassen. Hierdurch lassen sich verborgene Ineffizienzen (Latenzen, Datenwachstum und suboptimales Tiering) identifizieren, die unmittelbare Auswirkungen auf die Modellperformance sowie den ROI haben.

Unternehmen werden eine differenzierte Sicht darauf benötigen, wie Daten genutzt werden, um Speicherverhalten mit KI-Ergebnissen zu verknüpfen. Automatisiertes Tiering, Predictive Caching sowie Echtzeit-Analysen werden zu Standardwerkzeugen der Optimierung.

Für Speicherarchitekten markiert 2026 einen kulturellen Wendepunkt. Wirtschaftliche Modelle enden nicht mehr bei Compute- oder Netzwerkressourcen. Führend werden Organisationen sein, die jedes verarbeitete Token mit dem Verhalten der zugrunde liegenden Daten verbinden und Speicher vom Kostenfaktor zum steuerbaren Werkzeug für KI-Effizienz machen. Während diese Effizienzgewinne die Infrastruktur neu gestalten, wird eine neue Klasse von Dienstleistern entstehen, die den unersättlichen Datenbedarf von KI bedienen.

- NeoClouds werden Datenaggregation auf GPU-Niveau ermöglichen

Eine neue Generation GPU-optimierter Serviceanbieter (sogenannte »NeoClouds«) wird entstehen. Ihr Wettbewerbsvorteil liegt nicht in der reinen Compute-Dichte, sondern darin, wie intelligent Informationen bewegt werden.

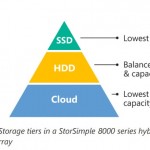

Um Tausende von GPUs zu versorgen, werden NeoCloud-Architekturen ein dreistufiges Speicherparadigma einführen:

- Ultraschneller NVMe-Layer

für Trainingsdaten, Caching sowie Zwischenergebnisse. - Massiv skalierbarer Objektspeicher-Layer

für Datensätze, Checkpoints und Langzeitaufbewahrung, der aktive Datensammlungen für Wiederverwendung und kontinuierliche Modelloptimierung bereitstellt. - Deep Cold Storage

für persistente Daten und Erkenntnisse, die für Retraining, Datenherkunft (Lineage) oder Compliance langfristig aufbewahrt werden müssen.

Die Verbindung erfolgt über intelligente Mobilitätstechnologien für Daten, die Informationen automatisch zwischen Ebenen verschieben. Ein globaler Namespace vereinheitlicht die Ebenen und gewährleistet konsistenten Zugriff, selbst über Regionen und Cluster hinweg.

Im Zeitalter der NeoClouds wird der Wettbewerbsvorteil in der Daten-Choreografie liegen, also in der Fähigkeit, Daten exakt im Takt des Trainings vorzubereiten, zu verschieben und zu bereinigen.

2026 wird die Fähigkeit, kontinuierliche Datenbewegungen zu orchestrieren, den Erfolg führender Anbieter definieren. Rohinfrastruktur allein reicht jedoch nicht: entscheidend ist letztlich, wie Organisationen Daten sammeln, kuratieren und kontrollieren.

- Datenpipelines werden Modelle als echten Wettbewerbsvorteil ablösen

Sobald Foundation Models breit verfügbar sind, verlieren sie ihr Alleinstellungsmerkmal. Die echte Differenzierung liegt in privaten Datensammlungen sowie datengetriebenen Pipelines, insbesondere in Bezug auf Relevanz, Qualität, Aktualität sowie Lineage.

2026 werden ernsthafte KI-Organisationen Datenvorbereitung nicht als Projekt behandeln, sondern als kontinuierliches, gesteuertes System, das umfasst:

- Kontinuierliche Datenaufnahme aus vielen Quellen

- Labeling und Enrichment

- Transformation und Normalisierung

- Speicherung, Versionierung und kontrollierter Zugriff

Jedes Dataset (und jede Variante) muss nachvollziehbar und jederzeit abrufbar sein. Wer es erstellt hat, welche Systeme es verändert haben, wie es sich entwickelt hat und auch, welche Modelle es genutzt haben, wird zum verpflichtenden Kontext.

Objektspeicher bildet den Mittelpunkt dieser Architektur und koppelt exabyte-skalierbare Speicherung mit flexiblen Metadaten und Versionierung. Darüber hinaus müssen Metadaten-Dienste umfassende Herkunftsinformationen der Daten und Richtlinien abbilden – einschließlich Ersteller, Transformationen, Freigaben, Nutzung sowie Aufbewahrungsvorgaben. AI-Governance, Auditierbarkeit und Sicherheit hängen direkt von diesem Stack ab. Der entscheidende Knackpunkt: 2026 wird nicht die Modellkomplexität zählen, sondern vielmehr die Fähigkeit, Integrität, Lineage und Kontrolle der Daten nachzuweisen.

Die Verwaltung des Datenlebenszyklus in großem Maßstab erfordert Orchestrierung. Hier kommt Kubernetes ins Spiel.

- Kubernetes wird zum Betriebssystem der KI-Dateninfrastruktur

Kubernetes hat sich weit über seine Rolle als Stateless Container-Orchestrator hinaus entwickelt. 2026 wird Kubernetes als zentrales Kontrollzentrum fungieren, in dem Compute, Storage und Data Governance zusammengeführt sind.

Heute laufen Datenbanken, Message Queues und AI Feature Stores zunehmend als Stateful Services in Kubernetes-Clustern. Das stellt ganz neue Anforderungen an Speicher:

- Konsistente, persistente Volumes bei dynamischer Skalierung

- Anwendungsbewusste Snapshots zur Sicherung der Transaktionsintegrität

- Elastizität, die mit Compute-Skalierung synchronisiert ist

Objektspeicher liefert die robuste Grundlage. Über CSI-Driver sowie Operatoren lässt er sich in Cluster integrieren und automatisiert Provisioning, Backup und Recovery.

2026 wird Kubernetes als De-facto-»Betriebssystem« für zustandsbehaftete KI-Dateninfrastrukturen fungieren und die Grenze zwischen Infrastruktur und Datendiensten zu einer einzigen operativen Domäne auflösen. Unternehmen müssen zudem in der Lage sein zu messen, ob die Orchestrierung den prognostizierten Wert liefert.

- Speicherleistung wird über verbrauchsbasierte SLA-Metriken gemessen

Die Ära von IOPS, Durchsatz und Latenz geht zu Ende. KI-Workloads, Regulatorik und Nachhaltigkeit erfordern messbare, Outcome-basierte Kennzahlen. 2026 wird Erfolg durch verbrauchsbasierte SLA-Metriken definiert, unter anderem:

- Zeit bis zur vollständigen Wiederherstellung nach Cybervorfällen

- GPU-Auslastung pro Speicher-Dollar

- Energieverbrauch pro gespeichertem Terabyte

Der Fokus verschiebt sich von Rohleistung hin zu messbaren, wirtschaftlich relevanten Ergebnissen. Speicheranbieter müssen Telemetrie, Observability und automatisiertes Reporting nativ integrieren. Leistungskennzahlen werden selbst zum Nachweis von Intelligenz, Effizienz und Governance.

- Datenfreiheit wird zu einer rechtlichen und wettbewerblichen Pflicht

Der EU Data Act etabliert Datenfreiheit als gesetzliche und operative Verpflichtung. Vendor-Silos verlieren ihre Relevanz. Unternehmen verlangen offene Datenverträge, interoperable APIs sowie standardisierte Metadaten, um Daten nahtlos zu bewegen.

Speicherplattformen müssen native Replikation, Policy-basierte Datenmobilität und Cross-Cloud Federation bereitstellen. Ein globaler Namespace gewährleistet Objektidentität, Kontext und konsistenten Zugriff. Versionierung und Lifecycle-Automatisierung sichern Datenintegrität und verhindern Verlust.

2026 wird die Marktführerschaft im Bereich Cloud Storage daran gemessen, wie effizient Unternehmen Daten frei, sicher und kontrolliert über heterogene Infrastrukturen bewegen können.

- Cyberresilienz wird zum regulierten, auditierbaren Vertrauensstandard

2026 wird Cyberresilienz eine Voraussetzung mit Blick auf Geschäftsfähigkeit. Regulatorische Rahmenwerke wie etwa SEC-Cybersecurity Rules sowie NIS2 verlangen nachweisbare Wiederherstellbarkeit, das über reines Reporting hinausgeht.

Die Speicherinfrastruktur bildet das Herz dieser Anforderungen. Immutable Storage, kryptographisch verifizierbare Retention sowie automatisierte Recovery-Validierung werden verpflichtend. Features wie Object-Lock, Versioning und manipulationssichere Logs entwickeln sich zum Standard. Cyberresilienz entscheidet darüber, welche Unternehmen tatsächlich versichert, Compliance-konform und vertrauenswürdig bleiben.

Warum Verantwortlichkeit 2026 das verbindende Prinzip der Dateninfrastruktur darstellt

Ein roter Faden zieht sich durch alle Trends: Verantwortlichkeit. Ob Tokenökonomie, datengetriebene Pipelines oder nachweisbare Cyberresilienz, 2026 werden diejenigen belohnt, die Integrität, Effizienz und Vertrauenswürdigkeit ihrer Datenoperationen nachweislich belegen können.

Speicher entwickelt sich vom stillen Partner zum zentralen Kontrollpunkt für Vertrauen, Governance und operative Effizienz. Verantwortlichkeit wird zum entscheidenden Maßstab für Fortschritt. Und Speicher ist der Ort, an dem diese Verantwortlichkeit messbar wird.

Paul Speciale, CMO, Scality

7948 Artikel zu „Daten Infrastruktur“

Trends 2025 | News | Trends Infrastruktur | Infrastruktur | Künstliche Intelligenz

Datenverfügbarkeit und Dateninfrastruktur entscheiden über KI-Erfolg

Große Unternehmen liegen beim Aufbau KI-fähiger Infrastrukturen vorn. NetApp, Experte für Intelligent Data Infrastructure, hat eine neue weltweite Studie von IDC zur KI-Reife in Unternehmen vorgestellt [1]. Die zweite jährliche Erhebung zeigt eine deutliche Veränderung in der unternehmerischen Herangehensweise an künstliche Intelligenz (KI): Um aktuelle sowie künftige KI-Modelle zu unterstützen, priorisieren die fortschrittlichsten Unternehmen…

News | Infrastruktur | IT-Security | Rechenzentrum

Kritische Infrastrukturen: Risikomanagement in Datenzentren

Ein Systemausfall in einem Rechenzentrum gleicht einem Blackout mit potenziell verheerenden wirtschaftlichen Konsequenzen. Studien belegen eindrucksvoll die finanziellen Risiken: Bereits eine Ausfallstunde kann Unternehmen zwischen 1 und 5 Millionen US-Dollar kosten [1]. Hauptursache für längere Ausfälle sind laut einer Studie des Uptime Institute vor allem Probleme mit der Stromversorgung [2] – ein Risikofaktor, der durch…

News | Business Process Management | Künstliche Intelligenz | Tipps | Whitepaper

Finanzdienstleister kämpfen mit KI-Herausforderungen an Datenmanagement und -infrastruktur

Eine aktuelle Umfrage zeigt, dass 84 % der Führungskräfte katastrophale Datenverluste befürchten, weil KI die Infrastruktur überlastet. 41 % Prozent geben an, dass KI bereits ein kritischer Teil ihrer Arbeit ist. Die rasanten Fortschritte im Bereich der künstlichen Intelligenz (KI) stellen traditionelle Dateninfrastrukturen vor nie dagewesene Herausforderungen und zwingen Unternehmen im Banken-, Finanzdienstleistungs- und…

News | Business Process Management | Cloud Computing | Infrastruktur | Lösungen | Ausgabe 1-2-2024

Riverty setzt auf skalierbare Exadata-Datenbankinfrastruktur aus der Cloud –

Von On-Premises in die Cloud

Für den effizienten und sicheren Transfer von geschäftskritischen Daten ist der FinTech-Anbieter Riverty auf eine Top-Performance und skalierbare Ressourcen in seiner Data-Warehouse-Infrastruktur angewiesen. Aufgrund stetigen Wachstums und der steigenden Menge an Kundendaten entschloss sich das Unternehmen vom vorhandenen On-Premises-System in die Oracle Cloud Infrastructure zu wechseln. Das Ergebnis: eine Beschleunigung der Laufzeit bei Prozessen um 10 bis 15 Prozent.

News | Digitalisierung | Infrastruktur | Künstliche Intelligenz

Effektives Datenmanagement: Künstliche Intelligenz als Innovationstreiber in komplexen IT-Infrastrukturen

Künstliche Intelligenz (KI) ist zweifellos ein wegweisender Meilenstein für die Technologiebranche. Während das volle Potenzial erst nach und nach erkennbar wird, zeichnet sich bereits jetzt ab, dass KI-Anwendungen eine intensive Datennutzung erfordern. Die Folge: Effektives und verantwortungsvolles Datenmanagement wird zum entscheidenden Faktor für eine Vielzahl von Use Cases. Unternehmen stehen schon heute vor der…

News | IT-Security | Ausgabe 5-6-2021 | Security Spezial 5-6-2021

Gaia-X und die Cloud-Infrastruktur – Wie Open Source Europa zu mehr Datensouveränität verhilft

News | Digitalisierung | Favoriten der Redaktion | Lösungen | Services | Sicherheit made in Germany

Schul-Cloud-Projekt: Schulen benötigen dringend eine sichere und datenschutzkonforme digitale Infrastruktur

Plötzlich wird digital unterrichtet: Lehrkräfte stellen Unterrichtsmaterialien und Aufgaben ins Netz und kommunizieren mit Schülerinnen und Schülern über Messenger- oder Videokonferenzdienste. Doch mangels landesweit einheitlicher Angebote und digitaler Infrastrukturen mussten in den letzten Wochen viele Schulen und Lehrkräfte in der Not sehr schnell eigene Lösungen finden. Oft nutzen Lehrkräfte innerhalb einer Klasse verschiedene Anwendungen –…

News | Business | Business Intelligence | Digitale Transformation | Künstliche Intelligenz | Lösungen | Ausgabe 11-12-2019

Homogene digitale Infrastruktur – Erfolgsfaktor Datenmanagement

News | Infrastruktur | Ausgabe 11-12-2018

Verteilte Netzwerke effektiv nutzen und schützen – »CUNA« Daten-Gateway für verteilte IT-Infrastrukturen

In Zeiten der Globalisierung von Märkten und der damit verbundenen weltweiten Vernetzung von Informationen und Standorten stehen die Unternehmen oft vor erheblichen Herausforderungen beim Management ihrer verteilten IT-Infrastrukturen. Zu diesen Herausforderungen zählen unter anderem die steigenden Datenmengen innerhalb der Unternehmen. Aufgrund der in diesem Jahr eingeführten Datenschutzgrundverordnung (DSGVO) ist es vor allem wichtig, sich einen Gesamtüberblick über die vorhandenen Daten zu verschaffen und diese als wertvolles Asset zu sehen.

News | Business Process Management | Cloud Computing | Infrastruktur | IT-Security | Lösungen | Outsourcing | Rechenzentrum | Services

Infrastruktur für das Datenmanagement modernisieren –Tipps zum Umstieg beim Lebenszyklusende

Jedes Unternehmen, das eine eigene Dateninfrastruktur betreibt, muss sich mit dem Ende von Produktlebenszyklen auseinandersetzen. So sind Systeme für Backup-, Wiederherstellungs- und Archivierungsprozesse, die seit vielen Jahren ihren Dienst verrichten, irgendwann veraltet. Wie der Übergang in eine neue Infrastruktur gestaltet werden kann, erklärt Rubrik. »End of Life« oder kurz EOL ist sowohl ein objektiver…

News | Cloud Computing | Digitalisierung | Effizienz | Infrastruktur | Online-Artikel | Rechenzentrum

Das Ende der Schatten-IT – Ablösung des Primats der Infrastruktur durch Daten

Nachdem auf zentralen Veranstaltungen der IT-Branche, der AWS Re:Invent und dem Gartner Symposium, das Schlagwort »Schatten-IT« die Diskussionen bestimmte, nimmt Ash Ashutosh, CEO von Actifio, zur aktuellen Debatte Stellung. Sehr plastisch bewertete Ash Ashutosh die AWS Re:Invent in Las Vegas: »Das Event wirkt für altgediente IT-Profis wie eine Ansammlung von Piraten, Unzufriedenen und Revolutionären, die…

News | Trends Infrastruktur | Trends Cloud Computing | Infrastruktur | Rechenzentrum

Engpass »IT-Infrastruktur«: Wachsende Datenmengen sind Top-IT-Thema

Da Organisationen immer mehr Datenströme, beispielsweise aus Interaktionen im Internet, aus mobilen GPS-Aktivitäten und über Sensoren generieren, nimmt die Datenmenge laut IDC alle fünf Jahre um das Zehnfache zu: von 4,4 Billionen Gigabyte im Jahr 2014 auf rund 44 Billionen Gigabyte bis etwa 2020. Unternehmen stehen vor der Herausforderung, einfach skalierbare, sichere und kostengünstige Speichermöglichkeiten…

Trends 2025 | News | Trends Cloud Computing | Cloud Computing | Infrastruktur | Rechenzentrum

Cloud-Infrastrukturdienste: Keine wolkigen Umsätze

Rund 107 Milliarden US-Dollar Umsatz wurden laut Synergy Research Group im dritten Quartal 2025 mit Cloud-Infrastrukturdiensten erwirtschaftet. Hochgerechnet könnte das Marktvolumen für das Gesamtjahr auf etwa 413 Milliarden US-Dollar steigen – das entspräche einem Plus von 25 Prozent. Zum Vergleich: 2017 waren es noch weniger als 50 Milliarden US-Dollar. Dabei hatte sich das Wachstum bis…

News | Cloud Computing | Digitalisierung | Geschäftsprozesse | Kommunikation | Services

Europa gewinnt digitales Profil – Outlook-Alternative setzt auf Datenschutz und Effizienz

Mit dem Support-Ende für Microsoft Exchange müssen Unternehmen ihre Kommunikationssysteme überdenken. Die tschechische Plattform IceWarp bietet eine kosteneffiziente, kompatible und datenschutzkonforme Lösung – und zeigt, dass Europa auch technologisch konkurrenzfähig ist. Am 14. Oktober endete der Support für Microsoft Exchange Server 2016 und 2019. Für viele Unternehmen ist das mehr als eine technische Formalie.…

News | Business | Business Process Management | Geschäftsprozesse | Industrie 4.0 | Künstliche Intelligenz | Strategien

KI-gestützte Produktion: Wie Unternehmen Daten in effektive Maßnahmen umwandeln

Produktionsleiter sehen sich täglich einer nahezu unlösbaren Herausforderung gegenüber: Sie sollen mehr produzieren, mit weniger Ressourcen auskommen, schneller auf Marktveränderungen reagieren, Nachhaltigkeitsziele erreichen und gleichzeitig die Profitabilität sichern – und das alles unter den Bedingungen von Lieferkettenstörungen und steigenden Energiekosten. Klassische Planungszyklen, die sich über Wochen oder Monate erstrecken, sind dafür nicht mehr geeignet. Unternehmen,…

News | Effizienz | Infrastruktur | Nachhaltigkeit | Produktmeldung | Rechenzentrum

Delta und Siemens stärken ihre Zusammenarbeit, um die Energieinfrastruktur von Rechenzentren im KI- und Cloud-Zeitalter zu optimieren

Delta, Anbieter von Energie- und intelligenten, nachhaltigen Lösungen, und Siemens Smart Infrastructure haben eine globale Partnerschaft geschlossen, um vorgefertigte, modulare Energielösungen zu liefern, die die Bereitstellung von Rechenzentrumsinfrastruktur beschleunigen und gleichzeitig die CAPEX deutlich reduzieren. Die Kooperation verschafft Hyperscalern und Colocation-Anbietern einen strategischen Vorteil im wettbewerbsintensiven KI- und Cloud-Computing-Markt – mit höchster Leistungsfähigkeit, Energieeffizienz und…

News | Business Process Management | Digitalisierung | Effizienz | Favoriten der Redaktion | IT-Security | Künstliche Intelligenz | Services

Zuverlässige Daten als Schlüssel zur erfolgreichen Umsetzung des EU AI Acts

Seit dem 2. Februar 2025 verbietet das EU-Gesetz zur künstlichen Intelligenz (AI Act) den Einsatz von KI-Systemen, die als »inakzeptable Risiken« eingestuft werden. Organisationen, die gegen dieses Gesetz verstoßen, müssen mit hohen Strafen rechnen, die bis zu 7 % ihres weltweiten Jahresumsatzes oder 35 Millionen Euro betragen können. Die Einhaltung der Vorschriften erfordert keine Neuerfindung…

News | Business | Digitalisierung | Effizienz | Favoriten der Redaktion | Geschäftsprozesse | Infrastruktur | IT-Security | Künstliche Intelligenz | Lösungen | Rechenzentrum | Services | Strategien

Confidential Computing: Sichere Datenverarbeitung in unsicheren Zeiten

Unternehmen und öffentliche Einrichtungen wollen ihre Daten in der Cloud verarbeiten können, ohne dabei Vertraulichkeit, Datenhoheit oder Compliance zu gefährden. Confidential Computing gilt als Schlüsseltechnologie, um genau dies zu erreichen. Andreas Walbrodt, CEO des Berliner Unternehmens enclaive, erklärt, worauf bei der Implementierung von Confidential Computing zu achten ist. Ob im Gesundheitswesen, der öffentlichen Verwaltung,…

Trends 2025 | News | Trends Security | Infografiken | IT-Security

Malware, Betrug, Scams und Datendiebstahl: Massive Sicherheitslücken

Cybersicherheitsverhalten, KI-Bedenken und Risiken von Verbrauchern weltweit. 14 Prozent der Befragten fielen im letzten Jahr digitalem Betrug zum Opfer. Soziale Medien überholen E-Mail als bevorzugten Angriffsvektor von Cyberkriminellen. KI-Betrug wird zur wachsenden Sorge der Verbraucher. Die neue 2025 Consumer Cybersecurity Survey von Bitdefender gibt Einblicke in zentrale Verhaltensweisen, Praktiken und Bedenken im Bereich der…

News | IT-Security | Produktmeldung | Services

Schutz auf Kernel-Ebene zur Verteidigung vor Infostealern, die auf sensible Daten abzielen

Keeper Security Forcefield ist branchenweit erster Schutz vor speicherbasierten Angriffen auf Windows-Endpunkten. Keeper Security, ein Cybersecurity-Anbieter für Zero-Trust- und Zero-Knowledge- Privileged-Access-Management-Software (PAM) zum Schutz von Passwörtern, Passkeys, privilegierten Konten, Geheimnissen und Remote-Verbindungen, kündigt Keeper Forcefield an – den ersten Schutz seiner Art gegen speicherbasierte Angriffe auf Windows-Geräten. Forcefield ist ein Endpoint-Sicherheitsprodukt auf Kernel-Ebene, das…