foto freepik

Ein Kommentar von Knar Hovakimyan, Responsible AI Lead und Engineering Manager bei Grammarly.

Die Möglichkeiten der künstlichen Intelligenz zur Erstellung von Inhalten sind im letzten Jahr rasant gestiegen. Doch der Akt des Schreibens ist nach wie vor unglaublich persönlich. Wenn KI eingesetzt wird, um Menschen bei der Kommunikation zu helfen, ist es wichtig, die ursprüngliche Absicht einer Nachricht zu respektieren. Doch die jüngsten Innovationen – insbesondere im Bereich der generativen KI – haben die bestehenden Ansätze zur Bereitstellung verantwortungsvoller Schreibassistenz weit hinter sich gelassen.

Wenn über Sicherheit und Fairness im Zusammenhang mit KI-Schreibassistenten nachgedacht wird, konzentrieren sich Forscher und Branchenexperten in der Regel darauf, toxische Sprache wie abwertende oder obszöne Ausdrücke zu erkennen und zu verhindern, dass sie den Nutzern angezeigt wird. Dies ist ein wichtiger Schritt, um die Modelle sicherer zu machen und sicherzustellen, dass sie nicht die denkbar schlechtesten Inhalte produzieren. Dies allein reicht jedoch nicht aus, um ein Modell sicher zu machen. Was passiert, wenn ein Model Inhalte produziert, die an sich völlig harmlos sind, aber in bestimmten Kontexten anstößig werden? Ein Satz wie »Look on the bright side« auf Englisch (»Sieh es positiv«) kann im Zusammenhang mit einer kleinen Unannehmlichkeit positiv sein, aber im Zusammenhang mit einem Krieg äußerst beleidigend.

Als KI-Entwickler reicht es nicht aus, toxische Sprache zu blockieren, um zu behaupten, dass das Modell sicher ist. Um wirklich verantwortungsvolle KI-Produkte anbieten zu können, muss man verstehen, wie die Modelle funktionieren, welche Schwachstellen sie haben und in welchen Kontexten sie eingesetzt werden könnten. Kontrollen müssen zudem eingeführt werden, um schädliche Interaktionen zwischen KI-Systemen und Nutzern zu verhindern.

Das Problem und seine Bedeutung

Laut einer Forrester-Studie verwenden 70 Prozent der Erwerbstätigen generative KI für die meisten oder alle ihre Schreib- und Textbearbeitungsaufgaben. Mit diesem Anstieg der Nutzung generativer KI-Tools interagieren mehr Inhalte als je zuvor regelmäßig mit KI, maschinellem Lernen (ML) und großen Sprachmodellen (LLMs). KI macht bekanntlich Fehler. Laut einer Studie kontrollieren 67 Prozent der Erwerbstätigen, die textbasierte generative KI schon beruflich genutzt haben, die Resultate auf Korrektheit. 66 Prozent geben an zu wissen, dass generative KI falsche Ergebnisse erzeugen kann [1]. Wenn ein KI-Modell einen Vorschlag macht, der die Bedeutung eines Satzes verändert, ist das in der Regel ein harmloser Fehler und kann abgelehnt werden. Dies wird jedoch umso komplizierter, je weiter die Technologie voranschreitet und je mehr Entwickler sich auf LLMs verlassen. Wenn zum Beispiel ein LLM zu politischer Voreingenommenheit neigt, könnte es unverantwortlich sein, es politische Berichte erstellen zu lassen. Wenn die Tendenz zu Fehlinformationen und Halluzinationen besteht, kann es gefährlich und unethisch sein, es medizinische Ratschläge und Diagnosen generieren zu lassen. Diese unangemessenen Ergebnisse können also nicht nur harmlose Fehler sein, sondern weit schlimmer ausfallen und somit tiefgreifendere Folgen haben.

Ein Weg in die Zukunft

Die Branche muss neue Taktiken für Sicherheitsbemühungen entwickeln, um mit den Fähigkeiten – und Schwächen – der neuesten KI-Modelle Schritt zu halten.

Einige Beispiele oben verdeutlichen, dass das Blockieren toxischer Sprache meist nicht ausreicht, um gefährliche Interaktionen zwischen KI-Systemen und Nutzern im heutigen Ökosystem zu verhindern. Erforscht man die Funktionsweise und Schwächen der Modelle und die Kontexte, in denen sie eingesetzt werden, kann man verantwortungsvolle Unterstützung für bereits genannte und weitere Fallbeispiele liefern:

- Ein generativer KI-Schreibassistent kann eine Zusammenfassung einer medizinischen Diagnose erstellen. In einer Situation, in der viel auf dem Spiel steht, besteht jedoch ein großes Risiko, dass irreführende oder aus dem Zusammenhang gerissene Informationen eingefügt werden. Durch die Verwendung des richtigen ML-Modells als Leitplanke kann verhindert werden, dass das LLM ungenaue Informationen liefert.

- Politische Meinungen sind nuanciert, sodass der Vorschlag oder die Ausgabe eines KI-Produkts leicht die Integrität eines Punktes fehldeuten kann, da es die Absicht oder den Kontext nicht versteht. Ein sorgfältig ausgearbeitetes Modell kann ein LLM davon abhalten, sich mit einigen politischen Themen zu befassen, bei denen die Gefahr von Fehlinformationen oder Voreingenommenheit besteht.

- Soll im Trauerfall eine Beileidsbekundung für einen Kollegen verfasst werden, kann ein Modell verhindern, dass ein KI-Schreibassistent einen unpassenden Vorschlag macht, der »positiv« klingt.

Schutzmechanismen erkennen »Sprach-Erdbeben” durch Kontext

Ein Beispiel für einen solchen Schutzmechanismus, ist Seismograph. Es ist das erste System seiner Art, das auf große Sprachmodelle und proprietäre maschinelle Lernmodelle aufgesetzt werden kann, um heikle Ausgaben zu reduzieren: ähnlich wie ein »Seismograf« Erdbebenwellen misst, erkennt und misst die Seismograph-Technologie, wie sensibel ein Text ist, sodass die Modelle rechtzeitig angemessen eingreifen können, um die negativen Auswirkungen auf Nutzende zu minimieren. Die Entwicklung von Seismograph ist nur ein Beispiel dafür, wie ein hybrider Ansatz, bei dem LLM, ML und KI-Modelle zusammenarbeiten, zu vertrauenswürdigeren und zuverlässigeren KI-Produkten führt. Durch die Verringerung der Wahrscheinlichkeit, dass KI unerwünschte Inhalte ohne angemessenen Kontext liefert, kann die Branche KI-Schreibassistenz aus einer Position der Empathie und Verantwortung heraus anbieten.

Die Zukunft der verantwortungsvollen KI

Als sich KI-Kommunikationswerkzeuge in erster Linie auf die grundlegenden Mechanismen des Schreibens beschränkten, war der potenzielle Schaden, den ein Schreibvorschlag anrichten konnte, unabhängig vom Kontext minimal. Mit dem Fortschreiten der Technologie und dem zunehmenden Einsatz von KI bei komplexeren Schreibaufgaben, bei denen der Kontext eine Rolle spielt, wächst auch die Verantwortung solcher KI-Anbieter, dafür zu sorgen, dass ihre Lösungen keine unbeabsichtigten Folgen haben. Produktentwickler können diese drei Grundsätze befolgen, um sich selbst zur Verantwortung zu ziehen:

- Die Suche nach Schwachstellen im Produkt durch Red Teaming, Bias- und Fairness-Evaluierungen sowie andere Drucktests können Schwachstellen aufdecken, bevor sie sich erheblich auf Kundinnen und Kunden auswirken.

- Die Ermittlung branchenweiter Lösungen macht die Entwicklung verantwortungsvoller KI einfacher und zugänglicher. Die Entwicklung in verantwortungsvollen Ansätzen hilft, die Qualität der Produkte zu verbessern und das Vertrauen der Verbraucher in die KI-Technologie zu stärken.

- Die Einbindung von Teams für »Responsible AI« in die gesamte Produktentwicklung ist wichtig, denn wenn niemand ausdrücklich dafür verantwortlich ist, dass die Modelle sicher sind, geht das schnell unter. Unternehmen müssen diesen Teams entsprechend Priorität einräumen und sie befähigen, eine zentrale Rolle bei der Entwicklung neuer und der Pflege bestehender Funktionen zu spielen.

Diese Grundsätze leiten so beispielsweise die Arbeit von Grammarly und bilden die Grundlage für das Engagement bei der Entwicklung öffentlich zugänglicher Modelle wie Seismograph. Auf diese Weise zeigt das Unternehmen, dass die Branche den Risiken voraus ist und den Menschen komplexere Vorschläge und generierte Ergebnisse bieten kann – ohne Schaden anzurichten.

Über die Autorin: Knar Hovakimyan leitet das Responsible AI Team von Grammarly, das sich auf die Entwicklung und Verbesserung von KI-Systemen fokussiert, die Vorurteile (Bias) abbauen und Fairness fördern. Knars Team aus analytischen Linguisten und Ingenieuren für maschinelles Lernen setzt sich dafür ein, dass die Vorschläge und Outputs von Grammarly für die über 30 Millionen Menschen und 70.000 Business-Teams, die das Produkt nutzen, inklusiv, unvoreingenommen und fair sind.

[1] https://www.bidt.digital/publikation/verbreitung-und-akzeptanz-generativer-ki-in-deutschland-und-an-deutschen-arbeitsplaetzen/

1616 Artikel zu „Verantwortung KI“

NEWS | KÜNSTLICHE INTELLIGENZ

Das zeichnet eine verantwortungsvolle KI aus

Trifft künstliche Intelligenz diskriminierende Entscheidungen oder schlägt Kunden unpassende Angebot vor, kann das den Ruf und den Umsatz von Unternehmen ernsthaft beschädigen. Wie kann man sich mit einer verantwortungsvollen KI davor schützen?. Immer mehr Unternehmen setzen bei ihren Angeboten auf künstliche Intelligenz (KI). Ihre Algorithmen schlagen Produkte und Services vor, hauchen Chatbots Leben ein…

NEWS | BUSINESS | TRENDS 2019 | KÜNSTLICHE INTELLIGENZ | WHITEPAPER

KI verantwortungsvoll und effektiv gestalten

84 Prozent der Unternehmensleiter sind der Meinung, dass künstliche Intelligenz (KI) in drei Jahren für ihr Unternehmen von entscheidender Bedeutung sein wird, aber nur 15 Prozent wissen, ob KI-Projekte in ihren Unternehmen vollständig umgesetzt werden. Während schnell wachsende Unternehmen in der KI einen Beitrag zur Festigung ihrer Führungsposition sehen, hat die Hälfte aller Unternehmen keine…

TRENDS 2024 | NEWS | TRENDS SERVICES | FAVORITEN DER REDAKTION | KÜNSTLICHE INTELLIGENZ | WHITEPAPER

Herausforderungen, ROI, Kosten & Co: Wie wird KI in Unternehmen wirklich eingesetzt?

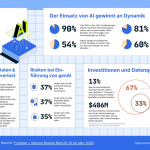

Fivetran, der Anbieter für Data Movement, präsentiert die Ergebnisse einer Umfrage, die zeigt: 81 % der befragten Unternehmen vertrauen ihren KI/ML-Ergebnissen, obwohl sie zugeben, fundamentale Datenineffizienzen zu haben. Sie verlieren im Durchschnitt 6 % ihres weltweiten Jahresumsatzes, beziehungsweise 406 Millionen US-Dollar bei einem durchschnittlichen Jahresumsatz von 5,6 Milliarden US-Dollar der befragten Unternehmen. Die Ursache sind…

NEWS | KÜNSTLICHE INTELLIGENZ | LÖSUNGEN

KI in der Praxis: Best Practices zum Einsatz von künstlicher Intelligenz

Es ist nicht leicht, mit den neuesten KI-Trends Schritt zu halten, geschweige denn, sie gewinnbringend in die Praxis umzusetzen. Für den Visionary Voices AI Guide spricht Qlik ab sofort regelmäßig mit Datenexperten aus der ganzen Welt, um herauszufinden, wie sie konkrete KI-Techniken im Geschäftsalltag anwenden. Welche Erkenntnisse sich aus den ersten Gesprächen ergeben haben, hat…

NEWS | KÜNSTLICHE INTELLIGENZ | STRATEGIEN | TIPPS

So können Unternehmen generative KI mit gutem Gewissen einsetzen

Generative KI bietet enorme Möglichkeiten, kommt aber nicht ohne Risiken ins Haus. Bei einem unbedarften Einsatz drohen Datenschutzverstöße und der Verlust von geistigem Eigentum. Experten zeigen auf, wie Unternehmen ChatGPT und Co. in vier Schritten unter Kontrolle bekommen. Im Handumdrehen Content erstellen, Tabellenkalkulationen erzeugen und sogar Programmcode schreiben: Generative KI bietet immense Möglichkeiten beim…

NEWS | KÜNSTLICHE INTELLIGENZ | STRATEGIEN

Die Grenzen der LLM: Wegweisende KI-Technologie ist kein Alleskönner

Large Language Models (LLMs) sind voll im Trend. Ob privat oder in Unternehmen, auf LLMs basierende Chatbots wie beispielsweise ChatGPT von OpenAI generieren mit Deep-Learning-Modellen Texte in menschenähnlicher Weise. Auf Basis von massiven Mengen von Textdaten trainiert, können sie so auf viele Fragen Antworten liefern und Befehle ausführen. Unternehmensentscheider prüfen momentan, welche Vorteile diese Sprachmodelle für ihre Organisation haben und wie man…

AUSGABE 1-2-2024 | NEWS | BUSINESS | KÜNSTLICHE INTELLIGENZ | STRATEGIEN

Künstliche Intelligenz verändert Organisationen – KI braucht Change Management

AUSGABE 1-2-2024 | SECURITY SPEZIAL 1-2-2024 | NEWS | EFFIZIENZ | IT-SECURITY

Die beste Technologie zur Verwaltung der Netzwerkinfrastruktur – Cyberrisiken effizient eindämmen

Unternehmen jeder Größe sehen sich einer wachsenden IT-Bedrohungslandschaft gegenüber. Gleichzeitig steigen die Anforderungen an die Leistungsfähigkeit der Netzwerkinfrastruktur. Bei vielen Unternehmen steht zudem die Migration in die Cloud an. Welche Herausforderungen kommen daher auf Unternehmen zu und wie kann man Effizienz mit Sicherheit verbinden? Darüber haben wir mit Professor Avishai Wool, Mitgründer und CTO von AlgoSec, gesprochen.

TRENDS 2024 | NEWS | BUSINESS | IT-SECURITY | KÜNSTLICHE INTELLIGENZ

Riskanter Balanceakt: Führungskräfte fordern Geschwindigkeit bei KI, IT pocht auf Sicherheit

Die Führungskräfte machen Druck auf die IT-Abteilungen für eine schnelle Einführung generativer KI. Die IT-Abteilungen wiederum fordern einen stärkeren Fokus auf Datensicherheit und -qualität. Es gilt Gleichgewicht zwischen Geschwindigkeit, Geschäftswert und Sicherheit herzustellen. Eine kürzlich von Salesforce durchgeführte weltweite Umfrage unter 600 IT-Fachleuten hat ergeben, dass die Geschäftsleitung von der IT-Abteilung erwartet, generative KI schnellstmöglich…

NEWS | BUSINESS | FAVORITEN DER REDAKTION | KÜNSTLICHE INTELLIGENZ | STRATEGIEN | TIPPS

Kostentreiber KI: Strategie-Tipps zur Leistungs- und Kostenoptimierung

Unternehmen nutzen vermehrt künstliche Intelligenz zur Optimierung ihrer operativen Effizienz und Produktinnovation. Eine aktuelle Umfrage des Beratungsunternehmens McKinsey zeigt, dass 40 Prozent der befragten Unternehmen aufgrund der rapiden Fortschritte im Bereich der generativen KI ihre Investitionen in KI-Technologien generell erhöhen wollen [1]. Ein Nachteil des zunehmenden Einsatzes ist jedoch, dass KI – insbesondere generative…

NEWS | DIGITALISIERUNG | KÜNSTLICHE INTELLIGENZ | STRATEGIEN | WHITEPAPER

Generative KI: Abwarten ist die falsche Strategie

Deutsche Unternehmen zögern bei ChatGPT & Co.: Erst 3 Prozent setzen generative KI zentral ein, 6 Prozent planen das fürs laufende Jahr. Bitkom veröffentlicht Leitfaden zu rechtlichen Fragen beim Einsatz generativer KI im Unternehmen. ChatGPT, Gemini & Co. haben in deutschen Unternehmen noch einen schweren Stand. Erst 3 Prozent nutzen generative KI bereits zentral…

NEWS | CLOUD COMPUTING | IT-SECURITY | KÜNSTLICHE INTELLIGENZ | SERVICES

Generative KI verbessert die Behebung von Schwachstellen im Code erheblich

Large-Language-Modelle helfen Cloud-Entwicklern im Hinblick auf die Sicherheit. Durch den Einsatz KI-gesteuerter Lösungen zur Behebung von Schwachstellen kann DevSecOps erheblich verbessert werden. Cyberbedrohungen entwickeln sich schneller als je zuvor. Um dem entgegenzuwirken und ihr Unternehmen besser zu schützen, ist das Ziel von CISOs im Prinzip relativ einfach: Fehlkonfigurationen und Schwachstellen in Anwendungen sollten möglichst…

NEWS | INFOGRAFIKEN | IT-SECURITY | KOMMUNIKATION | LÖSUNGEN

Wie sicher sind Passwörter in Zeiten von KI?

Die Herausforderungen rund um die IT-Sicherheit sind nur deshalb so spannend, weil sie stetig durch neue Technologien angefeuert werden. Die Krux daran: Sowohl die Verteidiger als auch die Angreifer bedienen sich oft derselben Innovationen und Technologien. Seit Jahren geht es darum, wer das Katz- und Maus-Spiel besser, schneller und effizienter beherrscht. Da der Fortschritt rasend…

NEWS | BUSINESS | EFFIZIENZ | KÜNSTLICHE INTELLIGENZ

»SAP erwartet durch KI einen riesigen Transformationsprozess, riesige Produktivitätssteigerungen«

Im Expert-Talk Schweiz 2024 sprachen Sybit und SAP über KI und Customer Relationship Management (CRM) in der Schweiz. Die Welt des Customer Relationship Managements (CRM) und der Customer Experience (CX) erlebt durch den Einsatz von künstlicher Intelligenz (KI) eine bemerkenswerte Transformation. Im Sybit Expert-Talk Schweiz am 30. Januar 2024 sprachen live am Zürcher Flughafen…

NEWS | EFFIZIENZ | IT-SECURITY | KÜNSTLICHE INTELLIGENZ | SERVICES

Generative KI hat enorme Auswirkungen auf Softwareentwicklung und Softwaresicherheit

Seit der Veröffentlichung von ChatGPT im November 2022 arbeitet die Technologiebranche daran, solche auf annähernd menschlichem Level funktionierenden Konversationsschnittstellen zu etablieren und praktisch zu nutzen. Fast jedes größere Unternehmen verbindet heute seine interne oder produktbezogene Dokumentation mit einem großen Sprachmodell, sogenannten »Large Language Models« oder kurz LLMs, um Fragen möglichst schnell zu beantworten. Gleichzeitig kommen…