Illustration: Absmeier, ArtTower

Nicht selten bleibt man an traditionellen Prinzipien, die sich in der Vergangenheit als zuverlässig erwiesen haben, standhaft hängen. Das gilt auch bei der Gestaltung neuer Datenarchitekturen, wie Otto Neuer, Regional VP Sales bei Denodo, weiß: Dabei stehen physische Datenspeicher weiterhin im Mittelpunkt, in denen Daten wiederholt und in überzähliger Menge gespeichert werden. Im Laufe der Zeit wurden neue Formen der Datenspeicher eingeführt, wie Data Lakes, Data Hubs und Data Lake Houses. Wenn einer Architektur beispielsweise Data Lakes hinzugefügt werden, ist es durchaus üblich, nicht einen, sondern eine ganze Reihe von Datenspeichern einzuführen, die als »Zones« oder »Tiers« bezeichnet werden. Der Einsatz mehrerer Depots bedeutet aber, dass viele Abfragen entwickelt, gepflegt und verwaltet werden müssen, um Daten zwischen den einzelnen Aufbewahrungsorten zu kopieren.

»Datengestütztes Vorgehen« und »digitale Transformation« – Unternehmen profitieren von der Vielseitigkeit in der Datennutzung und unterstützen auch neu aufkommende Formen: von den einfachsten bis hin zu komplexeren und anspruchsvolleren. Nach einer Begutachtung ihrer derzeitigen IuK-Systeme, haben die meisten Unternehmen festgestellt, dass diese die neuen Formen der Datennutzung nicht adäquat unterstützen. Es ist also Zeit für eine neue Datenarchitektur.

Jenseits der Legacy-Design-Prinzipien denken

Datenverwaltungsinfrastrukturen, welche auf einer Architektur mit redundanter Datenhaltung basieren, werden auch heute noch implementiert. Doch sollte es nicht vielmehr das Ziel sein, Datenspeicher, Datenredundanz und Datenkopiervorgänge zu minimieren?

Denn durch datenspeicherzentriertes Vorgehen ergeben sich viele Probleme:

- Je öfter Daten physisch kopiert werden, desto höher ist die Datenlatenz.

- Mit jeder Replizierung leidet die Datenqualität.

- Zeitaufwändige Verwaltung physischer Datenbanken, was zu unflexiblen Datenarchitekturen führt.

- Laut DSGVO sollen personenbezogene Daten erst gar nicht redundant in mehreren Datenbanken gehalten werden.

- Fehlende Architektur-Transparenz führt zu Ergebnissen, denen Geschäftskunden weniger vertrauen.

Moderne Datenarchitekturen sollten zum einen flexibel, erweiterbar und skalierbar sein. Zum anderen sollten sie eine niedrige Datenlatenz mit der bestmöglichen Datenqualität bieten, höchst vertrauenswürdige Ergebnisse liefern und die Einhaltung der DSGVO und vergleichbaren Regulierungen garantieren.

Architekturen agiler machen

Während des Designs einer neuen Datenarchitektur, sollte der Fokus weniger auf replizierender Datenspeicherung, sondern viel mehr auf der Verarbeitung und Nutzung der Daten liegen. Durch Datenvirtualisierung können Daten verarbeitet werden, ohne dass sie davor gespeichert werden müssen – noch bevor sie von Geschäftskunden genutzt werden. Datenvirtualisierung ist eine logische Datenschicht, die alle über verschiedene Systeme verteilten Unternehmensdaten integriert, einheitliche Daten für zentralisierte Sicherheit und Governance verwaltet und diese den Analysten in Echtzeit zur Verfügung stellt.

Die meisten Unternehmen brauchen neue Datenarchitekturen, um den rasant wachsenden Anforderungen der Datennutzung gerecht zu werden. Neue Architekturen sollten nicht auf veralteten Prinzipien basieren, sondern es bedarf an flexiblen Lösungen, die eben nicht datenspeicherzentriert sind. Die Datenvirtualisierung bietet höchste Flexibilität, indem zugrunde liegende Quellen problemlos hinzugefügt, entfernt oder geändert werden können. Somit ermöglichen Virtualisierungslösungen den IuK-Systemen, sowohl mit dem Tempo des Unternehmens mitzuhalten als auch neue Formen der Datennutzung schnell und flexibel zu unterstützen.

NEWS | CLOUD COMPUTING | TRENDS 2019 | KÜNSTLICHE INTELLIGENZ

Trends 2019: Datenvirtualisierung, KI und Cloud

Maschinelles Lernen wird für Unternehmen ein Muss. Interaktive Datenkataloge um nach relevanten Datenbeständen zu suchen. Datenvirtualisierung spielt bei Multi-Location-Cloud-Architekturen eine zunehmend wichtige Rolle. Denodo, ein Unternehmen im Bereich der Datenvirtualisierung, hat für das Jahr 2019 drei Top-Tech-Trends identifiziert. Neben künstlicher Intelligenz und modernen Datenvirtualisierungs-Tools wird sich auch die Cloud neu erfinden. Maschinelles Lernen für…

NEWS | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN | ONLINE-ARTIKEL | STRATEGIEN

Sechs Gründe für Datenvirtualisierung

Im Zeitalter von Big Data und Cloud Computing, mit explodierendem Datenvolumen und zunehmender Datenvielfalt, können es sich Unternehmen nicht mehr leisten, zahlreiche Kopien und Reproduktionen der Daten zu speichern, die sie für ihr Geschäft benötigen. Deshalb werden bis 2020 mehr als ein Drittel (50 Prozent) der Unternehmen laut Gartner eine Form der Datenvirtualisierung als effiziente…

NEWS | CLOUD COMPUTING | DIGITALE TRANSFORMATION | INFRASTRUKTUR | ONLINE-ARTIKEL

Datenvirtualisierung: Überbrückung der Technologielücke mit Hybrid-IT

Der Begriff »Hybrid-IT« wird oft falsch interpretiert oder verwendet. Er steht nicht einfach für eine heterogene Umgebung aus altgedienten, herkömmlichen (»Legacy«-) Umgebungen und modernen virtualisierten Umgebungen. Er steht vielmehr für eine Strategie, die IT auf einer offenen, erweiterbaren Basis zu betreiben, was Technologiefragen, Geschäftserwartungen, Sicherheits- und Überwachungsbedarf sowie diverse Kostenstrukturen mit einschließt. Actifio sieht in…

NEWS | EFFIZIENZ | TRENDS 2015 | RECHENZENTRUM

Rechenzentrum: Datenvirtualisierung löst Konflikt zwischen Datenexplosion und Energiebedarf

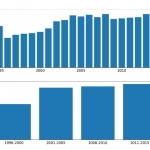

Eine aktuelle Studie [1] hat weltweit 800 Rechenzentrumsspezialisten befragt, wie sie die zukünftigen Entwicklungen im Rechenzentrum einschätzen. Herausgekommen ist unter anderem, das die durchschnittliche Leistungsdichte pro Rack signifikant ansteigen wird, wodurch sich zusätzlich Herausforderungen beim Wärmemanagement ergeben. Die Studie befasste sich auch damit, wie die Stromversorgung von Rechenzentren im Jahr 2025 aussehen würde. Energieeffizienz ist…

NEWS | BUSINESS PROCESS MANAGEMENT | FAVORITEN DER REDAKTION | GESCHÄFTSPROZESSE | ONLINE-ARTIKEL

Datenstrategien für Big Data – Automatisierung des Data Warehouse muss Teil der Lösung sein

Im Zeitalter von Big Data könnte man davon ausgehen, dass man gar nicht genug Daten haben kann. Denn aus Daten lassen sich in der Theorie wichtige Erkenntnisse ziehen, die Unternehmen zu ihrem Vorteil nutzen können. Und so sammeln Unternehmen seit Jahren fleißig Daten aus immer mehr Quellen ein – und stehen damit auch vor der…

NEWS | BUSINESS PROCESS MANAGEMENT | GESCHÄFTSPROZESSE | KÜNSTLICHE INTELLIGENZ

Mit Machine Learning die Logistikprozesse optimieren

Viele Unternehmen haben das Potenzial selbstlernender Systeme, die Machine Learning benutzen, erkannt. Dieser Teilbereich der künstlichen Intelligenz basiert auf Algorithmen, die Muster und Gesetzmäßigkeiten in großen Datenmengen erkennen. Mithilfe neuronaler Netze lassen sich aus den Datenbeständen Rückschlüsse ziehen und Prognosen treffen. In vielen Branchen bereits etabliert, findet Machine Learning als Analyse- und Steuerungsinstrument nun…

TRENDS 2020 | NEWS | KÜNSTLICHE INTELLIGENZ

Studie Machine Learning 2020: Maschinelles Lernen wird in deutschen Unternehmen Standard

Das Thema künstliche Intelligenz / Machine Learning (ML) hat sich in den deutschen Unternehmen etabliert. Während die Executive-Ebene das Potenzial dieser Technologie für das Business erkannt hat, begegnen ihr allerdings IT und Fachabteilung mit Skepsis. Das hat die aktuelle Studie »Machine Learning 2020« von IDG Research Services ergeben. An der Umfrage haben sich 406…

NEWS | BUSINESS INTELLIGENCE | DIGITALISIERUNG | FAVORITEN DER REDAKTION | TIPPS | WHITEPAPER

Data Preparation: In 4 Schritten zum Data-Science-Projekt

Die richtige Data Preparation erhöht die Vorhersagequalität von Datenmodellen und steigert die Wirksamkeit von Machine Learning-Zyklen. Die meisten Daten sind ohne eine vorher durchgeführte Data Preparation für KI-gestützte Prognosen ungeeignet: ihre Qualität ist unzureichend, sie liegen nicht in numerischer Form vor, oder es fehlen Werte. Diese Handlungsempfehlungen unterstützen bei der Datenvorbereitung und helfen, den…

NEWS | INFRASTRUKTUR | KOMMENTAR

Diese Trends prägen aktuell den Storage-Markt

Die Digitalisierung schreitet unaufhaltsam voran, die Datenmengen vervielfachen sich und immer mehr Daten sollen nicht nur einfach gespeichert, sondern auch analysiert werden. Damit Unternehmen auch in naher Zukunft den Wert der Daten noch voll ausschöpfen können, sollten sie bei der gegenwärtigen Storage-Technik stets mithalten und diese Trends berücksichtigen: Das Ende der alten Ordnung: die…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | FAVORITEN DER REDAKTION | GESCHÄFTSPROZESSE

Fehlerhafte Datenbestände bereinigen: Die Relevanz von Daten steigern

»Gott vertrauen wir. Alle anderen müssen Zahlen vorlegen.« So lautet ein Zitat des amerikanischen Statistikers W. Edwards Deming. Es unterstreicht die Relevanz von Messungen und Analysen für die Überprüfbarkeit von Fakten. Da das Datenvolumen jedoch exponentiell wächst, wird dieser Anspruch immer schwerer umzusetzen. Wie Unternehmen die Relevanz ihrer Daten steigern, zeigt der folgende Beitrag. Grassierende…

NEWS | BUSINESS INTELLIGENCE | CLOUD COMPUTING | FAVORITEN DER REDAKTION | TIPPS

Drei Fehler, die man bei der Modernisierung von Business-Intelligence-Lösungen vermeiden sollte

Business Intelligence hat sich von großen Software-Monolithen, welche in der Vergangenheit ausschließlich von der IT kontrolliert wurden, zu einem agileren Tool-Set gewandelt. Eine große Rolle spielt dabei auch Nutzerfreundlichkeit durch ansprechende Visualisierung. Nicht umsonst sind Angebote wie Tableau, Qlik und andere am Markt sehr erfolgreich. Sollen solche Werkzeuge nachhaltig im Unternehmen etabliert werden, müssen Verantwortliche…

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | SERVICES | TIPPS | WHITEPAPER

Wie gelangt man zu einem effektiven Data Lake?

Die schnelle Entscheidungsfindung auf Basis digitaler Daten verändert die Art und Weise, wie Unternehmen und IT arbeiten. Da Unternehmen auf alle Arten von Informationen zugreifen wollen, haben sie einen Bedarf an Infrastrukturexperten erkannt, die ihnen helfen, aus ihren Daten neue Werte zu erschließen. Rubrik, Anbieter einer Plattform für Multi-Cloud Data-Control, erläutert jüngste Entwicklungen in diesem…

NEWS | BUSINESS PROCESS MANAGEMENT | GESCHÄFTSPROZESSE | TIPPS | WHITEPAPER

MDM: 5 Tipps, wie IT-Mitarbeiter ihre Stammdaten stressfrei verwalten können

Die Dynamik der Digitalisierung erschwert das für Geschäftsprozesse so wichtige Stammdatenmanagement. Ein Master-Data-Management-System (MDM) kann verschiedene Systeme abbilden und integrieren – ohne den laufenden Betrieb zu stören. Stammdaten bilden die Basis für erfolgreiche Geschäftspartnerbeziehungen – sie sind wesentlich für eine gezielte Ansprache von Geschäftspartnern und bilden das Rückgrat für Geschäfts- und Vertriebsprozesse. Daher schätzen…

TRENDS 2020 | NEWS | KÜNSTLICHE INTELLIGENZ

Diese fünf KI-Trends werden das Jahr 2020 prägen

Das Thema künstliche Intelligenz wird die Unternehmen auch im nächsten Jahr wieder beschäftigen. Die IntraFind Software AG, ein Search-Spezialist, der für seine Lösungen auch KI und modernste Machine-Learning-Verfahren nutzt, sieht dabei fünf zentrale Entwicklungen: Echter Mehrwert von KI wird genutzt. Nach Jahren des KI-Hypes kehrt in das Thema nun langsam Vernunft ein. Immer mehr…

TRENDS 2020 | NEWS | TRENDS CLOUD COMPUTING

Digitaltrends für 2020

2020 steht vor der Tür und gibt einen willkommenen Orientierungspunkt dafür, welche Trends und Entwicklungen das kommende Jahr entscheidend mitbestimmen werden. Technologien wie künstliche Intelligenz und die Cloud entwickeln sich rasant weiter und werden auch in 2020 zu den dominierenden Themen der Digitalisierung gehören. Doch die Hürden auf dem Weg zur erfolgreichen Implementierung werden dank…