»Gott vertrauen wir. Alle anderen müssen Zahlen vorlegen.« So lautet ein Zitat des amerikanischen Statistikers W. Edwards Deming. Es unterstreicht die Relevanz von Messungen und Analysen für die Überprüfbarkeit von Fakten. Da das Datenvolumen jedoch exponentiell wächst, wird dieser Anspruch immer schwerer umzusetzen. Wie Unternehmen die Relevanz ihrer Daten steigern, zeigt der folgende Beitrag.

Grassierende Fake News in den sozialen Netzwerken sind für Menschen oft nur schwer zu erkennen und können Basis für falsche Vermutungen und Handlungen sein. Auch Mitarbeiter in Unternehmen stehen vor ähnlichen Herausforderungen: Wenn sie missbräuchlich genutzte, erfundene oder mehrdeutige Daten verwenden, kann dies Fehlentscheidungen, Reputationsschäden und Gesetzesverstöße mit erheblichen Geldbußen zur Folge haben. Seit dem Inkrafttreten der Datenschutzgrundverordnung (DSGVO) ist dieser Aspekt immer wichtiger geworden, denn die Gesetzgebung hat die Unternehmen noch stärker in die Pflicht genommen, den Überblick darüber zu behalten, welche Daten sie wo speichern und ob die Nutzung dieser Daten im Einklang mit gesetzlichen Anforderungen erfolgt.

Im Gegensatz zu »echten« Fake News, die die öffentliche Meinung beeinflussen sollen oder in satirischer Weise verwendet werden, sind Falschinformationen, die in Unternehmen verwendet werden, nicht unbedingt durch böse Absicht entstanden. In einem geschäftlichen Kontext kann es beispielsweise durchaus sein, dass Entscheidern schlichtweg unzureichende Daten zur Verfügung stehen, es ihnen an der erforderlichen Kompetenz zur Bewertung von Informationen mangelt oder sie voreingenommen sind, weil sie eine bestehende Hypothese nachweisen wollen. Solche Fehler lassen sich mit einem Konzept beheben, das drei Komponenten umfasst: Moderation, Management und Transparenz.

Organisation benötigen neue Funktionen, wie die eines Datenkurators sowie einen Datenschutzbeauftragten (DSB). Der Datenkurator arbeitet ähnlich wie ein Museumskurator, indem er aus einer Masse von Exponaten und Informationen die wichtigen und bedeutenden herauszieht, um eine Geschichte zu erzählen. Daten müssen so kuratiert werden, dass sich auf ihrer Grundlage die richtigen geschäftlichen Entscheidungen treffen lassen. Der DSB sorgt ergänzend für Governance. Heute – im Zeitalter von DSGVO und einer datengestützten Geschäftswelt – sind es die Unternehmen, die Verantwortung für die von ihnen gespeicherten Daten und deren Verwendung tragen müssen.

Transparenz steigern

Nach DSGVO müssen Unternehmen gegenüber ihren Kunden Transparenz zeigen. Auf Anfrage müssen sie Auskunft darüber geben, welche Daten über den Antragsteller sie warum gespeichert haben und wie sie diese nutzen. Deswegen ist es für Unternehmen von entscheidender Bedeutung, die Metadaten zur Herkunft der Dateien stets auf dem aktuellen Stand zu halten. So können die Unternehmen jegliche Änderungen katalogisieren und dabei festhalten, wann und wie Datensätze erstellt oder geändert wurden. Wenn es darum geht, die Integrität der Datenanalyse durch einen eindeutigen Änderungsverlauf zu wahren, ist eine solche Vorgehensweise unverzichtbar.

Dieser Ansatz zeigt sich beispielsweise in der Funktionsweise von Wikipedia. Grundlage dieses Modells ist eine offene Zusammenarbeit mit transparenten Aufzeichnungen darüber, welche Inhalte wann und von wem geändert wurden. Das Ergebnis ist ein sorgfältig dezentralisierter Service, der darauf abzielt, stets zuverlässige und ausgewogene Informationen bereitzustellen. Von einem solchen Ansatz können Unternehmen in ihrem Bestreben, betriebsinterne Verfälschungen und Datensilos zu beseitigen, nur lernen. Am Ende steht eine gemeinsam gepflegte und neutrale Datenplattform.

Daten verantwortungsbewusst verwalten

Doch selbst bei vollkommen transparentem Datenmanagement ist auch künftig eine Datenaufsicht unverzichtbar. Diese Instanz sorgt dafür, dass vorgenommene Änderungen den Strukturen und Regeln in Unternehmen und innerhalb der Branche entsprechen. Hierfür wird ein »Self-Service-Governance-Modell« benötigt. Dieses ermöglicht es den Benutzern, Inhalte hinzuzufügen, zu nutzen und zu bearbeiten, jedoch nur innerhalb der Grenzen eines festgelegten Regelwerks, das vom Datenkurator beaufsichtigt wird. Anders formuliert: Jeder Benutzer ist dafür zuständig, die Richtigkeit von Daten auf der Mitarbeiterebene zu gewährleisten. In Kombination mit dem Regelwerk des Datenkurators stellt ein solches Konzept sicher, dass die Richtigkeit der Daten gewährleistet wird. Weiterhin lassen sich damit Daten prüfen, denn dies ist gleichermaßen für Datenermittlung wie für Datenanalyse und Datenanreicherung relevant.

Ein weiterer Aspekt: Angesichts der schieren Menge von Informationen, die den heutigen Unternehmen zur Verfügung stehen, wird das Potenzial dieser Daten oft als erdrückende Datenflut wahrgenommen. Angesichts der zunehmenden Dezentralisierung von Informationen müssen Mitarbeiter oft auf mehrere Informationskanäle zurückgreifen, die effektiv verwaltet und zusammengestellt werden müssen, damit sie genutzt werden können. Der Datenkurator ist ein wesentlicher Akteur in diesem Prozess.

Die Anforderung der DSGVO an größere Unternehmen, einen Datenschutzbeauftragten zu benennen, festigt diese Abläufe innerhalb der eigenen Organisation. Weiterhin steht so mit dem DSB eine zentrale Anlaufstelle zur Einhaltung des Datenschutzes bereit. Diese zentrale Figur, die dafür zuständig ist, eine auf Dauer konforme Datennutzung zu gewährleisten, ist eine wertvolle Ressource für Unternehmen jeglicher Größe, die auf der Grundlage von Daten zuverlässige und umsetzbare Entscheidungen treffen wollen.

Nachholbedarf bei der DSGVO

Soweit die Theorie. Eine DSGVO-Studie von Talend hat jedoch gezeigt, dass in 2019 noch mehr als die Hälfte aller befragten Unternehmen nicht in der Lage war, Datenzugriffs- und Datenportierungsanfragen innerhalb des vorgesehenen einmonatigen Zeitraums zu bearbeiten. In der Praxis behalten Organisationen ihre personenbezogenen Daten nicht ausreichend im Blick, und oft gibt es einfach niemanden, der unter Beachtung eindeutiger Vorgaben damit beauftragt wurde, Prozesse zu verwalten, Best Practices festzulegen und die erforderlichen technischen Lösungen bereitzustellen.

Mit einem DSB kann die DSGVO allerdings auch zur treibenden Kraft für das Unternehmen werden und sich als Wettbewerbsvorteil erweisen. Die Aufgabe des DSBs sollte auch darin bestehen, erforderliche Strategien und Prozesse zu implementieren, gemeinsam mit der IT-Abteilung die geeigneten Tools auszuwählen und alle Data Workers und Geschäftsanwender an einen Tisch zu bringen. Auf diese Weise kann der DSB dafür sorgen, dass sich im Unternehmen eine hohe Sensibilität für das vorhandene Dateneigentum entwickelt. Daraus wiederum entsteht der starke Drang, die eigenen Daten auch zu schützen, und die umzusetzende Data-Governance-Strategie findet allgemein hohe Zustimmung. Die Benennung eines DSB ist der erste und wichtigste Schritt auf dem Weg zu einer gut verwalteten und verantwortungsvollen Datenmanagementstrategie.

Datenprozesse moderieren

Die Beaufsichtigung des Datenprozesses ist eine der zentralen Aufgaben von Datenkuratoren. In Social-Media-Unternehmen wie Facebook sind über 4.500 Content-Moderatoren damit befasst, von Nutzern hochgeladene Inhalte auf unangemessenes Material zu prüfen. In der Geschäftswelt bedeutet dies, dass Unternehmen hochgeladene, geänderte und geteilte Daten korrekt und auf dem neuesten Stand halten müssen.

Einer der Bereiche, in denen eine Moderation schon bald besonders wichtig sein wird, ist der zunehmende Einsatz von KI und Big Data Analytics in Unternehmen. Die Eingabe unzutreffender Verlaufsdaten in das Programm führt zu fehlerhaften Zukunftsprognosen. Im Personalbereich könnte dies zu falschen Personalprognosen führen, im Vertrieb könnte ein Produkt versehentlich der falschen Zielgruppe zugeordnet oder auf Kosten anderer Angebote ausgerichtet werden. Ein menschlicher Operator ist daher notwendig, um sicherzustellen, dass datengestützte Entscheidungen belastbar und korrekt sind. Nur so können Daten den Unternehmen tatsächlich einen Wettbewerbs- und Geschäftsvorteil verschaffen.

Datenschätze heben

Die Auswirkungen einer erfolgreichen Datenkuratierung können gar nicht hoch genug eingeschätzt werden. Eine Umfrage des US-Unternehmens CrowdFlower ergab, dass Data Scientists 80 Prozent ihrer Zeit mit der Datenaufbereitung verbringen, aber nur 20 Prozent mit der eigentlichen Datenanalyse. Mit einem Datenkurator sorgen Unternehmen für eine Verbesserung von Datenqualität, Datenverfügbarkeit und Datenintegrität und können den Zeitbedarf auf diese Weise erheblich verringern. So würden sie nicht mehr von der Flut der Daten überwältigt, sondern könnten von individuellen und branchenspezifischen Erkenntnissen profitieren.

Jean-Michel Franco, Director, Product Marketing Data Governance, Talend

NEWS | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | TRENDS 2016 | INFOGRAFIKEN

Apache-Spark-Studie zeigt Wachstum bei Anwendern und neuen Workloads wie Data Science und Machine Learning

Zum besseren Verständnis der zunehmenden Bedeutung von Spark bei Big Data hat die Taneja Group ein großes Marktforschungsprojekt durchgeführt und rund 7.000 Teilnehmer befragt. In die weltweit angelegte Analyse wurden Führungskräfte aus Technik und Verwaltung einbezogen, die unmittelbar mit dem Thema Big Data zu tun haben. Die mit überwältigender Resonanz abgeschlossene Studie gibt Aufschluss die…

NEWS | BUSINESS INTELLIGENCE | DIGITALISIERUNG | KOMMENTAR | LÖSUNGEN | SERVICES

Die neue Rolle von BI: Data Science für Jedermann

Daten sind das neue Gold. Nur danach muss gegraben und geschürft werden. Ein schweißtreibender Job, wenn Anwender nicht die richtigen Werkzeuge zur Hand haben. Welche Rolle Bottom-up-Strategien und User Experience bei der Umsetzung erfolgreicher BI-Strategien haben, zeigt Tableau derzeit eindrucksvoll mit einer Reihe an neuen Features und Produkten. Mit der digitalen Transformation nehmen Volumen und…

NEWS | TRENDS 2020 | TRENDS WIRTSCHAFT | BUSINESS INTELLIGENCE | DIGITALISIERUNG | KOMMUNIKATION | LÖSUNGEN | SERVICES

Mehr als 40 Prozent der Data-Science-Tätigkeiten werden bis 2020 automatisiert sein

Laut des IT-Research und Beratungsunternehmens Gartner werden bis zum Jahr 2020 mehr als 40 Prozent der Data-Science-Tätigkeiten automatisiert sein – dies hat sowohl eine Produktivitätssteigerung zur Folge als auch eine intensivere Nutzung von Daten und Analytics durch sogenannte »Citizen Data Scientists«. Laut Gartner können Citizen Data Scientists die Lücke zwischen den Mainstream-Self-Service-Analytics der Businessanwender und…

LÖSUNGEN | AUSGABE 7-8-2016

Wettbewerbsvorteile durch Data-Science

In allen Unternehmen mit mehr oder weniger komplexen Geschäftsprozessen ist die heute anfallende Datenmenge enorm. Es hat sich mittlerweile herumgesprochen, dass eine gezielte Analyse dieser Daten unterschiedliche positive Effekte für ein Unternehmen bringt. Der Bedarf an Data-Science-Know-how ist deshalb groß wie nie, und der Kampf um diese Ressourcen zwischen den Abteilungen ist bereits in vollem Gange.

NEWS | TRENDS WIRTSCHAFT | BUSINESS | BUSINESS INTELLIGENCE | TRENDS GESCHÄFTSPROZESSE | DIGITALE TRANSFORMATION | EFFIZIENZ | STRATEGIEN

Intuitiv versus faktenbasiert: Nachholbedarf bei Data-Science-Nutzung

An der Bedeutung intelligenter Datenanalysen als Innovationsmotor und Treiber der digitalen Transformation herrscht in neun von zehn deutschen Firmen keinerlei Zweifel mehr. Für die meisten von ihnen steht der geschäftliche Nutzen von Data Science inzwischen außer Frage. Gleichwohl vertraut noch immer jedes zweite Unternehmen bei wichtigen Entscheidungen eher der menschlichen Intuition als computergestützten Analysen und…

NEWS | AUSGABE 11-12-2019 | SERVICES | STRATEGIEN

Wissen in Datenbanken entdecken – 5 Mythen rund um Data Mining

NEWS | TRENDS 2020 | BUSINESS INTELLIGENCE

Die Trends für Business Intelligence & Big Data 2020

Welche Trends für Business Intelligence (BI), Data & Analytics werden das Jahr 2020 prägen? Im Interview gibt BARC-Chef-Analyst Dr. Carsten Bange seine Prognosen ab. Außerdem stellt er exklusiv die Ergebnisse des BARC BI Trend Monitor 2020 vor, der 2.650 Anwender von BI-Technologie zu ihren persönlichen Trendthemen befragt hat. Dr. Carsten Bange, Gründer und Geschäftsführer von…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | ONLINE-ARTIKEL | STRATEGIEN

Big Data: Wo die wilden Daten leben

Data Lakes, Data Marts, Data Vaults und Data Warehouses. Worin unterscheiden sich die verschiedenen Ansätze der Dateninfrastruktur? Big Data oder Data Analytics sind einige der größten Herausforderungen für die IT unserer Zeit. Viele Unternehmen befinden sich inmitten einer Umstellung auf eine datengesteuerte Ausrichtung ihrer Organisation und sind auf der Suche nach der dazu passenden Dateninfrastruktur.…

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN

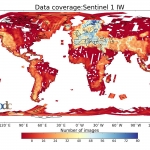

Klimawandel und Big Data: Ein Speichersystem ohne Grenzen für die Erdbeobachtung

Was hat sich durch den Klimawandel auf der Welt verändert? Was bedeutet das für die Menschen? Welche Maßnahmen sind wichtig, um den Klimawandel zu stoppen – oder um zumindest seine Folgen zu bewältigen? Diese Fragen stehen nicht erst seit Greta Thunberg im Fokus des öffentlichen Interesses und werden auch in Zukunft eine zentrale Rolle spielen.…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

Das Potenzial von Machine Learning in einem Data Lake

Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem…

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Big Data im Alltag – Wie die Analyse großer Datenmengen unser aller Leben beeinflusst

NEWS | BUSINESS INTELLIGENCE | ONLINE-ARTIKEL | SERVICES | STRATEGIEN

Fünf Vorurteile über Data Analytics

Die Entwicklungen von Big Data, Machine Learning und künstlicher Intelligenz werden 2019 wieder zu einem spannenden Jahr machen. Dank der Zukunftstechnologien gewinnt vor allem die Datenanalyse an Fahrt und Unternehmen werden noch weniger um die effektive Auswertung ihrer Informationen herumkommen. Manch einer tut sich aber schwer mit dieser neuen, tragenden Säule im Geschäftsalltag. IT-Experten sehen…

NEWS | CLOUD COMPUTING | DIGITALISIERUNG | INFOGRAFIKEN | KÜNSTLICHE INTELLIGENZ | LÖSUNGEN | SERVICES

Big Data killed the Radio Star? Wie künstliche Intelligenz die Musikindustrie beeinflusst

Schon immer war die Musikindustrie eine, die sich konstant weiterentwickelt und an die Gegebenheiten der Welt angepasst hat. Mittlerweile hat mit Streaming, Cloud Computing und Algorithmen eine neue Ära dieser begonnen. Künstliche Intelligenz hat nicht nur die Prozesse in der Branche revolutioniert, sondern hilft uns auch dabei, Musik auf eine neue Art und Weise wahrzunehmen…