10 Fragen und Antworten rund um Data Quality und Stammdatenmanagement.

Die Achillesferse für eine effiziente Digitalisierung liegt nicht in der Technik. Der entscheidende Schwachpunkt sind die Daten. Schleicht sich im digitalisierten Prozess eine Null zu viel ein oder fehlen wichtige Angaben, hat der gesunde Menschenverstand keine Chance mehr einzugreifen. Diese Schwäche lässt sich nur mit einem stringenten Fitnessprogramm für Daten beseitigen. Der ERP-Hersteller proALPHA hat 10 häufige Fragen und Antworten über Data-Quality- und Stammdatenmanagement zusammengefasst:

- Lässt sich Datenqualität überhaupt vernünftig messen und bewerten?

Experten beschreiben bis zu 15 theoretische Dimensionen von Datenqualität. Die Praxis ist einfacher: Automatisierte Prozessschritte müssen vor allem mit vollständigen, aktuellen und vor allem eindeutigen Daten arbeiten. Denn bei Dubletten im Teilestamm oder in den Kundendaten schwächelt die Effizienz. Existieren etwa für einen Kunden zwei Datensätze, kann dies dazu führen, dass er wie ein C-Kunde behandelt wird, obwohl er tatsächlich zu den B-Kunden zählt.

Dabei ist nicht jede Information gleich wichtig. Denn verschiedene Schreibweisen einer Adresse haben nicht die gleiche Auswirkung auf die Prozessfitness wie eine fehlende Konditionenliste für einen Lieferanten. Deshalb gehört zur Messung der Datenqualität auch immer eine Bewertung der gefundenen Fehler. Besonders kritische Fälle erfordern zudem einen Eskalations-Workflow, um Fehler zeitnah auszumerzen. - Lohnt sich die Mühe? Ist nicht alles nach kurzer Zeit wieder genauso chaotisch wie vor einer Bereinigung?

Wer bereits mit mehreren Projekten versucht hat, die Datenqualität in den Griff zu bekommen, wird sich wie Sisyphus in der griechischen Sage fühlen. Kaum oben angekommen, rollt der Stein wieder den Berg hinunter und die Mühe beginnt von vorne. Tatsächlich zeigen Erfahrungswerte, dass der Effekt eines projektweisen Säuberns nach einer gewissen Zeit wieder verpufft. Wie beim Lauftraining heißt es dranbleiben und ein Programm für Datenqualität implementieren. - Wo am besten anfangen?

Idealerweise startet ein Unternehmen dort, wo bessere Daten den schnellsten Mehrwert liefern. Das kann im Einkauf sein, weil Lieferantenadressen, Konditionen und Wiederbeschaffungszeiten die operative Beschaffung spürbar beschleunigen. Auch ein Start in Produktion und Logistik kann helfen, Teilestämme sauber zu pflegen. Teile sind dann vollständig ihren Gruppen zugeordnet und für den Versand liegen alle nötigen Gewichtsangaben vor. Je nach Branche und Unternehmen können auch Vertrieb und Service besonders stark profitieren, wenn Adress- und Vertragsdaten aktuell sind. - Lässt sich ein Datenqualitätsprogramm auch ohne Analysegurus oder Excel-Spezialisten etablieren?

Moderne Analyseprogramme kommen heute völlig ohne Programmierung aus. Das Definieren der Regeln ist für einen User, der sich im System etwas auskennt, kein Hexenwerk. Sind die Regeln einmal definiert, erhalten die Mitarbeiter der Fachabteilung einen Hinweis, welche Daten neu zu korrigieren sind. Im Idealfall können sie sich unmittelbar zu dem betroffenen Datensatz durchklicken. Das spart Zeit. Kurzfristige Korrekturen sorgen außerdem für einen raschen Lerneffekt. Die Fehlerhäufigkeit geht damit ganz natürlich zurück. - Wie schnell lassen sich solche Regelwerke an neue Anforderungen anpassen?

Änderungen sind heute sehr kurzfristig machbar. Denn moderne Analysewerkzeuge erfordern weder die Programmierung durch einen Softwarehersteller noch einen IT-Experten. Allerdings müssen Unternehmen dabei sicherstellen, dass sich Regeländerungen nicht widersprechen oder an anderer Stelle zu Problemen führen. Ohne eine Data Governance geht es nicht. - Müssen für eine laufende Datenprüfung und Bereinigung alle Daten in einem System sein?

Wer das postuliert, denkt weltfremd. Denn die allermeisten Unternehmen arbeiten heute mit mehr als einem System. Prüfsoftware, sogenannte Data Quality Manager, integrieren heute mühelos Daten mehrerer Quellen und prüfen sie gemeinsam. - Wie bekommt man das Thema international in den Griff?

Hier führt am Stammdatenmanagement kein Weg vorbei. Klare Verantwortlichkeiten sind dabei das A und O: Wer ist für welche Daten zuständig, wer darf und wer muss welche Daten ändern – und wo, in welchem System. Das Stammdatenmanagement regelt, welche Daten zentral und welche lokal gepflegt werden, und sorgt für die nötige Synchronisation. - Wie lässt sich ein Fortschritt zuverlässig messen und dokumentieren?

Das Reporting regelmäßiger Analyseläufe darf sich nicht nur auf den Ausweis einzelner Fehler beschränken. Es muss auch ein Controlling im Sinne eines „state of the data“ ermöglichen. Dieser Zustandsbericht zeigt der Fachabteilung sowie dem Management, dass sich Datenbereinigung lohnt und die Bemühungen Früchte tragen – und das nachhaltig. Es kann sich hier sogar ein gesunder Wettbewerb unter den Bereichen entwickeln. - Wie läuft ein Programm für kontinuierliche Datenqualität ab?

Eine Data Quality Manager-Software prüft die zuvor extrahierten Teilestämme, Kundendateien oder andere Daten gegen ein Regelwerk. So sind zum Beispiel Postleitzahlen in Großbritannien alphanumerisch, in Deutschland oder Österreich bestehen sie dagegen nur aus Ziffern. Auch Prüfungen gegen externe Datenbanken, die etwa Postleitzahl und Straße plausibilisieren, sind möglich. Neben der reinen Fehlererkennung kategorisiert die Software, ob es sich um schwerwiegende Mängel oder um Defizite mit geringer Tragweite handelt. Die gefundenen Fehler werden dann nebst Bewertung an das Zielsystem übergeben. In den meisten Fällen ist das ein ERP-System. Dort können dann die Mitarbeiter direkt die Daten bereinigen. Wird ein Ausnahmefall festgestellt, wird dieser neu im Regelwerk vermerkt. All dies lässt sich heute bewerkstelligen, ohne dass ein Mitarbeiter oder ein Berater eine Zeile Code programmieren müsste. - Wie oft sollten Datenbestände geprüft werden?

Dafür gibt es keine festen Vorgaben. Die Frequenz hängt sehr vom jeweiligen Unternehmen, seinen Abläufen und Datenbeständen ab. Wie jedes Fitnessprogramm wird es auf die individuellen Ziele und Leistungsparameter abgestimmt. Entscheidend ist, dass kontinuierlich und regelmäßig geprüft und der Fortschritt gemessen wird.

Die meisten Unternehmen sind sich ihrer Achillesferse inzwischen bewusst und bereit, aktiv etwas für die Datenqualität zu tun. Diejenigen, die schon begonnen haben, berichten von einem doppelten Trainingseffekt: Das Data Quality Management sorgt zum einen intern für mehr Produktions- und Prozesssicherheit – und so für fundierte Entscheidungen. Zusätzlich steigern verlässliche Aussagen über Liefertermine und Verfügbarkeiten bei Kunden sowie Lieferanten die Zufriedenheit und beschleunigen die Zusammenarbeit.

164 Artikel zu „Datenqualität“

NEWS | LÖSUNGEN | STRATEGIEN

Nachhaltiges Datenqualitätsmanagement – einfacher als gedacht

In langfristig genutzte Wertobjekte wie eine Maschine, ein Fahrzeug oder ein Gebäude investieren wir regelmäßig, um ihre Qualität und Funktionalität zu erhalten. Ohne permanente Wartung ist der schnelle Wertverlust absehbar. Das gilt auch für die Daten in Unternehmen und Organisationen. Vor allem die Stammdaten sind »langlebige Wertobjekte«, die permanent gepflegt werden müssen.

NEWS | BUSINESS PROCESS MANAGEMENT | DIGITALE TRANSFORMATION | GESCHÄFTSPROZESSE | LÖSUNGEN | OUTSOURCING | SERVICES

Wie hohe Datenqualität die elektronische Rechnungsverarbeitung befeuert

Als Unternehmen ist es immer gut, Freiräume zu schaffen, um sich auf komplexe Sachverhalte sowie auf die eigenen Stärken fokussieren zu können. Das gelingt oft besser, wenn administrative Tätigkeiten wie die Rechnungserfassung und -prüfung an externe Dienstleister ausgelagert werden. Kein Wunder, dass Outsourcing in Deutschland nach wie vor gefragt ist: Laut einer aktuellen Axxcon-Studie [1]…

TRENDS 2019 | NEWS | BUSINESS INTELLIGENCE | TRENDS SERVICES

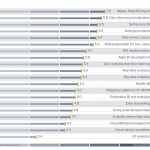

BI-Trends 2019: Business Intelligence braucht ausreichende Datenqualität

Top-Thema ist weiterhin Stammdaten- und Datenqualitätsmanagement, gefolgt von Data Discovery, Self-Service Business Intelligence und Data Governance. Der Markt für Business Intelligence (BI) und Datenmanagement unterliegt einem ständigen Wandel. Neue Trends haben besonders starken Einfluss auf die Art und Weise, wie Unternehmen arbeiten, interagieren, kommunizieren, kollaborieren und sich selbst wirtschaftlich nachhaltig aufstellen. Der BARC BI…

TRENDS WIRTSCHAFT | NEWS | BUSINESS | TRENDS CLOUD COMPUTING | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | TRENDS GESCHÄFTSPROZESSE | DIGITALE TRANSFORMATION | TRENDS 2017

Digitalisierung im Rechnungswesen führt zu höherer Datenqualität und schnellerem Reporting

Bei Unternehmen, die im Rechnungswesen auf digitale Lösungen setzen, verbessern sich häufig Datenqualität und -konsistenz. Zudem erhöht sich meist die Schnelligkeit im Reporting. Überraschend wenige Unternehmen setzen derzeitig im Rechnungswesen schon auf Cloud-Lösungen. Das sind wesentliche Erkenntnisse aus einer gemeinsamen Umfrage von KPMG und der Ludwig-Maximilians-Universität München unter knapp 150 deutschen Unternehmen zur Digitalisierung im…

TRENDS SECURITY | NEWS | BUSINESS PROCESS MANAGEMENT | TRENDS GESCHÄFTSPROZESSE | EFFIZIENZ | GESCHÄFTSPROZESSE | TRENDS 2017 | IT-SECURITY | STRATEGIEN

Studie: Hohe Datenqualität beschleunigt Applikationsentwicklung

Schlechte Brauchbarkeit von Testdaten verzögert Veröffentlichung von Software. Jedes siebte Release ist fehlerhaft. Die internationale Studie »State of Test Data Management« kommt zu dem Ergebnis, dass eine hohe Datenqualität essenziell für eine schnelle Anwendungsentwicklung ist. Die Befragung von Delphix zeigt auch: Unternehmen wollen mehr Daten für eine größere Anzahl an Teams bereitstellen. Das führt in…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | TRENDS GESCHÄFTSPROZESSE | DIGITALE TRANSFORMATION | TRENDS SERVICES | EFFIZIENZ | TRENDS 2016 | SERVICES

Hohe Stammdatenqualität kritischer Erfolgsfaktor für digitale Geschäftsmodelle

Unternehmen drohen an der digitalen Transformation zu scheitern. Zahlreiche Unternehmen in Deutschland sind aktuell für die Herausforderungen der digitalen Transformation nicht in ausreichendem Maße gerüstet. Nur etwa jedes siebte Unternehmen sieht sich bei dem dafür wichtigen Fundament Stammdatenmanagement gut aufgestellt. 85 Prozent stufen sich hier als »mittelmäßig« oder gar als »schlecht« ein. Zu diesem Ergebnis…

NEWS | TRENDS INFRASTRUKTUR | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | DIGITALE TRANSFORMATION | TRENDS SERVICES | GESCHÄFTSPROZESSE | TRENDS 2016 | RECHENZENTRUM

Ohne hohe Stammdatenqualität keine erfolgreiche digitale Transformation

Datenqualität nimmt großen Einfluss auf Digitalisierungserfolg. Bei Strukturen und Prozessen zur Verwaltung der Stammdaten besteht sehr hoher Optimierungsbedarf. Fachbereiche dürfen Verantwortung für Stammdaten insbesondere bei Digitalisierungsprojekten nicht an IT abgeben. Ist wirkungsvolles Stammdatenmanagement eine oftmals unterschätzte Herausforderung für die moderne Unternehmensführung? Dieser Frage ist das Marktforschungs- und Beratungsunternehmen Lünendonk in der aktuellen Studie »Revival der…

NEWS | BUSINESS INTELLIGENCE | KOMMUNIKATION | LÖSUNGEN | MARKETING | SERVICES | AUSGABE 11-12-2016

CRM und die Datenqualität – Erfolgsfaktor für Vertrieb und Marketing

Für eine umfassende Kundenbetreuung muss man seine Kunden genau kennen – die vorhandenen Informationen bilden die Basis für kundenorientiertes Handeln. Doch was ist wichtig und wie sieht eine fundierte Datenbasis aus? Wie pflege ich sie und welche Vorteile bietet sie mir konkret in der täglichen Arbeit mit Kundendaten?

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | GESCHÄFTSPROZESSE | TIPPS

Fünf Best Practices für eine bessere Datenqualität

Ohne eine optimale Datenqualität kommt es zu Abweichungen oder Fehlern in zentralen Geschäftsprozessen und strategische Big-Data-Analytics-Projekte sind zum Scheitern verurteilt. Eine Korrektur lässt sich nur durch ein systematisches und im idealen Fall unternehmensweites Vorgehen erzielen. Ziel einer Qualitätssteigerung ist es, die relevanten Daten aus den unterschiedlichen Quellen möglichst effizient zur Optimierung von Entscheidungs- und Geschäftsprozessen…

BUSINESS PROCESS MANAGEMENT | TOP-THEMA | AUSGABE 3-4-2015

Für erfolgreiche Geschäftsentscheidungen muss die Datenqualität stimmen

Wie sichern Verantwortliche die Qualität der eigenen Daten? Wie gewährleisten sie, dass diese aktuell und akkurat sind? Wie erfüllen sie rechtliche Vorschriften und Compliance-Anforderungen?

BUSINESS | AUSGABE 1-2-2015

Kontextbasierte Datenanalyse – Datenqualität: Erfolgsfaktor in der Digitalwirtschaft

Same-Day Delivery ist ein aktueller Trend im E-Commerce. Amazon bietet seit einiger Zeit in zehn US-Großstädten die Zustellung von Online-Bestellungen noch am gleichen Tag an. Es ist nur eine Frage der Zeit, bis der Trend auch in Europa ankommt. Doch zum Erfolg wird die Blitzlieferung nur mit hoher Datenqualität, aber in vielen Unternehmen mangelt es daran.

NEWS | BUSINESS INTELLIGENCE | LÖSUNGEN | ADVERTORIAL

Daten sammeln mit System: Das Software-Tool MIOvantage ermöglicht eine effiziente Datenqualitätsanalyse

Noch vor wenigen Jahren galt das Sammeln von möglichst vielen Daten als zentraler Erfolgsfaktor. Inzwischen ist ein weiterer Faktor hinzugekommen: Sondierungseffizienz. Die Fähigkeit, große Datenmengen schnell und systematisch sondieren und analysieren zu können, ist heute mindestens ebenso wichtig wie der Zugang zu den Daten selbst. Mit dem Software-Tool MIOvantage steht Unternehmen jetzt ein sehr leistungsfähiges Werkzeug für das schnelle Inspizieren von Rohdaten bzw. für die Kontextstrukturierung von Massendaten zur Verfügung.