Euronext nutzt Data Lake in der AWS-Cloud und bietet aktuelle Marktdaten als erweiterten Service.

Mit der Trennung von der New York Stock Exchange wurde die Euronext im Jahr 2014 die erste länderübergreifende Börse der Eurozone. Hier sind Handelsplätze wie Amsterdam, Brüssel, Dublin, Lissabon und Paris vereint. Mit einer Marktkapitalisierung von 3,7 Billionen Euro (Stand März 2018) und knapp 1.300 Emittenten ist Euronext damit die größte Börse in Kontinentaleuropa.

Im Jahr 2016 begann Euronext mit der Migration ihrer Daten in die Cloud. Das System umfasste zu diesem Zeitpunkt rund 100 Terabyte und zählte damit zu den größten Datenbanksystemen in Europa. Das Ziel des Migrationsprojekts war, einen verwalteten Data Lake mit Self-Service-Funktionen zu implementieren, sodass Geschäftseinheiten und Kunden selbstständig auf die benötigten Daten zugreifen können. Euronext verfolgte damit das Ziel, neue Dienstleistungen schaffen und zusätzliche Umsätze generieren.

Entscheidung für die Hybrid Cloud

Die Börse verwendet mit Optiq eine Handelsplattform, deren Systeme mit Antwortzeiten im Nanosekundenbereich arbeiten. Die riesige Euronext-Datenbank ist der aktive Speicher für Transaktionen. Dort werden 1,5 Milliarden Nachrichten pro Tag verarbeitet. Die Datenbank wird zwar bereits mit einer Quote von 400 Prozent komprimiert, aber dennoch konnten nicht alle Informationen aus Platzmangel damals archiviert werden.

Vor 2016 wurden alle Daten auf lokalen Storage-Systemen gespeichert. Die Anforderungen an den Speicher wuchsen immer weiter, insbesondere nach Übernahmen verschiedener Börsen, wie der Dublin Stock Exchange. Zudem erforderten Regularien die Aufbewahrung von immer mehr Daten. Nach Börsenschluss konnte es sechs bis zwölf Stunden dauern, bis die Börse Daten für ihre Kunden aufbereitet hatte.

Die Börse entschied sich schließlich für ein Hybrid-Cloud-Modell. So werden weiterhin einige Informationen der Trading-Plattform lokal gespeichert, da Latenzzeiten in der Cloud nicht konfigurierbar sind. Bei der Cloud setzt Euronext auf AWS Managed Services im Serverless-Modus mit Amazon S3 Storage für unlimitierte Speicherkapazität. Für Analysefunktionen setzt die Börse auf Amazon Redshift. Durch die hohe Skalierbarkeit der Cloud kann das Unternehmen flexibel auf bevorstehende Marktereignisse reagieren, die hohe Transaktionsvolumen erzeugen könnten.

Eine wichtige Voraussetzung für den Übergang zu einem Platform as a Service-Modell (PaaS) ist jedoch eine Unabhängigkeit von dem Cloud-Anbieter. Euronext hat sich daher für eine Lösung von Talend entschieden, um in einen Data Lake die Echtzeitdaten einzuspielen. Hierbei werden sowohl interne Daten aus der eigenen Handelsplattform als auch externe Daten, beispielsweise von Nachrichtendiensten wie Reuters oder Bloomberg, verarbeitet.

Der Kern des Data Lakes wird von Talend verwaltet. Für die Börse war es wichtig, von den unterhalb der Talend-Lösung liegenden Architekturschichten unabhängig zu bleiben, um künftig bei Bedarf die Cloud wechseln zu können.

Mit dem Data Catalog Geld und Zeit sparen

In einer sehr stark regulierten Welt ist es notwendig, dass die neue Lösung dabei hilft, Themen wie Data Governance umzusetzen und regulatorische Vorschriften einzuhalten. Um Daten sicher bereitstellen zu können, ist es wichtig, die eigenen Daten genau zu kennen. Dazu zählt, Veränderungen sowie hinzugefügte Datenquellen zu dokumentieren und die Informationen in einer granularen Struktur zu klassifizieren.

Da der Amazon S3 Speicher von jedem nutzbar ist, muss das Unternehmen wissen, wer der Besitzer der Daten ist, wer welche Zugriffsrechte hat, wer Freigaben erteilen darf und wer welche Prioritäten über wen hat. Data Stewards haben die Aufgabe, die Prozesse rund um die Organisation der Daten zu überwachen.

Die Governance-Strategie wird über die Lösung Talend Data Catalog abgebildet. Für jedes technische Projekt und für jeden Markt wird ein Datenverzeichnis angelegt. So wird die Historie der Datennutzung von der Quelle bis zum Reporting transparent. Anwender können damit beispielsweise erkennen, dass S3 eine Datenquelle ist und können diese Daten mit weiteren Informationen veredeln oder mit Redshift in andere Daten konvertieren. Weiterhin lassen sich Tags hinzufügen, die zum Beispiel über die Dauer der Datenspeicherung informieren. Euronext nutzt diese Funktion, um festzulegen, ob Daten für zehn Jahre aufbewahrt werden müssen oder nur für fünf Jahre, wie es MiFID II vorschreibt. Oder auch, ob die Daten archiviert werden können.

Gleichzeitig haben sich Abläufe rund um die Datenverwendung vereinfacht. Will Euronext beispielsweise einen Index an der britischen Börse verändern, wird dieser zunächst im eigenen System abgebildet. Anschließend macht sich dieser Index selbstständig in den angeschlossenen Handelssystemen bekannt. Zuvor waren rund 200 Manntage notwendig, um herauszufinden, in welchen Systemen der Index genutzt wurde. Mit dem neuen Datenverzeichnis stehen diese Informationen mit einem Mausklick zur Verfügung.

Mit Echtzeitdaten Umsätze generieren

Schon zwei Jahre nach Start wertete Euronext das Projekt eines verwalteten Data Lake mit Talend und AWS als einen Erfolg. Auf der technischen Seite kann das Unternehmen inzwischen zehnmal so viele Iso-Budget-Daten verwalten wie zuvor. Über die verbesserte Infrastruktur hinaus kann sich die Börse nun auch als Datenhändler positionieren. Der Verkauf von Daten macht inzwischen 20 Prozent der Umsätze von Euronext aus.

Händler, die an der Börse kaufen und verkaufen, treffen ihre Investitionsentscheidungen in Millisekunden. Sie haben einen großen Bedarf an aggregierten Daten, die in Echtzeit bereitgestellt werden: Wer verkauft welche Aktien an wen, zu welchem Preis und wann? Die Euronext-Börse kann Daten über den französischen CAC 40 oder andere Indizes aufbereiten und diese Informationen an Investoren über einen Datashop vertreiben.

Darüber hinaus können die eigenen Mitarbeiter im Self-Service-Verfahren auf Daten in Echtzeit zugreifen, um in Data-Sandboxes ein Monitoring des Marktes vorzunehmen. In weniger als einem Tag kann Euronext heute für Data Scientists eine Systemumgebung für diese Analysen aufsetzen. Dies dauerte zuvor 40 Tage. Darüber hinaus beschleunigten sich D+1-Analysen hin zu Echtzeitanalysen. Diese sind fundamental, um zu verstehen, wie Märkte, Kunden und Wettbewerber miteinander interagieren.

Diese Entwicklung war für Euronext ein echter Wendepunkt. Schon im Jahr 2016 wurde der Bedarf für eine solche Lösung identifiziert, aber das Unternehmen hatte nicht die Kapazität für die Umsetzung. Damals konnte nur das Volumen der Marktaktivitäten an die Regulierungsbehörden weitergeben werden (MiFID II). Heute muss die Börse nach der DSGVO wissen, wo personenbezogene Daten gespeichert werden. Anfragen für eine Änderung oder das Löschen von Daten können die Mitarbeiter über das Datenverzeichnis sehr schnell durchführen. Ebenso kann ein Benutzer, der eine Transaktion sucht, sofort erkennen, ob sie vertraulich ist. Sobald Daten als kritisch identifiziert wurden, kann der Data Steward den Zugriff durch Anwender verweigern.

Fazit

Euronext ist noch lange nicht am Ende ihrer digitalen Transformation angekommen. Derzeit werden goldene Datenquellen definiert, die für alle Systeme und Funktionsbereiche gültig sind, also für CRM, Trading, Rechnungsstellung, Finance und weitere. Das Ziel ist, die Qualität aller Euronext-Daten weiter zu verbessern, beispielsweise um festzustellen, ob ein Kunde über alle internen Plattformen hinweg konsistent angelegt ist. Solche Qualitätsstandards machen die Daten noch wertvoller.

Jan Wetzke, Director Sales DACH bei Talend

51 Artikel zu „Data Lake“

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

Das Potenzial von Machine Learning in einem Data Lake

Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem…

BUSINESS INTELLIGENCE | TOP-THEMA | AUSGABE 3-4-2015

Data Lake statt Data Warehouse – Im Zuhause für Big Data erfolgreich fischen

Daten, so war auf der CeBIT immer mal wieder zu hören, seien doch ein recht dröges Thema. Big Data hingegen, das sei eine spannende Sache. Nicht zuletzt wegen seiner engen Verbindung mit dem Internet der Dinge. Also eine wichtige Zukunftstechnologie. Tatsächlich geht es aber auch bei Big Data um nichts anderes als das Zusammenführen von strukturierten und unstrukturierten Daten beispielsweise aus dem Internet of Things oder Social Media.

NEWS | BUSINESS | TRENDS CLOUD COMPUTING | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | TRENDS SERVICES | FAVORITEN DER REDAKTION | TRENDS 2020 | KÜNSTLICHE INTELLIGENZ

Analytics reicht nicht mehr aus: Top-Trends im Big-Data-Umfeld 2020

Wide Data, DataOps, Metadaten-Kataloge, Datenkompetenz und Shazamen sind die wichtigsten Trends im kommenden Jahr. Für 2020 hat der Data-Analyst-Spezialist Qlik folgende fünf Trends im Zusammenhang mit Big Data und Analytics identifiziert: Aus Big Data wird Wide Data Dank skalierbarer Cloud-Lösungen sind in Big-Data-Umgebungen nicht länger die Kapazitätslimits unternehmensinterner IT-Infrastrukturen ein begrenzender Faktor. Die Herausforderung…

NEWS | BUSINESS INTELLIGENCE | TRENDS 2020

Die Trends für Business Intelligence & Big Data 2020

Welche Trends für Business Intelligence (BI), Data & Analytics werden das Jahr 2020 prägen? Im Interview gibt BARC-Chef-Analyst Dr. Carsten Bange seine Prognosen ab. Außerdem stellt er exklusiv die Ergebnisse des BARC BI Trend Monitor 2020 vor, der 2.650 Anwender von BI-Technologie zu ihren persönlichen Trendthemen befragt hat. Dr. Carsten Bange, Gründer und Geschäftsführer von…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | ONLINE-ARTIKEL | STRATEGIEN

Big Data: Wo die wilden Daten leben

Data Lakes, Data Marts, Data Vaults und Data Warehouses. Worin unterscheiden sich die verschiedenen Ansätze der Dateninfrastruktur? Big Data oder Data Analytics sind einige der größten Herausforderungen für die IT unserer Zeit. Viele Unternehmen befinden sich inmitten einer Umstellung auf eine datengesteuerte Ausrichtung ihrer Organisation und sind auf der Suche nach der dazu passenden Dateninfrastruktur.…

AUSGABE 9-10-2019 | NEWS | BUSINESS PROCESS MANAGEMENT | LÖSUNGEN | SERVICES

Von Big Data zu Smart Data – Öl des 21. Jahrhunderts

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN

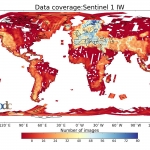

Klimawandel und Big Data: Ein Speichersystem ohne Grenzen für die Erdbeobachtung

Was hat sich durch den Klimawandel auf der Welt verändert? Was bedeutet das für die Menschen? Welche Maßnahmen sind wichtig, um den Klimawandel zu stoppen – oder um zumindest seine Folgen zu bewältigen? Diese Fragen stehen nicht erst seit Greta Thunberg im Fokus des öffentlichen Interesses und werden auch in Zukunft eine zentrale Rolle spielen.…

NEWS | BUSINESS INTELLIGENCE | STRATEGIEN | AUSGABE 3-4-2019

Vorsprung durch Wissen – Die Ära von Big Data kommt noch

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | INFRASTRUKTUR | OUTSOURCING | ONLINE-ARTIKEL | SERVICES

6 Gründe für ein Cloud-basiertes Data Warehouse

Ein Data Warehouse, das Daten aus verschiedenen Quellen zusammenfasst, um sie analysieren und darauf reagieren zu können, ist heute entscheidend für den Geschäftserfolg. Denn es verarbeitet schnell die enormen Datenmengen, die sich heute in Unternehmen ansammeln. Darauf basierend können Führungskräfte zuverlässige datenbasierte Entscheidungen treffen. Allerdings halten es fast zwei Drittel der kürzlich befragten Experten für…

NEWS | DIGITALISIERUNG | FAVORITEN DER REDAKTION | LÖSUNGEN | ONLINE-ARTIKEL

Wie Automatisierung des Data Warehouse den Wert der Unternehmensdaten erhöhen kann

Volume, Velocity, Variety, Veracity. Im englischen IT-Sprachgebrauch haben sich die vier Vs der Datenspeicherung längst etabliert. Volumen, Geschwindigkeit, Vielfalt und Wahrhaftigkeit gilt es in Einklang zu bringen, um die Daten eines Unternehmens erfolgreich verwalten zu können. Herkömmliche Data-Warehouse-Infrastrukturen sind häufig nicht mehr in der Lage, die enormen Datenmengen, die Vielfalt der Datentypen, die Geschwindigkeit mit…

TRENDS 2019 | NEWS | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | DIGITALE TRANSFORMATION | TRENDS SERVICES | OUTSOURCING

Ertragsoptimierung bei Cloud-Data-Warehouse-Investitionen

Immer mehr datengestützte IT-Systeme werden in die Cloud verlagert und dazu gehört auch das Data Warehouse. Neue Cloud-Data-Warehouse-Lösungen (CDW) sollen noch umfassendere Datenfunktionen, eine bessere Leistung und mehr Flexibilität als herkömmliche lokale Datenbanken bieten. Laut einer neuen Umfrage des TDWI (The Data Warehousing Institute) im Auftrag von Talend bieten neue Cloud-Data-Warehouse-Lösungen (CDW) noch umfassendere…