Illustration Absmeier foto freepik

Data Lakes: Flexibilität mit eingebautem Risiko

Data Lakes sind aus modernen Datenarchitekturen kaum wegzudenken. Sie bieten Unternehmen einen skalierbaren, zentralen Speicherort für Daten unterschiedlichster Herkunft – von klar definierten Transaktionsdaten bis hin zu unstrukturierten Sensordaten. Ihre Stärke liegt in der hohen Flexibilität – doch ohne ein durchdachtes Governance-Konzept droht der vermeintliche Datenpool zu einem »Data Swamp« zu werden: unübersichtlich, inkonsistent und wenig vertrauenswürdig.

Ein Governance-Konzept stellt den Schlüssel dar, um reine Datenspeicherung auf die Stufe eines geschäftsrelevanten Mehrwerts zu heben. Sie sorgt für konsistente Definitionen, klare Verantwortlichkeiten sowie valide Daten – von der ersten Einspeisung bis hin zur finalen Analyse.

Wenn Daten zum Risiko werden: Das Governance-Defizit

Die weitverbreitete Annahme »gespeichert heißt nutzbar« ist trügerisch. Ohne ein durchdachtes Governance-Konzept wächst das Risiko des User-Zugriffs auf veraltete, inkonsistente oder unvollständige Daten. Die Folgen: beschädigtes Vertrauen, falsche Entscheidungen, verlorene Investitionen.

Ein robustes Governance-Modell stellt sicher, dass Begriffe wie »Kunde« über Abteilungsgrenzen hinweg identisch interpretiert werden. Es etabliert Prozesse zur Validierung und Profilierung direkt beim Eintritt in den Data Lake, gewährleistet Nachvollziehbarkeit und verankert IT-Arbeit in den Geschäftszielen.

Vom Rohdatenstrom zur analytischen Wertschöpfung: Governance über alle Ebenen hinweg

Ein moderner Data Lake folgt einem mehrschichtigen Architekturprinzip – von der Erfassung unbearbeiteter Rohdaten (Layer 0) bis hin zur Bereitstellung kuratierter, analysebereiter Datensätze (Layer 4). Jede dieser Schichten stellt spezifische Anforderungen an Datenqualität, Strukturierung sowie Metadatenmanagement.

Eine ganzheitliche Data-Governance-Strategie muss sämtliche Ebenen durchgängig adressieren. Durch den Einsatz KI-gestützter Regeltransfers lassen sich Qualitäts-, Sicherheits- und Strukturvorgaben automatisiert und konsistent entlang der gesamten Datenpipeline anwenden – vom Ingest bis zur analytischen Veredelung der Daten.

Das Ergebnis ist eine skalierbare, hochverfügbare und durchgängig überwachte Dateninfrastruktur, die eine konsistente Datenqualität über alle Verarbeitungsschritte hinweg sicherstellt und damit eine verlässliche Grundlage für datengetriebene Wertschöpfung bildet.

Echtzeit ist nicht gleich zuverlässig: Qualitätssicherung im hochfrequenten Datenstrom

Moderne Technologien wie Change Data Capture (CDC) sowie Datenreplikation ermöglichen die Übertragung von Daten nahezu in Echtzeit – oft innerhalb von Millisekunden. Doch Geschwindigkeit allein garantiert keine Datenintegrität. Fehlende Attributwerte, Inkonsistenzen oder inkorrekte Sequenzierungen können unbemerkt in den Data Lake gelangen und dort weitreichende Auswirkungen auf Analysemodelle und nachgelagerte Systeme entfalten.

An diesem Punkt greift eine robuste Data-Governance-Strategie: Durch definierte Prüfregeln, automatisierte Mechanismen zur Validierung sowie kontinuierliches Monitoring wird sichergestellt, dass Echtzeitdaten nicht nur schnell, sondern auch vollständig, konsistent und vertrauenswürdig bereitgestellt werden.

Datenqualität ist eine strategische Führungsaufgabe – nicht nur ein IT-Thema

Traditionelle Frameworks zur Datenqualität sind häufig IT-zentriert, komplex in der Umsetzung und zu weit von fachlichen Anforderungen entfernt. Sie adressieren technische Probleme, greifen jedoch oft zu kurz, wenn es um unternehmensweite Wertschöpfung der Daten geht.

Ein moderner, geschäftsorientierter Governance-Ansatz stellt die fachliche Perspektive in den Mittelpunkt und verknüpft sie mit zentralen Technologien wie Master Data Management (MDM) sowie automatisierten Prozessen zum Matching und der Bereinigung. So lassen sich systemübergreifende Inkonsistenzen effizient auflösen und konsolidierte, aktuelle und vertrauenswürdige Datenbestände etablieren.

Daraus ergeben sich insgesamt weniger manuelle Korrekturen, beschleunigte Analyseprozesse sowie datengetriebene Entscheidungen mit höherer Genauigkeit und strategischer Relevanz.

Data Scientists von manueller Datenbereinigung entlasten – durch gezielte Governance

Wird ein Data Lake ungefiltert oder unstrukturiert befüllt, verbringen hochqualifizierte Data Scientists einen erheblichen Teil ihrer Arbeitszeit mit der Korrektur, Bereinigung und Harmonisierung von Rohdaten – anstatt diese in die Entwicklung von Modellen, Machine-Learning-Experimenten und analytischen Innovationen zu investieren.

Ein durchgängiges Data-Governance-Framework schafft hier Abhilfe: Es stellt sicher, dass Daten bereits vor der Analyse validiert, konsolidiert und mit relevanten Metadaten angereichert sind. So erhalten Data Scientists Zugriff auf verlässliche, konsistente und qualitätsgesicherte Daten – als belastbare Grundlage für analytische Wertschöpfung.

Der Mehrwert für Unternehmen liegt in beschleunigten, datenbasierten Entscheidungsprozessen, die eine fundierte und agile Steuerung ermöglichen. Gleichzeitig werden die operative Effizienz und die Ressourcennutzung gesteigert, was zu einer besseren Auslastung vorhandener Kapazitäten führt. Durch geprüfte und nachvollziehbare Daten sinkt das Risiko von Fehlentscheidungen erheblich. Zudem wird die Zusammenarbeit zwischen IT, Fachbereichen und Analytics-Teams gestärkt, wodurch Wissen effizienter geteilt und Innovationen schneller umgesetzt werden können.

Ohne Datenqualität keine KI-Exzellenz – Governance als strategischer Enabler

Mit dem Übergang zu Cloud-nativen Architekturen und Lakehouse-Modellen wird Data Governance zu einem integralen Bestandteil moderner Datenplattformen. KI-Modelle, Machine Learning und Advanced Analytics sind nur so leistungsfähig wie die Daten, auf denen sie aufbauen. Fehlende Struktur, uneinheitliche Definitionen sowie unzureichende Metadaten-Dokumentation beeinträchtigen nicht nur die Modellqualität, sondern auch deren Skalierbarkeit und Reproduzierbarkeit.

Wird Governance von Beginn an in die Datenarchitektur eingebettet, schafft sie die Voraussetzung für robuste, vertrauenswürdige und skalierbare KI- und Analyseanwendungen. Automatisierte Prüfmechanismen, standardisierte Daten-Pipelines sowie transparente Verantwortlichkeiten sorgen dafür, dass Daten als strategischer Wert zuverlässig genutzt werden können.

Governance als Differenzierungsfaktor

Der wahre Wert eines Data Lakes liegt nicht in seiner schieren Speicherkapazität, sondern in der Qualität, Zugänglichkeit und Nutzbarkeit der darin enthaltenen Informationen. Governance hebt den Data Lake vom passiven Speicher zum aktiven Steuerungsinstrument – und schützt zugleich vor dem Kontrollverlust, den ein »Data Swamp« mit sich bringt. Der Grundsatz ist klar: wer einen Data Lake plant, ist gut beraten, Governance von Anfang an zu verankern. Nur so entsteht aus heterogenen, teils unstrukturierten Daten ein belastbarer, langfristiger Wettbewerbsvorteil.

Mary Hartwell, Global Practice Lead Data Governance, Syniti, ein Unternehmen von Capgemini

Mary Hartwell, Global Practice Lead Data Governance, Syniti, ein Unternehmen von Capgemini

269 Artikel zu „Data Lake“

News | Business Process Management | Infrastruktur | Rechenzentrum

Der Weg vom Data Swamp zum Data Lake – oder umgekehrt

Wie Unternehmen verhindern können, dass sich ihr Data Lake in einen Data Swamp verwandelt. In der modernen Datenwelt von heute ist der Begriff »Data Lake« weit verbreitet. Ein Data Lake ermöglicht es immer mehr Unternehmen, die Gesamtheit ihrer Daten auf effiziente und effektive Weise zu speichern, abzurufen und zu nutzen. Data Lakes sind ein…

News | Business Process Management | Effizienz | Favoriten der Redaktion | Infrastruktur

Königsweg Automatisierung – Der Weg zu mehr Effizienz für Data Warehouse und Data Lake

Data Warehouses haben eine lange Tradition. Doch mit Big Data Analytics und Data Lakes haben viele diesen Ansatz totgesagt. Das entspricht allerdings nicht der Realität: Geschätzt betreiben mehr als 60 Prozent der Unternehmen Data Warehouses, oft sogar mehrere. Assets, in die viel investiert wurde und die Vorteile bieten, die mit einem Data Lake nicht erreicht…

News | Business Process Management | Infrastruktur | Services | Tipps | Whitepaper

Wie gelangt man zu einem effektiven Data Lake?

Die schnelle Entscheidungsfindung auf Basis digitaler Daten verändert die Art und Weise, wie Unternehmen und IT arbeiten. Da Unternehmen auf alle Arten von Informationen zugreifen wollen, haben sie einen Bedarf an Infrastrukturexperten erkannt, die ihnen helfen, aus ihren Daten neue Werte zu erschließen. Rubrik, Anbieter einer Plattform für Multi-Cloud Data-Control, erläutert jüngste Entwicklungen in diesem…

News | Business Intelligence | Business Process Management | Künstliche Intelligenz | Online-Artikel

Das Potenzial von Machine Learning in einem Data Lake

Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem…

Business Intelligence | Top-Thema | Ausgabe 3-4-2015

Data Lake statt Data Warehouse – Im Zuhause für Big Data erfolgreich fischen

Daten, so war auf der CeBIT immer mal wieder zu hören, seien doch ein recht dröges Thema. Big Data hingegen, das sei eine spannende Sache. Nicht zuletzt wegen seiner engen Verbindung mit dem Internet der Dinge. Also eine wichtige Zukunftstechnologie. Tatsächlich geht es aber auch bei Big Data um nichts anderes als das Zusammenführen von strukturierten und unstrukturierten Daten beispielsweise aus dem Internet of Things oder Social Media.

News | Lösungen | Produktmeldung

L’Oréal steigert das Kundenerlebnis durch den Einsatz von Databricks Lakehouse

Databricks, das Daten & KI-Unternehmen, gibt bekannt, dass L’Oréal, der Anbieter von Kosmetikprodukten, sich für Databricks entschieden hat, um die Interoperabilität seiner globalen Beauty Tech Data-Plattform zu ermöglichen und seine Multi-Cloud-Strategie zu verfolgen. Mit seiner starken Führungsposition im digitalen Bereich leistet L’Oréal nun Pionierarbeit im Bereich Beauty Tech. Die Experten der L’Oréal-Gruppe nutzen Daten…

News | Infrastruktur | Strategien | Ausgabe 11-12-2020

Unified-Data-Analytics-Plattform – Databricks baut das Lakehouse fertig

News | Digitale Transformation | Favoriten der Redaktion | Geschäftsprozesse | Künstliche Intelligenz | Lösungen

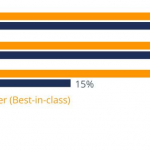

KI-Hype trifft auf Realität: Wie steht es um die Data Readiness?

Fast jedes zweite Unternehmen hat Probleme bei KI-Implementierung. Künstliche Intelligenz (KI) gilt als entscheidender Treiber der digitalen Transformation – doch der Weg zur erfolgreichen Umsetzung ist für viele Unternehmen holpriger als gedacht. Eine aktuelle globale Umfrage von Redpoint im Auftrag von Fivetran zeigt, dass bei 42 Prozent der befragten Unternehmen mehr als die Hälfte…

News | Business | Geschäftsprozesse | Services

Datenintensive Geschäftsmodelle brauchen professionelle Data Governance

Viele moderne Unternehmen sind einem großen Effizienzdruck unterworfen und müssen ihre Prozesse stark anpassen, um wettbewerbsfähig zu bleiben. Dabei setzen sie verstärkt auf datenbasierte Geschäftsmodelle, immer häufiger auf KI-Technologien. Verstärkte Nutzung und Abhängigkeit von digitalen Daten erfordern eine besonders akkurate, konsistente und regelkonforme Datenverarbeitung und -verwaltung. Das ideale Mittel dazu ist Data Governance, der systematische…

News | Künstliche Intelligenz | Services | Ausgabe 3-4-2024

Data Analytics as a Service – Mehr Erkenntnisgewinn für alle

News | Künstliche Intelligenz

Nachfrage von Unternehmen nach KI – Databricks meldet ein jährliches Wachstum von über 70 Prozent in EMEA

Der Pionier der Data Intelligence Platform begrüßt neue Kunden und investiert in EMEA, um die Einführung generativer KI in der Region zu beschleunigen Databricks, das Daten- und KI-Unternehmen, gibt bekannt, dass sein EMEA-Geschäft im vergangenen Geschäftsjahr im Vergleich zum Vorjahr um mehr als 70 Prozent gewachsen ist, angetrieben durch einen Nachfrageschub nach Daten- und KI-Funktionen…

News | Business Intelligence | Digitalisierung | Infrastruktur | Lösungen | Services

flaschenpost mit Databricks: Endlich genügend Rechenleistung für das Maximum an Datenanalyse

Anlässlich der Data & AI World Tour (DAIWT) baten wir Marco Lohaus, Head of Business Intelligence der Firma flaschenpost SE, über die Zusammenarbeit mit Databricks zu sprechen. Herr Lohaus, können Sie uns ihr Unternehmen kurz vorstellen? Die flaschenpost startete im Jahr 2016 als erster Onlineshop für die Sofortlieferung von Getränken innerhalb von 120 Minuten…

News | Business | Cloud Computing | Strategien | Ausgabe 1-2-2024

Komplett datengesteuerte Unternehmen – »Data Analytics betrifft das ganze Unternehmen«

Künstliche Intelligenz ermöglicht die Analyse von Informationen in hoher Geschwindigkeit – doch wie lässt sich die Technologie langfristig effizient nutzen? Im Gespräch mit »manage it« betont Jörg Tewes, CEO beim Nürnberger Anbieter von Hochleistungs-Analytics-Datenbanken Exasol, wie wichtig eine leistungsstarke, skalierbare Dateninfrastruktur für den erfolgreichen Einsatz von Data Analytics in Unternehmen ist.

News | Business Process Management | Digitalisierung | Künstliche Intelligenz | Rechenzentrum | Services

Databricks: Wir sind in allen relevanten Bereichen des Data-Managements der Stand der Dinge

Am 7. November 2023 hat die Firma Databricks in den Münchner Eisbachstudios die Hausmesse Data + AI Summit veranstaltet. Wir haben dort mit Roman Pritzkow gesprochen, den RVP DACH. Herr Pritzkow, zum Einstieg eine provokante Frage: Kann durch KI der Fachkräftemangel gelöst werden? Roman Pritzkow: Eine interessante Frage. Im Augenblick generiert KI mehr Bedarf…

News | Services | Strategien | Ausgabe 11-12-2023

Der Weg zur operativen Datennutzung –

All Eyes on Data

News | Produktmeldung

Databricks stellt Data Intelligence Platform vor

Databricks hat die Data Intelligence Platform auf den Markt gebracht, eine Evolution der Lakehouse-Architektur. Diese Entwicklung ist das Ergebnis der Integration von MosaicML, der bislang größten Übernahme in der Unternehmensgeschichte für 1,3 Milliarden US-Dollar im Juni 2023. Der Einfluss von KI auf Datenplattformen ist fundamental. Daher wird die neue Generation von Systemen als Data Intelligence…

News | Business Intelligence | Trends Infrastruktur | Trends 2022

Hat das Data Warehouse ausgedient?

BARC hat die Studie »The Future of Data Architecture – Has the Data Warehouse Had Its Day?« veröffentlicht. Sie basiert auf einer weltweiten Befragung von 268 Unternehmen unterschiedlicher Größe und Branchen und bietet Einblicke in die derzeit vielversprechendsten Datenarchitektur- und Datenmodellierungsansätze. Dank des Sponsorings von Precisley, TimeXtender, Denodo und Databricks kann das Dokument kostenlos heruntergeladen…

News | Business | Infrastruktur | Strategien | Ausgabe 7-8-2022

Eine Welle von Data Governance schwappt über die digitale Wirtschaft – »Beim Turmbau von Babel brauchen Sie eine Übersetzung«

News | Business Process Management | Trends 2022 | Rechenzentrum

Data-Mesh-Architektur: Daten besser nutzen

Die Dezentralisierung von Datenplattformen nimmt Fahrt auf – das Data Mesh gilt als vielversprechendes Architekturparadigma. Nachholbedarf existiert beim Self-Service: Datenanalysen bleiben bislang noch spezialisierten Teams vorbehalten. Viele Unternehmen unterschätzen die Auswirkungen einer dezentralen Datenarchitektur auf die Arbeitskultur. Das Data Mesh etabliert sich zunehmend in deutschen Unternehmen als vorherrschendes Muster für Datenplattformen. Bereits 60…

News | Business | Künstliche Intelligenz | Strategien | Ausgabe 11-12-2021

Data-Analytics-Strategie – Wie Unternehmen nachhaltig von Data Analytics profitieren

In der Breite nutzen bisher nur wenige Unternehmen künstliche Intelligenz (KI), oft bleibt die Entwicklung nach einem ersten Proof of Concept oder Pilotprojekt stecken. Damit sich das ändert, bedarf es einer funktionierenden Datenkultur. Vor allem gilt es jedoch, die Intelligenz an die richtige Stellen im Prozess zu bringen.