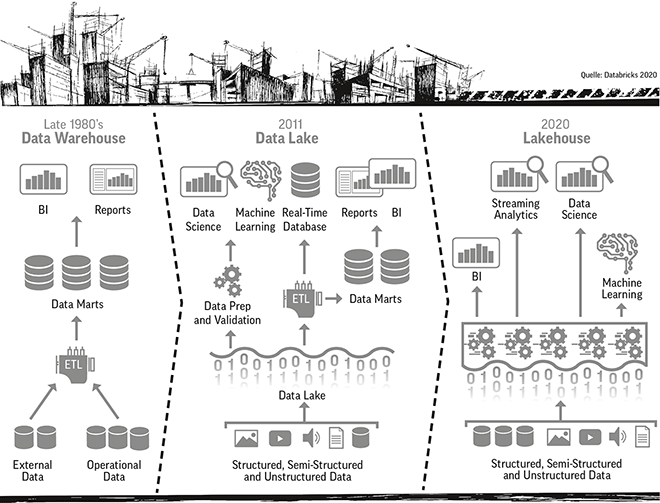

Die Lakehouse-Architektur soll die Leistung von Data Warehouses mit der Wirtschaftlichkeit von Data Lakes kombinieren.

Jedes Unternehmen wird in Zukunft ein Datenunternehmen sein, so alt der Satz ist, so bekannt ist er auch. Doch Daten allein machen noch nicht glücklich, es braucht auch Möglichkeiten die richtigen Schlüsse aus den Datenmengen zu ziehen und hier kommt Machine Learning- und KI-Technologie ins Spiel. Vielfach wurden sogenannte Data Lakes angelegt, die jedoch zu regelrechten Data Swamps verkommen sind. Darüber hinaus wurden Data Warehouses gefüllt. Doch bei all diesen Vorarbeiten bleiben die Probleme die gleichen, wie können die Daten schnell und effizient analysiert werden, ohne stundenlang die Datenformate anpassen zu müssen oder sich mühevoll die dafür notwendigen Daten zusammenzusuchen. Ein Unternehmen, dass sich dieser Aufgabe auf Basis von Apache Spark annimmt, ist Databricks, 2013 in San Francisco gegründet mit inzwischen über 1.500 Mitarbeitern weltweit. Ziel des Unternehmens ist es Data Scientists, Data Engineers und neuerdings auch Data Analysts bei ihrer Arbeit zu entlasten. Dafür hat es die Unified-Data-Analytics-Plattform geschaffen, die nun nach und nach erweitert wird. Letzte Neuerung ist das Lakehouse, damit soll die Zuverlässigkeit von Data Warehouses mit der Größe von Data Lakes kombiniert werden, um jede Art von Anwendungsfall zu unterstützen. Unternehmen können dann kuratierte Data Lakes erstellen, die strukturierte und halbstrukturierte Daten enthalten, und alle ihre Analysen auf qualitativ hochwertigen, aktuellen Daten in der Cloud ausführen. Nun baut das Unternehmen sein Lakehouse fertig. Dazu ein Gespräch mit Joel Minnick (JM), Vice President Marketing bei Databricks im Vorfeld des Data & AI Summit 2020.

Joel Minnick (JM), Vice President Marketing bei Databricks

![]()

Herr Minnick, was sind die wichtigsten Neuerungen, die Sie im Zuge der Konferenz vorstellen werden?

Wir führen SQL Analytics ein, damit Datenanalysten Workloads direkt in einem Data Lake durchführen können, anstatt in einem Data Warehouse. Damit wird der traditionelle Umfang eines Data Lakes von Data Science und ML auf alle Daten-Workloads einschließlich BI und SQL ausgeweitet. Jetzt können Unternehmen Data Teams aus den Bereichen Data Engineering, Data Science und Data Analytics an einer einzigen Datenquelle zusammenarbeiten. SQL Analytics verwirklicht unsere Vision einer Lakehouse-Architektur, die die Leistung von Data Warehouses mit der Wirtschaftlichkeit von Data Lakes kombiniert. Das führt zu einem bis zu 9x besseren Preis-Leistungs-Verhältnis als herkömmliche Cloud Data Warehouses.

![]()

Was ist die Lakehouse-Architektur?

Eine Lakehouse-Architektur vereinfacht die Datenauswertung und die Nutzung der KI. In der Vergangenheit mussten Data Teams proprietäre Data Warehouses für Business-Intelligence-Workloads und Data Lakes für Data-Science- und ML-Workloads pflegen, da keine einzige Datenplattform die Leistungsanforderungen der BI-Anwendungen und die Flexibilitätsanforderungen der Data-Science-Anwendungen erfüllen konnte. Diese Koexistenz von Legacy-Architekturen, die teuer und kompliziert in der Wartung ist, hat Datensilos geschaffen, die die Innovation verlangsamen und die Produktivität der Data Teams behindern. Ein Lakehouse löst dieses Problem, indem alle Workloads über eine einzige Architektur laufen.

![]()

Worauf baut SQL Analytics auf?

SQL Analytics baut auf Delta Lake auf, einer auf einem offenen Format basierenden Daten-Engine, die Zuverlässigkeit, Qualität und Sicherheit zu dem vorhandenen Data Lake des Kunden hinzufügt. Unternehmen können so vermeiden mehrere Datenkopien zu speichern und Daten in proprietären Formaten vorhalten zu müssen. Um BI-Performance auf einem Data Lake zu liefern, nutzt SQL Analytics zwei einzigartige Innovationen. Erstens bietet es benutzerfreundliche Endpunkte mit automatischer Skalierung, die die Abfragelatenz auch bei hoher Benutzerlast konstant niedrig halten. Zweitens verwendet es Delta Engine, unserer einzigartigen Query-Execution-Maschine, um Abfragen sowohl für große als auch für kleine Datensätze extrem schnell auszuführen. Mit nativen Konnektoren für alle wichtigen BI-Tools, einschließlich Tableau und Microsoft Power BI, können Kunden SQL Analytics problemlos in ihre bestehenden BI-Workflows integrieren, um Analysen mit wesentlich frischeren und vollständigeren Daten als je zuvor durchzuführen. SQL Analytics bietet außerdem eine SQL-native Abfrage- und Visualisierungsoberfläche, die es Analysten, Data Scientists und Entwicklern ohne Zugriff auf herkömmliche BI-Tools ermöglicht, Dashboards und Berichte zu erstellen, die problemlos innerhalb des Unternehmens gemeinsam genutzt werden können.

![]()

Welche Partner konnten Sie dafür gewinnen?

Die Lakehouse-Architektur wird von unterschiedlichen Partnern unterstützt. Sie kommen aus dem Bereich BI wie Tableau, Qlik, Looker und Thoughtspot, aus Ingest wie Fivetran, Fishtown Analytics, Talend und Matillion oder Catalog wie Collibra und Alation. Darüber hinaus haben wir uns noch Consulting-Unterstützung von Slalom, Thorogood und Advancing Analytics geholt.

Danke für das Gespräch.

Databricks hat eine Revenue Run-Rate von 350 Millionen US-Dollar in Q3 2020 erreicht, gegenüber 200 Millionen US-Dollar in Q3 2019 und gehört damit zu den am schnellsten wachsenden Software-Cloud-Unternehmen. Das Unternehmen hat seine Mitarbeiterzahl in Großbritannien, den Niederlanden, Deutschland und Schweden verdoppelt und in Australien und Indien im letzten Jahr verfünffacht hat.

Illustration: © Vectomart/shutterstock.com

118 Artikel zu „Data Lake“

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | INFRASTRUKTUR

Königsweg Automatisierung – Der Weg zu mehr Effizienz für Data Warehouse und Data Lake

Data Warehouses haben eine lange Tradition. Doch mit Big Data Analytics und Data Lakes haben viele diesen Ansatz totgesagt. Das entspricht allerdings nicht der Realität: Geschätzt betreiben mehr als 60 Prozent der Unternehmen Data Warehouses, oft sogar mehrere. Assets, in die viel investiert wurde und die Vorteile bieten, die mit einem Data Lake nicht erreicht…

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | SERVICES | TIPPS | WHITEPAPER

Wie gelangt man zu einem effektiven Data Lake?

Die schnelle Entscheidungsfindung auf Basis digitaler Daten verändert die Art und Weise, wie Unternehmen und IT arbeiten. Da Unternehmen auf alle Arten von Informationen zugreifen wollen, haben sie einen Bedarf an Infrastrukturexperten erkannt, die ihnen helfen, aus ihren Daten neue Werte zu erschließen. Rubrik, Anbieter einer Plattform für Multi-Cloud Data-Control, erläutert jüngste Entwicklungen in diesem…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

Das Potenzial von Machine Learning in einem Data Lake

Egal um welche Branche oder Unternehmensgröße es sich handelt: Daten sind unverzichtbar geworden, wenn es darum geht, fundierte Entscheidungen zu treffen oder Prozesse zu optimieren. Dazu müssen die gewaltigen Datenmengen, die Unternehmen heute ununterbrochen generieren allerdings erst erschlossen und nutzbar gemacht werden. Die Grundlage dafür bildet der Data Lake (Datensee), ein zentrales Repository, in dem…

BUSINESS INTELLIGENCE | TOP-THEMA | AUSGABE 3-4-2015

Data Lake statt Data Warehouse – Im Zuhause für Big Data erfolgreich fischen

Daten, so war auf der CeBIT immer mal wieder zu hören, seien doch ein recht dröges Thema. Big Data hingegen, das sei eine spannende Sache. Nicht zuletzt wegen seiner engen Verbindung mit dem Internet der Dinge. Also eine wichtige Zukunftstechnologie. Tatsächlich geht es aber auch bei Big Data um nichts anderes als das Zusammenführen von strukturierten und unstrukturierten Daten beispielsweise aus dem Internet of Things oder Social Media.

NEWS | BUSINESS | STRATEGIEN | AUSGABE 9-10-2020

Gut kombiniert: Data Analytics-Anwendungen mit künstlicher Intelligenz – KI-gestützt in die Zukunft

Datenanalysen gestützt durch künstliche Intelligenz (KI) stehen hinsichtlich ihres Einsatzes noch am Anfang. Doch es zeichnet sich bereits ab, dass beide immer mehr Bereiche des Geschäftsalltags erobern werden. Manage IT hat Philipp Kleinmanns, Abteilungsleiter Business Innovation bei Materna, befragt, inwieweit moderne Datenanalyse-Anwendungen und KI-Prozesse das Geschäft revolutionieren könnten.

NEWS | CLOUD COMPUTING

Datenschätze in den Wolken: Best Practices für Cloud Data Warehouses

Die Cloud bietet Unternehmen zahlreiche Vorteile und sorgt auch im Bereich Data Warehousing für hohe Skalierbarkeit und Flexibilität. Da es mittlerweile notwendig ist, Daten aus einer Vielzahl sich ständig weiterentwickelnden Datenquellen effizient zusammenzuführen und sie auf einfache Weise einem immer breiteren Kreis an Entscheidungsträgern zugänglich zu machen, haben deshalb viele Data-Warehousing-Teams begonnen, ihre Data-Warehouse-Bemühungen auf…

NEWS | STRATEGIEN

Fünf Hürden auf dem Weg zu einer erfolgreichen Data Governance

An einer umfassenden Data-Governance-Strategie führt heute kaum noch ein Weg vorbei – da sind sich die meisten modernen Unternehmen einig. Dass viele von ihnen aber noch weit von der tatsächlichen Umsetzung entfernt sind, belegt jetzt eine Dataversity-Studie aus dem Jahr 2020. Nur zwölf Prozent der befragten Unternehmen gaben hier an, eine entsprechende Strategie bereits vollständig…

NEWS | EFFIZIENZ | INFRASTRUKTUR | RECHENZENTRUM

Mit Data Vault zu mehr Agilität im Data Warehouse

Architekturen. Frameworks. Praxis. Data Vault ist eine Modellierungstechnik, mit der sich bestehende Data Warehouses (DWH) modernisieren und damit den aktuellen Anforderungen an Datenhaltung und Analytics anpassen lassen. DWH-Verantwortliche stehen unter immer größeren Druck, ihre Systeme anpassen zu müssen. Klassische DWH-Konzepte nach Inmon oder Kimball sind nicht dafür geeignet, weil sie schnell immer komplexer werden und…

NEWS | VERANSTALTUNGEN

Save the date: InfoZoom Data Quality Management Online-Konferenz im November

Die humanIT Software GmbH führt ihre jährliche InfoZoom-Kundenveranstaltung am 4. November 2020 als Online-Event durch. Die Teilnehmer erhalten in der DQM-Online-Konferenz einen Überblick über aktuelle Strategien für ein zukunftssicheres und nachhaltiges Data Quality Management. Praxisbeispiele steuern unter anderem die Anwender von Vodafone und dem LKA Rheinland-Pfalz bei. Interessenten können sich ab sofort kostenfrei anmelden unter…

NEWS | BUSINESS PROCESS MANAGEMENT | FAVORITEN DER REDAKTION | GESCHÄFTSPROZESSE | ONLINE-ARTIKEL

Datenstrategien für Big Data – Automatisierung des Data Warehouse muss Teil der Lösung sein

Im Zeitalter von Big Data könnte man davon ausgehen, dass man gar nicht genug Daten haben kann. Denn aus Daten lassen sich in der Theorie wichtige Erkenntnisse ziehen, die Unternehmen zu ihrem Vorteil nutzen können. Und so sammeln Unternehmen seit Jahren fleißig Daten aus immer mehr Quellen ein – und stehen damit auch vor der…

NEWS | BUSINESS | STRATEGIEN | AUSGABE 3-4-2020

Von Big Data zu Smart Data – Intelligente Daten für Geschäftsentscheidungen

Das Thema Big Data wird bereits seit Jahren in der Fachpresse als Trend bezeichnet. Dabei sind große Datenmengen schon seit geraumer Zeit ein Thema. Allerdings hat sich in der Handhabung von Big Data einiges getan. Der Anspruch, große Datenmengen mithilfe von IT-Unterstützung intelligent und effizient zu nutzen, ist deutlich gestiegen.

NEWS | DIGITALISIERUNG | SERVICES | STRATEGIEN

Open-Data-Initiative: Mit Datenkooperationen gegen die »Daten-Kluft«

Durch die Nutzung und den Austausch öffentlich zugänglicher Daten können fundierte Entscheidungen getroffen und sogar einige der weltweit drängendsten sozialen Herausforderungen besser bewältigt werden. So heißt es in der neuen Datenstrategie der Bundesregierung, »Daten sind eine Schlüsselressource«, etwa für die Verbesserung der Gesundheitsversorgung. Die Fähigkeit Daten verantwortungsvoll und selbstbestimmt zu nutzen, zu verknüpfen und auszuwerten,…

NEWS | BUSINESS INTELLIGENCE | DIGITALISIERUNG | FAVORITEN DER REDAKTION | TIPPS | WHITEPAPER

Data Preparation: In 4 Schritten zum Data-Science-Projekt

Die richtige Data Preparation erhöht die Vorhersagequalität von Datenmodellen und steigert die Wirksamkeit von Machine Learning-Zyklen. Die meisten Daten sind ohne eine vorher durchgeführte Data Preparation für KI-gestützte Prognosen ungeeignet: ihre Qualität ist unzureichend, sie liegen nicht in numerischer Form vor, oder es fehlen Werte. Diese Handlungsempfehlungen unterstützen bei der Datenvorbereitung und helfen, den…

NEWS | EFFIZIENZ | LÖSUNGEN | SERVICES | AUSGABE 11-12-2019

Data Quality: HELM AG modernisiert und zentralisiert Datenhaltung

Dezentral organisierte Unternehmen tun sich oft schwer, Informations- und Datenprozesse schlank, einheitlich und transparent zu organisieren. Die Digitalisierung verstärkt den Erneuerungsdruck. Die global tätige HELM AG hat es mit Hilfe einer Data-Quality-Lösung geschafft, ihre vertrieblichen und kaufmännischen Arbeitsabläufe zu optimieren. Die Software sorgt dafür, dass die neu erstellte zentrale Stammdatenbasis von Dubletten und Inkonsistenzen befreit wird und im Tagesgeschäft dauerhaft »sauber« bleibt.

NEWS | SERVICES | STRATEGIEN | AUSGABE 11-12-2019

Wissen in Datenbanken entdecken – 5 Mythen rund um Data Mining

NEWS | TRENDS 2020 | BUSINESS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | DIGITALISIERUNG | TRENDS SERVICES | FAVORITEN DER REDAKTION | KÜNSTLICHE INTELLIGENZ

Analytics reicht nicht mehr aus: Top-Trends im Big-Data-Umfeld 2020

Wide Data, DataOps, Metadaten-Kataloge, Datenkompetenz und Shazamen sind die wichtigsten Trends im kommenden Jahr. Für 2020 hat der Data-Analyst-Spezialist Qlik folgende fünf Trends im Zusammenhang mit Big Data und Analytics identifiziert: Aus Big Data wird Wide Data Dank skalierbarer Cloud-Lösungen sind in Big-Data-Umgebungen nicht länger die Kapazitätslimits unternehmensinterner IT-Infrastrukturen ein begrenzender Faktor. Die Herausforderung…

NEWS | TRENDS 2020 | BUSINESS INTELLIGENCE

Die Trends für Business Intelligence & Big Data 2020

Welche Trends für Business Intelligence (BI), Data & Analytics werden das Jahr 2020 prägen? Im Interview gibt BARC-Chef-Analyst Dr. Carsten Bange seine Prognosen ab. Außerdem stellt er exklusiv die Ergebnisse des BARC BI Trend Monitor 2020 vor, der 2.650 Anwender von BI-Technologie zu ihren persönlichen Trendthemen befragt hat. Dr. Carsten Bange, Gründer und Geschäftsführer von…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | ONLINE-ARTIKEL | STRATEGIEN

Big Data: Wo die wilden Daten leben

Data Lakes, Data Marts, Data Vaults und Data Warehouses. Worin unterscheiden sich die verschiedenen Ansätze der Dateninfrastruktur? Big Data oder Data Analytics sind einige der größten Herausforderungen für die IT unserer Zeit. Viele Unternehmen befinden sich inmitten einer Umstellung auf eine datengesteuerte Ausrichtung ihrer Organisation und sind auf der Suche nach der dazu passenden Dateninfrastruktur.…

NEWS | BUSINESS PROCESS MANAGEMENT | LÖSUNGEN | SERVICES | AUSGABE 9-10-2019

Von Big Data zu Smart Data – Öl des 21. Jahrhunderts

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN

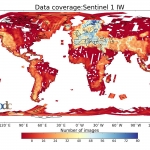

Klimawandel und Big Data: Ein Speichersystem ohne Grenzen für die Erdbeobachtung

Was hat sich durch den Klimawandel auf der Welt verändert? Was bedeutet das für die Menschen? Welche Maßnahmen sind wichtig, um den Klimawandel zu stoppen – oder um zumindest seine Folgen zu bewältigen? Diese Fragen stehen nicht erst seit Greta Thunberg im Fokus des öffentlichen Interesses und werden auch in Zukunft eine zentrale Rolle spielen.…