Die Cloud bietet Unternehmen zahlreiche Vorteile und sorgt auch im Bereich Data Warehousing für hohe Skalierbarkeit und Flexibilität. Da es mittlerweile notwendig ist, Daten aus einer Vielzahl sich ständig weiterentwickelnden Datenquellen effizient zusammenzuführen und sie auf einfache Weise einem immer breiteren Kreis an Entscheidungsträgern zugänglich zu machen, haben deshalb viele Data-Warehousing-Teams begonnen, ihre Data-Warehouse-Bemühungen auf die Cloud umzustellen.

Ein Cloud Data Warehouse ist ein Datenbankservice, der online von einem Public-Cloud-Anbieter gehostet wird. Es verfügt über die Funktionalität einer On-Premises-Datenbank, wird jedoch von einer Drittpartei verwaltet, kann per Fernzugriff aufgerufen werden, und sein Speicher und seine Rechenleistung können bei Bedarf sofort verkleinert oder erweitert werden.

Unterschiede zwischen traditionellen und Cloud Data Warehouses

Ein traditionelles Data Warehouse ist eine Architektur für die Organisation, Speicherung und den Zugriff auf angeforderte Daten, die On-Premises in einem Rechenzentrum des Unternehmens gehostet wird. Das klassische Data Warehouse hat eine endliche Größe und Leistung und befindet sich im Besitz der Organisation, deren Daten darin gespeichert sind.

Ein Cloud Data Warehouse bietet ein flexibles Volumen an Speicher- und Rechenleistung, ist Teil eines Public-Cloud-Rechenzentrums, online zugänglich und wird extern verwaltet. Die Speicher- und Rechenleistung wird lediglich gemietet. Sein physischer Standort ist weitgehend irrelevant, außer für Länder und/oder Branchen, deren Regularien vorschreiben, dass Daten im selben Land des jeweiligen Unternehmens gespeichert werden müssen.

Fünf Vorteile von Cloud Data Warehouses

Die Vorteile eines Cloud Data Warehouses lassen sich in fünf Kernpunkten zusammenfassen:

- Zugang

Anstatt nur physischen Zugang zu Datenbanken in Rechenzentren zu haben, kann auf Cloud Data Warehouses von jedem beliebigen Ort aus zugegriffen werden. Mitarbeiter können bei Bedarf auch von zu Hause aus oder außerhalb der Geschäftszeiten Fehler beheben. Dieser flexible Zugriff bedeutet zudem, dass Unternehmen Fachkräfte auch ortsungebunden einstellen können, was Talentpools eröffnet, die zuvor nicht verfügbar waren. - Kosten

Rechenzentren sind teuer in Anschaffung und Unterhalt. Die Gebäude, in denen sie untergebracht werden, müssen entsprechend gekühlt und versichert werden, es benötigt fachkundiges Personal, und die Datenbanken selbst sind mit enormen Kosten verbunden. Mit Cloud Data Warehousing kann derselbe Service in Anspruch genommen werden, jedoch zahlen Unternehmen nur für die Rechen- und Speicherleistung, die sie benötigen und wenn sie sie benötigen. Bei elastischen Cloud-Diensten wie beispielsweise Snowflake können Rechen- und Speicherleistung auch separat und in unterschiedlichen Mengen gekauft werden. Unternehmen müssen dabei nur für das bezahlen, was sie wirklich nutzen, und können Funktionen, die sie nicht mehr benötigen, sofort schließen oder verkleinern. - Leistung

Anbieter von Cloud-Diensten konkurrieren darum, die Nutzung der leistungsfähigsten Hardware für einen Bruchteil der Kosten anzubieten, die für die Reproduktion einer solchen Leistung On-Premises anfallen würden. Upgrades werden automatisch durchgeführt, sodass Unternehmen immer über die neuesten Funktionen verfügen und keine Ausfallzeiten beim Upgrade auf die neueste »Version« erleben. Einige On-Premises-Datenbanken bieten eine schnellere Performance, jedoch nicht zu den Kosten und der Verfügbarkeit des Infrastructure-as-a-Service (IaaS), die Cloud-Anbieter ermöglichen. - Skalierbarkeit

Die Eröffnung eines Cloud Data Warehouse ist so einfach wie die Eröffnung eines Kontos bei einem Anbieter wie Microsoft Azure, AWS Redshift, Google BigQuery oder Snowflake. Das Konto kann erweitert und verkleinert oder sogar sofort wieder geschlossen werden. Die Benutzer sind sich zudem der entsprechenden Kosten bewusst, bevor sie die Menge des gemieteten Storage ändern. Diese Skalierbarkeit hat zur Prägung des Begriffs »Elastic Cloud« geführt. - Unabhängigkeit

Das Hosten von Daten in einem Cloud Data Warehouse bedeutet, dass Unternehmen den Anbieter wechseln können, wenn es zu Änderungen ihrer Geschäftsstrategie passt. Bleiben Unternehmen datenbankunabhängig, haben sie die Flexibilität, ihre Datenbank zu vergrößern, zu verkleinern oder komplett zu wechseln. Mit metadatengesteuerter Automatisierungssoftware können Unternehmen zudem ganze Dateninfrastrukturen auf Wunsch aus dem Cloud Data Warehouse extrahieren, hinein verschieben sowie verschiedenen Teams innerhalb desselben Unternehmens ermöglichen, mit der Datenbank und der hybriden Cloud-Struktur zu arbeiten, die ihren Anforderungen am besten entspricht.

Auswahl einer Cloud-Data-Warehouse-Lösung

Eine Kostenanalyse ist unerlässlich, um abzuschätzen, wie viel Geld ein Cloud Data Warehouse dem Unternehmen sparen würde. Verschiedene Cloud-Anbieter haben unterschiedliche Preisstrukturen, die berücksichtigt werden müssen. Etabliertere Anbieter wie Amazon und Microsoft mieten Knoten und Cluster, sodass ein Unternehmen einen definierten Teil des Servers nutzt. Dadurch wird die Preisgestaltung vorhersehbar und konstant, jedoch ist manchmal die Wartung des jeweiligen speziellen Knotens erforderlich.

Snowflake und Google bieten ein serverloses System an, was bedeutet, dass die Standorte und die Anzahl der Cluster nicht definiert und somit irrelevant sind. Stattdessen wird dem Kunden genau die Menge an Rechen- oder Verarbeitungsleistung in Rechnung gestellt, die er verbraucht. In größeren Unternehmen ist es jedoch oft schwierig, die Anzahl der Nutzer und die Größe eines Prozesses vorherzusagen, bevor er stattfindet. Es ist möglich, dass die Anfragen viel größer sind und viel mehr kosten als erwartet.

Jeder Cloud-Anbieter hat seine eigene Suite von unterstützenden Tools für Funktionen wie Datenmanagement, Visualisierung und Predictive Analytics, sodass diese besonderen Bedürfnisse bei der Entscheidung für einen Anbieter berücksichtigt werden sollten.

Die Verwendung von Cloud-basierten Data-Warehouse-Plattformen bedeutet, dass Unternehmen noch mehr Daten aus einer Vielzahl von Datenquellen sammeln und sofort und elastisch skalieren können, um praktisch unbegrenzt Benutzer und Arbeitslasten zu unterstützen. Mit der Fähigkeit, den Zustrom großer Datenmengen zu verwalten und durch Automatisierung die Investitionsrentabilität zu steigern, können Unternehmen den Zustrom großer Datenmengen bewältigen, manuelle Prozesse automatisieren und die Rentabilität der Cloud maximieren.

Rob Mellor, VP und GM EMEA, WhereScape

Zu Rob Mellor, WhereScape

Zu Rob Mellor, WhereScape

Rob Mellor ist Vice President und General Manager EMEA bei WhereScape, dort über 9 Jahre im Unternehmen tätig. Mellor schöpft aus mehr als 16 Jahren Branchenerfahrung in leitenden Vertriebs- und Marketingpositionen, etwa bei TAH, Cognos und IBM, für führende Unternehmen, die das Time-to-Value Prinzip ihrer Investitionen in Data Warehouse und Business Analytics verbesserten. Er hat auf diesem Weg viele Technologien und Beratungsherausforderungen kennengelernt.

154 Artikel zu „Cloud Data Warehouse“

NEWS | TRENDS 2020 | CLOUD COMPUTING | TRENDS CLOUD COMPUTING

IT-Entscheidungsträger greifen für Data Warehouses und Datenbanken zur Cloud

Analysedaten in die Cloud verschieben: Das sehen 43 Prozent der Umfrageteilnehmer einer globalen Studie als einflussreichsten Cloud-Trend. In Deutschland gehen 37 Prozent der Befragten mit dieser Einschätzung mit. Die MariaDB Corporation befragte in einer globalen Studie deutsche und internationale IT-Führungskräfte zu allgemeinen Cloud- und Datenbanktrends und zu den Auswirkungen von Covid-19 auf IT-Entscheidungen. In Deutschland…

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | INFRASTRUKTUR | OUTSOURCING | ONLINE-ARTIKEL | SERVICES

6 Gründe für ein Cloud-basiertes Data Warehouse

Ein Data Warehouse, das Daten aus verschiedenen Quellen zusammenfasst, um sie analysieren und darauf reagieren zu können, ist heute entscheidend für den Geschäftserfolg. Denn es verarbeitet schnell die enormen Datenmengen, die sich heute in Unternehmen ansammeln. Darauf basierend können Führungskräfte zuverlässige datenbasierte Entscheidungen treffen. Allerdings halten es fast zwei Drittel der kürzlich befragten Experten für…

NEWS | CLOUD COMPUTING | TRENDS CLOUD COMPUTING | DIGITALE TRANSFORMATION | TRENDS SERVICES | TRENDS 2019 | OUTSOURCING

Ertragsoptimierung bei Cloud-Data-Warehouse-Investitionen

Immer mehr datengestützte IT-Systeme werden in die Cloud verlagert und dazu gehört auch das Data Warehouse. Neue Cloud-Data-Warehouse-Lösungen (CDW) sollen noch umfassendere Datenfunktionen, eine bessere Leistung und mehr Flexibilität als herkömmliche lokale Datenbanken bieten. Laut einer neuen Umfrage des TDWI (The Data Warehousing Institute) im Auftrag von Talend bieten neue Cloud-Data-Warehouse-Lösungen (CDW) noch umfassendere…

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALE TRANSFORMATION

Automation vereinfacht Data-Warehouse-Migration in die Cloud

Die Migration des Data Warehouse in die Cloud ist für Unternehmen, die Teile ihrer Infrastruktur in die Cloud verlegen, ein wichtiger und über kurz oder lang auch notwendiger Schritt. Als eines der wichtigsten Puzzleteile der Infrastruktur, ist er leider auch meist sehr komplex und mit hohen Kosten verbunden. Anstatt die Migration dieses wichtigen Bestandteils der…

NEWS | CLOUD COMPUTING | DIGITALISIERUNG | IT-SECURITY | ONLINE-ARTIKEL | RECHENZENTRUM | SERVICES

Vor- und Nachteile eines Database-as-a-Service: Data Warehouse aus der Cloud

Die Themen Big Data und Cloud beschäftigen die Unternehmen in allen Branchen. Digitalisierung, Internet of Things, Social Media und cloudbasierte Geschäftsmodelle produzieren massenhaft Daten, die verwertbar und überall zugänglich sein sollen. Doch wohin damit? Am besten wäre es doch, alle Daten je nach Bedarf in ein über die Cloud flexibel erweiterbares Data Warehouse abzulegen, also…

NEWS | STRATEGIEN

Fünf Hürden auf dem Weg zu einer erfolgreichen Data Governance

An einer umfassenden Data-Governance-Strategie führt heute kaum noch ein Weg vorbei – da sind sich die meisten modernen Unternehmen einig. Dass viele von ihnen aber noch weit von der tatsächlichen Umsetzung entfernt sind, belegt jetzt eine Dataversity-Studie aus dem Jahr 2020. Nur zwölf Prozent der befragten Unternehmen gaben hier an, eine entsprechende Strategie bereits vollständig…

NEWS | CLOUD COMPUTING

App in die Cloud? Welche Vorteile sich für Unternehmen aus der Migration ergeben können

Nicht erst die Corona-Krise hat gezeigt, dass Unternehmenssoftware auf dem hauseigenen Server häufig ihre Tücken hat. Das flexible und mobile Arbeiten im Home Office oder unterwegs bekommt ohne die Möglichkeit des externen Server-Zugriffs schnell einen eher symbolischen Charakter. Und selbst wenn der Zugriff gegeben ist, sorgen wackelige Verbindungen und lange Ladezeiten immer wieder für Verzögerung.…

AUSGABE 7-8-2020 | NEWS | CLOUD COMPUTING | INFRASTRUKTUR | LÖSUNGEN

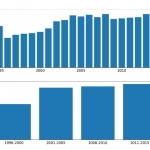

Migration – Einhundert Prozent in die Cloud: So geht’s

Die weltweiten Auswirkungen der Covid-19-Pandemie haben die Art und Weise, wie wir arbeiten, drastisch verändert. Sie hat zahllose Unternehmen dazu gezwungen, neue Technologien einzuführen, damit die Mitarbeiter von zu Hause arbeiten können und der Betrieb aufrechterhalten werden kann. Auch wenn sich die Situation allmählich normalisiert und es eine gewisse Rückkehr zur Vor-Corona-Normalität gibt, wird einiges anders bleiben, insbesondere der beschleunigte Trend zur Cloud.

NEWS | EFFIZIENZ | INFRASTRUKTUR | RECHENZENTRUM

Mit Data Vault zu mehr Agilität im Data Warehouse

Architekturen. Frameworks. Praxis. Data Vault ist eine Modellierungstechnik, mit der sich bestehende Data Warehouses (DWH) modernisieren und damit den aktuellen Anforderungen an Datenhaltung und Analytics anpassen lassen. DWH-Verantwortliche stehen unter immer größeren Druck, ihre Systeme anpassen zu müssen. Klassische DWH-Konzepte nach Inmon oder Kimball sind nicht dafür geeignet, weil sie schnell immer komplexer werden und…

NEWS | CLOUD COMPUTING | TIPPS

Die sechs Stolpersteine bei der Migration in die Cloud

Für Unternehmen hat es viele Vorteile, ihre Daten in die Cloud zu verlagern. Allerdings kann auf dem Weg in die Wolke einiges schiefgehen. Der Datenbank-Pionier Couchbase nennt sechs Fallstricke bei der Migration in die Cloud. Beim Verlagern von Prozessen, Anwendungen und Daten in die Cloud sollten Unternehmen nichts überstürzen. Wer die Migration unvorbereitet in Angriff…

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | INFRASTRUKTUR

Königsweg Automatisierung – Der Weg zu mehr Effizienz für Data Warehouse und Data Lake

Data Warehouses haben eine lange Tradition. Doch mit Big Data Analytics und Data Lakes haben viele diesen Ansatz totgesagt. Das entspricht allerdings nicht der Realität: Geschätzt betreiben mehr als 60 Prozent der Unternehmen Data Warehouses, oft sogar mehrere. Assets, in die viel investiert wurde und die Vorteile bieten, die mit einem Data Lake nicht erreicht…

NEWS | VERANSTALTUNGEN

Save the date: InfoZoom Data Quality Management Online-Konferenz im November

Die humanIT Software GmbH führt ihre jährliche InfoZoom-Kundenveranstaltung am 4. November 2020 als Online-Event durch. Die Teilnehmer erhalten in der DQM-Online-Konferenz einen Überblick über aktuelle Strategien für ein zukunftssicheres und nachhaltiges Data Quality Management. Praxisbeispiele steuern unter anderem die Anwender von Vodafone und dem LKA Rheinland-Pfalz bei. Interessenten können sich ab sofort kostenfrei anmelden unter…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | FAVORITEN DER REDAKTION | INFRASTRUKTUR | LÖSUNGEN

Robuste und widerstandsfähige Lieferketten: So hält Data Analytics die Supply Chain am Laufen

Die rasche Verbreitung von Covid-19 hat viele Lieferketten unter Stress gesetzt. Hamsterkäufe und Produktionsstopps angesichts fehlender Rohstoffe machten es schwer, die Nachfrage der Märkte zu erfüllen. Da viele Branchen von Lieferungen aus anderen Ländern abhängig sind, müssen Entscheidungsträger in der Lage sein, schnell Anpassungen an der Supply Chain vorzunehmen. Dies funktioniert jedoch nur, wenn verlässliche…

NEWS | BUSINESS PROCESS MANAGEMENT | FAVORITEN DER REDAKTION | GESCHÄFTSPROZESSE | ONLINE-ARTIKEL

Datenstrategien für Big Data – Automatisierung des Data Warehouse muss Teil der Lösung sein

Im Zeitalter von Big Data könnte man davon ausgehen, dass man gar nicht genug Daten haben kann. Denn aus Daten lassen sich in der Theorie wichtige Erkenntnisse ziehen, die Unternehmen zu ihrem Vorteil nutzen können. Und so sammeln Unternehmen seit Jahren fleißig Daten aus immer mehr Quellen ein – und stehen damit auch vor der…

NEWS | DIGITALISIERUNG | SERVICES | STRATEGIEN

Open-Data-Initiative: Mit Datenkooperationen gegen die »Daten-Kluft«

Durch die Nutzung und den Austausch öffentlich zugänglicher Daten können fundierte Entscheidungen getroffen und sogar einige der weltweit drängendsten sozialen Herausforderungen besser bewältigt werden. So heißt es in der neuen Datenstrategie der Bundesregierung, »Daten sind eine Schlüsselressource«, etwa für die Verbesserung der Gesundheitsversorgung. Die Fähigkeit Daten verantwortungsvoll und selbstbestimmt zu nutzen, zu verknüpfen und auszuwerten,…

NEWS | BUSINESS INTELLIGENCE | DIGITALISIERUNG | FAVORITEN DER REDAKTION | TIPPS | WHITEPAPER

Data Preparation: In 4 Schritten zum Data-Science-Projekt

Die richtige Data Preparation erhöht die Vorhersagequalität von Datenmodellen und steigert die Wirksamkeit von Machine Learning-Zyklen. Die meisten Daten sind ohne eine vorher durchgeführte Data Preparation für KI-gestützte Prognosen ungeeignet: ihre Qualität ist unzureichend, sie liegen nicht in numerischer Form vor, oder es fehlen Werte. Diese Handlungsempfehlungen unterstützen bei der Datenvorbereitung und helfen, den…

NEWS | TRENDS 2020 | BUSINESS PROCESS MANAGEMENT | TRENDS INFRASTRUKTUR | CLOUD COMPUTING | TRENDS CLOUD COMPUTING

Datenstrategie und Datenkultur: Cloud-Modell erleichtert die Datendemokratisierung

Uneinheitlicher Ansatz in Bezug auf Datenstrategie, Kultur, IT-Infrastruktur und Cloud-Migration kann Unternehmen schaden Mehr als 80 Prozent der befragten Unternehmen berichten über Performance-Probleme, wenn sich Daten in verschiedenen Umgebungen befinden Nur 32 Prozent der Daten-Teams können die Erkenntnisse gewinnen, die ihr Unternehmen für eine bessere Entscheidungsfindung braucht Die neue Studie der Exasol AG, Hersteller…

NEWS | CLOUD COMPUTING | DIGITALISIERUNG | DIGITALE TRANSFORMATION | AUSGABE 1-2-2020

Ganzheitliche Digitalisierung – Ohne Cloud wird wie ohne Handy sein

»Es hängt von dir selbst ab, ob du das neue Jahr als Bremse oder als Motor benutzen willst«, soll Henry Ford gesagt haben. Uwe Bergmann, Gründer und Vorstandsvorsitzender der Cosmo Consult Gruppe, rät zum Motor.

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | SERVICES | TIPPS | WHITEPAPER

Wie gelangt man zu einem effektiven Data Lake?

Die schnelle Entscheidungsfindung auf Basis digitaler Daten verändert die Art und Weise, wie Unternehmen und IT arbeiten. Da Unternehmen auf alle Arten von Informationen zugreifen wollen, haben sie einen Bedarf an Infrastrukturexperten erkannt, die ihnen helfen, aus ihren Daten neue Werte zu erschließen. Rubrik, Anbieter einer Plattform für Multi-Cloud Data-Control, erläutert jüngste Entwicklungen in diesem…

NEWS | EFFIZIENZ | LÖSUNGEN | SERVICES | AUSGABE 11-12-2019

Data Quality: HELM AG modernisiert und zentralisiert Datenhaltung

Dezentral organisierte Unternehmen tun sich oft schwer, Informations- und Datenprozesse schlank, einheitlich und transparent zu organisieren. Die Digitalisierung verstärkt den Erneuerungsdruck. Die global tätige HELM AG hat es mit Hilfe einer Data-Quality-Lösung geschafft, ihre vertrieblichen und kaufmännischen Arbeitsabläufe zu optimieren. Die Software sorgt dafür, dass die neu erstellte zentrale Stammdatenbasis von Dubletten und Inkonsistenzen befreit wird und im Tagesgeschäft dauerhaft »sauber« bleibt.