Illustration Absmeier foto freepik

Die digitale Transformation treibt nicht nur Innovationen voran, sondern führt zu einer massiven Zunahme an Daten. Unternehmen in Deutschland, vom globalen Industriekonzern bis zum regionalen Mittelstand, sehen sich mit einer Datenflut konfrontiert, die sich in den kommenden zehn Jahren vervielfachen wird. Der Umgang mit dieser Entwicklung wird zu einer entscheidenden Herausforderung für Wettbewerbsfähigkeit, Effizienz und Innovationsfähigkeit.

Diese Entwicklung betrifft alle Branchen, besonders jedoch solche mit hohen Automatisierungs- und Digitalisierungsgraden. Die Industrie, insbesondere im Kontext von Industrie 4.0, zählt zu den größten Datenproduzenten: Sensorik, IoT-Plattformen und digitale Zwillinge erzeugen kontinuierlich Echtzeitdaten in Milliardenhöhe. Aber auch das Gesundheitswesen, der Handel und die Finanzbranche sehen sich mit massiven Datenströmen konfrontiert, die analysiert, gespeichert und geschützt werden müssen.

Viele Unternehmen unterschätzen dabei noch immer die Dynamik, mit der Datenströme ihre Geschäftsprozesse verändern. Es geht längst nicht mehr nur um das Speichern von Informationen, sondern um deren intelligente Nutzung: Echtzeitverarbeitung, Automatisierung und gezielte Analyse werden zunehmend zu kritischen Erfolgsfaktoren. Wer seine Daten nicht strategisch nutzt, läuft Gefahr, den Anschluss zu verlieren.

Datenvolumen wachsen exponentiell – KI als Schlüsseltechnologie

Die Zahlen sprechen für sich: Laut IDC wurden im Jahr 2024 weltweit rund 150 Zettabyte an Daten erzeugt. Bis 2035 könnte diese Menge auf mehr als 600 Zettabyte ansteigen. Besonders im unternehmerischen Umfeld entstehen täglich enorme Datenmengen – durch Maschinen, Sensoren, Kommunikation, Kundentransaktionen oder digitale Services.

Eine zentrale Rolle spielt dabei Künstliche Intelligenz. Einerseits ist sie Treiber dieses Wachstums, da KI-Systeme selbst große Datenmengen erzeugen und verarbeiten. Andererseits ist sie ein unverzichtbares Werkzeug, um diese Informationen effizient zu analysieren, Muster zu erkennen und automatisierte Entscheidungen in Echtzeit zu ermöglichen. Ohne den Einsatz von KI wird es in Zukunft kaum möglich sein, Datenmengen dieser Größenordnung sinnvoll zu bewältigen.

Datenmanagement als kritischer Erfolgsfaktor

Trotz fortschreitender Digitalisierung zeigen Studien, z.B. von bitkom2, dass viele Unternehmen ihre Daten noch nicht systematisch nutzen. Zwar werden große Mengen gesammelt, aber oft fehlt es an Struktur, Analysefähigkeit und der nötigen Datenkompetenz. Der Engpass liegt nicht nur in der Technologie, sondern auch im strategischen Umgang mit Daten.

Eine wirksame Datenstrategie umfasst mehrere Komponenten: die zielgerichtete Erfassung relevanter Informationen, leistungsfähige Speicherarchitekturen und die systematische Analyse durch moderne Tools. Hybride Modelle, bestehend aus Cloud-Plattformen, lokalen Rechenzentren und sogenannten Data Lakes, setzen sich dabei zunehmend durch. Entscheidend ist außerdem die Qualität der Daten, denn nur valide, aktuelle und vollständige Informationen ermöglichen belastbare Analysen.

Quantentechnologie als Treiber der nächsten Datenwelle

Mit der Quantentechnologie zeichnet sich ein weiterer Entwicklungsschub ab. Erste Pilotprojekte in Deutschland, etwa von Fraunhofer, DLR oder in Partnerschaften mit IBM, zeigen, wie Quantencomputer hochkomplexe Aufgaben lösen können, etwa in der Materialforschung, Logistik oder der Finanzmodellierung. Die Rechenleistung solcher Systeme übertrifft konventionelle IT-Infrastrukturen um ein Vielfaches.

Das bedeutet jedoch auch: Die Menge und Komplexität der verarbeiteten Daten steigen weiter. Unternehmen müssen sich daher frühzeitig auf diese Entwicklung vorbereiten – nicht nur durch technologische Aufrüstung, sondern auch durch die Etablierung skalierbarer, sicherer Datenarchitekturen.

Infrastruktur entscheidet über Zukunftsfähigkeit

Die beste Datenstrategie nützt wenig ohne eine leistungsfähige Infrastruktur. Eine stabile Glasfaseranbindung bildet das Rückgrat für datenintensive Anwendungen, insbesondere wenn große Mengen in Echtzeit übertragen oder analysiert werden müssen. Glasfasertechnologie sichert niedrige Latenzen, hohe Übertragungsraten und ist essenziell für den Einsatz von KI- und Quantenanwendungen.

Ebenso wichtig sind Redundanzkonzepte. Unternehmen müssen dafür sorgen, dass ihre Datenverarbeitung auch bei Ausfällen oder Angriffen stabil bleibt. Mehrfach abgesicherte Netzpfade, geografisch verteilte Rechenzentren und Notfallpläne sorgen für Ausfallsicherheit und gewährleisten die unterbrechungsfreie Verfügbarkeit kritischer Systeme.

Fazit: Der Weg zur Datenreife beginnt jetzt

Das exponentielle Datenwachstum der kommenden Dekade ist weit mehr als eine technische Herausforderung. Es ist ein strategischer Wendepunkt. Wer in der Lage ist, Daten effektiv zu erfassen, zu analysieren und in geschäftlichen Mehrwert zu überführen, verschafft sich klare Wettbewerbsvorteile. Unternehmen sollten daher jetzt beginnen, konkrete Schritte umzusetzen:

- Analyse der bestehenden Datenlandschaft

- Definition klarer Geschäftsziele auf Basis von Daten

- Aufbau einer skalierbaren, sicheren Dateninfrastruktur

- Integration von KI zur Analyse und Automatisierung

- Beobachtung und frühzeitige Pilotierung von Quantentechnologien

- Sicherstellung von Infrastrukturstabilität durch Glasfaser und Redundanz

Der Weg zur Datenreife ist ein unternehmensweiter Prozess, der von der Technologie über die Organisation bis hin zur Unternehmenskultur reicht. Wer diesen Weg konsequent geht, schafft die Voraussetzungen für langfristigen Erfolg im datengetriebenen Zeitalter.

Julia Neumann

Julia Neumann, Head of Communication bei GlobalConnect Germany und zertifizierte KI-Managerin begleitet seit über 13 Jahren deutsche Unternehmen bei der digitalen Transformation. Bei GlobalConnect in Deutschland arbeitet sie eng mit der Vertriebsabteilung zusammen und kennt die Herausforderungen der mittelständischen Unternehmen bei der digitalen Transformation

Quellen:

1 Aktueller Report von 2025: IDC forecasts that by 2025 the global datasphere will grow to 163 zettabytes (that is a trillion gigabytes). That’s ten times the 16.1ZB of data generated in 2016.

2 bitkom: Repräsentative Befragung von 603 Unternehmen ab 20 Beschäftigten aus allen Wirtschaftsbereichen im Auftrag des Digitalverbands Bitkom.

Weiterführende Studien:

– IDC / Seagate: Data Age 2025 – The Digitization of the World

– Statista 2024: Global Data Volume Forecast

265 Artikel zu „Data Readiness“

News | Digitale Transformation | Favoriten der Redaktion | Geschäftsprozesse | Künstliche Intelligenz | Lösungen

KI-Hype trifft auf Realität: Wie steht es um die Data Readiness?

Fast jedes zweite Unternehmen hat Probleme bei KI-Implementierung. Künstliche Intelligenz (KI) gilt als entscheidender Treiber der digitalen Transformation – doch der Weg zur erfolgreichen Umsetzung ist für viele Unternehmen holpriger als gedacht. Eine aktuelle globale Umfrage von Redpoint im Auftrag von Fivetran zeigt, dass bei 42 Prozent der befragten Unternehmen mehr als die Hälfte…

Trends 2025 | News | Trends Services | Geschäftsprozesse | Künstliche Intelligenz | Strategien

Fast die Hälfte der KI-Projekte in Unternehmen scheitern an unzureichender Data Readiness

Eine neue globale Umfrage zeigt steigende Kosten durch gescheiterte KI-Projekte: Komplexität der Datenbereitstellung und Wartung der Datenpipelines verbrauchen technische Ressourcen. Fivetran, Anbieter für Data Movement, präsentiert eine neue Studie über den Einsatz von KI in Unternehmen [1]. Die von Redpoint Content durchgeführte Umfrage zeigt, dass fast die Hälfte der Unternehmen von verzögerten, unzureichenden oder…

Ausgabe 5-6-2025 | News | Business | Künstliche Intelligenz | Strategien

Solide Data Governance für KI-Projekte – Schlechte Daten verhageln auch die beste KI

Der Erfolg einer KI-Nutzung steht und fällt mit der Qualität ihrer Ergebnisse: Ist nur ein kleiner Teil der Antworten potenziell fehlerbehaftet, müssen Mitarbeitende viel Zeit in die Prüfung und Nachbearbeitung der Ergebnisse investieren – der Nutzen sinkt rapide. Eine Problematik, die mit Agentic AI nun noch eine weitere Dimension gewinnt. Schließlich generieren KI-Agenten nicht nur Informationen, sondern führen auf dieser Basis auch autonome Aktionen aus. Damit das Risiko von Fehlern sinkt und Vertrauen in die Technologie entstehen kann, braucht es mehr als »nur« eine hohe Datenqualität. Eine durchdachte Data Governance ist zum entscheidenden Erfolgsfaktor moderner KI-Szenarien geworden.

News | Effizienz | Favoriten der Redaktion | Infrastruktur | Nachhaltigkeit | Rechenzentrum | Strategien | Tipps

Direct Liquid Cooling: Der Paradigmenwechsel in der Datacenter-Kühlung

Wie Flüssigkeitskühlung Rechenzentren effizienter, nachhaltiger und zukunftsfähig macht – eine technische und strategische Analyse. Rechenzentren verschlingen weltweit 1,3 % des globalen Stromverbrauchs [1], ein großer Teil davon für die Kühlung. Moderne KI-Anwendungen verstärken dieses Problem dramatisch: Sie erzeugen bis zu fünfmal mehr Abwärme als herkömmliche Server und bringen traditionelle Luftkühlsysteme an ihre Grenzen. Direct…

News | Business | Favoriten der Redaktion | Künstliche Intelligenz | Strategien | Tipps

Sechs Bausteine zur KI-Readiness: KI lebt von hochwertigen Daten und intelligenter Planung

Künstliche Intelligenz hat das Potenzial, Prozesse in nahezu allen Branchen zu revolutionieren. Doch der Erfolg jeder KI-Anwendung steht und fällt mit der Qualität der zugrunde liegenden Daten und der richtigen Vorbereitung. NTT DATA erklärt, welche Aspekte bei der Umsetzung eines KI-Projekts relevant sind. Künstliche Intelligenz hat sich in den letzten Jahren zu einem der…

News | Business | Digitale Transformation | Künstliche Intelligenz | Strategien | Ausgabe 11-12-2024

Data Governance, Integrationsprozesse und Datenqualitätssicherung – Balance zwischen menschlicher Expertise und Automatisierung

KI-gestützte Automatisierung generiert einen Produktivitäts-Boost und es entstehen weniger Fehler, was folgerichtig zu besseren Ergebnissen und Entscheidungen führt. Muhi S. Majzoub, EVP & Chief Product Officer bei OpenText erklärt im Interview welche Vorteile und Nachteile bei der Integration von generativer KI in Unternehmensprozesse entstehen können.

News | Business | Künstliche Intelligenz | Services

KI-Readiness: Was zeichnet erfolgreiche KI-Projekte aus?

»Erfolgreiche KI-Projekte zeichnen sich vor allem dadurch aus, dass Business-Expertise und KI-Know-how planvoll und strukturiert zusammengebracht werden.« Interview mit Ralf Bauer, President CGI Deutschland. An der sinnvollen Nutzung künstlicher Intelligenz kommt praktisch kein Unternehmen mehr vorbei, sei es nun ein mittelständischer Betrieb, ein Dienstleister oder ein Großkonzern. Gibt es Gemeinsamkeiten, so…

Trends 2025 | News | Trends Security | IT-Security | Künstliche Intelligenz

Vorhersagen für 2025: Umstellung auf Quantum Readiness

Die Experten von Palo Alto Networks veröffentlichen ihre Vorhersagen für die Cybersicherheitsbranche in der EMEA-Region. Darin rufen sie Cyber-Teams dazu auf, eine Strategie für Quantenresistenz zu entwickeln, um ihre Unternehmen vor dieser wachsenden Bedrohung zu schützen und gleichzeitig die Chancen zu nutzen. Das CSO-Team von Palo Alto Networks hat fünf Prognosen für die Gestaltung der…

News | Business | Geschäftsprozesse | IT-Security | Strategien | Tipps

Data Protection und Cyberresilienz: Der Weg zur DORA-Compliance

Leitfaden zur Erfüllung der Anforderungen der EU-Verordnung in Bezug auf Geschäftskontinuität und Datensicherheit. Die DORA-Verordnung (Digital Operational Resilience Act) verlangt von Unternehmen in der Finanzbranche umfassende Standards für Geschäftskontinuität und Datensicherheit für ihre IT-Dienste und -Anwendungen einzuhalten. Leider sind viele Unternehmen nicht darauf vorbereitet, diese vollständig einzuhalten, insbesondere wenn es um den Schutz von…

News | IT-Security | Strategien | Tipps | Whitepaper

Whitepaper IT-Sicherheit: Zur NIS2-Readiness in sechs Schritten

Laut dem Lagebericht des Bundesamts für Sicherheit in der Informationstechnik (BSI) ist die Bedrohung im Cyberraum so hoch wie nie zuvor [1]. Besonders Ransomware-Attacken nehmen gravierend zu. Es geht nicht mehr darum, ob, sondern wann ein Unternehmen mit einem Cyberangriff konfrontiert wird – und wie sich dies bestmöglich abwenden lässt, um den Geschäftsbetrieb nicht…

News | Business | Digitalisierung | Künstliche Intelligenz | Services | Strategien | Tipps

Erfolgreiche KI-Projekte beginnen mit dem Readiness-Check

Das KI-Potenzial ist praktisch unerschöpflich. Doch um es richtig zu nutzen und daraus echte Wettbewerbsvorteile zu generieren, muss vorab die Bereitschaft des Unternehmens dafür geklärt werden. Der IT-Dienstleister CGI erklärt, warum der Readiness-Check so wichtig ist, was er genau analysiert und was mit den daraus gewonnenen Erkenntnissen passiert. Künstliche Intelligenz ist für Unternehmen…

News | Trends 2024 | Trends Infrastruktur | Business Process Management | Infrastruktur | Künstliche Intelligenz

KI-Readiness ist Daten-Readiness: Datenintegration und die Verfügbarkeit nutzbarer Daten

64 % der befragten Führungskräfte nennen Datenintegration und die Verfügbarkeit nutzbarer Daten als oberste Investitionspriorität für KI und generative KI. Als entscheidende Investitionsbereiche für die Nutzung von KI- und Generative-KI-Technologien sehen die befragten Führungskräfte des Reports »AI readiness for C-suite leaders« die Datenintegration, den sicheren Zugriff auf alle Datenquellen sowie die Fähigkeit, Daten aus…

News | Business Process Management | Effizienz

Fünf Gründe für Automatisierung von Data Warehouses

Obwohl die Rolle von Daten bei der Entscheidungsfindung von Unternehmen zunehmend wichtiger wird, führen viele Firmen ihre ETL-Prozesse immer noch manuell durch und nehmen langwierige Prozesse und veralteten Daten in Kauf. In einem modernen Data Warehouse müssen Daten sich schnell und korrekt integrieren lassen, um ihre einfache Nutzung für die Geschäftsberichtserstattung sicherzustellen. Die traditionellen Ansätze…

News | Trends Security | Trends 2018 | Trends 2017 | Trends 2019 | Trends 2020 | IT-Security

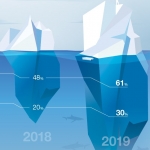

Cyber Readiness Report 2019: Cybergefahr in Deutschland steigt im Jahresvergleich

Digitalisierung und Vernetzung, zunehmende Aufklärung vor Cybergefahren und zahlreiche medienwirksame Hackerangriffe – und dennoch: Viele deutsche Unternehmen vernachlässigen nach wie vor ihr Cyber-Risikomanagement. Die Zahlen des Hiscox Cyber Readiness Reports 2019 sprechen eine deutliche Sprache und sind alarmierend. Die überwiegende Mehrheit (70 %) der befragten deutschen Unternehmen zählt noch immer zu den sogenannten Cyberanfängern. Auf…

News | Cloud Computing | Digitale Transformation | Rechenzentrum | Strategien | Tipps

Data Center Trends 2019: Wie Unternehmen ihr Rechenzentrum fit für die Zukunft machen

Was sind aktuell die wichtigsten Herausforderungen und Erfolgsfaktoren bei der Data Center-Modernisierung? Das wollten die Marktanalysten von IDC herausfinden und haben dazu IT- und Fachentscheider aus 210 deutschen Unternehmen befragt. Höhere Produktivität, Konsolidierung von Ressourcen, verbesserte Sicherheit und Compliance – das sind für Unternehmen heute die wichtigsten Gründe, um in neue Data Center-Infrastrukturen zu investieren.…

News | Cloud Computing | Digitalisierung | Services | Ausgabe 3-4-2019

Entscheidungstool: Die Qual der Wahl – Cloud Readiness for Dummies

News | Trends Cloud Computing | Cloud Computing | Digitale Transformation | Trends Services | Trends 2019 | Outsourcing

Ertragsoptimierung bei Cloud-Data-Warehouse-Investitionen

Immer mehr datengestützte IT-Systeme werden in die Cloud verlagert und dazu gehört auch das Data Warehouse. Neue Cloud-Data-Warehouse-Lösungen (CDW) sollen noch umfassendere Datenfunktionen, eine bessere Leistung und mehr Flexibilität als herkömmliche lokale Datenbanken bieten. Laut einer neuen Umfrage des TDWI (The Data Warehousing Institute) im Auftrag von Talend bieten neue Cloud-Data-Warehouse-Lösungen (CDW) noch umfassendere…

News | Cloud Computing | Digitalisierung | IT-Security | Online-Artikel | Rechenzentrum | Services

Vor- und Nachteile eines Database-as-a-Service: Data Warehouse aus der Cloud

Die Themen Big Data und Cloud beschäftigen die Unternehmen in allen Branchen. Digitalisierung, Internet of Things, Social Media und cloudbasierte Geschäftsmodelle produzieren massenhaft Daten, die verwertbar und überall zugänglich sein sollen. Doch wohin damit? Am besten wäre es doch, alle Daten je nach Bedarf in ein über die Cloud flexibel erweiterbares Data Warehouse abzulegen, also…

News | Business Intelligence | Trends Infrastruktur | Business Process Management | Trends Cloud Computing | Cloud Computing | Trends 2015 | Infrastruktur | IT-Security

Ohne Big Data kein Industrie 4.0 – ohne Sicherheit kein Big Data

»Mit dem Schlagwort Industrie 4.0 ist es nicht getan«, warnte die Kanzlerin dieser Tage auf dem CDU-Wirtschaftskongress den deutschen Mittelstand, die Digitalisierung nicht zu verschlafen. Sie fordert die Wirtschaft auf, Big Data als Chance zu verstehen und nicht immer als erstes über den Schutz nachzudenken. »Big Data ist keine Bedrohung, sondern die Wertschöpfungskette der Zukunft«,…

News | Kommentar | Künstliche Intelligenz

KI – Herausforderung und Chance für CIOs

Der Platz, den die künstliche Intelligenz in Unternehmen einnimmt, wächst und wächst. Laut dem Statistischen Bundesamt setzen 20 % der deutschen Unternehmen KI-Technologien ein, damit ist innerhalb eines Jahres die Nutzung von KI um 8 Prozentpunkte gestiegen. Joel Carusone, Senior Vice President of Data and Artificial Intelligence bei NinjaOne, erläutert, welche Folgen der Einzug der…