Illustration Absmeier foto freepik

Jahrzehntelang bildeten Mainframes ein effizientes und sicheres Fundament für die Datenverarbeitung in Unternehmen. Die heutigen Cloud-Plattformen bieten jedoch ähnliche Funktionen, mit zusätzlichen Vorteilen wie Flexibilität, Elastizität und nahezu unbegrenzter Skalierbarkeit. Die Cloud hilft Unternehmen, ihre Investitionskosten zu senken, ihre betriebliche Effizienz zu verbessern und schneller zu werden.

Der Übergang von Mainframe-Systemen zu einer Cloud-first-Strategie kann sich als kompliziert erweisen. Die Migration von Applikationen und Daten ist kostspielig, zeitaufwändig und risikobehaftet. Die Modernisierung von Mainframes ist jedoch kein Entweder-oder-Vorschlag. Viele Unternehmen verfolgen einen langfristigen Ansatz und nutzen die Vorzüge sowohl von Mainframe- als auch von Cloud-Systemen.

Diese integrierte Strategie ermöglicht ein breites Spektrum an IT-Optionen und kombiniert auf diese Weise die Zuverlässigkeit von Mainframes mit der Innovation des Cloud-Computing. Dieser Artikel befasst sich mit den Feinheiten der Mainframe-Optimierung und beschreibt die treibenden Kräfte, gängige Konzepte sowie die wichtigsten Methoden und Tools für eine effiziente Implementierung.

Ein praktischer Ansatz zur Mainframe-Modernisierung

Mainframe-Systeme haben unter IT-Fachleuten immer noch viele Verfechter, und das aus gutem Grund. Ein einziger IBM z16-Mainframe kann täglich bis zu 19 Milliarden Kreditkartentransaktionen verarbeiten. Diese Systeme unterstützen Containeranwendungen, Virtualisierung, KI und maschinelles Lernen, API- und Cloud-Konnektivität und vieles mehr. Ferner werden sie für ihre felsenfeste Zuverlässigkeit mit einer Betriebszeit von 99,999 % geschätzt.

Angesichts dieser Tatsache sollte die Modernisierung nicht als Ersatzstrategie betrachtet werden, sondern vielmehr als Ansatz zur Vereinheitlichung des Mainframe-Betriebs mit den heutigen Cloud-Plattformen. Um dies zu erreichen, müssen IT-Führungskräfte die verschiedenen Methoden und Tools kennen, die ihnen zur Verfügung stehen, und wissen, wie sie eine überschaubare Roadmap entwerfen können, die Kosten, Risiken und Nutzen in Balance hält.

Beispiele für die Modernisierung von Mainframes

Die IT-Landschaft eines jeden Unternehmens ist individuell, ebenso wie seine Geschäftsprozesse und Anforderungen. Dennoch kann es hilfreich sein, die einzelnen Funktionen, die von IT-Systemen ausgeführt werden, in ein paar umfassende Kategorien einzuteilen.

Die heutigen Cloud-Systeme zeichnen sich durch hohe Datenspeicherung, leistungsstarke Analysen, KI und Software- sowie Systementwicklung aus. Mainframes verfügen über hervorragende Transaktionsverarbeitungsfunktionen und bieten Geschwindigkeit, Sicherheit, Skalierbarkeit und Zuverlässigkeit. Durch die Modernisierung kann ein Unternehmen die Stärken der einzelnen Plattformen nutzen, ohne groß angelegte Änderungen vorzunehmen, die sowohl kostspielig als auch disruptiv sein können.

Es gibt drei mögliche Ansätze für die Mainframe-Modernisierung:

- Die Datenreplizierung erstellt eine duplizierte Kopie der Mainframe-Daten in einem Cloud-Data-Warehouse oder Data Lake und ermöglicht so Hochleistungsanalysen praktisch in Echtzeit, ohne die Mainframe-Leistung zu beeinträchtigen.

- Cloud-basiertes DevOps bietet eine moderne, agile Umgebung für die Entwicklung und Wartung von Anwendungen und Services, die mit den Mainframe-Daten des Unternehmens interagieren.

- Bei der Mainframe-Migration werden bestehende Arbeitslasten vom Mainframe in die Cloud verlagert. Diese beinhaltet in der Regel die Umstrukturierung und Neuformatierung von Mainframe-Anwendungen. Häufig bedeutet dies auch die Verlagerung von Betriebsdaten von systemeigenen Mainframe-Datenbanken in moderne relationale Datenbanken.

Im Folgenden werden die Beispiele näher betrachtet:

Datenreplikation

Eine Vielzahl von Unternehmen beginnt ihre Modernisierung mit dem Ziel, leistungsstarke Cloud-Analyse- und Entscheidungsunterstützungstools zu nutzen, darunter Business Intelligence, interaktive Abfragen und Echtzeitsuche. Bei der Datenreplikation fließen die Informationen im Allgemeinen in eine Richtung, nämlich vom Mainframe in die Cloud. Die Replikation in Echtzeit oder nahezu in Echtzeit ist am weitesten verbreitet.

Unabhängig davon, ob sich ein Unternehmen für eine vollständige Migration vom Mainframe entscheidet oder nicht, ist die Datenreplikation ein wichtiger erster Schritt, der für jede Art von Mainframe-Modernisierungsstrategie erforderlich ist.

Cloud-basierte DevOps

Cloud-basierte DevOps erleichtern die Einbeziehung von Mainframe-Daten und Mainframe-Entwicklung in die Entwicklungsbemühungen des Unternehmens insgesamt. Dies führt zu leistungsfähigeren und eng aufeinander abgestimmten Webanwendungen, System-APIs und -Funktionen, mobilen Anwendungen und Benutzeroberflächen usw. Das cloudbasierte DevOps-Muster trägt dazu bei, Reibungsverluste zwischen den zunehmend voneinander abhängigen Cloud- und Mainframe-Entwicklungsbemühungen eines Unternehmens zu beseitigen.

Im Laufe der Zeit wird die Synchronisierung von Mainframe- und Cloud-Entwicklung den Zusammenhalt der Teams stärken und sowohl die Kosten als auch den Zeitrahmen für die Projektbereitstellung reduzieren. Auch die Codequalität und die Interoperabilität der Systeme werden sich im Allgemeinen verbessern.

Mainframe-Migration

Die Mainframe-Migration ist ein viel umfassenderer Ansatz, bei dem die meisten oder alle Mainframe-Anwendungen und Datenbanken durch cloudbasierte Alternativen ersetzt werden. Diese Strategie ist im Allgemeinen mit deutlich höheren Kosten und Risiken verbunden, da sie umfangreiche Änderungen an hochkomplexen und voneinander abhängigen Systemen erfordert.

Eine Mainframe-Migration in die Cloud umfasst in der Regel die Umstrukturierung des Codes in eine moderne objektorientierte Sprache wie Java oder C# und den Wechsel zu einer modernen relationalen Datenbank. Bei der Umstellung auf die neue Cloud-Plattform müssen Sie verschiedene Mainframe-Funktionen, einschließlich Sicherheit, Systemprotokolle, Metadaten und COBOL-Copybooks, sorgfältig berücksichtigen.

Angesichts der Komplexität und des Umfangs von Mainframe-Migrationsprojekten holen sich die meisten Unternehmen Hilfe von externen Experten und nutzen bewährte Angebote wie den Mainframe Modernization Service von AWS.

Best Practice 1: Beginn der Mainframe-Datenreplikation

Unabhängig davon, welches Muster bevorzugt wird, werden zu einem bestimmten Zeitpunkt Daten aus dem Mainframe extrahiert und an einen anderen Ort verschoben. Für viele Unternehmen ist die Datenreplikation in Echtzeit ein wichtiger erster Schritt auf ihrem Modernisierungsweg.

Die Technologie der Änderungsdatenerfassung (CDC) vereinfacht diesen Prozess und bietet Flexibilität, Zuverlässigkeit, Genauigkeit und Leistung. Die Replikation von Mainframe-Daten in die Cloud in Echtzeit bietet einen schnellen Weg zur Nutzung von leistungsstarken Cloud-Analysen, KI, Unternehmenssuche und mehr.

Best Practice 2: Die Rolle der Metadaten

Werden Daten von einem System in ein anderes verschoben, ist es wichtig, dass Metadaten durch die Herkunft der Daten eingepflegt werden. Dies ist für die Gewährleistung der Datenintegrität von entscheidender Bedeutung und für die Einhaltung gesetzlicher Vorschriften, einschließlich Finanzprüfungen, Datenschutz und branchenspezifischer Vorschriften, unerlässlich.

In Anbetracht der Bedeutung der Metadatenverwaltung müssen Unternehmen optimale Lösungen einsetzen, die diese Anforderung von vornherein erfüllen. Maßgeschneiderte Datenreplikationslösungen, die intern entwickelt werden, bieten oft nicht das erforderliche Maß an Metadatenmanagement.

Best Practice 3: Skalierbar und wiederholbar machen

Mainframe-Modernisierungsprojekte umfassen in der Regel eine Vielzahl verschiedener Datenreplikationsszenarien. Diese werden sich mit der Entwicklung Ihrer Mainframe- und Cloud-Umgebungen ändern und können sogar die Integration von Cloud-Daten zurück zum Mainframe erfordern.

Daher ist es wichtig, die fest programmierten Datenreplikationstools zu vermeiden, die viele Unternehmen intern entwickeln. Eine flexible, skalierbare Datenreplikationstechnologie, die einen »Build Once, Deploy Anywhere«-Ansatz unterstützt und sich leicht an die unvermeidlichen Änderungen beider Plattformen im Laufe der Zeit anpassen lässt.

Best Practice 4: Integrierte Systemsicherheit

Viele Mainframe-Systeme arbeiten als separate Silos innerhalb der IT-Landschaft des Unternehmens. Wenn die Mainframe-Systeme nicht in die SIEM-Lösung integriert sind, kann mit einigen blinden Flecken in Sachen Sicherheit gearbeitet werden. Ein kontinuierlicher und vollständig integrierter Zugriff auf Sicherheitsdaten ist für Ihr Betriebsmanagement und die Teams zur Einhaltung gesetzlicher Vorschriften unerlässlich.

Durch die Replikation von Sicherheitsereignissen in Ihre bestehende SEIM-Lösung können Sie diese Lücke schließen, den Silo-Effekt beseitigen und eine stärkere Verteidigung gegen Cybersecurity-Bedrohungen aufbauen.

Best Practice 5: Aufbau eines ganzheitlichen Data-Governance-Rahmens

Die meisten Unternehmen haben erhebliche Fortschritte bei der Entwicklung eines soliden Data Governance Frameworks gemacht. Die Modernisierung von Mainframes kann zu einer erheblichen Komplexität führen, die einen neuen Blick auf die Data Governance und die Auswirkungen der Datenreplikation erfordert. Ohne eine proaktive Haltung in Bezug auf Data Governance und Datenintegrität im Allgemeinen laufen Unternehmen Gefahr, die Kontrolle zu verlieren, die Datenintegrität zu beeinträchtigen und die Vorschriften nicht einzuhalten.

Fazit

Die Mainframe-Modernisierung bietet enorme potenzielle Gewinne und Vorteile, bringt aber auch eine Reihe neuer Herausforderungen mit sich. Es ist wichtig, eine solide Roadmap und eine passende Vision für die Modernisierungsreise eines Unternehmens zu entwickeln.

Bernd Stiene, Key Account Executive bei Precisely

163 Artikel zu „Mainframe“

NEWS | RECHENZENTRUM | AUSGABE 11-12-2021

Artificial Intelligence for IT Operations – Warum die Zeit für Mainframe-AIOps gekommen ist

Zunehmend mehr Entscheidern im Bereich Mainframe wird bewusst, dass die traditionelle Art und Weise der Abwicklung des Mainframe-Betriebs bald zurückbleiben wird. Die stetig wachsende Nachfrage nach neueren, schnelleren digitalen Diensten erhöht den Druck auf Rechenzentren, mitzuhalten, weil neue Anwendungen erscheinen, das verarbeitete Datenvolumen kontinuierlich steigt und die Arbeitslasten immer unvorhersehbarer werden.

NEWS | BUSINESS | DIGITALE TRANSFORMATION

Mainframe reloaded: Modernisierung und Generationenwechsel meistern

Während sich so vieles um Cloudnutzung und Digitalisierung dreht, läuft IT-Leitern vor allem von Banken und Versicherungen bei einem anderen Thema gerade die Zeit davon: Die Spezialisten der für diese Bereiche so wichtigen Mainframe-Technologie, stehen meist kurz vor dem Ruhestand – und es fehlt an Nachwuchskräften. Wie sind Mainframe-Modernisierung und Generationenwechsel zu schaffen, ohne dass…

NEWS | TRENDS INFRASTRUKTUR | TRENDS 2020

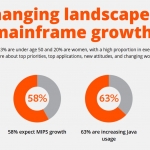

Mainframe-Umfrage 2020: Anpassen, Automatisieren und Sicherheit haben höchste Priorität

IBM Z ist entscheidend für den digitalen Erfolg. BMC hat die Ergebnisse des 15th Annual Mainframe Survey veröffentlicht. Sie zeigen eine starke Zustimmung für die Mainframe-Modernisierung, neue strategische Prioritäten und ein Erstarken der nächsten Generation von Mainframe-Talenten. Als größte Umfrage ihrer Art interviewt der jährliche Mainframe Survey über tausend Führungskräfte und Mainframe-Experten zu ihren Prioritäten,…

NEWS | INFRASTRUKTUR | LÖSUNGEN | AUSGABE 3-4-2019

Software Defined Mainframes – Die letzten ihrer Art

Mainframes sind für Ausfallsicherheit, Zuverlässigkeit und hohen Datendurchsatz bekannt. Dennoch erscheint eine Modernisierung auf einen Software Defined Mainframe (SDM) zweckmäßig. Dieser ermöglicht den Weiterbetrieb der Bestandsapplikationen in einer Open-Source-Umgebung. Dadurch kann Bewährtes beibehalten, Neues flexibel hinzugefügt und die Unternehmensagilität gesteigert werden.

NEWS | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | INFRASTRUKTUR | TRENDS 2019 | RECHENZENTRUM

Mainframe-Trends für 2019

Der Mainframe wird auch im Jahr 2019 seinen Platz in der Unternehmens-IT behaupten. Machine Learning, Analytics und intelligente Algorithmen werden den Weg ebnen für selbstverwaltende Mainframe-Umgebungen. In mehrschichtigen Architekturen ist der Mainframe die leistungsfähigste, sicherste und zuverlässigste Backend-Infrastruktur. Welche weiteren Entwicklungen besonders prägend sein werden, weiß Hubert Göhler, Sales Director ZSO in der DACH-Region bei…

NEWS | TRENDS 2022 | TRENDS WIRTSCHAFT | TRENDS INFRASTRUKTUR | DIGITALISIERUNG | TRENDS 2018 | INFRASTRUKTUR | STRATEGIEN

Mythos Mainframes: Großrechner bleiben langfristig Rückgrat der Digitalisierung

Es existieren Vorurteile über aktuelle Rolle und Zukunft von Großrechnern (Mainframes) in Industrie, Handel, Dienstleistung und Verwaltung. Eine Umfrage belegt, dass 91 Prozent der Befragten mit einer Zunahme von Mainframes rechnen. Multicloud-Technologien können sie auch langfristig nicht ersetzen. Große Unternehmen aus Industrie, Handel und Dienstleistung sowie der öffentlichen Verwaltung setzen auch in Zukunft auf…

NEWS | BUSINESS PROCESS MANAGEMENT | TRENDS INFRASTRUKTUR | CLOUD COMPUTING | TRENDS CLOUD COMPUTING | DIGITALE TRANSFORMATION | EFFIZIENZ | TRENDS GESCHÄFTSPROZESSE | GESCHÄFTSPROZESSE | TRENDS 2018 | INFRASTRUKTUR | RECHENZENTRUM

Mainframe wird immer wichtiger: Kritische Workloads nehmen zu

Mehr als drei Viertel der Kunden-Anwendungen hängen vom Mainframe ab. Zahl der Mainframe-Experten sinkt. Unternehmen versäumen die Erhebung wichtiger KPIs. Der Mainframe wird für große Unternehmen immer wichtiger. Die Zahl der Nutzer, die mindestens die Hälfte ihrer geschäftskritischen Anwendungen auf dieser Plattform laufen lässt, wird im kommenden Jahr steigen. Allerdings droht der Mangel an…

NEWS | TRENDS SECURITY | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | DIGITALE TRANSFORMATION | EFFIZIENZ | INFRASTRUKTUR | IT-SECURITY | TRENDS 2017 | STRATEGIEN

Mainframes gelten als besonders sicher, doch bleiben Insiderbedrohungen vielerorts ein weißer Fleck

In Deutschland vertrauen 76 Prozent der Unternehmen einseitig auf Logdateien – und setzen sich damit selbst der Gefahr von Datenlecks aus. Laut einer internationalen CIO-Umfrage halten hierzulande 72 Prozent der IT-Verantwortlichen ihre Mainframerechner für sicherer als andere IT-Systeme [1]. Gleichzeitig gehen 85 Prozent der deutschen Studienteilnehmer von signifikanten Insiderrisiken aufgrund mangelnder Transparenz bei Datenzugriffen auf…

NEWS | BUSINESS | EFFIZIENZ | INFRASTRUKTUR | IT-SECURITY | ONLINE-ARTIKEL | RECHENZENTRUM | SERVICES

RACF-Audit minimiert Risiken bei Mainframe-Kunden

Neun Zehntel aller globalen z/OS-Anwenderunternehmen nutzen RACF für Benutzeridentifikation, Zugriffsrechte-Verwaltung und Logging. Steigende kriminelle Angriffe, organisatorische Mängel oder technische Unfälle erfordern es, das IBM-Tool permanent auf IT-Risiken und Schwachstellen zu überprüfen. Im Rahmen eines neuen Beratungsangebotes bietet die Beta Systems DCI Software AG z/OS-Anwenderunternehmen solche Audits an. Mögliche Schwachstellen lassen sich dadurch rechtzeitig aufdecken und…

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALE TRANSFORMATION | DIGITALISIERUNG | INFRASTRUKTUR | OUTSOURCING | RECHENZENTRUM | SERVICES | TIPPS

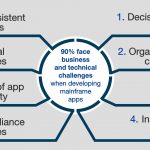

Studie: Mainframe-Anwendungen behindern Innovationen

DevOps ermöglichen günstigere und schnellere Bereitstellung in höherer Qualität. Unternehmen mit Mainframes haben Schwierigkeiten damit, neue Versionen von Anwendungen so schnell bereitzustellen, wie es die digitale Geschäftsentwicklung erfordert. Damit laufen sie Gefahr, die Erwartungen der Kunden an die Produkte nicht zu erfüllen. Dies zeigt eine neue Studie, die von Forrester Consulting im Auftrag von Compuware…

NEWS | BUSINESS | TRENDS INFRASTRUKTUR | DIGITALE TRANSFORMATION | INFRASTRUKTUR | TRENDS 2017 | RECHENZENTRUM | STRATEGIEN

Der Mainframe ist auch im Zeitalter des digitalen Wandels unverzichtbar

Überragende Zuverlässigkeit, Leistung und Sicherheit sind Hauptgründe für Investitionen in Mainframe-Technik. BMC hat die Ergebnisse seines 11. Mainframe Research Report vorgelegt [1]. Danach bleiben schnelle und robuste Mainframe-Systeme auch in Zeiten des digitalen Wandels eine gefragte Plattform. Fast 60 Prozent der befragten Unternehmen gehen davon aus, dass sie sich angesichts zunehmender Datenmengen, Transaktionsvolumina und Datenbankzahlen…

NEWS | CLOUD COMPUTING | EFFIZIENZ | INFRASTRUKTUR | KOMMENTAR | ONLINE-ARTIKEL | RECHENZENTRUM | STRATEGIEN

Zeit umzudenken: Der Mainframe ist tot, lang lebe der Mainframe!

7 Mythen über Mainframes von Peter Schroff, Principal Value Engineer bei BMC Software. Mainframes stehen nicht im besten Ruf. Der Otto Normalverbraucher assoziiert sie zuweilen mit gewissenlosen Künstlichen Intelligenzen, die die Menschheit entweder ausbeuten oder auslöschen wollen – wie etwa in den »Terminator«- oder »Matrix«-Trilogien. Im besten Fall denkt er an den Supercomputer »Deep Thought«…

NEWS | CLOUD COMPUTING | INFOGRAFIKEN | RECHENZENTRUM

So sehen vier Mitarbeiter-Generationen den Mainframe

Viele Technologien kommen und gehen, doch eine bleibt: Der Mainframe. Dieser bildet bereits seit seiner Einführung in den 60er-Jahren die Basis für fast alle Transaktionen im Finanzsektor, aber auch in anderen Bereichen wie im Flugverkehr. Während sich die grundlegenden Technologien nur wenig verändert haben, wird er inzwischen von der vierten Generation an Mitarbeitern verwaltet. Doch…

NEWS | DIGITALISIERUNG | EFFIZIENZ | FAVORITEN DER REDAKTION | IT-SECURITY | KÜNSTLICHE INTELLIGENZ | SERVICES | STRATEGIEN

Observability, Application Security und KI: Tiefe KI-gestützte Echtzeit-Einblicke für Entwicklungsprozesse

Optimierung von DevOps und Platform Engineering durch Observability, Application Security und KI. Bei der Bereitstellung von Cloud-nativen Technologien und Software spielen die Disziplinen DevOps und Platform Engineering eine entscheidende Rolle. Um Zuverlässigkeit, Sicherheit und Effizienz in den Prozessen zu gewährleisten, ist es wichtig, weitere technologische Investitionen zu tätigen. Eine dieser Schlüsseltechnologien ist Observability. …

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | SERVICES | STRATEGIEN

Auf dem Weg zu Full-Stack Observability: Drei wichtigste Meilensteine

Die Überwachung der gesamten Anwendungsperformance ist mittlerweile zu einem wesentlichen Bestandteil vieler Unternehmensstrategien geworden. Das gaben 85 Prozent der IT-Experten in einer kürzlich von Cisco durchgeführten globalen Studie an [1]. Tommy Ziegler, FSO Leader Sales Engineering von Cisco AppDynamics, verrät, wie wichtig es für IT-Experten und Entwickler ist, ihren gesamten IT-Stack im Blick zu haben,…

TRENDS 2024 | NEWS | TRENDS INFRASTRUKTUR | DIGITALISIERUNG | INFRASTRUKTUR | INFOGRAFIKEN | SERVICES

Die Forderung nach holistischem Durchblick setzt IT-Experten unter Druck

In einer kürzlich von Cisco durchgeführten Studie haben 75 Prozent der Umfrageteilnehmer angegeben, dass die digitale Erfahrung in den letzten drei Jahren für die Führungskräfte in ihrem Unternehmen zu einem deutlich wichtigeren Thema geworden ist. In den meisten Unternehmen (80 Prozent) wird dabei die Leistung geschäftskritischer Anwendungen und digitaler Services sowie deren Auswirkung auf das…

TRENDS 2024 | NEWS | DIGITALISIERUNG | EFFIZIENZ | KÜNSTLICHE INTELLIGENZ | SERVICES | STRATEGIEN | WHITEPAPER

State of Application Modernization 2024 Report

Als Mitglied der Konveyor-Community hat Red Hat gemeinsam mit dem Marktforschungsunternehmen Illuminas in einer neuen Studie untersucht, was die Hauptgründe für die Modernisierung von Anwendungen sind und wie Unternehmen dabei vorgehen. Aus den Antworten der rund eintausend Befragten stechen dabei deutlich die drei Faktoren Sicherheit, Zuverlässigkeit und Skalierbarkeit hervor. Mit 68 Prozent gab erstmals eine…

NEWS | INFRASTRUKTUR | RECHENZENTRUM | SERVICES

Erfolgsfaktoren für die Anwendungsmodernisierung im Rechenzentrum

Damit Unternehmen langfristig wettbewerbsfähig bleiben, müssen sie schnell auf Marktveränderungen reagieren und mit technologischen Entwicklungen Schritt halten. Doch das gelingt nur, wenn auch die IT-Systeme mitspielen. Aerospike rät Unternehmen daher, ihre Legacy-Anwendungen regelmäßig auf den aktuellen Stand zu bringen. Milliarden von Entscheidungen werden heute in weniger als einer Millisekunde getroffen: bei der Betrugsbekämpfung, beim Online-Shopping…

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | DIGITALISIERUNG | SERVICES | STRATEGIEN

Vier Phasen für eine erfolgreiche VMware-Migration: Erkennen, Analysieren, Pilotieren und Planen

Wie eine reibungslose Umstellung auf eine VMware-Alternative sichergestellt werden kann. Eine Schockwelle ging durch die Welt der Virtualisierung und Cloud Computing, als Broadcom die Übernahme von VMware im Mai 2022 ankündigte. Speziell die Meldungen der vergangenen Wochen haben für Wirbel gesorgt und dazu geführt, dass sich viele Unternehmen – teilweise eilig – auf die…

TRENDS 2024 | NEWS | BUSINESS | TRENDS SERVICES | KÜNSTLICHE INTELLIGENZ

Vorhersagen 2024: Daten und KI, Schlüssel zu Geschäftsleistungen und -ergebnissen

Das Jahr 2023 stand im Zeichen großer Veränderungen in der IT mit dem Aufkommen von ChatGPT und anderen generativen KI-Tools, die in vielen Sektoren, auch in der Datenverarbeitung, eine neue Rolle spielen. Diese Innovationen haben die IT-Landschaft und ihre Regeln deutlich verändert und sollten von Unternehmen berücksichtigt werden, die wachsen, Vorschriften einhalten und ihre Leistung…