Die New Economy der frühen 2000er kündigte sich noch mit einem Donnerschlag an – man denke nur an die Fintechs, die mit ihrer technologiegetriebenen Entwicklung angetreten sind, den Finanzsektor auf den Kopf zustellen. Weitgehend unbemerkt erreicht diese Revolution mittlerweile auch die traditionellen Branchen. So hat selbst Volkswagen angekündigt, seine Marke in Zukunft über die Software zu definieren, und bündelt dazu in der neuen Einheit »Car.Software« die Kompetenz von mehr als 5.000 Digitalexperten. Doch ganz gleich, wo man hinschaut: Von den hoch optimierten Produktionsprozessen der Industrie ist die Softwareentwicklung noch weit entfernt – und das, obwohl die größten Kostenfallen längst bekannt sind.

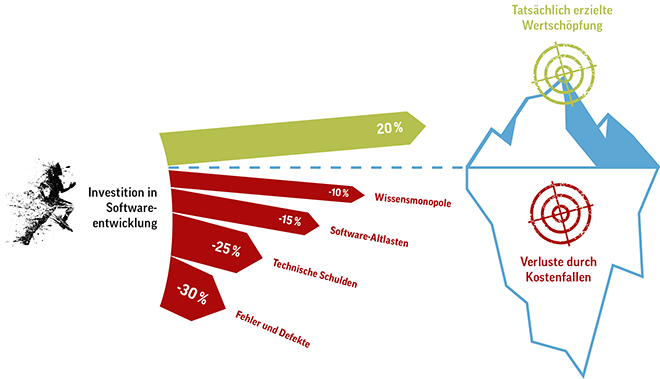

Als Idealfall will der interne oder externe Auftraggeber einer Entwicklung jeden Euro des investierten Budgets in volle 100 Cent Softwareinnovation umgesetzt sehen«, sagt Marc Hildebrandt, CEO und Gründer des Technologie-Inkubators German Deep Tech, der akademische Exzellenz in industriell nutzbare Softwarelösungen transformiert. »Wenn die Teams jedoch größer und die Projekte komplexer werden, entfernt man sich von diesem Ziel zwangsläufig immer weiter, weil mehr Budget auf Nebenschauplätzen auf der Strecke bleibt.«

Kostenfalle: Fehlerbehebung verschleppen.

Auch wenn es trivial klingt: Die Fehlerbehebung macht den größten unproduktiven – und obendrein unvorhersehbaren – Anteil an der Arbeitszeit von Entwicklern aus. Damit ist nicht nur das routinemäßige Testen der Software als Teil des Release-Zyklus gemeint. Richtig problematisch sind die Fehler, die es bis zu den Endanwendern geschafft haben. Das Managementsystem zur Prozessverbesserung Six Sigma kennt dafür die Zehnerregel: Die Kosten für einen nicht entdeckten Bug erhöhen sich von Stufe zu Stufe der Wertschöpfung um den Faktor 10. Je früher ein Fehler entdeckt und beseitigt wird, desto kostengünstiger ist dies also für die Organisation.

Vor allem sind spät gefundene »Defects« im ausgelieferten Code für die Entwickler frustrierend, weil sie häufig mit viel Aufwand und unter Zeitdruck behoben werden müssen, während die eigentlichen Aufgaben hintangestellt werden. Erfolg und Motivation im Team langfristig aufrechtzuerhalten und zugleich die Fehlerbehebung zu optimieren kann eine große Herausforderung an die Arbeitsorganisation bedeuten – ob nun einzelne Entwickler dafür verantwortlich zeichnen oder die Last gleichmäßig verteilt wird. »Letzten Endes muss sich das Team nun entscheiden, was sich besser anfühlt: Abwechselnd Freiwillige, die intensiv Bugfixing betreiben und für Anfragen zur Verfügung stehen, oder paralleles Arbeiten, das auf jeden Fall ablenkt und den Fokus verlieren lässt«, fasst Dr. Markus Friedrich, Spez. Entwicklung – Architektur Fahrzeugvernetzung bei der BMW Group im XING-Forum »SCRUM« zusammen.

Kostenfalle: Technische Schulden aufnehmen.

Wenn Software entwickler unter Zeitdruck arbeiten müssen, neigen sie dazu, von den eigentlich getroffenen Vereinbarungen abzuweichen und unsauber zu programmieren. Das kann im Einzelfall sinnvoll sein, um Release-Termine einzuhalten oder eine schnelle Fehlerbehebung vorzunehmen. Derartige Stellen im Quellcode werden auch als technische Schulden bezeichnet. Die Zinsen dafür zahlen diejenigen Entwickler, die später mit dem Code weiterarbeiten müssen, etwa um ihn zu erweitern. Sie benötigen mehr Zeit, sich einzuarbeiten, kommen langsamer voran und machen dabei mit größerer Wahrscheinlichkeit Fehler.

So sinnvoll die Aufnahme technischer Schulden in begründeten Einzelfällen auch sein mag – die Entscheidung gegen eine saubere Lösung fällt von Mal zu Mal leichter. Aus der Sozialpsychologie ist dieser Effekt als Broken-Windows-Theorie bekannt: An einem Gebäude mit zahlreichen bereits zerstörten Fenstern wird leichter ein weiteres Fenster eingeschlagen als an einem intakten Haus. Wird das Auslassen oder Verkürzen von Prozessschritten zum Normalfall im Entwicklungsteam, entsteht im Lauf der Zeit ein Flickenteppich an nicht-konformem Code, der kaum noch zu pflegen ist.

Kostenfalle: Altlasten anhäufen.

Technische Schulden sind Altlasten, die den Entwicklungsprozess so sehr behindern können, dass er nahezu zum Erliegen kommt. Spätestens wenn beim Auftraggeber der Eindruck entsteht, das Team sei nur noch mit sich selbst beschäftigt, führt kein Weg mehr an einem operativen Eingriff in den Code vorbei. Dieser kann minimalinvasiv als Refactoring erfolgen – immer, wenn betroffener Code angefasst werden muss, wird an dieser Stelle die Altlast gleich mit beseitigt – oder gemeinsam im Team als groß angelegtes Redesign des Codes auf einen Schlag erledigt werden.

»Ob im eigenen Haus oder extern, ob von Hand oder mit Werkzeugunterstützung – die Beseitigung von Altlasten lässt sich optimieren, aber immer müssen Zeit und Geld investiert werden, die dann nicht mehr für die eigentliche Entwicklungsaufgaben zur Verfügung stehen«, sagt Günter Hofmann, Geschäftsführer des Anwendungsmodernisierungs-Dienstleisters fecher. Trotzdem lohnt es sich aus seiner Sicht, diesen Aufwand eher früher als später zu betreiben: »Die größte Überraschung für die Entwicklungsteams ist es immer, nach Abschluss eines Modernisierungsprojekts zu sehen, wie viel leichter die Weiterentwicklung nun von der Hand geht.«

Kostenfalle: Wissensmonopole zulassen.

In einem komplexen Softwareprojekt mit Hunderttausenden von Zeilen kann sich nicht jedes Teammitglied auch noch im letzten Winkel der Code-Base auskennen. Gefährlich wird es jedoch immer da, wenn Wissensmonopole entstehen und der Erfolg von einigen wenigen Experten abhängt. Im Risikomanagement lassen sich solche Monopole durch den Bus-Faktor beschreiben: Wie viele Personen würden das Projekt ernsthaft in Gefahr bringen, »wenn sie von einem Bus überfahren werden«. Diese plakative Beschreibung schließt harmlosere Ausfallgründe wie Krankheit oder Verlassen des Unternehmens natürlich mit ein.

»Stellen Sie sich einfach vor, ein Schlüsselmitarbeiter des Projekts fällt überraschend für zwei oder drei Wochen aus«, sagt Dr. Martin Kuhlmann, Senior Solution Architect bei Omada. Wenn dann das ganze Projekt stehen bleibt, andere Entwickler eine lange Einarbeitungszeit benötigen, bis sie einspringen können, und mit dem unbekannten Code nur langsam vorankommen, zeigt sich die ganze Problematik. »Die Abhängigkeit von einzelnen Mitgliedern ist immer eine große Gefahr für das Team«, betont Kuhlmann. Gegensteuern lässt sich beispielsweise mit agilen Vorgehensmodellen, die einen regelmäßigen Austausch fördern und die Verantwortlichkeit für den Code auf alle Entwickler verteilen.

Software Analytics zeigt Ansatzpunkte. Einschlägige Schätzungen taxieren die Verluste durch Kostenfallen wie die genannten bereits in mittleren Entwicklungsprojekten auf über 50 Prozent. In großen, komplexen Projekten summieren sie sich leicht zu 80 oder 90 Prozent auf. »Wenn nur 20 Prozent der eingesetzten Produktivmittel den eigentlichen Zweck erfüllen, würde man in der Business-Welt doch schnellstens handeln«, befindet der Deep-Tech-Unternehmer Hildebrandt. »Wie können wir das ausgerechnet in unserer hoch technisierten Softwarewelt akzeptabel finden?«

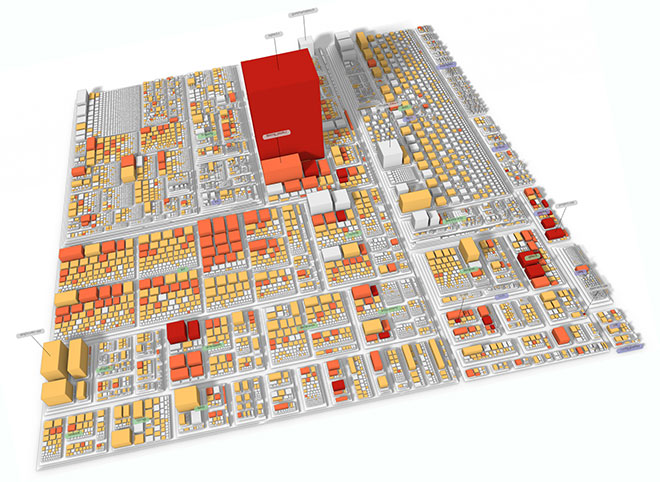

Abbildung 1: Visualisierung eines komplexen Code-Systems mit Software Analytics.

Tatsächlich wird selbst in Fortune-500-Unternehmen die Entwicklung komplexer Softwaresysteme bislang eher als Kunstform denn als Ingenieurwissenschaft gehandhabt. Der Prozess zerfällt in verschiedene Aufgabenbereiche, in denen jeweils eigene Sprachen und Sichtweisen vorherrschen und isolierte Softwarewerkzeuge zum Einsatz kommen. Agile Methoden können mit ihren Organisationsformen das Siloproblem etwas lindern, ändern aber auch nichts daran, dass der Prozess quer durch die Expertisenfelder verläuft. Somit muss eine ständige Übersetzung zwischen den Artefakten und Sprachwelten stattfinden und die Nachverfolgbarkeit des Prozesses bleibt gerade im Enterprise-Kontext, wenn mehrere Teams zusammen an einem großen System entwickeln, reines Wunschdenken. Wollen sich die Verantwortlichen im Management einen Überblick verschaffen, müssen sie Informationen bei den jeweiligen technischen Experten einholen und sind dabei in Ermangelung einer gemeinsamen Datengrundlage und Sprache mit den technischen Experten schlussendlich auf ihr Bauchgefühl angewiesen.

Abbildung 2: Die größten Kostenfallen in der Softwareentwicklung.

Ähnlich wie in der Business-Welt Big Data und Business Intelligence (BI) dazu geführt haben, dass das Management jederzeit verlässliche Entscheidungsgrundlagen auf Basis harter Fakten zur Verfügung stehen, will die verhältnismäßig neue Disziplin der »Software Analytics« dies mit dem Prozess der Softwareentwicklung ebenfalls erreichen. »In Repositorien und all den anderen Werkzeugen haben wir ausgezeichnete, präzise Daten über alle wesentlichen Aspekte der Softwareentwicklung vorliegen«, erläutert Prof. Jürgen Döllner vom Hasso-Plattner-Institut für Digital Engineering (HPI) in Potsdam. »Bislang fehlte schlicht und ergreifend die Erkenntnis, dass man aus diesen Daten wertvolles Wissen generieren kann.«

Gezielte Verbesserungen umsetzen. Dieses Wissen entsteht erst, wenn man den komplexen Prozess der Softwareentwicklung vom Anforderungsmanagement über die Codierung und das Testen bis zum Release Management betrachtet. »Nur wer weiß, wo im Gesamtprozess die Verluste entstehen, kann sinnvoll gegensteuern«, erläutert Geschäftsführer Dr. Johannes Bohnet von Seerene. Dazu bietet die HPI-Ausgründung in ihrer Seerene-Analytics-Plattform Business-Dashboards, auf denen sich die einzelnen KPI-Kennzahlen in Echtzeit verfolgen lassen. Bei Abweichungen vom Soll-Wert können alle Beteiligten, vom Manager bis zu den Experten, dann per Drill-Down zur genauen Ursache vorstoßen.

Verbringt das Team beispielsweise zu viel Zeit mit Fehlerbehebung, lässt sich exakt analysieren, an welchen Stellen in der Code-Base die Probleme entstehen und wo die Entwickler ihre Zeit beim Beheben von Fehlern tatsächlich verbringen. »Diese Art von Wissen ist extrem wertvoll, weil sie Konsequenzen hat: Wie ein Chirurg kann ich nun die Handvoll Stellen im Code reparieren, um die es wirklich geht«, so Bohnet. Die eingesparte Zeit steht dann zusätzlich für produktive Arbeiten zur Verfügung. »Letzten Endes erhält der Auftraggeber mehr Innovation für sein investiertes Budget«, freut sich der Software-Analytics-Experte. »In nahezu jedem Softwareprojekt lässt sich so ad hoc ein Produktivitätszuwachs von über 30 Prozent erreichen.«

Michael Ihringer

Michael Ihringer

Freier Autor in Darmstadt

Weitere Informationen:

www.seerene.com

Illustrationen: © Vectomart, ITS STUDIO, robodread,Rvector/shutterstock.com; Seerene

774 Artikel zu „Software Analytics“

NEWS | PRODUKTMELDUNG

Qlik zählt zu den führenden Anbietern für Analytics und BI-Software

Top-Bewertung für Qlik bereits zum neunten Mal in Folge. Das Analystenhaus Gartner bewertet Qlik im jährlichen Magic Quadrant for Analytics and Business Intelligence Platforms [1] schon zum neunten Mal in Folge als Leader. Diese erneute Spitzenplatzierung gab Qlik bekannt. »Qliks Investitionen werden weiterhin Kunden dabei unterstützten, die komplexesten Datenherausforderungen zu bewältigen und den Wandel voranzutreiben,…

NEWS | BUSINESS INTELLIGENCE | TRENDS 2016

Softwaremarkt für Customer Analytics

Die in Customer-Analytics-Projekten eingesetzte Software sollte den Nutzer möglichst in allen Phasen des Vorgehensmodells unterstützen. Neben den Möglichkeiten der analytischen Modellierung sollten auch Funktionalitäten im Bereich der Datenaufbereitung und Anbindungen an gängige Datenbanken und Fachsysteme (ERP, WAWI, CRM etc.) unterstützt werden. Die Software sollte die Evaluierung der erstellten Modelle anhand geeigneter Performance-Metriken, sowie eine Visualisierung…

AUSGABE 3-4-2020 | NEWS | BUSINESS | STRATEGIEN

Dank Advanced Analytics dem Kunden einen Schritt voraus

Die Bedeutung von Datenanalysten wird weiter zunehmen, Anwendungsbeispiele sind vielfältig. Mithilfe von künstlicher Intelligenz lassen sich beispielsweise Abwanderungspotenziale von Kunden frühzeitig identifizieren – und somit rechtzeitig verhindern. Ähnliches gilt für Bestandsprognosen, einen kosteneffizienten Lagerbetrieb und eine höhere Kundenzufriedenheit. Advanced Analytics kann Unternehmen also in vielerlei Hinsicht unterstützen.

NEWS | BUSINESS PROCESS MANAGEMENT | GESCHÄFTSPROZESSE | LÖSUNGEN

Software für Unternehmensplanung ermöglicht umfangreiche Auswertungen

Mit leichter Hand von vereinfachten Prozessen profitieren. Fehleranfällige Prozesse ablösen, Transparenz und Planungssicherheit ermöglichen: Als mehrere GmbHs auf die Mutter verschmolzen wurden, hat ein führender Baustoffspezialist nach einer kurzen Übergangszeit mit Excel-Tabellen erkannt, dass Auswertungen und Planung ohne leistungsstarke Software nur schwer zufriedenstellend bewältigbar sind. Mit einer Planungs- und Controllingsoftware wurde die passende Lösung gefunden,…

TRENDS 2020 | NEWS | TRENDS SECURITY | IT-SECURITY

Software-Security-Trends 2020

Im Zuge von Digitalisierung und IoT wird Software-Security über alle Branchen und Unternehmensgrößen hinweg immer wichtiger. Unternehmen von KMU bis Konzern benötigen leistungsfähige Software-Analyse-Lösungen, um ihre Anwendungen über den gesamten Software Development Lifecycle zuverlässig abzusichern. Dr. Christopher Brennan, Regional Director DACH bei Checkmarx, gibt einen Ausblick auf die Themen, die den Software-Security-Markt 2020 prägen werden.…

TRENDS 2020 | NEWS | TRENDS INFRASTRUKTUR | INFRASTRUKTUR

2020 viel Dynamik im Storage-Umfeld: Container, Analytics und KI zünden die nächste Stufe

Auch wenn Storage und Data Management sowie die damit verbundene Infrastruktur mittlerweile oft unter »Commodity« eingeordnet wird, so sieht Pure Storage auch in Zukunft hier ein erhebliches Potenzial für Unternehmen und deren Kunden. Für das Jahr 2020 geht Güner Aksoy, Director Central Europe bei Pure Storage von 6 wichtigen Entwicklungen aus, die direkte Auswirklungen auf…

TRENDS 2020 | NEWS | BUSINESS | TRENDS GESCHÄFTSPROZESSE

2020: Digitalisierung und künstliche Intelligenz sind Treiber im Markt für Business-Software

Fünf Haupttrends prägen die IT-Branche und den Markt für Business-Software laut der d.velop Herbstprognose 2020 in besonderem Maße. Seit fast einem Jahrzehnt wertet d.velop jedes Jahr die Daten und Informationen aus Kundenbefragungen, von Partnern und Mitarbeitern für eine interne Prognose aus. 2019 werden die Ergebnisse erstmals in Form der nun vorliegenden Herbstprognose mit fünf Haupttrends…

Analytics reicht nicht mehr aus: Top-Trends im Big-Data-Umfeld 2020

Wide Data, DataOps, Metadaten-Kataloge, Datenkompetenz und Shazamen sind die wichtigsten Trends im kommenden Jahr. Für 2020 hat der Data-Analyst-Spezialist Qlik folgende fünf Trends im Zusammenhang mit Big Data und Analytics identifiziert: Aus Big Data wird Wide Data Dank skalierbarer Cloud-Lösungen sind in Big-Data-Umgebungen nicht länger die Kapazitätslimits unternehmensinterner IT-Infrastrukturen ein begrenzender Faktor. Die Herausforderung…

TRENDS 2020 | NEWS | TRENDS SECURITY | TRENDS CLOUD COMPUTING

IT-Trends 2020: Hybrid Cloud, Predictive Data Analytics und Nachhaltigkeit bestimmen die Agenda

Zum Ende des Jahres wird es Zeit, die Technologien und Ansätze ins Auge zu fassen, die 2020 die Unternehmens-IT beeinflussen werden. Sage hat fünf Trends identifiziert, mit denen sich Entscheider und Entwickler vermehrt beschäftigen sollten, um Effizienz und Wettbewerbsstärke voranzutreiben. Hybrid Cloud, Data Analytics, DevOps, energieeffiziente Software und Security by Design sind, so Oliver Henrich,…

NEWS | BUSINESS INTELLIGENCE | TRENDS GESCHÄFTSPROZESSE | FAVORITEN DER REDAKTION | TRENDS 2019

Käufer von BI-Software setzen die falschen Prioritäten

Das Business Application Research Center (BARC) veröffentlicht den BI Survey 19, die neueste Ausgabe seiner einflussreichen, empirischen Studie über den globalen Markt für Analytics und Business Intelligence (BI) Software [1]. Daten aus dem BI Survey 19 zeigen, dass die beliebtesten Gründe für den Kauf eines BI-Produkts nicht immer diejenigen sind, die zu den erfolgreichsten Implementierungen…

NEWS | BUSINESS INTELLIGENCE | SERVICES | AUSGABE 7-8-2019

Der Mittelstand profitiert eindeutig von Predictive Analytics – Einfach mal probieren

Predictive Analytics ist mehr als nur ein Big-Data-Trend. Beispiele zeigen, dass gerade der Mittelstand ohne großen finanziellen Aufwand Daten nutzen kann, um zukünftige Ereignisse vorherzusagen.

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | DIGITALE TRANSFORMATION

Neue Kultur durch Business Intelligence & Advanced Analytics

Im Zuge des rasant fortschreitenden technischen Wandels stehen Unternehmen heute neue Analysemethoden zur Verfügung. Im Gegensatz zur vergangenheitsorientierten klassischen Business Intelligence (BI) verfolgen diese modernen Analysewerkzeuge einen in die Zukunft gerichteten Verwendungszweck. Dadurch ist es nun möglich, nicht nur den operativen und strategischen Mehrwert von Daten erheblich zu steigern, sondern Informationen als entscheidenden Erfolgsfaktor zu…

NEWS | BUSINESS | BUSINESS INTELLIGENCE | LÖSUNGEN | ONLINE-ARTIKEL | SERVICES

Der Mittelstand profitiert eindeutig von Predictive Analytics

Predictive Analytics ist mehr als nur ein Big-Data-Trend. Beispiele zeigen, dass gerade der Mittelstand ohne großen finanziellen Aufwand Daten nutzen kann, um zukünftige Ereignisse vorherzusagen. Der Wunsch ist vielerorts groß, Vorhersagen auf Basis von historischen Daten zu treffen. Aber wie stellen sich Mittelständler mit ihren vergleichsweise kleinen IT-Abteilungen wirkungsvoll auf? Wie können die innovativen Vorstellungen…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | GESCHÄFTSPROZESSE | PRODUKTMELDUNG

Business-Intelligence-Lösung finden: Dynamischer Konzern braucht anpassungsfähige Software

Die Qual der Wahl: Passende Software im breiten Angebot zu finden, ist für Unternehmen mittlerweile eine Herausforderung, für jeden noch so individuellen Unternehmensbedarf gibt es unzählige Softwarelösungen, die in Frage kommen. Auch die ISL Group hat diese Erfahrung gemacht, als sie eine Business-Intelligence-Lösung benötigte. Der intensive Vergleich lohnte sich: Mit BPS-ONE von Denzhorn wurde das…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | STRATEGIEN | AUSGABE 3-4-2019

Advanced, predictive, preventive: Data Analytics – Trend oder Zukunft?

Die Themen Digitalisierung und Big Data stehen bereits seit Jahren auf der »To-do-Liste« der Unternehmen und sind auch in den Fachmedien mehr als präsent. Allerdings steckt die Umsetzung in der Realität bei vielen Unternehmen noch in den Kinderschuhen. Das Potenzial, das Daten bieten, ist häufig nicht auf den ersten Blick ersichtlich. Erst durch eine detaillierte Analyse der Daten lassen sich diese optimal nutzen. Mittlerweile eröffnen sich hier mit Data Analytics ganz neue Möglichkeiten.

NEWS | BUSINESS INTELLIGENCE | DIGITALE TRANSFORMATION | STRATEGIEN | AUSGABE 3-4-2019

Mehr als Business Intelligence – Was erfolgreiche Analytics-Projekte auszeichnet

Damit Digitalisierung eine Erfolgsgeschichte werden kann, ist der Umgang mit Daten ein entscheidender Faktor: Fakten statt Bauchgefühl, Vernetzung statt Silo-Denken, Transparenz statt Exklusivität in der Entscheidungsfindung.