Softwarestörungen und -ausfälle kosten einerseits Zeit und Geld und frustrieren andererseits die Anwender. Umso wichtiger ist ein End-2-End-Monitoring, das frühzeitig mögliche Probleme erkennt. Die Implementierung und der Betrieb des Monitorings sind aber keine einfache Angelegenheit.

Das »traditionelle« Monitoring mit der Überwachung von CPU-Last, Datenbankeffizienz oder Applikationsverfügbarkeit reicht für die heutigen komplexen Systemarchitekturen nicht mehr aus. Eine optimale Funktionsweise und hohe Qualität von Systemen und Anwendungen sind nur mit einem ganzheitlichen End-2-End-Monitoring sicherzustellen, das vor allem auch die Nutzersicht umfasst. Allerdings ist das Aufsetzen eines End-2-End-Monitoring-Prozesses komplex und mit etlichen Herausforderungen verbunden. Die Auswahl der adäquaten Technologien, die Identifizierung geschäftskritischer Prozesse oder die Bestimmung der richtigen Schwellenwerte sind nur einige der Aufgaben.

Um Fehler bei der Einrichtung eines End-2-End-Monitorings zu vermeiden, hat der IT-Dienstleister Consol zehn Punkte zusammengestellt:

- Fokussierung auf geschäftskritische Pfade der Anwendung

Die regelmäßige Durchführung von End-2-End-Tests ist ressourcen- und wartungsintensiv und erfordert ein dediziertes Testmaschinen-, Testfarm- oder Container-Setup. Deshalb sollten End-2-End-Tests vor allem auf die zentralen und geschäftskritischen Pfade einer Anwendung abzielen.

- Durchführung der End-2-End-Überwachung auf Produktionssystemen

Das End-2-End-Monitoring erfolgt nach Möglichkeit auf Produktionssystemen und nicht auf alternativen Umgebungen mit einem unterschiedlichen Setup. Damit ist eine realistische Messung der User Experience und eine effiziente Sicherung des Umsatzes gewährleistet.

- Bestimmung der richtigen Schwellenwerte

Wenn die Performance einer Anwendung unter einen bestimmten Schwellenwert fällt, wird ihr Durchsatz und ihre Conversion-Rate drastisch reduziert, da sich das System für die Erwartungen eines Benutzers »zu langsam« anfühlt. Laut der Studie »A study on tolerable waiting time: how long are Web users willing to wait?« (2003; Prof. Nah) beträgt die akzeptable Wartezeit gerade einmal zwei Sekunden. Daher ist es wichtig, zur Aufrechterhaltung des Geschäftsbetriebs die richtigen Schwellenwerte zu bestimmen.

- Ruhe bewahren

Korrekt eingestellte Schwellenwerte lösen Alarme rechtzeitig aus, sodass unmittelbar reagiert werden kann. In komplexen Systemen können Belastungsspitzen zu Schwankungen in der Systemleistung führen, ohne dass ein ernsthaftes Problem daraus entsteht. Daher erfordert eine Warnung möglicherweise keine sofortige Reaktion, sondern lediglich eine Beobachtung, ob sich das System stabilisiert oder ob ein Eingreifen erforderlich wird.

- Durchführung eines globalen End-2-End-Monitorings

Wird eine Anwendung global genutzt, sollte das End-2-End-Monitoring in den entsprechenden lokalen Regionen und Märkten betrieben werden. Effekte die durch hohe Latenzzeiten oder schlechte Routing-Effizienz hervorgerufen werden und damit die Benutzerfreundlichkeit stark beeinflussen, können somit identifiziert und überwacht werden.

- Isolation vom Tagesgeschäft

Daten aus Monitoring-Checks dürfen das Tagesgeschäft nicht beeinträchtigen. Durch die Verwendung von identifizierbaren Testdaten und Dummy-Anmeldeinformationen kann ein Einfluss etwa auf Business-Intelligence-Systeme vermieden werden.

- Trennung von Test- und Produktivdaten

Testdaten und Testkonten in der Produktion sollten klar gekennzeichnet sein, um sie von Produktivdaten zu trennen. Eine transparente, zentralisierte Verwaltung und Dokumentation aller Testdaten sind dabei essenziell, um den Überblick zu behalten.

- Verschlüsselung sensibler Daten

Auch der Compliance-Aspekt darf nicht vernachlässigt werden, gerade hinsichtlich der Zugangsdaten für Testkonten auf Produktionssystemen. Moderne End-2-End-Monitoring-Tools verfügen über Sicherheitsmechanismen, die eine vollständige Verschlüsselung von Anmeldeinformationen bieten.

- Ermittlung von Mustern aus den Gesamtergebnissen

Ein einzelner fehlgeschlagener Test muss noch kein Indikator für eine fehlerhafte Anwendung sein. Die Probleme könnten durch den Internet Service Provider, die Infrastruktur, das Netzwerk oder interne Services hervorgerufen worden sein. Anstatt die Ergebnisse einzeln zu überprüfen, sollten Muster aus den Gesamtergebnissen ermittelt werden.

- Vergleichbare Messergebnisse erzeugen

Funktionalitäten, die in Abhängigkeit von Bedingungen getestet werden, können beim Monitoring zu inkonsistenten beziehungsweise nicht vergleichbaren Ergebnissen führen, wenn dadurch die Messergebnisse maßgeblich beeinflusst werden oder nur bedingt zustande kommen. End-2-End-Monitoring-Tests sollten, wenn möglich, ohne Bedingungen aufgebaut werden, um einheitliche Performance-Daten zu erhalten.

»End-2-End-Monitoring kann eine große Herausforderung sein. Feinheiten wie die Wahl der richtigen Schwellenwerte oder die Auswahl der zu testenden Prozesse und Workflows sind nicht auf den ersten Blick ersichtlich«, erklären Cliff Le Van von Consol. »Auf Basis unserer langjährigen Erfahrung in den Bereichen End-2-End-Testing und -Monitoring haben wir Punkte entwickelt, die Unternehmen ein erstes Hilfsmittel an die Hand geben, um erfolgreich in ein ganzheitliches Monitoring zu starten.«

Whitepaper zum Download

Weitere Informationen finden sich in dem Consol-Whitepaper »10 Step Guide to E2E Monitoring«. Es steht zum kostenlosen Download unter https://sakuli.io/wp/ zur Verfügung.

626 Artikel zu „Monitoring“

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | SERVICES

Managed Monitoring: Über die Schulter geschaut

Managed Monitoring hilft Rechenzentren dabei, die Herausforderungen der Verfügbarkeit und Performance zu meistern. In Zeiten von Digitalisierung, Cloud, und Big Data stellen Unternehmen immer höhere Ansprüche an ihre IT-Landschaften. Gleichzeitig müssen diese Systeme in immer kürzerer Zeit immer größere Datenmengen bewältigen. Verfügbarkeit und Performance werden zu jeder Tages- und Nachtzeit vorausgesetzt. Ausfallzeiten oder geringe Geschwindigkeiten…

NEWS | PRODUKTMELDUNG | WHITEPAPER

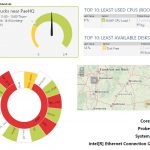

Wie Netzwerk-Monitoring die tägliche Arbeit eines Admins erleichtern kann

IT-Verantwortliche in Unternehmen haben es in ihrem Arbeitsalltag mit unterschiedlichsten Herausforderungen zu tun. Auch der beste IT-Administrator sehnt sich manchmal nach Hilfe, steckt doch der Alltag als IT-Administrator voller Überraschungen. Störungen im Netzwerk treten meist unangekündigt auf. Dabei hilft Ihnen in vielen Fällen eine umfassende Monitoring-Lösung, um Netzwerkprobleme zu vermeiden. In einem Whitepaper haben die…

NEWS | INFRASTRUKTUR | ONLINE-ARTIKEL | SERVICES

Gesundes Netzwerk dank Monitoring-Lösung

SmartStep wählt PRTG als zentrale Anlaufstation für seine hybride Infrastruktur. SmartStep ist ein modernes Beratungsunternehmen für die pharmazeutische und medizintechnische Industrie. Die Hamburger sind darauf spezialisiert, Herstellern einen schnellen Marktzugang für Produkte zu ermöglichen. In diesem komplexen Tätigkeitsfeld können Tage oder Stunden über den Erfolg entscheiden. Sollten dann Probleme mit der IT auftreten, kann…

NEWS | BUSINESS PROCESS MANAGEMENT | FAVORITEN DER REDAKTION | LÖSUNGEN | SERVICES | AUSGABE 5-6-2018

Übergeordnetes, einheitliches und umfassendes Monitoring – IT-Überwachung mit Schirm, Charme & Tool

Umbrella-Monitoring ist ein ganzheitlicher Lösungsansatz, mit dem über Jahre gewachsene heterogene Monitoring-Insellösungen durch ein übergeordnetes, einheitliches und umfassendes Monitoring zusammengeführt werden. Damit lassen sich nicht nur die Betriebs- und System-betreuungs-kosten senken, sondern vor allem auch das Risiko von Sys-temausfällen und Compliance-Verletzungen minimieren.

NEWS | LÖSUNGEN | PRODUKTMELDUNG | TIPPS

Agiles Web Testing und Monitoring durch automatisierte symptombasierte Fehlersuche

Wird das digitale Qualitätsmanagement durch Lean Testing revolutioniert? Leankoala aus Hamburg bietet mit seiner gleichnamigen Software eine Methode für das Testen und Monitoring von Websites, die auf dem Markt einzigartig ist. Die neue Lösung folgt dem sogenannten Lean-Testing-Ansatz, indem sie Websites auf relevante, geschäftskritische Eigenschaften durchsucht, statt alle möglichen Fehlerursachen zu überprüfen. Somit lassen sich…

NEWS | DIGITALISIERUNG | DIGITALE TRANSFORMATION | INDUSTRIE 4.0 | TRENDS 2018 | INTERNET DER DINGE | KÜNSTLICHE INTELLIGENZ | SERVICES | STRATEGIEN

Industrie 4.0 mit Luft nach oben: Manuelle Datenerfassung statt Echtzeit-Monitoring

Erschließung neuer Geschäftsmodelle Treiber der Digitalisierung. Nur jeder zweite Industriebetrieb setzt bereits Digitalisierungsprojekte um. Hindernisse sind fehlendes Know-how und technische Voraussetzung. Künstliche Intelligenz, Internet of Things und Smarte Fabrik – die Industrie 4.0 in aller Munde. Doch wie weit sind Industrieunternehmen hierzulande wirklich beim Thema Digitalisierung? 47 Prozent der Unternehmen haben bislang noch gar…

NEWS | CLOUD COMPUTING | INFRASTRUKTUR | RECHENZENTRUM | SERVICES | AUSGABE 1-2-2018

Monitoring-Dienste für hybride Cloud-Anwendungen – Den Überblick wahren

Die Nutzung der Cloud bietet viele Vorteile, die aber nur zum Tragen kommen, wenn auch die Überwachungs- und Verwaltungstools entsprechend angepasst werden. Diese kontrollieren jederzeit alle einzelnen Komponenten und können sogar zukünftige Risiken vorhersagen.

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | IT-SECURITY | SERVICES | TIPPS

Neue Chancen für Reseller und Systemhäuser mit Backup Monitoring

Mit Monitoring-Tools für Backup und Wiederherstellung bieten Reseller ihren Kunden nicht nur einen besonderen Service, sondern können damit zusätzliche Umsätze generieren. Zwar ist per Gesetz jeder Geschäftsführer verpflichtet, für eine ordnungsgemäße Datensicherung zu sorgen, doch bei vielen Unternehmen wird das Thema Backup und Wiederherstellung nach wie vor stiefmütterlich behandelt und der Schutz von Daten…

NEWS | TRENDS INFRASTRUKTUR | BUSINESS | BUSINESS PROCESS MANAGEMENT | TRENDS GESCHÄFTSPROZESSE | EFFIZIENZ | GESCHÄFTSPROZESSE | TRENDS 2017 | INFRASTRUKTUR | IT-SECURITY | SERVICES

Risikomonitoring: Deutsche Unternehmen erkennen Gefahren für Lieferkette nicht

71 Prozent hatten in den letzten zwölf Monaten mindestens eine Unterbrechung in der Lieferkette. 41 Prozent der Unterbrechungen gingen von Sub-Lieferanten-Strukturen aus. 80 Prozent haben keine oder unzureichende Maßnahmenpläne für wichtigste Gefahren. Deutsche Unternehmen sind auf plötzliche Unterbrechungen in ihrer Lieferkette nur unzureichend vorbereitet. Das ist das Ergebnis der Studie »Supply Chain Risk Management –…

NEWS | DIGITALISIERUNG | EFFIZIENZ | INFRASTRUKTUR | IT-SECURITY | RECHENZENTRUM | SERVICES | AUSGABE 9-10-2017

Intelligente Bereitstellung von IT-Services – Duales IT-Monitoring

Die Sicht auf die Verfügbarkeit der Infrastruktur reicht heute bei weitem nicht mehr aus. Verfügbarkeit und Sicherheit sollten gemeinsam betrachtet werden.

NEWS | BUSINESS PROCESS MANAGEMENT | IT-SECURITY | KOMMUNIKATION | SERVICES | TIPPS | AUSGABE 1-2-2017

IT Operations Analytics für mehr Client-Performance – Wenn Monitoring und Analytics, dann richtig!

Das Hochfahren dauert ewig, beim Tippen nerven Latenzzeiten und Druckaufträge verschwinden im Nirwana: Wenn End-User Probleme haben, liegt die Ursache dafür oft im Verborgenen. Doch was bringen übliche Monitoring-Tools überhaupt noch, wenn es um das Erkennen, Isolieren und schließlich Lösen von Schwierigkeiten am Arbeitsplatz eines End-Users geht?

NEWS | IT-SECURITY | PRODUKTMELDUNG

Ransomware: Monitoring- und Detection-Funktionen spüren Anomalien auf

Neue Enterprise-Funktionalität mit Reaktions- und Wiederherstellungsmechanismen erkennt verdächtige Abweichungen und schützt vor Attacken. Der Spezialist für Cloud-Datenschutz und Informationsmanagement Druva hat neue Monitoring- und Detection-Funktionen vorgestellt, die Organisationen proaktiv vor verdächtigen Datenaktivitäten durch potenziell gefährliche Bedrohungen warnen. Mit den neuen Erweiterungen bietet Druvas Datensicherungsplattform eine umfassende Lösung, um Gefahren für Geschäftsdaten durch Ransomware abzuwehren —…

NEWS | INFRASTRUKTUR | KOMMUNIKATION | LÖSUNGEN | ONLINE-ARTIKEL | PRODUKTMELDUNG | SERVICES

Informationszentrale Monitoring-Lösung

Fast jedes Unternehmen setzt heute eine oder mehrere IT-Monitoring-Lösungen ein, um die Verfügbarkeit und Leistungsfähigkeit seiner IT-Infrastruktur zu sichern. Bricht man die Funktionen einer solchen Software auf das Wesentliche herunter, bleiben letztlich drei Aspekte übrig: Daten sammeln, Daten analysieren und Daten publizieren. Wenn die Software einige technische Voraussetzungen erfüllt, lassen sich mit ihr jenseits von…

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | LÖSUNGEN | ONLINE-ARTIKEL | SERVICES

Standortübergreifendes Monitoring: Einfaches Lizenzmodell für komplexe Netzwerkstruktur

Mit der Größe des Betriebs wächst die IT-Infrastruktur. Das gilt erst recht für ein Unternehmen wie die HassiaGruppe mit mehreren Standorten: Die Tochterfirmen sind eigenständig geführte Betriebe, doch ihre IT wird zentral von der ita vero GmbH gemanagt. Als bei der HassiaGruppe die IT-Infrastruktur zu komplex für die verwendeten Netzwerk-Monitoring-Lösungen wurde, erhielt ita vero den…

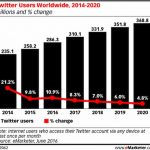

NEWS | TRENDS KOMMUNIKATION | TRENDS 2016 | KOMMUNIKATION | MARKETING

Twitter als Trend-Monitoring-Kanal: Bedeutung, Relevanz und Identifizierung von Meinungsführern

Auf Twitter wird täglich eine Vielzahl von Daten generiert. In unserer Kolumne gehen wir darauf ein, wie diese Daten – sinnvoll aufbereitet – für das Trend-Monitoring genutzt werden können. Nachdem wir im ersten Teil die generelle Relevanz und anschließend geeignete inhaltliche Analysen der Tweets erläutert haben, ist es in einem weiteren Schritt nötig, Trendtreiber zu…

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | LÖSUNGEN | ONLINE-ARTIKEL | SERVICES

Monitoring ist nicht gleich Monitoring

Reaktives Monitoring ist immer noch Stand der Dinge in der IT. Die Zukunft heißt aber proaktives oder Predictive Monitoring. Nur so lassen sich Störungen zuverlässig verhindern. Status quo im Monitoring-Bereich ist das reaktive Monitoring, das zum Beispiel auf der Analyse von Logfiles basiert. Selbst wenn eine Echtzeitanalyse erfolgt, kann auf veränderte Bedingungen nur nachträglich reagiert…

SICHERHEIT MADE IN GERMANY | AUSGABE 5-6-2016

DC-Monitoring steigert die Datacenter-Effizienz – Ich sehe was, was Du nicht siehst

Ein übergreifendes Monitoring verhilft dem Rechenzentrum zu einem effizienten Betrieb. Die Informationen können vorhersehbare Störungen, erhöhten Energieverbrauch und unnötige Kosten vermeiden.