Illustration Absmeier foto freepik

Wie Embedded-KI zur Reduzierung des Stromverbrauchs beiträgt und gleichzeitig die Effizienz fördert.

Der ungeheure Energiebedarf von künstlicher Intelligenz (KI) gerät zunehmend in den Blickpunkt der Diskussion. Kein Wunder, schon 2019 warnte eine US-Studie davor, dass allein das Training eines einzigen neuronalen Netzwerks so viel CO2-Emissionen verursacht wie fünf (konventionelle) Autos. Allein das Training des GPT-3 Modells (also der seit Ende 2022 öffentlich zugänglichen Version von ChatGPT) verbrauchte so viel Strom, wie ein mittleres Atomkraftwerk in etwa einer Stunde produzieren kann (nämlich 1.287 Megawattstunden).

Inzwischen verursacht der Energiebedarf der gesamten Informations- und Kommunikationstechnik etwa 2-4 Prozent der globalen Treibhausemissionen – so viel wie der weltweite Flugverkehr. Und der Bedarf wächst: So schätzen Wissenschaftler, dass der Energieverbrauch künstlicher Intelligenz bis zum Jahr 2027 auf bis zu 134 Terawattstunden anwachsen könnte. Darüber hinaus benötigt KI-Training auch Wasser in erheblicher Menge – das Training des GPT-Modells soll um die 700.000 Liter Kühlwasser verschlungen haben.

Beispielloser Bedarf an Rechenleistung

Das Training großer KI-Modelle benötigt Rechenleistung in beispielloser Menge – so will NVIDIA bis Ende 2024 mehr als 2 Millionen KI-Rechenbeschleuniger des jüngsten Typs H100 »Hopper« verkaufen. Laufen diese alle unter Volllast, benötigen sie mit 1,6 Gigawatt mehr Strom, als einer der größten Atomreaktoren liefern kann.

Neben dem Training erfordert natürlich auch der Betrieb von KI-Systemen Energie. So wird der durchschnittliche Energiebedarf einer Anfrage an ChatGPT auf 3 bis 9 Wattstunden geschätzt. Würden alle der 9 Milliarden täglichen Suchanfragen von KI beantwortet, wäre mit einer Verdreissigfachung des Energiebedarfs zu rechnen. Die Integration von ChatGPT in Microsofts Bing und von Gemini in Googles Suchmaschine weist darauf hin, dass die Zahl der KI-generierten Suchantworten in jedem Fall erheblich zunehmen wird.

»Auch in der Medizintechnik und Industrie, zum Beispiel in der Produktion, nimmt der Einsatz von KI zu. Zwar verspricht der Einsatz von KI in der Industrie, Prozesse effizienter zu gestalten und Produktionsausfälle zu verhindern. Doch die Steigerung der Maschineneffizienz führt auch hier zu einem deutlich höheren Energiebedarf,« geht Viacheslav Gromov, Geschäftsführer des KI-Anbieters AITAD ins Detail.

KI muss energieeffizienter werden

Vor diesem Hintergrund muss die Entwicklung und der Einsatz von KI energieeffizienter werden, nicht nur um Kosten zu sparen, sondern auch um der Energieknappheit und dem zur Energieerzeugung notwendigen Ressourcenverbrauch zu begegnen. Nicht zuletzt zwingen die globale Erwärmung oder auch geopolitische Ereignisse zu einem sparsamen Umgang.

Natürlich ist die Lösung nicht der Verzicht auf KI, sondern die Fokussierung auf mehr Energieeffizienz bei ihrem Einsatz. So können KI und smarte Sensoren nicht nur die Industrie transformieren, sondern auch die Produktion energieeffizienter gestalten. Der zentrale Fokus sollte aber schon bei der Entwicklung neuronaler Netzwerke liegen sowie auf der Fragestellung, an welcher Stelle die gewünschten Informationen aus den von Sensoren erfassten Daten extrahiert werden. Große Einsparmöglichkeiten bestehen auf dem für die industrielle Nutzung besonders wichtigen Feld der diskriminativen KI. Anders als generative KI (wie ChatGPT, Midjourney, Gemini, etc.), wird diese Art von KI nicht zur Erschaffung von Inhalten sondern zur Analyse und Auswertung von Daten genutzt. Diskriminative KI gibt also Antworten auf an Geräte und Maschinen gerichtete Fragen wie: »Was passiert gerade, und was wird in Zukunft geschehen?«.

Größer heißt nicht immer auch leistungsfähiger

Letzten Endes hängt der Energieverbrauch im Wesentlichen von der Größe des künstlichen neuronalen Netzwerks und folglich den dahinterstehenden, meist parallelisierten Rechenoperationen ab. Das betrifft sowohl die Trainingsphase als auch den Einsatz des Modells. Was liegt also, näher als die Modelle so klein und effizient in der Verarbeitung wie möglich zu halten? Dabei bedeutet klein nicht zwangsläufig geringere Leistungsfähigkeit. Seit wenigen Jahren ist es möglich, KI auch auf kleinsten Halbleitern – von der MCU bis zur FPGA – laufen zu lassen – als Embedded System. Wenn man einen Cortex-M-Mikrocontroller (ggf. mit NPU und DMA) mit gleichen MAC-Parallel-Operationen mit einem typischen Intel i-PC-Prozessor vergleicht, kann man durch natürliche Beschränkungen im Spezifischen um Faktor 20-60 effizienter werden.

»Derartige Embedded-KI arbeitet vollautark an der Netzwerkkante – mit dem großen Vorteil, dass sie alle vom Sensor erhaltenen Daten in Echtzeit auswerten kann und schon deshalb kaum Konnektivität erfordert. Für die Industrie wird Embedded-KI in vielen Anwendungsfeldern immer wichtiger und hilft gleichzeitig dabei, den Energieverbrauch massiv einzudämmen,« erklärt Gromov genauer.

Energiesparendes Training auf einem Standard PC? Mit Embedded-KI geht das

Das beginnt bereits beim Training von KI-Modellen für Embedded-KI-Systemkomponenten. Während große Modelle für das Training eine umfangreiche Server-Infrastruktur benötigen (teilweise müssen zehntausende GPU-Server – die mehr als 400.000 USD pro Server kosten – verbunden sein) ist die KI-Entwicklung für ein Embedded-System oft schon auf einem Standard PC möglich. Das liegt natürlich auch daran, dass Embedded-KI sehr spezifische Fragestellungen beantwortet, wie zum Beispiel Vorhersagen über den Gesundheitszustand eines Antriebs, einfache Sprachsteuerungen (mit Erkennung auch komplexerer Wortgefüge), Überwachung und Prüfung von Schweißnähten, oder Beurteilung des Gesundheitszustands von Zähnen an Hand der beim Putzen erfassten Ultraschallgeräusche – und unzählige weitere Use Cases, z.B. zur Entlastung des Service oder der Vorhersage von Ausfällen bei Industrierobotern.

Da Embedded-KI-Systeme stets stark ressourcenbeschränkt sind, ist auch der Energiebedarf sehr gering, je nach Use Case werden nur wenige Milliampere benötigt. Das bedeutet, dass diese Systeme mit Batterie betrieben werden können, in vielen Fällen wäre sogar Energy Harvesting möglich.

Embedded-KI spart Strom und ist vielseitig einsetzbar

Auch wenn Embedded-KI-Systeme keine Allzweckwaffe sind – ihr Einsatz ist prinzipiell überall dort möglich, wo Sensoren zum Einsatz kommen. Um Energie zu sparen und so mehr Effizienz bei gleichzeitig besserer Klimabilanz zu erreichen, sind sie ideal. Angenehme Nebeneffekte sind die viel tiefer mögliche Analyse der Sensordaten, die Echtzeitfähigkeit und Wahrung des Datenschutzes – es werden ja nicht die Sensordaten übertragen, sondern nur die Auswertungsergebnisse. Nicht zuletzt dürften Entwicklungs- und Stückkosten deutlich unter denen vernetzter KI-Systeme liegen.

»Mit Hilfe von Embedded-KI lässt sich der KI-Einsatz dezentralisieren, so dass auch in großen vernetzten Produktionsbetrieben unter deutlich geringerem Energieeinsatz gearbeitet werden kann, ohne auf die Vorteile von KI zu verzichten. Um zukunftsfähig und ressourcenschonend zu bleiben, sollte daher wo immer möglich und erforderlich auf Embedded-KI gesetzt werden,« so Gromov abschließend.

Quellennachweis:

-

https://www.spektrum.de/news/kuenstliche-intelligenz-verbraucht-fuer-den-lernprozess-unvorstellbar-viel-energie/1660246

-

https://www.enviam-gruppe.de/energiezukunft-ostdeutschland/verbrauch-und-effizienz/stromverbrauch-ki

-

https://www.nzz.ch/technologie/chat-gpt-vs-googeln-der-massive-stromverbrauch-der-ki-ist-ein-problem-ld.1774379

-

https://www.tuev-verband.de/pressemitteilungen/energiebedarf-kuenstlicher-intelligenz-waechst-rasant

-

https://www.heise.de/hintergrund/Analyse-Weshalb-sich-der-KI-Stromverbrauch-schlecht-einschaetzen-laesst-9307813.html

-

https://www.ingenieur.de/technik/fachbereiche/kuenstliche-intelligenz/ki-koennte-den-energieverbrauch-explodieren-lassen/

-

https://www.industrie-energieforschung.de/forschen/kuenstliche-intelligenz

-

https://www.elektronikpraxis.de/ki-ist-nicht-ki-warum-eine-unterscheidung-sinnvoll-ist-a-6cbf3436007c725566959f1f9996f5f8/

-

https://www.elektronikpraxis.de/embedded-ki-industrierevolution-2024-a-58204d1c9400018965d614df97e62036/

-

https://www.juniper.net/de/de/research-topics/what-is-ai-data-center-networking.html

-

https://factorynet.at/menschen/predictive-maintenance-bei-industrierobotern-mit-embedded-ki/

KI-Inferenz-Workloads brauchen keine GPU

Illustration Absmeier foto freepik genki

Es ist unbestritten, dass die Entwicklung von KI eine der größten Herausforderungen unserer Zeit ist. Laut Next Move Strategy Consulting wird der Markt für KI-Technologien im Jahr 2023 rund 200 Milliarden US-Dollar betragen und bis 2028 auf über 1,8 Billionen US-Dollar anwachsen.

Zumindest im letzten Jahr konzentrierte sich der größte Teil dieses Marktes auf das KI-Training, bei dem Hochleistungs-GPU-Produkte eingesetzt wurden, um Modelle zu entwickeln und für den Einsatz vorzubereiten. Jetzt, da diese Modelle trainiert und eingesetzt werden, ist der Markt bereit für die nächste Phase der KI, dem sogenannten »Inferencing«. Tatsächlich ist dieser Wandel bereits im Gange – eine aktuelle Schätzung von D2D Advisory besagt, dass KI-Inferencing heute 85 Prozent der KI-Landschaft ausmacht, während KI-Training nur 15 Prozent des aktuellen Marktes belegt.

Diese Zunahme des KI-Inferencing erfordert ein grundlegendes Umdenken in Bezug auf die Rechenleistung, die für diese Arbeitslasten verwendet werden sollte. Während GPUs für ihre KI-Trainingsfähigkeiten sehr geschätzt werden, ist die Verwendung dieser Prozessoren für KI-Inferencing nicht die beste Wahl. Der Wechsel zu CPUs und der Verzicht auf GPUs für Inferencing wird dazu beitragen, den Energieverbrauch der Rechenzentren in unseren Netzwerken zu senken, eine bessere Leistung zu erzielen und eine leichter zugängliche, kosteneffiziente und skalierbare Lösung anzubieten.

- Unsere Energienetze können die Nachfrage nach KI-Inferenz mit GPUs nicht decken

Nach Angaben der Internationalen Energieagentur werden Rechenzentren im Jahr 2022 etwa 2 Prozent des weltweiten Energieverbrauchs ausmachen. Dieser Anteil könnte sich bis 2026 auf 4,6 Prozent mehr als verdoppeln, wenn man bedenkt, dass die KI-Branche bis 2023 voraussichtlich mindestens zehnmal so viel Energie verbrauchen wird.

Während der Energiebedarf steigt, nimmt der Zugang zu Energie ab, insbesondere in Europa. Die Strompreise in der Region haben vor kurzem Rekordhöhen erreicht, und in England wurden bereits Moratorien für Rechenzentren verhängt, da die Nachfrage die im Netz verfügbare Energie überstieg.

In diesem schwierigen Umfeld wird der Einsatz zusätzlicher, energieintensiver GPUs für KI-Inferenzlasten die Nachhaltigkeitsproblematik weiter verschärfen. Durch den Einsatz von CPUs – insbesondere Cloud-nativen CPUs, die speziell für diese Art von Arbeitslasten entwickelt wurden – können wir mehr Leistung aus unseren bestehenden Rechenzentren und Stromverbrauchsflächen herausholen, anstatt neue Gebäude und zusätzliche Stromquellen zu benötigen.

- GPUs sind zu rechenintensiv für KI-Inferenzanwendungen

Grafikprozessoren verbrauchen nicht nur mehr Strom, sondern sind auch für viele Inferenzanwendungen der KI zu rechenintensiv. Da Inferenzanwendungen weniger anspruchsvolle Workloads darstellen und nicht die Rechenleistung eines Grafikprozessors benötigen, ist die Verwendung von Grafikprozessoren für diesen Zweck vergleichbar mit dem Kauf eines Sportwagens für die morgendliche Fahrt zur Arbeit – es ist mehr, als man braucht. Bei der Verwendung eines Grafikprozessors für Inferenzen wird in der Regel nur ein kleiner Teil der Kapazität des Grafikprozessors genutzt. Da GPUs mehr Strom verbrauchen und teurer sind, spart der Ersatz des Grafikprozessors durch eine CPU in diesen Fällen Strom, Platz und Kosten. In vielen Fällen führt dies auch zu einer besseren Leistung, Erschwinglichkeit und Energieeffizienz.

Zur Einordnung: Bei der Ausführung des Whisper-Modells von OpenAI bieten CPUs bis zu 2,9-mal mehr Leistung als eine Reihe von GPU-basierten Lösungen. Je nach vergleichbarer GPU-Lösung verbrauchen sie auch deutlich weniger Strom pro Schlussfolgerung.

- CPUs sind leicht zugänglich und kostengünstiger, um die Anforderungen der KI-Inferenz zu erfüllen

GPUs sind unglaublich knapp und schwer zu bekommen. Teilweise aufgrund dieser Knappheit sind sie auch sehr teuer. Nach Angaben des Wall Street Journal hat die KI-Branche im vergangenen Jahr 50 Milliarden Dollar für GPUs ausgegeben, die für das Training fortgeschrittener KI-Modelle verwendet werden, aber nur 3 Milliarden Dollar Umsatz erzielt. Da 85 Prozent der KI-Arbeitslasten auf KI-Inferenz entfallen, wird diese Diskrepanz zwischen Aufwand und Ertrag für die meisten Unternehmen schnell untragbar, wenn sie für diese Arbeitslasten GPUs einsetzen.

Im Gegensatz zu GPUs sind CPUs heutzutage leicht verfügbar. Sie können von OEMs für den Einsatz vor Ort erworben oder über eine öffentliche Cloud von einer Vielzahl von Cloud-Dienstleistern bezogen werden. Außerdem sind sie deutlich kostengünstiger. Ein Rack mit vier DGX H100 kann beispielsweise mehr als 41 kW pro Rack verbrauchen und kostet etwa 1,5 Millionen US-Dollar. Dies steht in krassem Gegensatz zu erschwinglicheren und nachhaltigeren CPU-Alternativen für KI-Inferenz. Beispielsweise kann ein einzelnes Rack mit 40 CPUs mit 128 Kernen ein Rack mit vier DGX H100 um 19 Prozent in Bezug auf den Inferenzdurchsatz übertreffen, bei einem Verbrauch von weniger als 15 kW pro Rack und Kosten von etwa 290.000 US-Dollar.

GPU-frei ist die klare Wahl für KI-Inferenz

Während GPUs eine gute Wahl für das KI-Training sind, muss die Industrie ihre Computing-Lösungen für die KI-Inferenzierung überdenken, um die für die Inferenzierung erforderliche Größe zu erreichen. CPUs bieten eine höhere Leistung für diese Arbeitslasten bei geringerem Stromverbrauch und niedrigeren Kosten und sind die klare Wahl für die nächste Phase der KI-Ära.

Jeff Wittich, Chief Product Officer, Ampere

KI-Inferenz: Der Schlüssel zur Anwendung von künstlicher Intelligenz

Künstliche Intelligenz (KI) hat die Art und Weise, wie wir arbeiten, lernen und unser tägliches Leben gestalten, revolutioniert. Ein zentraler Aspekt der KI, der diese Fortschritte ermöglicht, ist der Prozess der KI-Inferenz. Aber was genau ist KI-Inferenz und warum ist sie so wichtig?

KI-Inferenz bezieht sich auf den Prozess, bei dem ein trainiertes maschinelles Lernmodell verwendet wird, um Schlussfolgerungen aus neuen, unbekannten Daten zu ziehen [1]. Dies ist der Schritt, der auf das Training des Modells folgt, bei dem es anhand von Beispieldaten lernt, Muster und Zusammenhänge zu erkennen. Nachdem das Modell ausreichend trainiert wurde, kann es seine »Intelligenz« anwenden, um Vorhersagen zu treffen oder Entscheidungen zu treffen, wenn es mit neuen Daten konfrontiert wird.

Ein einfaches Beispiel für KI-Inferenz könnte ein E-Mail-Filter sein, der darauf trainiert wurde, Spam von regulären Nachrichten zu unterscheiden. Nach dem Training kann das Modell neue E-Mails analysieren und mit hoher Genauigkeit vorhersagen, ob es sich um Spam handelt oder nicht. Ein weiteres Beispiel ist ein autonomes Fahrzeug, das Stoppschilder erkennen kann, selbst wenn es auf eine Straße trifft, die es zuvor noch nie befahren hat [2].

Die Fähigkeit zur KI-Inferenz ist entscheidend für praktisch alle realen Anwendungen von KI. Von der Spracherkennung über die prädiktive Analyse bis hin zur Cybersicherheit ermöglicht die KI-Inferenz Maschinen, intelligent auf neue Situationen zu reagieren und menschenähnliche Entscheidungen zu treffen. Dies eröffnet unzählige Möglichkeiten für Innovationen in verschiedenen Branchen.

Die Qualität der KI-Inferenz hängt stark von der Qualität des Trainings ab. Je besser ein Modell trainiert ist, desto genauer und zuverlässiger sind seine Inferenzen. Allerdings ist es wichtig zu beachten, dass kein KI-Modell perfekt ist und Fehler immer möglich sind. Daher ist es entscheidend, KI-Systeme kontinuierlich zu überwachen und zu verbessern, um ihre Leistung und Zuverlässigkeit zu optimieren.

Zusammenfassend ist die KI-Inferenz ein faszinierender und komplexer Prozess, der die Grundlage für die Anwendung von KI in der realen Welt bildet. Sie ermöglicht es Maschinen, aus Erfahrungen zu lernen und intelligente Entscheidungen zu treffen, die unser Leben verbessern und vereinfachen können. Mit fortschreitender Entwicklung der KI-Technologie wird die KI-Inferenz zweifellos weiterhin eine Schlüsselrolle in der Gestaltung unserer Zukunft spielen.

Genki Absmeier

[1]: https://www.cloudflare.com/de-de/learning/ai/inference-vs-training/ »«

[2]: https://www.allaboutai.com/de-de/ki-glossar/inferenz-ki/ »«

[3]: https://bing.com/search?q=Was+ist+eine+KI-Inferenz %3f »«

[4]: https://ki-echo.de/glossar/inferenz/ »«

[5]: https://www.datacenter-insider.de/was-ist-inferenz-a-670450/ »«

1795 Artikel zu „KI Energie“

NEWS | DIGITALISIERUNG | EFFIZIENZ | FAVORITEN DER REDAKTION | LÖSUNGEN | NACHHALTIGKEIT | VERANSTALTUNGEN

Ressourcen, Kreislauf, Energie: Das KIT auf der Hannover Messe 2024

In der AgiProbot-Fabrik arbeiten Forschende am Realisieren der automatisierten Demontage. (Foto: Amadeus Bramsiepe, KIT) Wie können sich Fabriken autonom an laufend neue Bedingungen anpassen? Wie lässt sich Beton ressourcen- und klimaschonend herstellen? Wie schaffen wir Speicherkapazitäten für den Ausbau erneuerbarer Energien? Das Karlsruher Institut für Technologie (KIT) entwickelt Lösungen für vielfältige Herausforderungen. Unter dem…

NEWS | INFRASTRUKTUR | NACHHALTIGKEIT | RECHENZENTRUM | AUSGABE 11-12-2023

Moderne Rechenzentren – Klimakiller oder Stütze der Energiewende?

Datacenter sind die technologische Basis für den unverzichtbaren Fortschritt der Digitalisierung. Auf der anderen Seite haben sie bei vielen Menschen den Ruf als Stromfresser und Betonklötze, die für einen massiven CO2-Ausstoß verantwortlich sind. Die noris network AG hat sich zum Ziel gesetzt, das zu ändern. Sie zeigt, dass es auch anders geht und hat Rechenzentren gebaut, die diesen Ruf zu Unrecht haben. Doch damit nicht genug. Der Plan ist, die Datacenter als integralen Bestandteil der Stromversorgung zu positionieren, und damit sogar die Energiewende voranzutreiben.

NEWS | BUSINESS | EFFIZIENZ | FAVORITEN DER REDAKTION | GESCHÄFTSPROZESSE | KÜNSTLICHE INTELLIGENZ

Energiemanagement und CO2-Tracking: Mehr Nachhaltigkeit und bessere Krisenbewältigung durch ERP-Integration

Wie mittelständische Unternehmen Energiemanagement und CO2-Tracking effizient umsetzen können. Die Weltwirtschaft befindet sich derzeit an der Schwelle eines neuen Zeitalters: Die Corona-Pandemie, Klimawandel sowie der Ukraine-Krieg wirken sich auf Lieferketten, Energieversorgung und Digitalisierungsinitiativen aus. Auch der deutsche Mittelstand bleibt von diesen Veränderungen nicht verschont und bekommt bereits erste Konsequenzen zu spüren. Mittelständler sollten sich…

NEWS | EFFIZIENZ | FAVORITEN DER REDAKTION | KÜNSTLICHE INTELLIGENZ | WHITEPAPER

Studie bestätigt: Künstliche Intelligenz (KI) ist ein wesentlicher Treiber der Energiewende

KI birgt ein enormes Potenzial als Treiber und Unterstützer der globalen Energiewende. KI kann in zahlreichen Anwendungen als intelligente Schicht dienen, damit Muster erkannt, die Systemleistung verbessert sowie die Ergebnisse komplexer Situationen vorhergesehen werden können. Energie- und Technologieexperten zufolge gibt es jedoch einige bedeutende Hindernisse, die einer raschen globalen Akzeptanz von KI im Wege stehen.…

NEWS | BUSINESS INTELLIGENCE | EFFIZIENZ | KÜNSTLICHE INTELLIGENZ | STRATEGIEN

Der Bot: KI ist die Zukunft des Energiehandels

Künstliche Intelligenz ist eine der meistdiskutierten Trends in der Energiebranche. Sie wurde bereits für unterschiedliche Anwendungen implementiert: Von der Optimierung der Netzleistung über die Steigerung der Energieeffizienz von Gebäuden bis hin zur präventiven Wartung, um Ausfälle zu vermeiden, noch bevor sie auftreten. Aber ist KI im Energiehandel wirklich notwendig? Bislang waren Energiehändler mit aus…

NEWS | INFRASTRUKTUR | RECHENZENTRUM

Neue Speichertechnologien im Rechenzentrum – für höhere Energieeffizienz bei neuen KI-Anwendungsfällen

Die Speicherinfrastruktur im Rechenzentrum wurde jahrelang mit herkömmlicher Hardware umgestaltet. Neue, datenintensive Anwendungen für künstliche Intelligenz (KI) und maschinelles Lernen (ML) sorgen nun aber für einen stark steigenden Energiebedarf. Hier sind neue Ideen gefragt. Eine Option für deutlich effizientere, auch für High-End-Workloads geeignete Lösungen – ist All-Flash-basierter Objektspeicher. Dazu erklärt Markus Grau, Principal Systems Engineer…

RECHENZENTRUM | TOP-THEMA | AUSGABE 5-6-2016

Notstromversorgung im Rechenzentrum – Eine USV-Lösung mit kinetischer Energie

Rotierende Schwungmassen als Notstromversorgung im Rechenzentrum machen ab einer gewissen Größe Sinn. Im Vergleich zu Batterien ergibt sich eine höhere Energieeffizienz bei geringerem Platzbedarf.

NEWS | CLOUD COMPUTING | KÜNSTLICHE INTELLIGENZ | PRODUKTMELDUNG

Red Hat OpenShift AI erweitert die Flexibilität von prädiktiver und generativer KI in der Hybrid Cloud

Vom lokalen Rechenzentrum über verschiedene Public Clouds bis hin zur Edge bietet Red Hat OpenShift AI neue Funktionen und Anpassungen, mit denen Unternehmen den Boom intelligenter Workloads bewältigen können. Red Hat, der weltweit führende Anbieter von Open-Source-Lösungen, hat heute Erweiterungen von Red Hat OpenShift AI angekündigt, einer offenen hybriden Plattform für Künstliche Intelligenz (KI)…

TRENDS 2024 | NEWS | TRENDS WIRTSCHAFT | EFFIZIENZ | INDUSTRIE 4.0 | KÜNSTLICHE INTELLIGENZ

Industrie sieht in KI die Zukunft

78 Prozent der Industrieunternehmen sind überzeugt, dass KI künftig wettbewerbsentscheidend sein wird, gleichzeitig wartet die Hälfte beim KI-Einsatz erst einmal ab. Größtes Potenzial wird beim Energiemanagement und in der Analytik gesehen. Geht es nach der deutschen Industrie, wird künstliche Intelligenz (KI) die Branche nicht nur prägen, sondern maßgeblich über ihre Zukunft entscheiden. 78 Prozent…

NEWS | KOMMENTAR | KÜNSTLICHE INTELLIGENZ | SERVICES

»Wir sollten KI-Potenziale nutzen und gleichzeitig kritisch bleiben.«

Lori Niles-Hofmann ist seit 25 Jahren Lernstrategin im Bereich Learning & Development (L&D). Ihr Spezialgebiet sind digitale Lerntransformationen. Die Kanadierin tritt auf der diesjährigen LEARNTEC als Keynote-Speakerin auf. Im Gespräch verrät sie vorab, welche Unterschiede es im Umgang mit künstlicher Intelligenz zwischen Europa und Kanada gibt, warum Jobtitel nicht mehr so wichtig sind und wie…

NEWS | EFFIZIENZ | FAVORITEN DER REDAKTION | KÜNSTLICHE INTELLIGENZ | NACHHALTIGKEIT | RECHENZENTRUM

KI-Inferenz-Workloads brauchen keine GPU

Es ist unbestritten, dass die Entwicklung von KI eine der größten Herausforderungen unserer Zeit ist. Laut Next Move Strategy Consulting wird der Markt für KI-Technologien im Jahr 2023 rund 200 Milliarden US-Dollar betragen und bis 2028 auf über 1,8 Billionen US-Dollar anwachsen. Zumindest im letzten Jahr konzentrierte sich der größte Teil dieses Marktes auf das…

NEWS | DIGITALE TRANSFORMATION | EFFIZIENZ | SERVICES

Eine solide Datengrundlage gewährleistet die Transformation des Energiesektors

Bereits heute verfügen Energieunternehmen über Massen an verschiedensten Daten. Doch um effizienter und nachhaltiger zu werden, müssen diese aus Silos befreit und einheitlich aufbereitet werden. Durch die Energiewende werden viel mehr kurzfristige, steuernde Eingriffe notwendig, die nur auf Basis einer optimalen Dateninfrastruktur realisiert werden können. Otto Neuer, Regional VP und General Manager bei Denodo, zeigt,…

NEWS | TRENDS 2023 | TRENDS INFRASTRUKTUR | EFFIZIENZ | FAVORITEN DER REDAKTION | INFRASTRUKTUR | NACHHALTIGKEIT

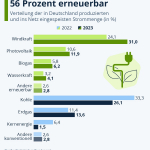

Strommix Deutschland: Welche Energieträger sind in Deutschland am wichtigsten?

https://de.statista.com/infografik/21058/verteilung-der-in-deutschland-produzierten-und-ins-netz-eingespeisten-strommenge/ Erneuerbare Energien sind laut Statistischem Bundesamt für 56 Prozent des 2023 in Deutschlands erzeugten Stroms verantwortlich – gegenüber dem Vorjahr entspricht das einem Plus von fast zehn Prozentpunkten. Wichtigster regenerativer Energieträger ist die Windenergie mit einem Anteil von 31 Prozent. »Die Gründe für den deutlichen Anstieg des Anteils waren ein gutes Windjahr 2023 sowie…

NEWS | KÜNSTLICHE INTELLIGENZ

KI in der Medizin: Mit Ursache und Wirkung rechnen

Maschinen können mit neuen Verfahren lernen, nicht nur Vorhersagen zu treffen, sondern auch mit kausalen Zusammenhängen umzugehen – Das könnte helfen, Therapien effizienter, sicherer und individueller zu machen, prognostiziert eine internationale Forschungsgruppe – Das Team um LMU-Forscher Stefan Feuerriegel will mit seinen Arbeiten „die Methoden einen Schritt näher an die Praxis bringen“ Künstliche Intelligenz…

NEWS | DIGITALISIERUNG | E-COMMERCE | KÜNSTLICHE INTELLIGENZ | PRODUKTMELDUNG

Nachfrage nach KI-gestütztem Handel auf neuem Hoch

Neue Studie zeigt: 62 % der deutschen Konsumenten finden, KI verbessert ihr Einkaufserlebnis – ein Anstieg von 13 % im Vergleich zu 2023 [1]. SAP Emarsys kündigt seinen AI Product Finder an, ein neues Tool, das die Art und Weise, wie Marken Produkte empfehlen und ihre Customer Experience personalisieren, verändert. Der neue Product Finder…

TRENDS 2024 | NEWS | CLOUD COMPUTING | TRENDS CLOUD COMPUTING | TRENDS SERVICES | INFRASTRUKTUR | RECHENZENTRUM | SERVICES

Hyperscaler-Markt: Sovereign Cloud und KI führen Provider zu neuem Wachstum

KI-Boom lässt Bedarf an DSGVO-konformen Hyperscaler-Leistungen stark steigen. Zwei neue ISG-Studien zeigen, welche IT-Dienstleister in Deutschland und Europa profitieren werden. Nach dem Auslaufen der Sonderkonjunktur durch Corona ist Künstliche Intelligenz der Toptreiber für weiteres Wachstum im Hyperscaler-Markt. In Europa und insbesondere auch in Deutschland geht diese Rechnung aber nur auf, wenn Unternehmen ihre KI-Modelle…

NEWS | EFFIZIENZ | NACHHALTIGKEIT | STRATEGIEN

Günstige und stabile Strompreise durch Erneuerbare-Energien-Pool

DIW-Studie zeigt Weg zu stabilen und günstigen Strompreisen für private Haushalte und Unternehmen auf – Erneuerbare-Energien-Pool reduziert Volatilität und stärkt Anreize zur flexiblen Stromnachfrage – Auch Finanzierung neuer Windkraft- und Solarprojekte wird erleichtert Auch wenn erneuerbare Energien immer günstiger werden und ihr Anteil am Strommix im Zuge der Energiewende stetig wächst, schwanken Strompreise weiterhin…

NEWS | BUSINESS | DIGITALISIERUNG | KÜNSTLICHE INTELLIGENZ | SERVICES

Und plötzlich ist jeder KI-Experte und KI-Berater

Dr. Harald Schönfeld: »Viele Consultants nutzen die aktuelle Debatte um künstliche Intelligenz, um sich eine goldene KI-Nase zu verdienen. Doch die Unternehmen brauchen keine Powerpoint-Pinsler, sondern praxiserfahrene Umsetzer, die während der Einführung von KI-Systemen die Verantwortung dafür in den Betrieben übernehmen.« »Die KI-Beratung läuft derzeit in eine völlig falsche Richtung«, warnt Dr. Harald Schönfeld,…

NEWS | KÜNSTLICHE INTELLIGENZ

Nachfrage von Unternehmen nach KI – Databricks meldet ein jährliches Wachstum von über 70 Prozent in EMEA

Der Pionier der Data Intelligence Platform begrüßt neue Kunden und investiert in EMEA, um die Einführung generativer KI in der Region zu beschleunigen Databricks, das Daten- und KI-Unternehmen, gibt bekannt, dass sein EMEA-Geschäft im vergangenen Geschäftsjahr im Vergleich zum Vorjahr um mehr als 70 Prozent gewachsen ist, angetrieben durch einen Nachfrageschub nach Daten- und KI-Funktionen…

TRENDS 2024 | NEWS | BUSINESS | TRENDS WIRTSCHAFT | KÜNSTLICHE INTELLIGENZ

Vor- und Nachteile von KI: Was denken Arbeitnehmer?

https://de.statista.com/infografik/32054/umfrage-zu-den-vorteilen-und-nachteilen-von-ki-am-arbeitsplatz/ Künstliche Intelligenz (KI) am Arbeitsplatz ist in der deutschen Arbeitswelt aktuell ein viel diskutiertes Thema. Eine aktuelle Umfrage unter Arbeitnehmerinnen und Arbeitnehmer, durchgeführt von Bitkom Research, liefert dazu detaillierte Erkenntnisse. Im Fokus steht die Frage, inwieweit KI die Arbeitslandschaft verbessern oder verschlechtern könnte. Die Statista-Grafik zeigt die am häufigsten genannten Vor- und Nachteile. Etwa…