Durch einen ganzheitlichen Ansatz korrelieren und bewerten Observability-Lösungen den Zustand der gesamten IT-gestützten Infrastruktur in Echtzeit, unabhängig davon, ob es sich um das Netzwerk, die Performance der Anwendungen oder die Nutzererfahrung handelt.

Der Begriff »Monitoring« beschreibt in der Medizin die Überwachung von Funktionen oder Funktionsstörungen von Patienten. Durch das medizinische Monitoring werden die Vitalfunktionen des Patienten beobachtet und die Erkenntnisse zur Behandlung von Verletzungen oder Krankheiten genutzt. Diese medizinische Definition kann durchaus auch in die IT übertragen werden. Die IT-Infrastruktur eines Unternehmens stellt dann den Körper eines Patienten dar. Bei Ausfällen können die Funktionen der IT-Infrastruktur beeinträchtigt oder ganz unterbrochen werden. Um diese gestörten Funktionen schnellstmöglich wiederherzustellen, kommt dem IT-Monitoring eine wichtige ökonomische Bedeutung zu. Vor allem in der heutigen Pandemie-Zeit beschleunigt sich in vielen Unternehmen die digitale Transformation, da Investitionen rund um die Infrastrukturen getätigt werden. Unweigerlich führt dies zu einem massiven Anstieg der Datenmengen, die zu überwachen sind. Mit IT-Monitoring lassen sich alle Hardware- und Software-Komponenten der Infrastruktur im Blick behalten. Dabei spielt es keine Rolle, ob es sich um Netzwerk-Equipment, Client-Systeme, Server oder selbstprogrammierte Applikationen handelt.

Von hoher Priorität sollte es deshalb sein, alle Komponenten der IT-Infrastruktur in möglichst wenige verschiedene Monitoring-Lösungen zu integrieren. Nur durch die übergreifende Überwachung aller Infrastrukturbestandteile ist es möglich, eine lückenlose Überwachung und einen störungsarmen Betrieb zu gewährleisten. Professionelles Monitoring ist für Systemadministratoren oder Systemverantwortliche Voraussetzung für den stabilen Betrieb der eigenen IT-Infrastruktur. Dabei sollten die implementierten Monitoring-Lösungen die überwachten Systeme nicht unnötig zusätzlich belasten.

Eine der wichtigsten und bekanntesten Monitoring-Arten ist das Netzwerk-Monitoring, das Bestandteil der meisten Netzwerk-Management-Systeme ist. Netzwerk-Monitoring-Systeme umfassen Software- und Hardware-Tools, die die eingesetzten Netzwerkkomponenten überwachen und unterschiedliche Parameter wie Bandbreite, Auslastung, Verfügbarkeit und Status erfassen. Netzwerkadministratoren verlassen sich in der Regel auf Netzwerküberwachungssysteme zur schnellen Erkennung von Geräte- oder Verbindungsfehlern beziehungsweise Verbindungsproblemen. Diese Überwachungssysteme liefern detaillierte Einblicke in das Netzwerk und informieren Administratoren per E-Mail oder Textnachricht über Probleme.

Historisches Monitoring. Beim historischen Monitoring werden die Erkenntnisse und Daten aus dem laufenden IT-Betrieb gesammelt und Langzeitstatistiken proaktiv erzeugt, um neben dem eigentlichen Monitoring auch zu überprüfen, ob die aktuellen Kapazitäten der IT-Infrastruktur für einen geregelten und störungsfreien Betrieb geeignet sind. Performance-Engpässe lassen sich somit schnell erkennen und beheben. Historisches Monitoring ermöglicht zum Beispiel die Optimierung der Budget-Planung für eine mögliche Neukonzeption des IT-Equipments, wodurch unnötige Kapazitätsüberschüsse verhindert werden können.

Echtzeit-Monitoring. Monitoring-Lösungen, die in Echtzeit operieren, unterstützen den Administrator dabei, akute Probleme in den Systemen zu erkennen. Der Administrator kann in Echtzeit analysieren, welche Probleme vorliegen und entsprechend reagieren, Folgeaktionen planen und Lösungsansätze implementieren, um die Funktionalität wiederherzustellen. Idealerweise werden Ausfälle von der Monitoring-Lösung selbstständig erkannt, registriert und behoben– ohne dass der Administrator aktiv werden muss oder Nutzer Einschränkungen bemerken.

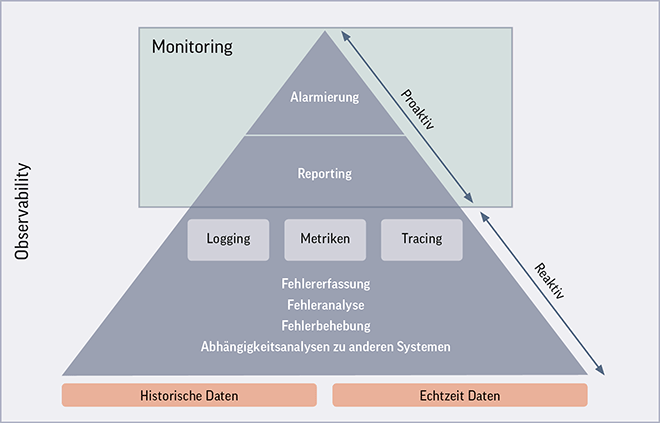

Observability – Nachhaltige Nutzung von Infrastrukturdaten. Monitoring und Observability werden häufig miteinander verwechselt und in ähnlichen Zusammenhängen verwendet. Observability bedeutet, dass neben den Daten und Informationen des klassischen Monitorings – wie beispielsweise dem Network Performance Monitoring – auch Metriken, Protokolle und Traces überwacht und auswertet werden. Die Funktionalitäten von Observability-Lösungen beinhalten die Erfassung, Sammlung und Korrelation von Daten aus der Infrastruktur. Zusätzlich werden die Ergebnisse ausgewertet und visualisiert. Observability ermöglicht die Beurteilung des Status der gesamten Infrastruktur, ohne diese zu stören oder zu verändern. Durch die Datennutzung lässt sich die Performance der verschiedenen Systeme »auf Knopfdruck« erkennen.

Generell baut das Observability-Konzept auf bestehende Monitoring-Disziplinen auf, ergänzt diese und ist dementsprechend eine Weiterentwicklung von Monitoring. Im Gegensatz zum klassischen Monitoring zielt Observability darauf ab, alle gesammelten Daten für einen ganzheitlichen Überblick zu nutzen. Observability-Lösungen korrelieren und bewerten aufgrund des ganzheitlichen Ansatzes den Zustand der gesamten IT-gestützten Infrastruktur, unabhängig davon, ob es sich um Netzwerk, Application Performance oder die Nutzererfahrung handelt. Aufgrund der steigenden Komplexität der IT-Infrastrukturen und IT-Services reicht es in der Regel nicht mehr aus, nur einzelne Bereiche zu überwachen (Abbildung 1).

Abbildung 1: Das Observability-Konzept baut auf bestehende Monitoring-Disziplinen auf, ergänzt diese und stellt eine Weiterentwicklung von Monitoring dar.

Digital Experience Monitoring. »Digital Experience Monitoring« (DEM) beziehungsweise »Monitoring der digitalen Nutzererfahrung« ist eine relativ neue Art von Monitoring. Bereits vor der Covid-19-Pandemie war Home Office für viele Unternehmen eine Möglichkeit, Mitarbeiter flexibel arbeiten zu lassen. Aktuell hat sich das »Büro Zuhause« für nahezu alle Unternehmen zu einem bedeutenden Thema entwickelt, da sich laut diversen Studien und Umfragen die Home-Office-Nutzung in Zukunft noch verstärken wird. Die vergangenen Lockdowns und die damit verbundene Arbeit im Home Office haben in relativ kurzer Zeit dazu geführt, dass Systemadministratoren einen neuen Teil der Infrastruktur genauer im Blick haben müssen – das World Wide Web.

Das Marktforschungsunternehmen Gartner definiert DEM in einer eigenen Kategorie für Analysewerkzeuge, die sich mit der Nutzererfahrung befasst. Speziell im IT-Umfeld hat die digitale Nutzererfahrung nicht nur in der jetzigen Pandemie-Phase einen hohen Stellenwert. Die digitale Nutzererfahrung hat mittlerweile Abhängigkeiten zu einer Vielzahl externer Services, wie Cloud, diverse Web-Conferencing Services oder andere SaaS-Anwendungen. Dies hat zu komplexen hybriden Implementierungen geführt, die sich der direkten Kontrolle des Systemadministrators entziehen und sich nur schwer an die speziellen Anforderungen von Unternehmen anpassen lassen.

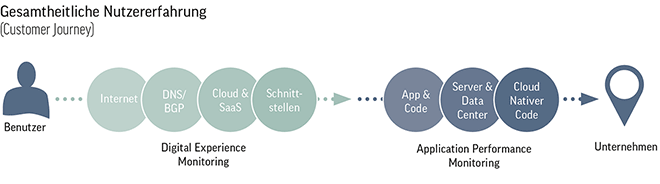

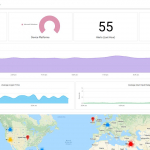

DEM-Lösungen grenzen sich zu traditionellen Monitoring-Tools wie dem Netzwerk-Performance Monitoring deutlich ab. Anders als diese Lösungen untersucht DEM den gesamten digitalen Interaktionspfad und zeigt auf, welchen Einfluss jeder Abschnitt des Pfades auf erfolgreiche Benutzeraktionen hat. Digital Experience Monitoring versucht zusätzlich, das Verhalten der Nutzer in Form einer gesamten Customer Journey darzustellen, um auf einen Blick erkennen zu können, ob Einschränkungen im Interaktionsfluss eines Benutzers vorliegen (Abbildung 2).

Abbildung 2: Die ganzheitliche Nutzererfahrung ergibt sich aus DEM und APM. Digital Experience Monitoring stellt das Verhalten der Nutzer in Form einer gesamten Customer Journey dar, um erkennen zu können, ob Einschränkungen im Interaktionsfluss vorliegen. Application Performance Monitoring überwacht innerhalb der IT-Infrastruktur die implementierten Applikationen anhand festgelegter Performance-Parameter.

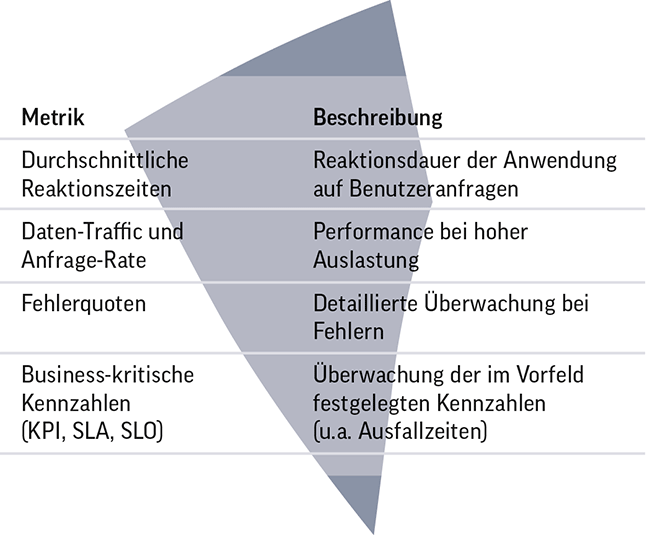

Application Performance Monitoring. Mit Application Performance Monitoring (APM) ist es möglich, innerhalb der IT-Infrastruktur die implementierten Applikationen anhand festgelegter Performance-Parameter zu überwachen. Zusätzlich lassen sich potenzielle Störungen identifizieren, wodurch der Observability-Ansatz unterstützt wird. APM-Lösungen liefern den Systemverantwortlichen aussagekräftige Informationen, um anhand der Anwendungsleistung mögliche Performance-Engpässe erkennen und beheben zu können, bevor sich diese auf den Nutzer auswirken. Verschiedene Softwarelösungen verfolgen unterschiedliche Ansätze für Application Performance Monitoring. Generell nutzen aber alle marktrelevanten APM-Tools die in Tabelle 1 erwähnten Metriken.

Tabelle 1: Alle marktrelevanten APM-Tools nutzen die dargestellten Metriken

APM-Lösungen sind in erster Linie darauf ausgelegt, die Anwendungsleistung direkt zu messen und Administratoren die Abhängigkeiten in der Infrastruktur aufzuzeigen.

Fazit und Handlungsempfehlungen. Das klassische Monitoring entwickelt sich in den letzten Jahren immer mehr von der Einzelbetrachtung eines Systems zu einer vollumfänglichen Übersicht der kompletten Infrastruktur. Speziell die IT wird für Unternehmen zu einem immer wichtigeren Teil innerhalb der Wertschöpfungskette und setzt damit hohe Verfügbarkeit und Stabilität voraus. Daher kommt dem Monitoring mittlerweile eine bedeutende Rolle zu. Nur durch zeitgemäßes Monitoring ist es möglich, IT-Infrastrukturen optimal zu überwachen und somit dem Worst Case, also dem Ausfall wichtiger IT-Systeme und Services, vorzubeugen.

Moderne Monitoring-Systeme unterstützen Systemverantwortliche dabei, Störungen frühzeitig zu erkennen, zu verhindern oder Teile der IT prophylaktisch anzupassen – unter Einbeziehung definierter Schwellenwerte. Ratsam ist es, die Erkenntnisse von Monitoring in einen nachhaltigen Entwicklungs- und Lernprozess zu überführen. Nur so können nachhaltig IT-Infrastrukturen und die implementierten Services kosten- und leistungsoptimiert funktionieren!

Der Observability-Ansatz bietet zusätzlich weitere Vorteile:

- Gesamtheitlicher Echtzeitüberblick über alle Systeme der Infrastruktur

- Mögliche Tool-Reduzierung und Abbau von Datensilos

- Verbesserte Stabilität der Gesamtinfrastruktur

- Ende-zu-Ende-Ansicht über verschiedene Systeme und Services in der Infrastruktur

Controlware unterstützt Unternehmen mit zeitgemäßen Monitoring- und Observability-Lösungen – von der Beratung über die Konzeption bis hin zur Realisierung. Unsere Experten erarbeiten gemeinsam mit dem Kunden individuelle Konzepte, die eine optimalen Nutzung von Daten ermöglichen und somit aktiv zum Geschäftserfolg beitragen.

Christopher Gasteier,

Christopher Gasteier,

Business Development Manager IT-Management

Controlware GmbH

www.controlware.de

Illustration: © Maisei Raman/shutterstock.com

69 Artikel zu „Observability „

NEWS | INFRASTRUKTUR | LÖSUNGEN | AUSGABE 5-6-2021

Cloud, Observability, Ende-zu-Ende-Sichtbarkeit und Teambuilding – In vier Schritten zum Vorreiter der Softwareentwicklung

Eine positive Customer Experience hängt zu einem großen Teil davon ab, dass Software und Systeme Höchstleistungen bringen. Daher sind für viele Unternehmen die Entwicklung und Bereitstellung optimierter Software die oberste Priorität. Trotzdem erleben Nutzer noch immer Ausfälle, die sich bei den Unternehmen meist unmittelbar als Umsatzverluste niederschlagen. Es ist also noch ein langer Weg zum optimalen Kundenerlebnis.

NEWS | DIGITALISIERUNG | FAVORITEN DER REDAKTION | INFRASTRUKTUR

End-to-End-Observability: 2021 bringt das Ende des klassischen Monitorings

Die Herausforderungen haben sich 2020 für viele Unternehmen drastisch verändert – und damit auch die Anforderungen an ihre IT. Wie geht die Reise 2021 weiter und welche IT-Trends stehen im neuen Jahr im Fokus? Klaus Kurz, Director Solutions Consulting bei New Relic, gibt einen Ausblick auf die wichtigsten Veränderungen und Trends – mit dem klaren…

NEWS | PRODUKTMELDUNG | RECHENZENTRUM

STRATO ist ab sofort klimaneutral

Bereits seit mehr als zehn Jahren ist STRATO Vorreiter beim Klimaschutz und betreibt seine Rechenzentren energieeffizient und mit grünem Strom. Den verbleibenden CO2-Fußabdruck gleicht der Webhoster nun vollständig durch Kompensationsprojekte aus und ist damit ab sofort klimaneutral. Nachhaltigkeit ist ein wichtiges Ziel von STRATO, für das sich das Unternehmen schon lange erfolgreich engagiert. Jetzt…

TRENDS 2021 | NEWS | BUSINESS PROCESS MANAGEMENT | TRENDS SERVICES | SERVICES

Sicherheitsbedenken in der Software-Lieferkette

64 Prozent der Führungskräfte wissen nicht, an wen sie sich im Falle eines Angriffs auf ihre Lieferkette wenden könnten. Eine neue globale Umfrage unter Führungskräften wurde von CloudBees, Spezialist für die Bereitstellung von Unternehmenssoftware, veröffentlicht. Sie zeigt ein hohes Vertrauen in die Sicherheit der Software-Lieferkette, aber ein begrenztes Verständnis für die wesentlichen Komponenten, die eine…

NEWS | CLOUD COMPUTING | PRODUKTMELDUNG | RECHENZENTRUM

Effizientes Monitoring jetzt als Cloud-Lösung

Mit der Software SmartZone von Panduit bekommen System-, Netzwerk- sowie Facility-Manager eine ganzheitliche Sicht auf die Infrastrukturkomponenten ihres Rechenzentrums. Die vor Ort installierte Lösung gibt es jetzt auch als Azure-Cloud-Webanwendung. Damit können Nutzer noch einfacher und flexibler Daten zu Stromverbrauch, Schrankzugriff und Umgebung der Rechenzentrums-Infrastruktur abrufen sowie überwachen. In der aktuellen Software ist zudem ein…

TRENDS 2021 | NEWS | TRENDS KOMMUNIKATION | TRENDS SERVICES

IT-Störungen am digitalen Arbeitsplatz hemmen Innovationsfähigkeit

Innovationssprung in Planung: 76 Prozent der befragten IT-Experten wollen künftig Predictive-Analytics-Technologien für präventives IT-Störungsmanagement nutzen. Nexthink, Anbieter von Digital Employee Experience (DEX) Management-Software, präsentiert die Ergebnisse seiner Studie »Digitale Arbeitsplätze: Von technischer Performance zum IT-Erlebnis«. Sie zeigt: Der bislang eher hemdsärmelige Umgang mit IT-Störungen wird zum Problem für die Innovationsfähigkeit und Produktivität in Unternehmen.…

NEWS | IT-SECURITY | STRATEGIEN | TIPPS

Application Security auf neuen Wegen

Immer schnellere Zyklen bei der Softwareentwicklung und aggressiv gesetzte Release-Termine führen nach verbreiteter Ansicht zu Mängeln bei der Sicherheit und Zuverlässigkeit: Es wird aus unterschiedlichen Gründen nicht immer gründlich genug getestet, heißt es. Tatsächlich muss diese Konsequenz nicht zwangsläufig eintreten. Es gilt vielmehr, ein in moderne, agile Entwicklungsverfahren integriertes Testmodell zu etablieren. Automatisierung und risiko-orientierte Priorisierung bei der…

NEWS | BUSINESS | DIGITALE TRANSFORMATION | OUTSOURCING

Digitaler Wandel in der HR: Cloud Computing statt On-Premises-Dinosaurier

Immer mehr Personalabteilungen wollen im Zuge ihrer digitalen Transformation operative Prozesse auslagern und ihr On-Prem-System ersetzen. Outsourcing spielt daher bei Digitalisierungs- und Cloud-Strategien eine wichtige Rolle. Welche Aspekte sollten Personalverantwortliche bei der Umsetzung solcher Projekte berücksichtigen? Der digitale Wandel verändert die Personalorganisation. Nicht nur Geschäftsmodelle, Prozesse und Technologien werden sich anpassen müssen, sondern auch…

NEWS | PRODUKTMELDUNG

Checkmarx präsentiert neues Global Channel Partner Program

Neues Programm hilft Resellern und Distributoren, die Weichen für ein nachhaltiges Wachstum und langfristige Kundenbeziehungen zu stellen und der steigenden Nachfrage nach AST-Lösungen gerecht zu werden. Checkmarx, Anbieter entwicklerzentrierter Application-Security-Testing-Lösungen, dokumentiert mit dem Launch des neuen Checkmarx Global Partner Programs sein nachhaltiges Channel-Commitment. Das neue Programm ermöglicht es Partnern, gemeinsam mit Checkmarx die Weichen für…

NEWS | CLOUD COMPUTING | SERVICES | TIPPS

Fünf Möglichkeiten für Kosteneinsparungen in der Cloud

Leitfaden für das Erschließen von Cloud-Potenzialen. Wer regelmäßig Cloud-Services nutzt, fragt sich gewiss von Zeit zu Zeit, warum die Rechnung in manchen Monaten höher ist als in anderen oder was es wohl kosten würde, eine bestimmte Anwendung in die Cloud zu verlagern. Um User gezielt dabei zu unterstützen, die volle Kostenkontrolle über ihre Cloud-Nutzung zu…

NEWS | PRODUKTMELDUNG | RECHENZENTRUM

Das Schweizer Taschenmesser für IT-Operations

ADN Group vertreibt die EUC-Analyse und Managementplattform von ControlUp. Mit der Portfolio-Erweiterung um ControlUp bietet die ADN Group ihren Partnern Cross- und Upselling-Chancen im Citrix- Microsoft- und VMware-Umfeld und erleichtert die Transformation vom klassischen Systemhaus zum Service Provider. Der Homeoffice-Boom der vergangenen Monate führte nicht selten zu Frust bei den Nutzern auf der einen…

NEWS | KOMMUNIKATION | LOGISTIK | AUSGABE 7-8-2021

Länderübergreifende Vernetzung – Digitaler Dokumentenaustausch in der Logistik

Sie agiert größtenteils im Hintergrund und ist dennoch Weltwirtschaftstreiber Nr. 1 und eine der Grundvoraussetzungen für die tagtägliche Versorgung der Bevölkerung: Die Logistikbranche. Mit einer Gesamtleistung von geschätzt 268 Milliarden Euro allein im Jahr 2020 und drei Millionen Beschäftigten ist sie laut Bundesvereinigung Logistik (BVL) der drittgrößte Wirtschaftsbereich Deutschlands – und seit jeher Ursprung digitaler Innovationen. Welch entscheidende Rolle hier der Dokumentenaustausch spielt, zeigt ein Logistikexperiment des Digitalverbands Bitkom.

NEWS | IT-SECURITY

Ist Zero Trust das Ende des VPN?

Ein VPN (Virtual Private Network) verschlüsselt Tunnel zwischen Unternehmensnetzwerken und zugelassenen Endnutzergeräten. Mit einem VPN können Remote-Mitarbeiter auf Netzwerkressourcen zugreifen, als ob sie in einem Büro arbeiten würden, das direkt mit dem Unternehmensnetzwerk verbunden ist. VPNs ermöglichen den Mitarbeitern einen sicheren Remote-Zugriff, ganz gleich, ob sie im Büro sind, zu Hause oder in einer anderen…

NEWS | TIPPS

Software-Tipps für ein erfolgreiches Unternehmen

Überlegen Sie, ein Unternehmen zu gründen? Dann wollen Sie sicherlich auch erfolgreich sein und von Beginn an richtig durchstarten. Dass das kein Honiglecken ist, sollte jedem klar sein. Schließlich gibt es unzählige Beispiele von gescheiterten Firmengründungen. Entweder weil der Businessplan fern ab von der Realität war, oder weil man sich hier und dort verkalkuliert hat,…

NEWS | BUSINESS | IT-SECURITY | STRATEGIEN

Raus aus den Silos – für mehr organisatorische Resilienz

In der Informations- und Cybersicherheit sprechen wir viel über die technische Seite von Resilienz und Kontrolle. Ein eher unterrepräsentiertes Thema ist die organisatorische Resilienz. Dazu spricht Tim Erlin, VP Strategy & Product Management bei Tripwire, mit Gary Hibberd, Professor für Cyberkommunikation bei Cyberfort. Hibberd leitete die Abteilungen Business Continuity und Informationssicherheit bei verschiedenen Unternehmen, und…

NEWS | EFFIZIENZ | STRATEGIEN

DevSecOps: Fünf Aspekte für den optimalen ROI

Entwicklungsteams von Morgen denken nicht nur an Code, Sicherheit und den alltäglichen Arbeitsbetrieb, sondern auch an die Rentabilität – den ROI. In einer zunehmend digitalisierten Welt ist es unerlässlich, dass die Verantwortlichen für den ständigen Wandel bei der Modernisierung ihrer IT-Strukturen Geschäftsziele mitdenken. Spätestens die Covid-19 Pandemie hat Unternehmen vor Augen geführt, wie entscheidend…

NEWS | BUSINESS | STRATEGIEN

Technologien nutzen, um soziale, wirtschaftliche und ökologische Performance zu maximieren

Traditionell spielen Themen wie Environment, Social und Governance für deutsche Unternehmen eine große Rolle und grüne Technologien werden auch in Zukunft stark an Relevanz gewinnen. Im Interview erklärt Dr. Rolf Werner von Cognizant wie seine Organisation den Wandlungsprozess hin zu nachhaltig agierenden Unternehmen unterstützt. Was war die Intention zur Veröffentlichung des ESG-Reports? Der ESG-Report…

TRENDS 2021 | NEWS | TRENDS INFRASTRUKTUR | INFRASTRUKTUR

Netzwerk-Experten fordern NetOps-Schulungen

NetOps ist in der Praxis noch relativ neu. Netzwerk-Manager, -Architekten und -Engineers sind sehr daran interessiert, die nötigen Skills für den Übergang zu der an DevOps orientierten Arbeitsweise zu erlernen. Doch Fortbildungsmaßnahmen fehlen, so das Ergebnis einer Studie von Opengear [1]. Rasant geht die Verbreitung von Automatisierung, Virtualisierung und Orchestrierung in der gesamten IT-Branche…

TRENDS 2021 | NEWS | TRENDS CLOUD COMPUTING | CLOUD COMPUTING

Hybrid Cloud Management 2021 – neue Studie zum optimalen Einsatz

Im Auftrag von USU hat das Forschungs- und Beratungsunternehmen »Research in Action« jetzt 750 Entscheider mittelständischer und großer Unternehmen zu den Herausforderungen, Lösungen und Einsparpotenzialen von Cloud-Services befragt. Die Studie untersucht fünf wichtige Aspekte zur Zukunft von Cloud-Services. Sie zeigt, dass Cloud Computing in der heutigen Wirtschaft unverzichtbar ist, die Herausforderungen aber immens sind: So…

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | LÖSUNGEN

PLM: Standardsoftware ist nicht die Antwort

Viele Anbieter im Bereich PLM (Product Lifecycle Management) preisen ihre Lösung damit an, dass sie out-of-the-box als Standardsoftware funktioniert. Das soll in der Theorie die Zusammenarbeit zwischen Herstellern und ihren externen Stakeholdern wie OEMs oder Zulieferern vereinfachen. In der Praxis sieht es jedoch oft anders aus: Denn der Einsatz von Standardsoftware wird den individuellen Anforderungen,…