Dass die Entwicklung der Datenbestände in Unternehmen nur eine Richtung kennt (Spoiler Alert: nach oben), ist mittlerweile eine Binsenweisheit. Für Unternehmen hat dies aber spürbare Auswirkungen auf ihr Tagesgeschäft, denn zum Einen müssen Daten den Mitarbeitern im Idealfall jederzeit und überall zur Verfügung stehen – aktuell auch im Home Office –, auf der anderen Seite liefern Datenanalysen wichtige Informationen für das Management. Klassischer Highend-Storage ist in der Lage, die meisten Herausforderungen locker abzudecken. Aber das hat seinen Preis und im »real life« spielen neben der Performance die Kosten eine immer größere Rolle, weshalb viele Unternehmen eine Alternative oder Ergänzung zu kostspieligen Appliances suchen.

Hier kommt Ceph ins Spiel: Bereits 2007 wurde der Kopffüßler (Ceph leitet sich von Cephalopod ab, einer Gattung, zu der auch der Oktopus zählt) von Sage Weil im Rahmen seiner Doktorarbeit an der University of California Santa Cruz als verteiltes, hoch verfügbares und leistungsfähiges Storage-System entwickelt. Ceph ist Open Source und wird von zahlreichen Unternehmen der Branche unterstützt. Mit Ceph lässt sich auf Linux-Basis mit Standard-Hardware ein Storage-Cluster aufbauen, der sich praktisch beliebig erweitern und auf nahezu jeden Anwendungsfall anpassen lässt, egal ob File, Block oder Object Storage. Als »Software defined Storage«-Lösung ist Ceph extrem skalierbar, hoch performant (in Abhängigkeit von der eingesetzten Hardware) und zudem ausfallsicher.

Enterprise-Storage mit Standard-Hardware

Für Administratoren mit Linux-Kenntnissen ist die Einrichtung eines Ceph-Clusters in einer Testumgebung keine große Herausforderung. Zahlreiche Tutorials im Internet geben Schritt-für-Schritt-Anleitungen. In Produktionsumgebungen sind die Anforderungen und Ansprüche an ein Storage-Cluster aber naturgemäß ganz andere, Deployment- und Management müssen 1a funktionieren und sollten möglichst wenig Zeit und Manpower in Anspruch nehmen. Hier schlägt die Stunde von Unternehmen wie croit.

Die Deployment- und Management-Lösung von croit erleichtert die Einrichtung und Verwaltung von Ceph-Clustern ungemein. Der Start ist einfach: Als Installationsbasis empfiehlt sich ein dedizierter Server oder auch eine virtuelle Maschine (VM), auf der beispielsweise ein Debian Linux läuft. Im Prinzip läuft die Software aber unter jedem beliebigen Betriebssystem, das eine aktuelle Version von Docker unterstützt. Dieser Host wird als »Management Node« bezeichnet und sollte als Hardware mindestens 8 GB RAM, 100 GB SSD-Kapazität für Statistiken und Logfiles und vier CPU-Cores mitbringen. Wichtig ist auch ein dedizierter Netzwerkzugriff auf alle Ceph-Hosts, möglichst ohne eine dazwischen geschaltete Firewall. Ratsam ist zudem das Einrichten eines eigenen Layer-2-Netzwerks für die Ceph-Infrastruktur, die von anderen Servern oder Desktop-Systemen getrennt ist. croit unterstützt in diesem Zusammenhang auch die Netzwerksegmentierung mit VLANs und empfiehlt für Produktions-Setups zwei unterschiedliche Netze, eines für den administrativen Datenverkehr zwischen dem Management-Node und den einzelnen Ceph-Servern, und ein zweites, das als eigentliches Ceph-Netzwerk den Datentraffic innerhalb des Clusters und zwischen Cluster und Clients abdeckt.

Das Medium definiert die Geschwindigkeit

Neben einem performanten Netz sollte in einem Storage-Cluster auch die Hardware zur Datenspeicherung möglichst leistungsstark sein, wobei natürlich die Spezifikation auch vom jeweiligen Einsatzzweck abhängt. Im Prinzip kann via Ceph jeder Server in den Cluster eingebunden werden, der über das Netzwerk angesprochen werden kann. Erfahrungswerte aus der Praxis zeigen, welche Systeme sich für einen reibungslosen und langfristigen Einsatz im Cluster am besten eignen. Schnellere – und teurere – Technologien wie NVMe bringen dabei natürlich Performance-Vorteile, aber Ceph ermöglicht hier einen effizienten Mix, in dem sich jedem Prozess der am besten passende Storage zuteilen lässt. Gegenüber klassischen Systemen können Unternehmen Kosten einsparen, weil keine RAID-Controller benötigt werden und die Systeme anstatt einer »One-Size-fits-all«-Lösung für den jeweiligen Anwendungsfall zusammengestellt werden können.

Die beste Performance bringen aktuell PCIe NVMe SSDs. SATA-Festplatten eignen sich aufgrund ihres günstigen Preises vor allem für Backup-Zwecke. Um ein möglichst gutes Preis-/Leistungsverhältnis zu erzielen, können Daten auch in hybriden Setups gespeichert werden. Vereinfacht dargestellt liegen die Daten im Cluster einmal auf einer SSD und zweimal redundant auf Festplatten. Läuft der Cluster korrekt, liefert die SSD hohe Geschwindigkeit, bei einem Ausfall sind die Daten über die Festplatten weiter verfügbar, allerdings mit geringerer Geschwindigkeit. Ein guter Kompromiss zwischen Performance, Sicherheit und Kosten.

Von MON und OSDs

Zur Überwachung des Clusters nutzt Ceph so genannte MON (Monitor) Nodes oder Server. Hier sind die Hardwareanforderungen recht überschaubar, ein kleines System oder eine VM mit etwas lokalem Speicher (in der Regel reicht eine 256 GB SSD), 16 GB RAM und 2 CPU-Cores reicht in der Regel aus. Da es sich bei den MONs um reine Softwareprozesse handelt, können sie auch auf den Storage-Nodes mitbetrieben werden, sofern dort ausreichend RAM- und CPU-Kapazität zur Verfügung stehen. Die MON-Nodes erstellen eine »Cluster Map« und sorgen im laufenden Betrieb für die Verwaltung des Clusters.

Als Basis für den eigentlichen Speicher dienen Storage-Nodes mit Platz für mehrere Platten oder SSDs. Pro eingebautem Speichermedium sollten die Server mindestens 6 GB RAM bieten, besser sind 8 GB. Bei einer Bestückung mit zwölf 14 TB-Medien sollten also 128 GB RAM vorhanden sein. Im laufenden Betrieb wird der Arbeitsspeicher in der Regel nicht gefordert, aber beispielsweise bei einem Recovery erweist sich weniger RAM schnell als Flaschenhals.

Die CPU-Anforderungen hängen von der Zahl der Platten oder SSDs ab. Für jedes einzelne Speichermedium startet Ceph einen Software-Prozess, der als OSD bezeichnet wird (Object Storage Daemons). Als Faustregel gilt, dass für jedes Speichermedium/ jeden OSD ein echter oder Hyper-Threading-Core zur Verfügung stehen sollte. Addiert man noch etwas Rechenpower, etwa für Betriebssystem und Netzwerkkarten hinzu, sollte im oben genannten Beispiel mit zwölf Devices also im Server mindestens eine 8-Kern-CPU mit Hyper-Threading verbaut sein, bei SSDs sollte besser mit zwei Threads pro Device kalkuliert werden, bei NVMe-Speicher sogar mit vier bis acht. Teure Rechenzentrums-Hardware ist dabei nicht erforderlich, auf der anderen Seite sollte aber auch auf besonders günstige Speichermedien mit schlechter Performance verzichtet werden.

Grafische Installation erleichtert das Ceph-Leben

Die Installation eines Ceph-Clusters geht mit Hilfe von croit schnell vonstatten: Docker Container einrichten, Anwendung starten und die Basis konfigurieren ist eher eine Sache von Minuten als Stunden, wenn die entsprechende Hardware im Netz vorhanden ist. Das Feintuning nimmt dann doch etwas mehr Zeit in Anspruch, die Investition lohnt sich aber. Zuerst wird der Management Node eingerichtet, danach die einzelnen Storage-Nodes. Auf den dafür vorgesehen Servern werden die MON-Disks eingerichtet und die MON-Dienste gestartet, die später die Ceph-Monitor-Datenbank enthalten. Aus Gründen der Ausfallsicherheit werden dabei in der Regel drei oder fünf MON-Dienste genutzt. Die anderen an den Server angeschlossenen Speichermedien werden schließlich als OSDs konfiguriert und in den Cluster integriert, indem sie der bestehenden Crushmap hinzugefügt werden. Bei Ceph nativ sind dazu mehrere Befehle auf der Kommandozeile erforderlich, croit bietet dazu einen Browser-basierten Prozess. Auch neue Hosts können über das User-Interface von croit jederzeit komfortabel zum Cluster hinzugefügt werden.

Steht die technische Basis des Clusters, baut Ceph aus allen angeschlossenen Speichermedien einen Speicherpool in Form eines Objektspeichers. Dieser Objektspeicher wird als »RADOS« bezeichnet (Reliable Autonomic Distributed Object Store) und fungiert quasi als Software-Layer zwischen der Speicher-Hardware und den Clients. Der Client-Zugriff auf RADOS kann über vier Wege erfolgen:

- CephFS, ein POSIX-konformes Dateisystem.

- Das RADOS Block Device (RBD) oder auch Ceph Block Device.

- radosgw, ein REST basierendes Web Service Gateway (via RESTful API auch S3 und OpenStack Swift kompatibel).

- Über die API librados können Applikationen direkt auf RADOS zugreifen.

croit bietet darüber hinaus noch die Einrichtung weiterer Gateways für NFS, SMB und iSCSI, so dass Linux- und Windows-Clients und auch Produkte wie VMware problemlos direkt angebunden werden können.

croit – weil der Teufel im Detail steckt

Die Machtverhältnisse in der IT haben sich gedreht. Software regiert mittlerweile das Rechenzentrum, wohingegen Hardware immer standardisierter und austauschbarer wird. Die Vorteile liegen auf der Hand: Deployment-Management und Skalierung werden einfacher, Hardwarekomponenten können problemlos ausgetauscht oder aktualisiert werden. Mit Blick auf Ceph ist das Einrichten eines Clusters für einen versierten Admin kein Hexenwerk. Der Teufel liegt – wie so oft – im Detail und ein Großteil der Konfigurationsarbeit erfolgt bei »native Ceph« über die Konsole. Hier sind zahlreiche Faktoren zu berücksichtigen, an vorderster Front sind das der Durchsatz und die Latenz.

Bei croit erleichtern eine durchgängige GUI, zahlreiche Skripte und fertige Schnittstellen die Einrichtung enorm. Wie beschrieben ist dabei vor allem das »Sizing« des Clusters ohne hinreichende Erfahrung nicht gerade trivial und Fehler können üble Folgen haben: Zu gering dimensionierte Hardware kann beispielsweise dazu führen, dass Journale überlaufen oder die Performance generell in den Keller geht. Es mag paradox klingen, aber auch die Einfachheit im Aufbau von Ceph kann zu einem Problem werden, wenn wachsende Speicheranforderungen mit immer mehr Platten beantwortet werden, ohne gleichzeitig auch die Nodes entsprechend aufzurüsten.

Mit croit lassen sich die meisten Fallstricke bei der Einrichtung und Verwaltung eines Ceph-Clusters elegant umschiffen. Und falls nicht, stehen – neben der agilen Open-Source-Community – qualifizierte Consultants und Support-Mitarbeiter zur Verfügung. Der große Vorteil für die Kunden liegt darin, dass croit eine zusätzliche Ebene für Management und Deployment aufbaut. Der Vorteil dieses Ansatzes zeigt sich gerade sehr deutlich für Kunden von SUSE: Der Linux-Anbieter zieht sich aus dem Ceph-Markt zurück und vermarktet seine Ceph-basierende Storage Lösung SES nicht mehr länger. Bei Unternehmen mit Petabyte großen Clustern wird dieser Move wohl ein flaues Gefühl im Magen hinterlassen. Muss es aber nicht, denn mit der Lösung von croit lassen sich auch auf SUSE Enterprise Storage basierende Ceph-Installationen problemlos importieren und zukunftssicher weiterbetreiben oder migrieren.

Andy Muthmann, Sales Director croit

www.croit.io

149 Artikel zu „Software defined Storage“

NEWS | RECHENZENTRUM

In 5 Schritten zum Open Source Software Defined Storage

Die Anforderungen für Speichersysteme sind in den letzten Jahren immer weiter gestiegen, Agilität, Flexibilität und die schnelle Bereitstellung von Ressourcen sind in einer bi-modalen IT die großen Herausforderungen. Wir haben heute mit mobilen und IoT-Geräten weitaus mehr Endpunkte, an denen Daten generiert werden, als noch vor einigen Jahren denkbar gewesen wäre. Besonders Videoinhalte verbreiten sich…

NEWS | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | DIGITALISIERUNG | DIGITALE TRANSFORMATION | EFFIZIENZ | TRENDS SERVICES | TRENDS 2017 | INFRASTRUKTUR | RECHENZENTRUM | SERVICES

SDS: Unternehmen wollen Software Defined Storage

Studie: Traditionelle Storage-Systeme bremsen Innovation in 94 Prozent der deutschen Unternehmen. Große Mehrheit überzeugt von Software Defined Storage. Traditionelle Storage-Systeme sind zu teuer und zu unflexibel, um für das exponentielle Datenwachstum der digitalen Transformation geeignet zu sein. 89 Prozent der deutschen IT-Verantwortlichen wollen deshalb wechseln, die große Mehrheit (76 %) zu Software Defined Storage (SDS).…

NEWS | EFFIZIENZ | INFRASTRUKTUR | LÖSUNGEN | RECHENZENTRUM | TIPPS

Speichersilos und Insellösungen mit Software Defined Storage in den Griff bekommen

Tipps zur Bewältigung der Datenflut. Viele Unternehmen sehen sich bei der Einführung neuer Speichertechnologien, Funktionalitäten und einem Upgrade auf neue Hardware mit erhöhter Komplexität und einem hohen Kostenaufwand konfrontiert. Denn in der Realität resultieren IT-Equipment, Plattformen und Systeme, die sich nicht nahtlos integrieren lassen, am Ende häufig in einem Sammelsurium von Insellösungen und Silos. Für…

NEWS | INFRASTRUKTUR | AUSGABE 11-12-2018

Maximale Leistung durch SDS – Immer höhere Akzeptanz von Software-defined Storage

Hochverfügbarkeit und Disaster Recovery stellen für viele Unternehmen nach wie vor die größten Herausforderungen in der IT-Infrastruktur dar. Hinzu kommt die Notwendigkeit, vorhandene und zukünftige IT-Hardware herstellerübergreifend nutzen zu können. Einen passenden Lösungsansatz liefert Software-defined Storage, mit dem sich ein Rechenzentrum der nächsten Generation umsetzen lässt. Eine aktuelle Studie von DataCore Software zeigt aktuelle Entwicklungen im Enterprise-Storage-Markt auf.

NEWS | TRENDS INFRASTRUKTUR | CLOUD COMPUTING | DIGITALE TRANSFORMATION | EFFIZIENZ | TRENDS 2017 | INFRASTRUKTUR | RECHENZENTRUM

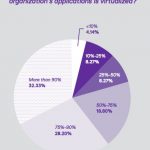

Studie mit teilweise überraschenden Befunden: Software-defined Storage, Hyper-converged und Cloud-Speicher

Die Infrastruktur in den Rechenzentren entwickelt sich von hardwarezentrierten Silos hin zu software-dominierten Ökosystemen. Hier bestimmt die Agilität der Anwendungen die Infrastrukturarchitektur. DataCore Software, Anbieter von Hyper-converged Virtual SAN, Software-defined Storage und Parallel-I/O-Technologie, hat zum sechsten Mal seine jährliche Anwenderstudie »State of Software-Defined Storage, Hyperconverged and Cloud Storage« veröffentlicht. 426 IT-Profis, darunter 180 aus Europa,…

INFRASTRUKTUR | ADVERTORIAL | AUSGABE 1-2-2016

Software-Defined Storage und Parallel-I/O-Technologie – Lösen Server den klassischen Storage ab?

Der Storage-Markt befindet sich im massiven Umbruch. Mit ein Grund dafür sind technologische Umwälzungen, die sich mit Software-definierten Storage (SDS)-Architekturen und Hyperkonvergenzansätzen etabliert haben und nun weiterentwickelt werden. Aufsehen erregt derzeit Parallel I/O-Software. Sie macht Standardserver so leistungsstark, dass sie herkömmlichen, das heißt auch teuren Storage in vielen Unternehmen bald obsolet machen könnten.

INFRASTRUKTUR | AUSGABE 9-10-2015

Web-Scale-Storage, Software-Defined-Storage und Object-Storage

Die guten alten Storage-Strukturen und -Architekturen scheinen in die Jahre gekommen zu sein. Scale-Up-Storage wie Block-Speichersysteme (vor allem die bekannten RAID-Systeme) und traditionelle NAS-Systeme stoßen in den Zeiten von virtualisierten Serverfarmen und Big Data an ihre Grenzen.

INFRASTRUKTUR | AUSGABE 1-2-2014

Hochverfügbarkeit effektiv umsetzen mit Software-defined Storage

Hochverfügbarkeit ist für den unterbrechungsfreien Ablauf von Geschäftsprozessen und damit den Unternehmenserfolg unerlässlich. Eine echte Alternative zu High-End-Lösungen bietet Software-defined Storage: SDS ermöglicht den Einsatz mit kosteneffizienterer Hardware beliebiger Hersteller und eine flexiblere Anpassung an Geschäftsanforderungen. Von der umfangreichen Funktionalität profitiert die gesamte Infrastruktur.

NEWS | CLOUD COMPUTING | RECHENZENTRUM | AUSGABE 11-12-2020

Von VDI bis SAP Hana – Performante Storage Services aus der Cloud

Azure NetApp Files bringt große Datenmengen unter Kontrolle.

NEWS | LÖSUNGEN | SERVICES

Open Source Software: Vorteile nutzen und Risiken vermeiden

Open Source Software zu nutzen, ist bei deutschen Unternehmen schon lange gang und gäbe, denn sie bringt ihnen viele Vorteile. Warum Unternehmen dabei auf kommerzielle Open-Source-Produkte setzten sollten, lesen Sie im Folgenden. Bei Open Source Software (OSS) denken die meisten Anwender an kostenlose Software. Tatsächlich kann OSS gratis sein – muss sie aber nicht. In…

NEWS | PRODUKTMELDUNG

Große Datenmengen effizient speichern und verwalten: Fujitsu erweitert sein Storage-Portfolio

Mit neuen Angeboten von Fujitsu können Unternehmen auch hochkomplexe Aufgaben im Datenmanagement effizient bewältigen und damit den Grundstein für ihre digitale Transformation legen. Fujitsu arbeitet mit einer Vielzahl an ausgewählten Partnern zusammen. Nicht zuletzt dank der intensiven Partnerschaft mit NetApp steht Kunden von Fujitsu eine große Bandbreite erstklassiger Hardware aus einer Hand zur Verfügung. Seit…

NEWS | INFRASTRUKTUR | LÖSUNGEN | RECHENZENTRUM

SD-WAN, SD-Branch, SD-LAN: Was ist was in Software-definierten Netzen

Das Software Defined Networking (SDN) findet in zentralen Rechenzentren immer mehr Anhänger. Darüber hinaus profitieren auch andere Teile des Unternehmensnetzwerks von ähnlichen Ansätzen. Wo liegen Gemeinsamkeiten, wo Unterschiede von SD-WAN, SD-Branch oder SD-LAN? Der Systemintegrator Circular durchleuchtet die Begrifflichkeiten. Weitreichende Performance: SD-WAN Betrieb und Verwaltung eines WAN gestalteten sich in der Vergangenheit teuer, komplex…

NEWS | INFRASTRUKTUR | PRODUKTMELDUNG

Software Defined Networking macht Unternehmen fit für die Digitalisierung

Die Digitalisierung stellt die IT-Infrastrukturen vieler Unternehmen zunehmend vor Herausforderungen, denn: Die hohen Anforderungen an Agilität, Sicherheit und Skalierung können die meist historisch gewachsenen Infrastrukturen oft nicht mehr erfüllen. Der Veränderungsdruck auf die IT ist groß, insbesondere bei den Netzwerkinfrastrukturen. Eine Lösung ist Software Defined Networking (SDN). Damit verfügen Unternehmen nicht nur in Krisensituationen über…

NEWS | INFRASTRUKTUR | KOMMENTAR

Diese Trends prägen aktuell den Storage-Markt

Die Digitalisierung schreitet unaufhaltsam voran, die Datenmengen vervielfachen sich und immer mehr Daten sollen nicht nur einfach gespeichert, sondern auch analysiert werden. Damit Unternehmen auch in naher Zukunft den Wert der Daten noch voll ausschöpfen können, sollten sie bei der gegenwärtigen Storage-Technik stets mithalten und diese Trends berücksichtigen: Das Ende der alten Ordnung: die…

NEWS | KOMMUNIKATION | LÖSUNGEN | AUSGABE 1-2-2020

Software-Defined WAN – Anpassungsfähig wie ein Chamäleon

Agile Unternehmen benötigen ein flexibles Netzwerk, das für Cloud-Anwendungen optimiert ist. Die Lösung ist ein Software-Defined WAN, das sich kontinuierlich und eigenständig an geänderte Geschäftsanforderungen anpasst, Stichwort »Continuous Adaptation«.

TRENDS 2020 | NEWS | TRENDS INFRASTRUKTUR | INFRASTRUKTUR

2020 viel Dynamik im Storage-Umfeld: Container, Analytics und KI zünden die nächste Stufe

Auch wenn Storage und Data Management sowie die damit verbundene Infrastruktur mittlerweile oft unter »Commodity« eingeordnet wird, so sieht Pure Storage auch in Zukunft hier ein erhebliches Potenzial für Unternehmen und deren Kunden. Für das Jahr 2020 geht Güner Aksoy, Director Central Europe bei Pure Storage von 6 wichtigen Entwicklungen aus, die direkte Auswirklungen auf…

NEWS | FAVORITEN DER REDAKTION | INFRASTRUKTUR | STRATEGIEN | AUSGABE 9-10-2019

Modernisierung im IT-Umfeld – Software Defined Everything

Es gibt eine neuartige Ausprägung der Infrastruktur. Die Hardware wird immer standardisierter, denn die Intelligenz des Gesamtsystems, die Flexibilität und die Automatisierung wird maßgeblich von der Software bestimmt.

NEWS | DIGITALISIERUNG | INFRASTRUKTUR | RECHENZENTRUM | SERVICES

Software Defined Networking (SDN) ergänzt klassische Netzwerke, statt sie komplett zu ersetzen

Neuer Anbietervergleich sieht langfristige Koexistenz von hardwarebasierten Netzwerken und SDN. Der Markt für Software Defined Networking (SDN) wächst weiter rasant. Doch werden SD-Netzwerke die herkömmlichen Lösungen auf Basis von MPLS (Multi Protocol Label Switching) auch längerfristig nicht komplett ablösen, sondern eher ergänzen. Dies meldet der neue »ISG Provider Lens – Network – Software Defined Solutions…

NEWS | BUSINESS PROCESS MANAGEMENT | FAVORITEN DER REDAKTION | IT-SECURITY | SERVICES | STRATEGIEN | TIPPS

5 Grundsätze sicherer Open-Source-Software

Kaum ein Softwareprojekt beginnt heute noch auf der grünen Wiese. Das können sich Entwickler und Unternehmen in Zeiten immer schnellerer Release-Zyklen nicht leisten. Um Zeit und Kosten zu sparen, entscheiden sie sich deshalb oft für Open-Source-Bibliotheken. Dabei sollte man aber bedenken, dass die Open-Source-Komponenten, die aus Millionen von bestehenden Bibliotheken entnommen werden, auch Schwachpunkte in…

NEWS | CLOUD COMPUTING | INFRASTRUKTUR | STRATEGIEN

Neue Storage-Architekturen: Hybrid- und Multi-Cloud-Strategien beschleunigen

Auch wenn alle Welt über Daten und ihre Bedeutung für mehr Wettbewerbsfähigkeit und Flexibilität spricht, so fällt es vielen Unternehmen dennoch schwer, dieses Potenzial zu nutzen – und zwar aus einem einfachen Grund: Traditionelle Storage-Anbieter halten sie davon ab, ihr System zu modernisieren, weil sie an herkömmlichen Architekturen mit all ihrer inhärenten Komplexität und Einschränkungen…

TRENDS WIRTSCHAFT | NEWS | BUSINESS | TRENDS 2019

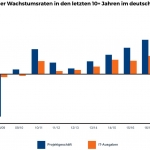

Software- und IT-Services-Markt in Deutschland: Droht nach guten Jahren der Markteinbruch?

Die IT-Branche in Deutschland blickt auf zwei hervorragende Jahre zurück. Der Softwaremarkt wuchs (dank SaaS) um mehr als 5 Prozent, das Wachstum im IT-Services-Geschäft näherte sich der 5-Prozentmarke, die IT-Ausgaben nahmen im letzten Jahr um knapp 4 Prozent zu. Basierend auf der aktuellen Wirtschaftssituation und aktuellen Gesprächen mit zahlreichen Anbietern und Anwendern hat das Marktanalyse-…

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | ONLINE-ARTIKEL | STRATEGIEN

Mit dem Einsatz von Containern steigen die Storage-Herausforderungen

Laut einer Gartner Studie wird im Jahr 2020 über die Hälfte der Unternehmen Container-Technologien einsetzen. Kein Wunder, schließlich bieten Container bisher ungekannte Mobilität, Vereinfachung und Effizienz, damit IT-Teams neue Mikroservices und bestehende Anwendungen schnell aufsetzen und aktualisieren können. Wegen ihrer zahlreichen Vorteile werden Container in den kommenden Jahren eine immer größere Rolle in der IT…

NEWS | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | TRENDS 2019 | OUTSOURCING | SERVICES

Storage-Markttrends 2019: Die Public Cloud tappt in die Kostenfalle

Der Storage-Markt ist in Bewegung. Kostenprobleme in der Public Cloud, künstliche Intelligenz und sich selbst verwaltende Service-Dienstleistungen. Die Komplexität von IT-Infrastrukturen und neue Cloud-Technologien werden Hersteller, den Channel und die Kunden zusätzlich vor neue Herausforderungen stellen. In der Einschätzung von Arcserve, einem Anbieter von Datenschutzlösungen, werden vor allem diese drei Trends den Markt für Backup…

NEWS | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | EFFIZIENZ | INFRASTRUKTUR | TRENDS 2019 | KÜNSTLICHE INTELLIGENZ | RECHENZENTRUM

Prognosen für 2019: Storage zwischen Cloud, Container und KI

Die Anforderungen an Storage sowie Data Management steigen und verändern sich aktuell rasant. Explodierende Datenvolumina, Trends wie KI und IoT sowie die wachsende Beliebtheit von Cloud-Modellen und IoT-Anwendungen halten die Hersteller auf Trab. Für Pure Storage wagt Güner Aksoy, Regional Sales Director Central Europe, einen Blick auf die Veränderungen im kommenden Jahr. Beseitigung der…

NEWS | DIGITALISIERUNG | INFRASTRUKTUR | RECHENZENTRUM | STRATEGIEN

Welche Vorteile bietet Software Defined Networking (SDN)?

Herkömmliche Netzwerkarchitekturen haben sich in den letzten 15 Jahren kaum verändert und sind in die Jahre gekommen. Die heute gestellten Anforderungen an Flexibilität, Schnelligkeit und Sicherheit können damit nicht erfüllt werden. In jedem einzelnen traditionellen Switch ist die Firmware implementiert – bei Änderungen oder Neuinstallation von Devices oder Anwendungen muss die Konfiguration an jeder einzelnen…

NEWS | BUSINESS PROCESS MANAGEMENT | EFFIZIENZ | INFRASTRUKTUR | PRODUKTMELDUNG | SERVICES | TIPPS

Mehr Zeit für Innovation, weniger Aufwand für Service –mit moderner Storage-Technologie die Produktivität der IT-Abteilung steigern

Mit einer veralteten Speicherumgebung zu arbeiten, wird immer komplexer, teurer und aufwändiger. Das kostet Unternehmen Ressourcen, die in innovationsorientierte Aktivitäten besser angelegt wären. IT-Fachkräfte in Unternehmen wenden einen großen Teil ihrer Arbeitszeit dafür auf, Serviceanfragen abzuarbeiten und Probleme zu lösen. Für Innovationen, die das Unternehmen voranbringen, bleibt hingegen kaum Zeit. Dies bestätigt eine aktuelle Studie…

NEWS | CLOUD COMPUTING | INFRASTRUKTUR | IT-SECURITY | KOMMUNIKATION | LÖSUNGEN | RECHENZENTRUM | TIPPS

Software-Defined WAN löst das Problem mit dem Internet-Zugang

Jemandem ein Rätsel aufzugeben, bedeutet, die betreffende Person vor ein Problem zu stellen. So steht es im Duden. Und mit einem speziellen »Rätsel« sehen sich Netzwerkspezialisten konfrontiert: Sie suchen nach Wegen, um Mitarbeitern in Niederlassungen und Home Offices einen Internet-Zugang bereitzustellen. Das ist schwieriger als gedacht. Denn viele Unternehmensnetze sind nach dem Prinzip »Nabe und…

NEWS | CLOUD COMPUTING | INFRASTRUKTUR | KOMMUNIKATION | ONLINE-ARTIKEL | SOFTWARE-DEFINED NETWORKING

Software-Defined WANs sind nicht das Ende von WAN-Optimierung

Software-Defined WANs (SD-WANs) sind ein zentrales Thema in der IT. Einer der größten Vorteile eines SD-WAN ist, dass Unternehmen preisgünstige Breitband-Internet-Verbindungen nutzen können. Doch bedeutet dies, dass WAN-Optimierung überflüssig wird? Die Antwort hängt von den Einsatzfeldern ab. Business Continuity (BC) und Disaster Recovery (DR) stellen beispielsweise sicher, dass der Geschäftsbetrieb auch nach Unglücksfällen und Naturkatastrophen…

NEWS | CLOUD COMPUTING | DIGITALISIERUNG | EFFIZIENZ | INFRASTRUKTUR | KOMMUNIKATION | OUTSOURCING | RECHENZENTRUM | SERVICES | STRATEGIEN

Software Defined Networking (SDN) – eine Revolution im Netzwerkumfeld

Nach den Virtualisierungswellen im Server- und Storage-Umfeld rollt nun die Virtualisierung des Netzwerks auf die Anwender zu. Herkömmliche Netzwerkinfrastrukturen sind in die Jahre gekommen und können die Anforderungen an Flexibilität, Schnelligkeit und Sicherheit nicht erfüllen. In jedem einzelnen traditionellen Switch ist die Software (Firmware) implementiert, bei Änderungen oder Neuinstallation von Devices oder Anwendungen muss die…

NEWS | EFFIZIENZ | INFRASTRUKTUR | KOMMUNIKATION | LÖSUNGEN | ONLINE-ARTIKEL | RECHENZENTRUM | STRATEGIEN | TIPPS

Was CIOs über Software-Defined WANs wissen müssen

Bei der Diskussion über Software-Defined-Technologien wie SDN (Software-Defined Networking) oder SDS (Software-Defined Storage) in virtualisierten IT-Umgebungen und Rechenzentren wird oft ein Punkt übersehen: Auf welche Weise vergleichbare Ansätze bei Weitverkehrsnetzen (Wide Area Networks, WANs) genutzt werden können, um die Performance von Applikationen zu verbessern. Denn nach wie vor greift ein Großteil der Mitarbeiter von Unternehmen…

NEWS | TRENDS INFRASTRUKTUR | EFFIZIENZ | TRENDS 2016 | INFRASTRUKTUR

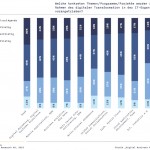

Storage: Einfache Verwaltung löst Performance als wichtigste Herausforderung ab

Mehr als ein Drittel nutzt noch immer manuelle Listen für die Übersichtserstellung ihrer VMs. In der Studie »Storage Status Quo 2016« (State of Storage) für virtuelle Umgebungen werden jährlich 300 IT-Profis zum Stand der Speicherindustrie befragt [1]. Die wichtigste Erkenntnis des diesjährigen Reports besteht darin, dass Performance nicht mehr die größte Herausforderung der IT-Verantwortlichen ist…

NEWS | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | DIGITALE TRANSFORMATION | INDUSTRIE 4.0 | INFRASTRUKTUR | RECHENZENTRUM | SOFTWARE-DEFINED NETWORKING

Software-defined Infrastructure mit OpenStack und OpenDaylight

Die digitale Transformation schlägt weiter um sich. Was sich für einen Großteil der Unternehmen »lediglich« auf Geschäftsmodell- und Prozessebene bemerkbar macht, bereitet Industrie-Unternehmen auch innerhalb der Produktion Kopfzerbrechen. Insbesondere die Automobilbranche hat mit einer hohen Erwartungshaltung hinsichtlich Innovationen über die gesamte Lieferkette zu kämpfen. Eine bedarfsgerechte Produktion in nahezu Echtzeit sowie eine flexible Lieferung der…

TRENDS WIRTSCHAFT | NEWS | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | EFFIZIENZ | INFRASTRUKTUR | OUTSOURCING | ONLINE-ARTIKEL | STRATEGIEN

»Software-definiert« steht für einen neuen Infrastrukturansatz

Datenvirtualisierung kombiniert mit Service Levels bieten eine notwendige Ergänzung zur effizienteren Umsetzung von Software-defined Storage. Damit Unternehmen das Datenwachstum bewältigen können, müssen sie ihre derzeitige Storage-Strategie überdenken und neu ausrichten. Der Ansatz des Software-defined Storage (SDS) soll die Nutzung vorhandener Speicherressourcen optimieren. Für Actifio, spezialisiert auf Datenvirtualisierung, ist SDS ist jedoch nur der halbe Schritt…

STRATEGIEN | AUSGABE 7-8-2015

Software Defined Data Center – Das moderne Rechenzentrum

Der Begriff Software Defined Data Center (SDDC) hat sich zum Synonym für moderne Rechenzentren (RZ) entwickelt. In der Tat ist ein Wandel zu »Software Defined« bei den meisten Kerntechnologien in den Rechenzentren bereits zu beobachten. Es ist also durchaus ein günstiger Zeitpunkt, sich anzuschauen, worum es sich eigentlich konkret handelt.

EDITORIAL | AUSGABE 5-6-2015

Durch Software definiert

Weniger Aufwand bei der Implementierung und dem Betrieb der Netzwerke, Server und Speicher; das ist es, was sich die IT-Verantwortlichen wünschen. Software-defined Server, Sofware-defined Storage und nun auch Software-defined Networking sind die Bausteine für das Rechenzentrum der Zukunft, dem Software-defined Datacenter.

Interessanterweise findet die Hinwendung zu »Software-defined« bei vielen Unternehmen zunächst aus der Motivation heraus statt, die Lebensdauer der Server, der Speicher oder der Switche zu verlängern. Das lässt sich mit dem software-definierten Ansatz auch hervorragend realisieren, ist aber zu kurz gesprungen.

Der zweite, und wesentlichere Grund hat mit der langfristigen Strategie der Reduzierung der Komplexität zu tun …

SOFTWARE-DEFINED NETWORKING | TOP-THEMA | AUSGABE 5-6-2015

Interview Software-defined Networking – SDN ist der nächste logische Schritt

Mit SDN sparen Unternehmen nicht nur Strom und Kosten, sondern können ihre Netzwerke auch schneller an die Bedürfnisse des Marktes und des eigenen Unternehmens anpassen. SDN ist das i-Tüpfelchen auf dem Weg zum Software-defined Data Center, der nächste Schritt in Richtung Modernisierung.

CLOUD COMPUTING | STRATEGIEN | AUSGABE 9-10-2014

Software Defined Data Center im Service-Rechenzentrum – Mit dem SDDC in die Cloud

Die Servervirtualisierung im Service-Rechenzentrum hat den Providern mehr Flexibilität und eine bessere Auslastung der Ressourcen ermöglicht. Mit dem Software Defined Data Center wird dieser Ansatz weitergedacht und um Storage- und Netzwerkvirtualisierung erweitert. Auf dieser Basis kann die Bereitstellung definierter Services innerhalb von Rechenzentren weitestgehend automatisiert werden. Provider können auf diese Weise individuelle Cloud-Leistungen in kürzester Zeit einheitlich bereitstellen.

INFRASTRUKTUR | AUSGABE 7-8-2014

Software-defined seit der ersten Stunde

Im Storage-Bereich dreht sich alles um »Software-defined«. Grundlage des Software-defined Storage (SDS)-Ansatzes ist die Virtualisierung. Wir sprachen mit George Teixeira, Mitgründer und CEO von DataCore Software, einst Pionier bei der Storage-Virtualisierung und heute mit über 25.000 Installationen bei 10.000 Kunden weltweit einer der führenden Anbieter bei Software-defined Storage.

SERVICES | AUSGABE 5-6-2014

Nächster Halt: Software Defined Data Center? – Das Abenteuer Virtualisierung geht weiter

Software Defined Data Center (SDDC) ist zurzeit in aller Munde. Der Begriff Software Defined Data Center ist zwar griffig, aber auch vielsagend. Was verbirgt sich tatsächlich dahinter, wo kommt die Entwicklung her und wo geht sie hin? Was kann heute schon nützlich sein und für wen? Wenn es um derartige Fragen geht, hilft es, hinter die Kulissen zu schauen, um die wesentlichen Entwicklungsstränge, Abhängigkeiten und Wechselwirkungen nachvoll-ziehen zu können.

NEWS | FAVORITEN DER REDAKTION | IT-SECURITY

Cyberkriminelle greifen verstärkt die Open-Source-Lieferketten an

Untersuchungen verzeichneten gerade in den letzten Monaten einen hohen Anstieg bei Supply-Chain-Angriffen auf Open-Source-Softwareprojekte. Einem Bericht zufolge wurden in der Zeit zwischen Juli 2019 und Mai 2020 insgesamt 929 Attacken verzeichnet. Im Vergleich dazu soll es in den vier Jahren zwischen Februar 2015 und Juni 2019 lediglich 216 solcher Angriffe gegeben haben. Dazu haben wir Tim Mackey,…